标题:A survey on semantic-based methods for the understanding of human movements

作者:

下载链接:https://pdf.sciencedirectassets.com/271599/1-s2.0-S0921889019X0007X/1-s2.0-S0921889018303932/main.pdf?X-Amz-Security-Token=IQoJb3JpZ2luX2VjEOz%2F%2F%2F%2F%2F%2F%2F%2F%2F%2FwEaCXVzLWVhc3QtMSJHMEUCIQCqiTbXZs12Q1xLi%2FI9YdCovWqMZIy3FNFaYfv2UgF7pgIgYCDPryccCfaQCknJltA24ohBGwTRVQRRBUu7q7NQMs0qtAMIFBADGgwwNTkwMDM1NDY4NjUiDFbi12j3WI9e%2F%2B%2BVlyqRA2z7c2BbVvIm7QxCySoi%2FJ6hzpMPiZwxvFzxVgK5HHnNnlAS9t1qRIPwUQZwmWsUVxdKVa779uhxkrnD2THaI7NxUs1OAG4vXZOHFzqxPx2Gnbs%2FfhPwa74AhI15DbIPrLFphWEol7KsD0dOHjzhtgMAyDtWxBajaV8y8futUSP74cK1pzgYwqf8k9%2B1v%2BGXa3sDuSl5fFkctmPVXO0bb07b7mRoAMhG2gevX%2BSRvOHLgwuf1VSi2rTW2hJfzqnIqiU1laXP9kfk80Df7nHzsl4QoElaHtTNWOrMCUF27snpiRUWXolw6Pv7yfud97crpIK9AzC%2FmcXWHwAsPiXl8sc3UWhbN6K6EHVf1sD%2FOQSOWxXkrprkt0RZl%2FYNdaaOEI8CkTZHuSRb5rI1AQMi3o%2FUWdhosNX3MgIuyzknUS3GMhz6aJnsLhmpRhW8G9YA8vQuMbL6AGNGIB3%2B0ehOPBNIsKtJbYHUiMWT9Wo8PDi4pqGYFKmsfF0VLXBYUMh0%2FcLBYTaYr%2BgPybwKOp8BWfsKMOHGjYIGOusBzNWn6efAniWsRfMIUXoO7snjXNojkiq6ne42n3Rw7HzK%2B2LASzJOL29gQToQt82WsE5WZVCTFnnge7q0GdO5yzEq1Z%2Fd4EdHZWFYKVahnSFwop6mGSRa78Vb3qwi9trAUQ1SdsV3bxdxIqQgWUHJSSAli83wNFLL5p0KQi829M%2BdwF84N7waD9V6s8ePhWYJKKNkf4EjSBTbpNnc8N7Uv6kwI%2F9fjFGgp%2FZdTuCrmcyI6QY19QtaUDMUAcDX30GdXO50ifBRq78TuAD0a8fDbz0Yta3AiP4a9Xwf3%2B6weVBaFhibkCSOQk3DYw%3D%3D&X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Date=20210306T115641Z&X-Amz-SignedHeaders=host&X-Amz-Expires=300&X-Amz-Credential=ASIAQ3PHCVTY65MPBJNS%2F20210306%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Signature=dfbd935468a31beb73cd2d7e241c1485719ad2f037b02baf45a648d83f3c68d6&hash=fcc702016a716493f89ea09eb73cdababacd0461bed01f0885f4ca782517f14a&host=68042c943591013ac2b2430a89b270f6af2c76d8dfd086a07176afe7c76c2c61&pii=S0921889018303932&tid=spdf-0bf1cf94-442c-483f-b064-34ebbac77dfc&sid=0fa3fd974ab8b14d458ae3d29eef656a2657gxrqb&type=client

0. 摘要

本文提出了一种基于语义的方法来理解机器人应用中的人体运动。要了解人类的动作,机器人首先需要识别观察到或演示的人类活动,其次要学习不同的参数以执行动作或机器人行为。为了实现这一目标,需要解决一些挑战,例如人类活动的自动分段,识别动作的重要特征,确定活动之间的正确顺序以及获得连续数据与符号和语人类活动义解释之间的正确映射。本文旨在介绍基于语义的最新方法,尤其是新兴的方法,这些方法解决了为机器人领域寻找通用且紧凑的语义模型的挑战。最后,我们将重点介绍未来几年的潜在突破和挑战,例如实现可伸缩性,更好的通用性,紧凑灵活的模型以及更高的系统精度。

1. 介绍

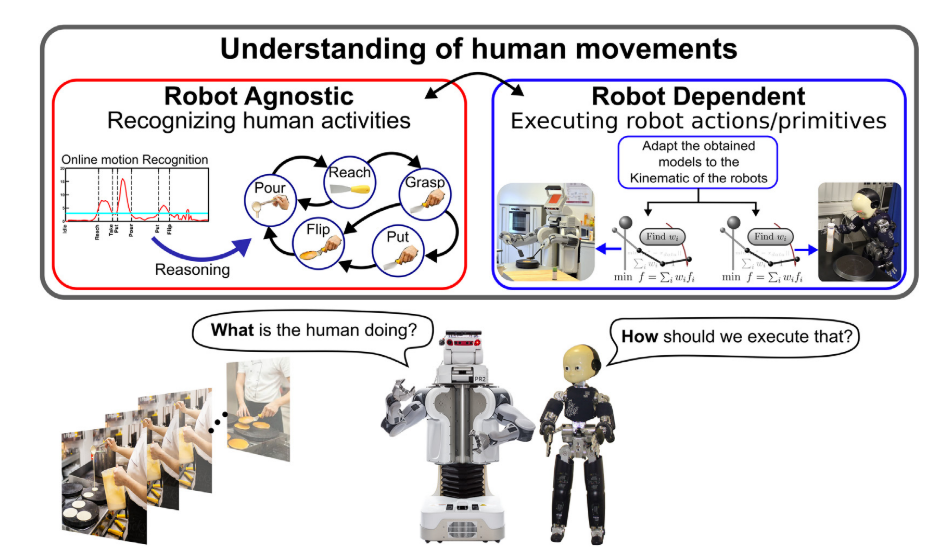

下一代机器人有望与人类同事并肩工作。 从这个意义上讲,机器人需要以有意义,灵活和适应性强的方式与人类互动,尤其是在面对新的未知情况时。 为了使机器人具有这种能力,需要解决一个非常重要的方面,即对人体运动的理解。 理解机器人技术中人类运动的目标是双重的,以自动识别演示的人类活动,并学习必要的参数以允许机器人执行演示的动作。 例如,假设不同的机器人正在观察同一个人准备薄煎饼(见图1)。 为了了解准备薄煎饼的任务,机器人需要回答以下两个关键问题:

人类在做什么? 机器人应通过自动分割并识别演示的任务(制作煎饼)来解释活动,例如伸手抓一把铲子,然后翻转煎饼。 理想的解决方案是开发一种与机器人无关的学习方法。 具有机器人不可知系统,即使它们具有不同的实施例和传感器,也可以在不同的机器人之间转移学习的模型。 这可以通过提取演示任务的含义(语义)来实现。 在这一点上,两个机器人都首先了解到,他们需要握住铲子来翻转薄煎饼。

我们(机器人)应如何执行学习到的任务?在这种情况下,机器人需要学习相关功能以执行动作来实现演示的任务。要执行动作,应在模型中考虑机器人的实施方式以及环境。例如,图1显示了具有不同实施例的两个机器人,这意味着获得的模型需要适合于机器人的不同运动学链。例如,要执行公认的抓铲操作,具有抓取器的PR2机器人将使用与具有五个手指的iCub机器人不同的抓取动作(行为)。然后,还需要在执行期间考虑有关环境的信息,例如当机器人执行翻转桌子高度的动作时,还应考虑其他因素,例如面团的粘度,煎饼的大小,翻转煎饼所需的力等。这些模型是特定于所使用的机器人的,因此,学习模型从一个机器人到另一机器人在不同环境中具有不同运动学结构的可移植性并非易事。

图1.本次调查提出了基于语义的方法,使机器人能够理解人类的动作,涉及两个主要研究领域:识别和执行。 识别人类活动的方法应该与机器人无关,然后可以在不同的机器人之间转移获得的模型。 然而,提出的用于执行动作/基元的方法是依赖于机器人的,并且所获得的模型需要根据机器人的实施例进行适配。

识别和执行问题都可以使用基于语义的方法来解决。通过基于语义的方法,我们从这些形式化描述中能得到什么?基于语义的方法旨在在人体运动和物体属性之间找到有意义的关系,以便理解人体运动。例如,基于语义的方法提取观察到的原始信号(例如姿势,速度和距离)的含义,以创建信息模型,从而可以找到观察到的运动的意图或目的[1,2]。例如,当机器人观察到执行浇注活动的人员时,机器人没有从浇注活动中学习特定的低级参数(例如速度或位置)模型,而是使用抽象表示来学习浇注的含义。这使得学习到的浇注活动的语义描述可以在不同的情况下使用,因为获得的模型允许这种类型的概括。

生成用于活动识别或动作执行的基于语义的模型的主要优点之一是创建形式描述以提取人类活动的语法和语义。 这项调查的主要贡献是向不断发展的机器人技术界介绍最常见的通用生成语义描述方法以及最有代表性的经典方法,这些方法可用于主要解决两个问题(参见图1) ,人类活动的识别以及机器人的动作执行。

1.1

在各种学科中已经针对不同的应用研究了对人体运动的理解。例如,计算机视觉社区有兴趣提出一些方法,以分析图像或视频中正在进行的活动,例如,将图像或视频应用于视觉监控[3-6]。认知科学学科研究计算代理人识别目标为目标的行为者的心理能力[7-10]。神经科学界通过研究中枢神经系统内的过程来定义解释感官信号与运动控制之间关系的原理[11,12]。人工智能界正在投资开发方法,以自动分割和识别动态环境(例如家庭和汽车领域)中的高级人类活动[13-16]。最后,机器人社区提出了一些方法,以找到适当的控制策略,以将已证明的人类行为转移到机器人系统,通常使用非线性动力学系统对目标定向的人类行为进行建模[17-19]。

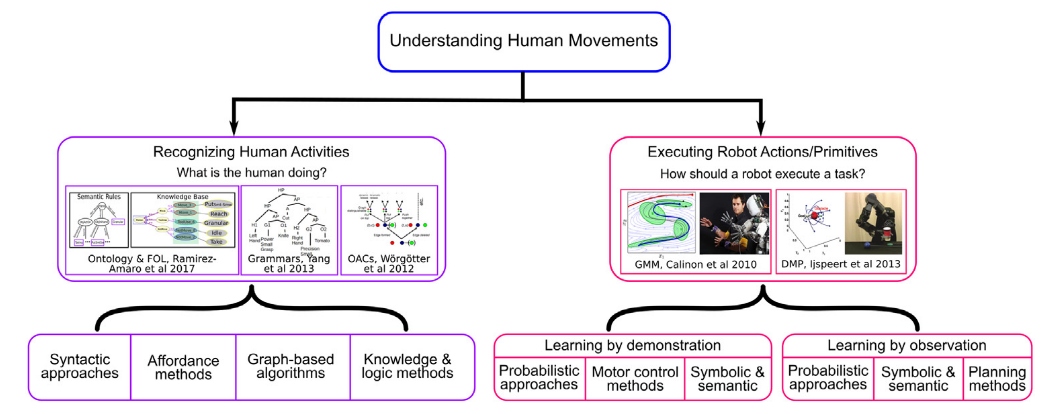

这项调查探索了主要在两个不同的社区开发的不同方法,即人工智能和机器人技术,其共同目标是使机器人能够理解人类的运动(见图2)。 为了完全理解人类的动作,机器人需要正确地解释和学习如何执行演示的动作。 为此,需要考虑两个不同的空间,即问题和执行[20]。 在“问题”空间中对人类活动进行了正确的解释,该问题空间提供了所演示动作的语义描述并表示了与机器人无关的知识,因此,可以将学习到的模型转移到不同领域的不同机器人上。 然后,在执行空间中执行机器人的动作或行为执行,该执行空间包含有关当前机器人参数的特定信息,例如: 机器人运动链。

根据人类运动的复杂性,我们可以将其分为四个不同的抽象级别:(i)流程,(ii)任务,(iii)活动和(iv)基本/动作(见图3)。 在本文中,我们采用这种术语,指的是不同著作的交叉点[4,14,16]。 流程代表最高级别,例如 对水果进行排序,这被定义为顺序任务的组合。 任务,例如 拿起一个橘子,是有序活动的结合。 活动,例如 最原始的语义描述达到一个橙色,最后,原始表示执行一个机器人动作所必需的参数,请参见图3。问题空间和执行空间之间的连接是通过技能图完成的。 这意味着,对于每个活动(问题空间),技能图都将关联一组机器人和环境参数,这些参数是执行机器人执行空间中相应的基本操作/动作所必需的。

图2.本文研究的主要方法来理解人体运动。

本调查的范围仅限于机器人技术领域中用于解决两个主要问题的基于语义的方法:(a)人类活动识别,以及(b)机器人执行所学动作。例如,对于人类活动的识别(参见第2节),主要是在问题空间中进行分析,人们提出了各种方法,例如句法方法[13],提供方法[9],基于图的算法[22]。 ,知识和逻辑方法[16]。另一方面,对于在执行空间中进行分析的机器人动作/行为的执行(请参见第3节),已经提出了两种主要的学习方法。首先,从动觉演示中学习的方法,例如概率方法[23],运动控制方法[24]以及符号和语义方法[25]。其次,用于从观测中学习的算法,例如概率方法[26],符号和语义[1]以及计划方法[27]。图2例示了本次调查中分析的不同基于语义的方法的总体概述。

在进入有关已分析的基于语义的方法的详细信息之前,需要解决以下研究问题:基于语义的方法中通常使用的数据类型是什么—是否存在标准? 哪些机器人应用程序可以从此类方法中受益?

1.2 机器人应用程序的输入数据-是否存在标准?

在机器人技术中,了解人类运动的一个重要因素是可用信息的来源,因为它取决于每个机器人具有的传感器的类型。例如,机器人通常配备有内部摄像头,这些摄像头从以自我为中心的角度捕获有关当前环境的信息。另外,对于摄像机,机器人还包含其他内部传感器以感知环境(请参见图4),例如,激光,激光雷达,机器人编码器信息[24]和触觉信息[21]。这些传感器对于允许机器人与环境交互以完成所需任务非常有用。但是,有时还会使用额外的传感器,例如,单个RGB摄像机[28],RGB-D传感器[10],立体声传感器[29],多个摄像机[30]或运动捕获系统[31],它们可以是安装在重要地点以捕获人类或机器人的动作。如今,随着新技术的发展,可以通过使用虚拟现实系统[32,33]和可穿戴式传感器[34,35]来增强数据的收集,这些系统可以直接从被分析的对象收集信号,而无需杂乱场景中的遮挡问题,这是相机输入的典型问题。

具有来自内部和外部传感器的输入信息可用于不同目的,例如,来自机器人内部传感器的信息主要用于获取有关机器人环境的信息并从Kinesthetic演示中学习必要的执行参数。获得的模型还可以从学习阶段的环境反馈中受益,例如,如果机器人在其末端执行器上具有扭矩/力传感器,则它可以学习抓握满满的瓶子与空的瓶子所需的力。但是,访问不同的机器人传感器具有挑战性,因为有时其他机器人无法使用这些传感器。因此,使用外部传感器是克服此问题的一个很好的选择。从外部传感器(例如YouTube视频)获得的信息已被机器人社区广泛用于识别人类的日常活动。这类信息的主要优点是,可以由不同的研究人员独立于所使用的机器人来使用它,从而导致可能的标准。

分析的另一个重要方面是机器人社区中已提出的不同数据集,用于从外部传感器中提取基于语义的模型。 Huang等人[40]对与对象操作和抓取主题相关的不同数据集进行了非常全面的分析。 表1总结了一些公开可用的数据集,这些数据集已在文献中针对机器人应用中基于语义的方法提出。 例如,德拉托雷等人[36]提出了卡内基梅隆大学烹饪数据集(CMU-MMAC),其中包含5台外部摄像机,1台可穿戴式摄像机,5个麦克风,一个具有以下功能的Vicon运动捕捉系统的多模式信息: 12个红外热像仪,内部测量单元(IMU)和可穿戴设备(eWatch)。

该数据集捕获了执行五种不同烹饪任务(例如准备布朗尼,比萨,三明治,沙拉和炒鸡蛋)的43位受试者的运动。这是一个非常复杂的数据集,可以对由多个传感器捕获的对象的运动进行不同的分析。另一个包含多个相机的数据集是TUM烹调数据集[37],它包含三个位于不同位置的RGB相机和一个可穿戴式凝视相机,其标头安装在对象的头部。使用TUM烹饪数据集,可以从不同的角度和不同的角度分析已执行的任务。该数据集记录了9个主题,涉及两个不同的烹饪任务:制作煎饼和准备三明治。该数据集的有趣组成部分是第一个视图透视图,它是机器人在执行所需任务时所拥有的视图,然后使用此数据集,有可能分析参与者的注意力焦点并将其转移给机器人。

为了捕获人体的运动,人们已经做了一些努力,例如,KIT全身体人体运动数据库[38]。 KIT数据集使用运动捕捉系统,对于人体运动分析,模仿学习,动作识别和机器人运动生成非常有用。这个大规模的数据集包含来自38个对象的全身人体运动,这些对象执行各种各样的操作任务,例如饮酒,摇晃,倾倒,扔东西,准备面团,跳舞等。这是最大的数据集之一机器人技术,除了操纵动作外,还包含运动和手势动作。康奈尔活动数据集[10]包含来自两个数据集的记录,即CAD-60和CAD-120,它们都具有8个人在不同环境(例如办公室,厨房,卧室,和客厅。使用Microsoft Kinect传感器记录了以下动作的人体运动:做谷类食品,刷牙,吃药,堆放物体,微波食品等。康奈尔数据集还提供有关跟踪的人体骨骼和任务注释的信息,活动和能力。另一个还包括操纵活动的语义注释的数据集是MANIAC数据集[39]。 MANIAC数据集记录了8种不同的操作活动,例如推,搅拌,切割,切碎等。所有操作均使用Microsoft Kinect传感器记录,观察5位不同的受试者执行8个不同的任务,每个任务在15个不同的时间执行。

最近,Beetz等人[41]提出了一个名为OpenEASE的在线平台,用于共享不同的数据集。 OpenEASE1是针对机器人的基于Web的知识服务,其中包含语义标记的信息,以供机器人和人类执行的人类日常活动使用。 这个在线平台包含机器人执行比萨饼或早餐准备任务的失败和成功尝试。 捕获并分析了不同机器人的执行情况,这些机器人为机器人传感器提供了语义。 可能,opeEASE将允许不同的用户上载他们的机器人实验执行文件,以与社区共享。 这代表着定义基准的第一步,该基准用于从人或机器人执行中测试带有语义标记的活动。

本文的其余部分安排如下,第2节介绍了用于识别人类活动的基于语义的方法。 然后,第3节介绍了允许机器人执行所学动作的方法。 最后,第4节介绍了本文的最后评论。

2.基于语义的识别方法

基于语义的方法背后的主要目标是开发一种方法,该方法可以将连续的现实世界事件映射为有意义的概念,这将有助于理解所演示任务的含义。提取语义表示的好处之一是允许学习方法更灵活,更适应新情况,并可以转移到不同的机器人上。基于语义的方法通常被认为是分层方法,其中需要不同级别的抽象以从演示的动作中提取有意义的信息。分层方法能够识别过程,任务和活动,所有这些都具有复杂的时间结构[15,16,42]。例如,清洁厨房的过程可以通过检测一些任务来识别,例如擦拭碗碟和干燥盘子。擦碗任务也可以通过检测活动的顺序来识别,例如触摸和抓住海绵。这种分层结构在基于语义的方法中得到了广泛的利用。分层方法适用于人类和/或物体之间的语义级别的分析。另外,他们能够通过将先验知识整合到他们的表示中来处理较少的训练数据[14,54]。

在本文中,我们将基于语义的方法分为四类:句法方法,基于负担的方法,图形方法以及基于知识和逻辑的推理方法。 表2列出了与这些类别相对应的一些作品,这些作品将在本节的其余部分中进行介绍。

2.1 句法方法

句法方法定义符号字符串以模拟人体运动。 每个符号都与一个人类活动相关联,并且使用一组规则来标识每个活动。 这些规则定义每个活动的含义或语义。 然后,人类活动被解释为一组生产规则,可以使用语言或语法算法进行定义。

2.4 基于知识和逻辑的推理方法

知识和推理在处理部分可观察的信息中起着至关重要的作用。 这是可能的,因为它们能够像我们(人类)所做和期望的那样,推断或预测不同的运动。 之所以能够部分获得这一信息,是因为这样的事实,即知识库系统可以将常识与世界的当前感知相结合,以推断出当前状态的隐藏方面。 关键因素是开发获取适当知识和推理规则的方法,以从感知到的环境中推断出有意义的关系。

建立适当的知识库需要仔细的域分析过程,选择适当的语音并对推理引擎进行编码以获得所需的推论。在这方面,Tenorth和Beetz [55]提出了KnowRob(机器人知识)使用Web本体语言(OWL)定义机器人知识的实用方法,该语言是一种动作表示形式,它使用序言查询来加载,存储和推理关于知识库。机器人在执行动作时会收集经验,并将其用于学习基于感知和动作系统的动作相关概念的模型和方面。 KnowRob本体是OpenCyc本体的扩展,OpenCyc本体是涵盖了广泛人类知识的通用上层本体。最近,Beetz等人[48]提出了第二代机器人知识KnowRob2,其主要优点是可以按需生成许多逻辑表达式,机器人可以获取开放式操作技能以及有关不同操作参数的原因。更现实地,请参见图14。借助KnowRob2,机器人能够识别诸如伸手,抓住,放置等活动以及诸如设置桌子之类的任务。

Ramirez-Amaro等人[16]提出了一种基于KnowRob的新颖推理和知识库方法,该方法可以自动识别人类活动。 作者介绍了一种基于语义的两步方法,该方法包括从视频中提取低级特征,并且作为第二阶段,该方法自动生成紧凑的语义规则(高级),以确定性地推断和识别人。 来自观察结果的活动,请参见图15。这些语义规则用于开发基于一阶逻辑的推理方法,以定义手势与对象之间的有意义的关系。 然后,改进了推理方法,可以在线识别所观察到的活动,以进行家庭活动,例如制作煎饼和准备三明治[28]。

此外,这种改进使推理系统可以按需学习新的活动。由于此方法具有在线特性,因此在iCub机器人的控制回路中实现了该方法,该机器人可以自动分割并识别人类活动,例如伸手,抓地和砍伐。后来,使用另一种场景和从虚拟环境中获得的不同输入信息(例如信号(3D信息))验证了这种推理方法[32]。在这种情况下,分析的运动是从随机人操纵的虚拟机器人中获得的,因此,这些运动相对于人类运动的变化预计会有所不同。然后,作者证明,从三明治制作过程中从人体运动中获得的提取的语义规则可以被视为面对新环境时的经验,因为提取了运动的含义,例如,到达小刀在语义上是相同的。即使从人类或机器人获得分析的轨迹,也可以到达瓶子。

然后,Ramirez-Amaro等人[69]通过包括一个依赖表扩展了这种推理方法,该依赖表允许推理系统处理双臂活动,例如:左手握住面包,而右手切面包。所获得的语义表示对于同一活动的不同演示样式而言是健壮的且不变的。最近,Ramirez-Amaro等人[37]结合了第一眼和第三眼观察的信息,以识别人类活动,例如伸手,割肉,争夺等,并使用TUM烹饪数据集和CMU-MMAC数据集(请参见表1)。由于包括了新的传感器,因此可以提取来自环境的新信息,例如,被摄对象的眼睛关注的焦点。这项研究表明,从外部相机获得的信息与以自我为中心的信息之间存在很强的相关性,事实上,它们相互补充,从而提高了识别精度。这是一个非常有趣的发现,因为它有助于处理摄像机的遮挡问题。

Gehrig等[49]提出了一个学习框架,该框架将有关研究领域的知识与混合动态贝叶斯网络(HDBN)相结合,以推断不同的任务,例如准备谷物,擦桌子,煮布丁等。 这些任务,首先需要使用隐马尔可夫模型(HMM)估计活动(例如,将对象放在桌子上),然后使用上下文无关的语法对活动序列进行建模。 之后,通过添加二进制随机变量来表示场景中每个对象的存在或不存在,从而在模型中引入了有关域的知识。 模型中包含的另一个可改善结果的知识参数是一天中的时间,例如 上午,下午或晚上。

诸如HMM的推理方法取决于拥有正确数量的数据来训练和测试所获得的模型。为此,已经提出了零射击学习范例,该范例涉及机器学习方法,其中局部类没有可用的训练数据,但包含这些类的一些语义描述。这些模型试图最小化训练数据集的数量并减少对训练数据集的依赖,而极端情况是系统能够对之前未曾见过的动作进行分类,而无需任何事先训练[70,71]。通常,三个条件使零击学习识别系统可行:(1)提供标签嵌入作为类的矢量表示,需要通过人工标记[72,73]或自动过程[74]提供; (2)嵌入表示应允许知识从可见的类别转移到看不见的类别[75]; (3)嵌入空间适当地弥合了低级图像特征和高级对象类之间的语义鸿沟[76]。例如,Cheng等人[56]提出了一种语义属性顺序模型,该模型考虑了活动的层次结构和顺序类型,从而无需训练样本即可识别未见新活动。上推或下蹲,请参见图16。为此,作者设计了一个概率图形模型,该模型是条件随机场(CRF)的变体,用于建模来自可穿戴设备的惯性传感器的顺序数据在时间上的依赖性。在这种情况下,作者手动定义了活动属性矩阵,该矩阵是提取的属性与可见/不可见活动之间的相关性。通过包括最小的用户反馈,该方法已经扩展到活动的识别,在此,作者开发了一种主动学习算法[77]。

有几个未解决的问题尚未完全由知识和基于逻辑的方法解决,例如,对于稀有或新颖的动作,所获得的语义表示的鲁棒性如何?如果没有先验描述,如何合并新类别?如何整合人类对环境的知识以丰富语义描述?已经提出了几种解决方案,例如Nyga和Beetz [78]提出使用概率关系知识库从自然语言指令中获取知识。这是通过诸如wikihow.com之类的数据挖掘网站实现的,该网站提供了执行日常任务的书面说明,例如准备一餐饭。知识库的组织是使用提议的语义聚类技术获得的,该语义聚类技术基于从指令中提取的有关WordNet类分类法的概念之间的距离度量。 Nguyen等人[71]提出了基于特征和基于属性的学习(FE-AT)方法,该方法通过考虑新活动的语义含义及其与现有活动的关系,扩展了传统的基于监督/基于特征的方法。例如,骑自行车的新活动将与现有的活动(如骑摩托车或跑步)相关。该方法在很大程度上取决于两个因素:(1)属性检测的准确性; (2)属性向量表示的唯一性,因为某些活动可以用相同的属性表示(例如,站立,躺着和坐着)。最近,贝茨等人[33]提出了一种基于本体的推理方法,该方法从虚拟现实系统中收集了人类的活动。作者扩展了Ramirez-Amaro等人[32]的工作,其中包括一种学习方法,该方法可以通过连续观察自动构建所有观察到的活动及其关系的图形表示。该方法从演示中自动提取相关特征,然后使用提出的本体推理方法对人类动作进行连续分割,同时对已知活动和未见活动进行分类(见图17)。这种方法的主要优点是无需事先培训就可以学习新的/未见的活动。

3. 基于语义的机器人执行方法

在上一节中,介绍了几种基于语义的方法来解决识别人类活动和任务的问题。 但是,为了使机器人完全理解一个活动的含义,机器人还需要学习并提取必要的参数,以允许执行推断的活动。 例如,当机器人正确地识别出该活动并且能够知道闭合抓爪是为了抓取目标物体而执行的正确原语时,机器人便会理解抓握的含义。 本节介绍了广泛研究的方法来教机器人新的动作和任务。

机器人需要不断学习新技能并使现有技能适应新情况的能力。教导机器人新动作的主要形式有两种,一种是通过物理指导它们,也称为通过演示编程;另一种是观察人类的动作,即通过观察/观察进行编程。机器人社区主要研究从演示或观察到的运动中学习机器人参数(技能)的技术(见图2)。提取的参数允许机器人执行学习到的动作。将学习模型转移到机器人的一项重大挑战是正确识别执行学习到的动作的相关参数。为此,已经研究了两个主要方面[79]:(1)获得模型以在机器人上复制相似的人类动作,以及(2)通过使人类动作适应机器人实施例来提取动作的含义。为了解决上述问题,文献中已经提出了不同的学习技术,例如概率算法,符号方法,语义方法和计划算法(请参见表3)。 Argall等人[80]提出了一项详细的调查,该调查主要讨论了通过示范方法学习的方法,该方法侧重于找到世界状态与机器人动作之间的最佳映射(通常称为策略)。这项工作与这项工作之间的主要区别在于,本次调查中的分析方法侧重于提取所学动作的含义。

以下小节介绍了一些基于语义表示的经典方法和最新技术,这些方法允许机器人正确执行已演示或观察到的动作或任务,请参见表3。首先,介绍了通过演示方法学习的方法,该方法 主要分为三类,例如运动控制,概率方法以及符号和语义方法。 其次,介绍了通过观察法进行学习的方法。 在以下三个类别中对这些方法进行了解释,分别是概率,符号和语义以及计划算法。 这种类型的方法中使用的词汇是原语或动作,技能和任务(见图3)。