多变量线性回归

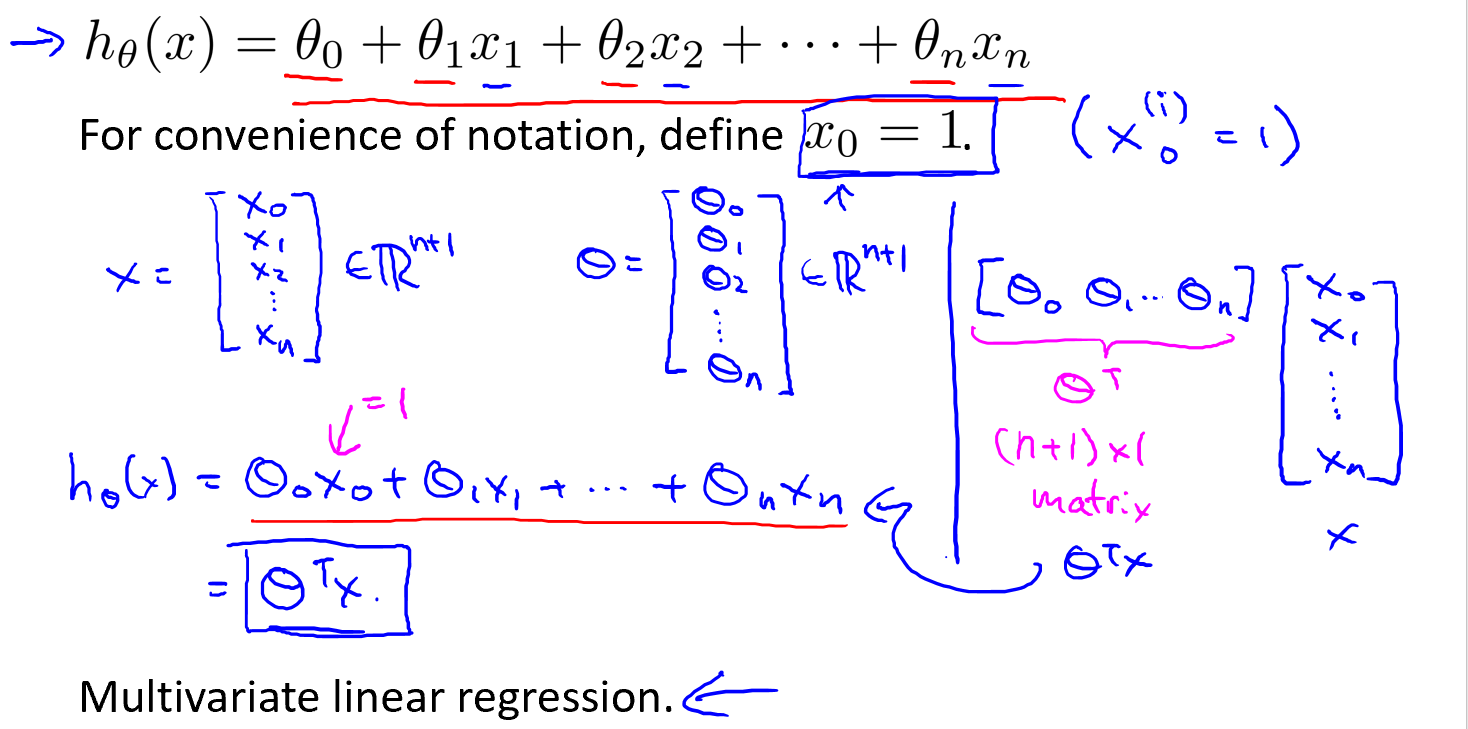

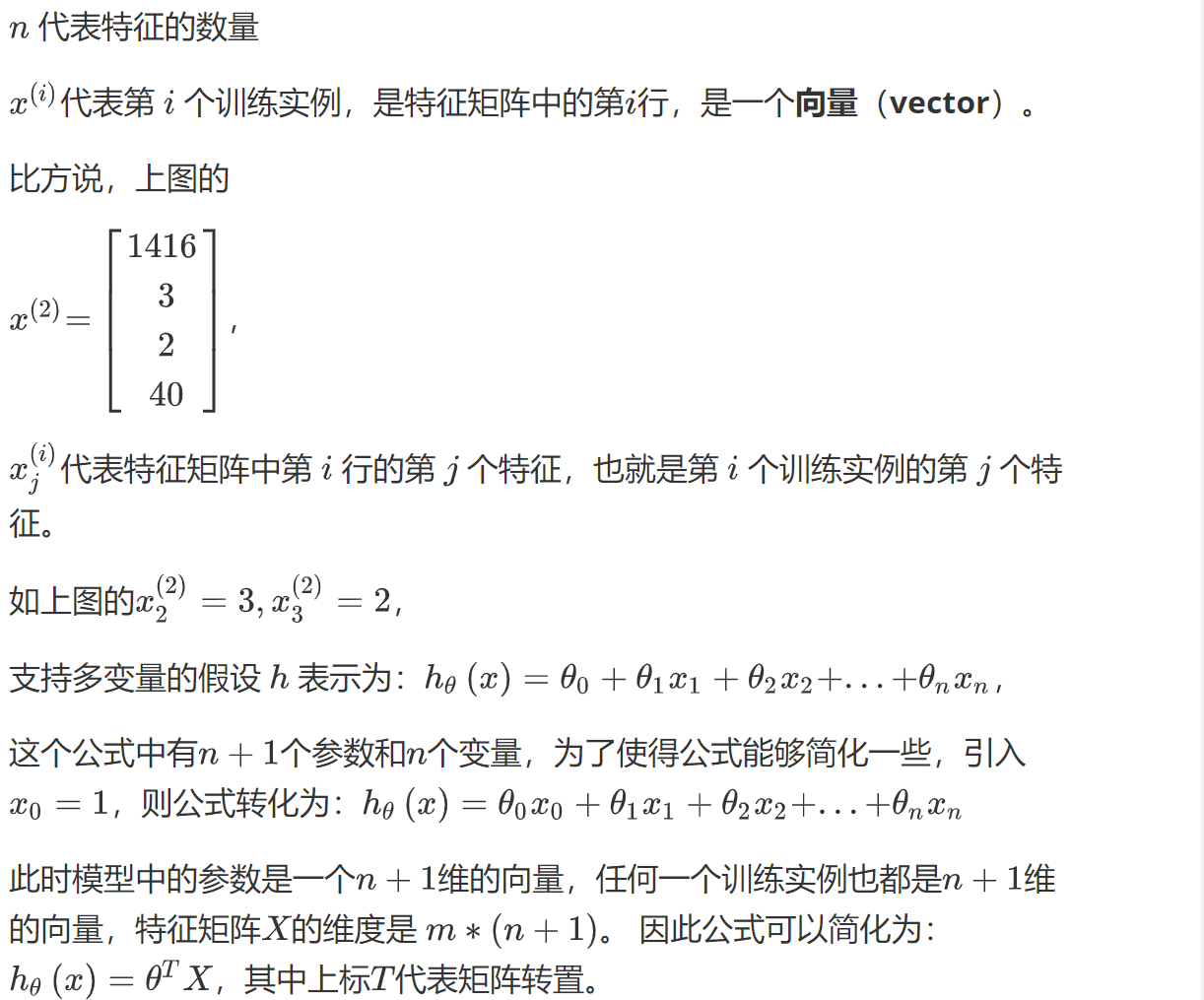

一、多维特征

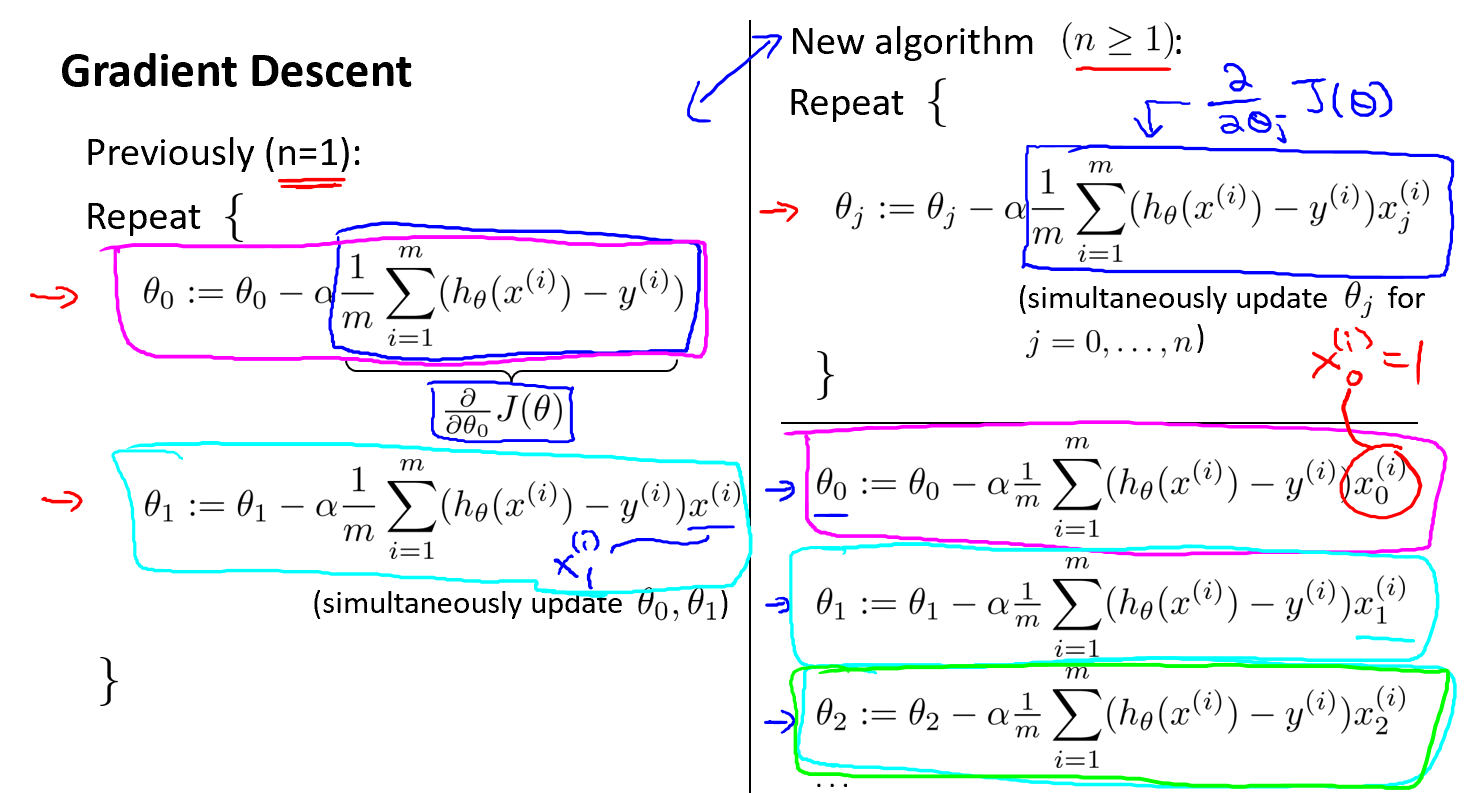

二、多变量梯度下降

Python代码:

def computeCost(X, y, theta):

inner = np.power(((X * theta.T) - y), 2)

return np.sum(inner) / (2 * len(X))

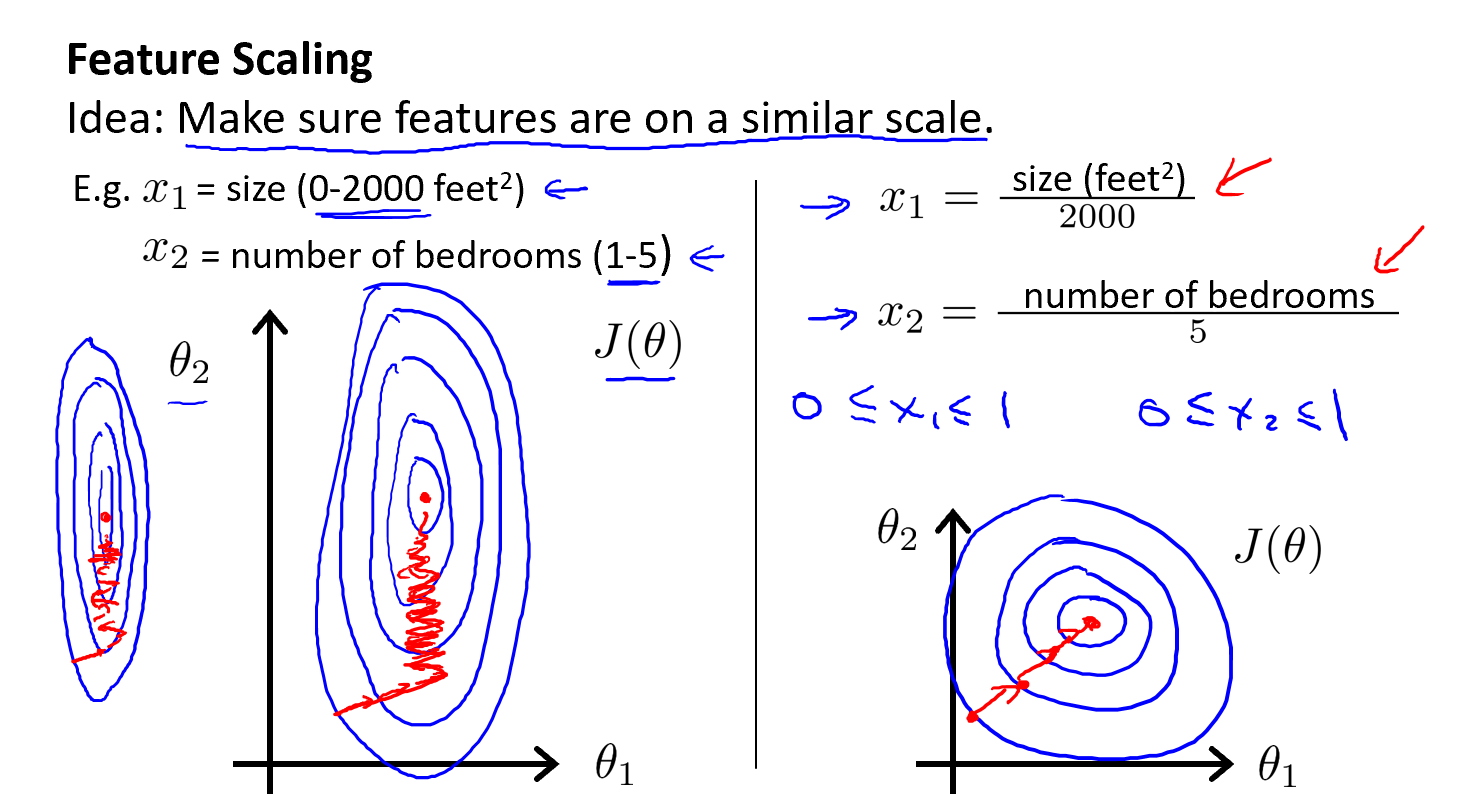

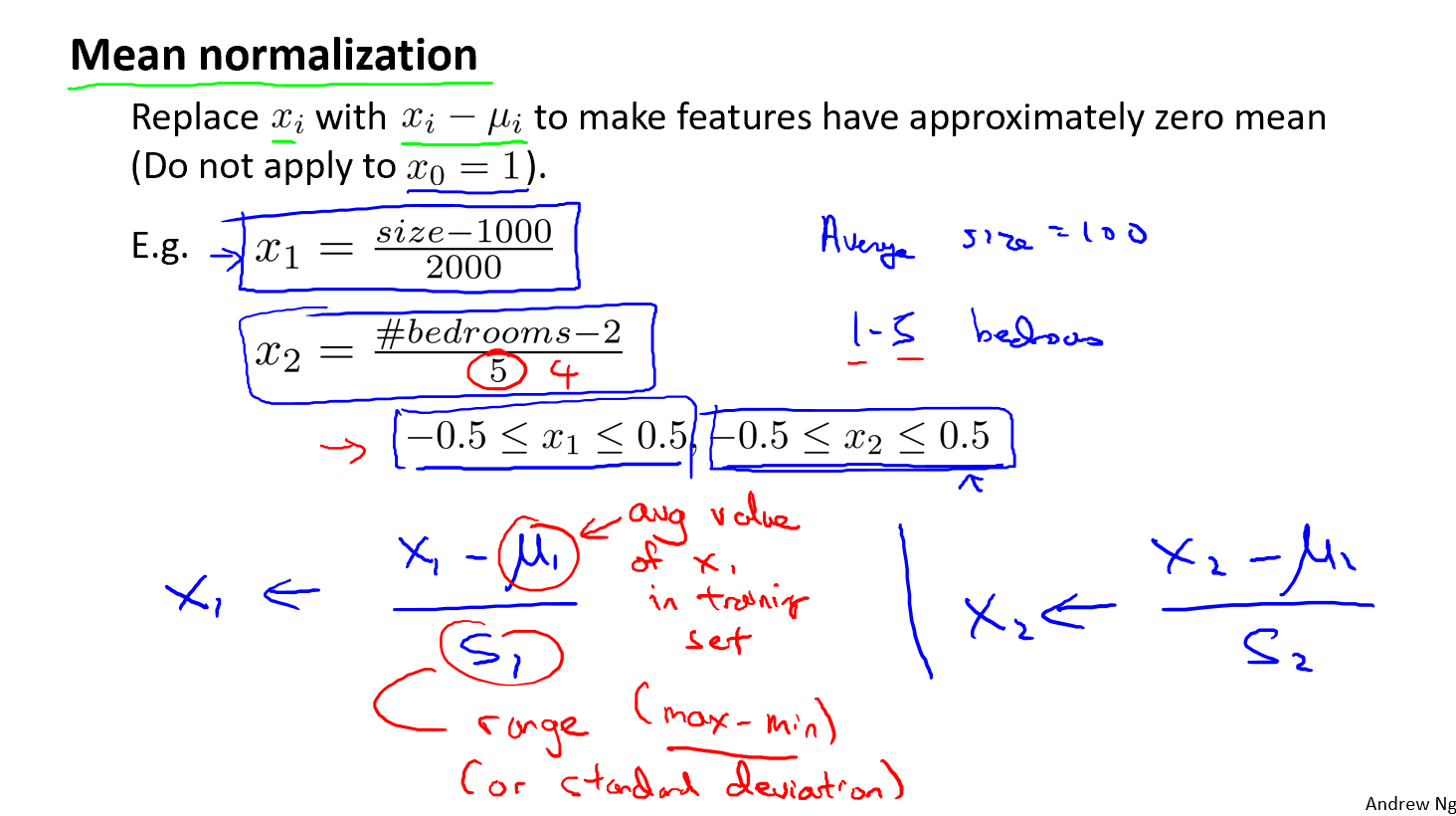

三、梯度下降法实践-特征缩放

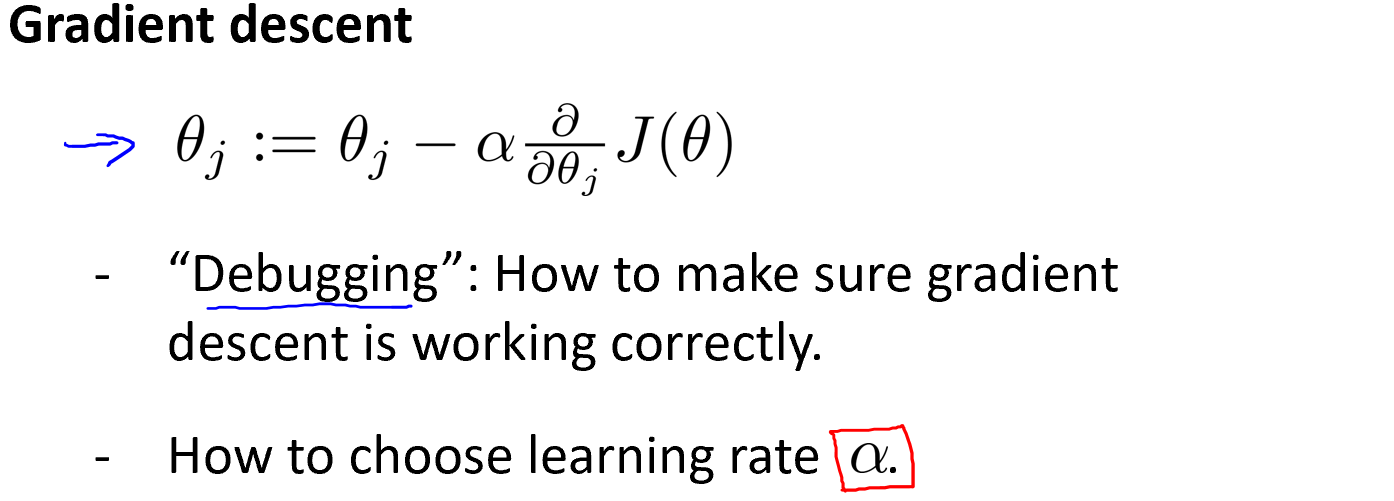

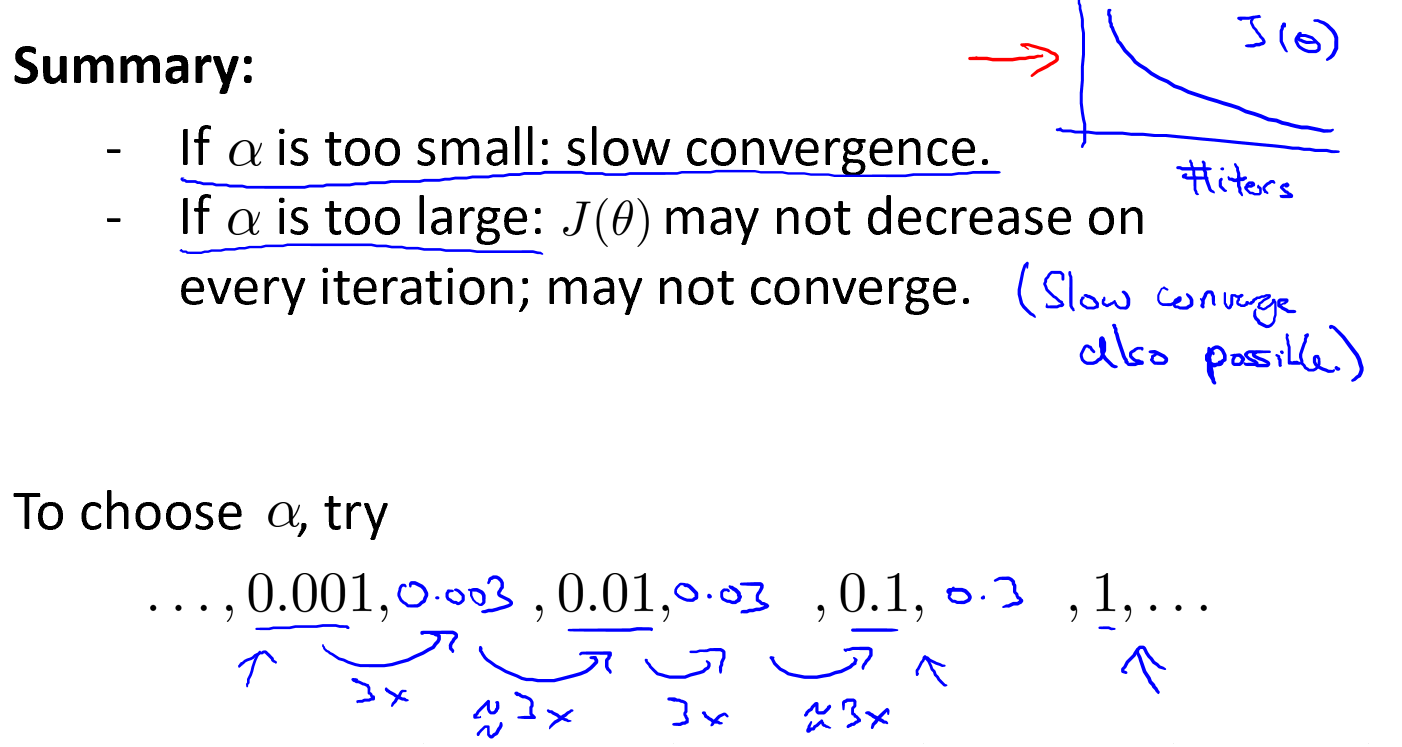

四、梯度下降法实践-学习率

梯度下降算法收敛所需要的迭代次数根据模型的不同而不同,我们不能提前预知,我们可以绘制迭代次数和代价函数的图表来观测算法在何时趋于收敛。

梯度下降算法的每次迭代受到学习率的影响,如果学习率α过小,则达到收敛所需的迭代次数会非常高;如果学习率α过大,每次迭代可能不会减小代价函数,可能会越过局部最小值导致无法收敛。

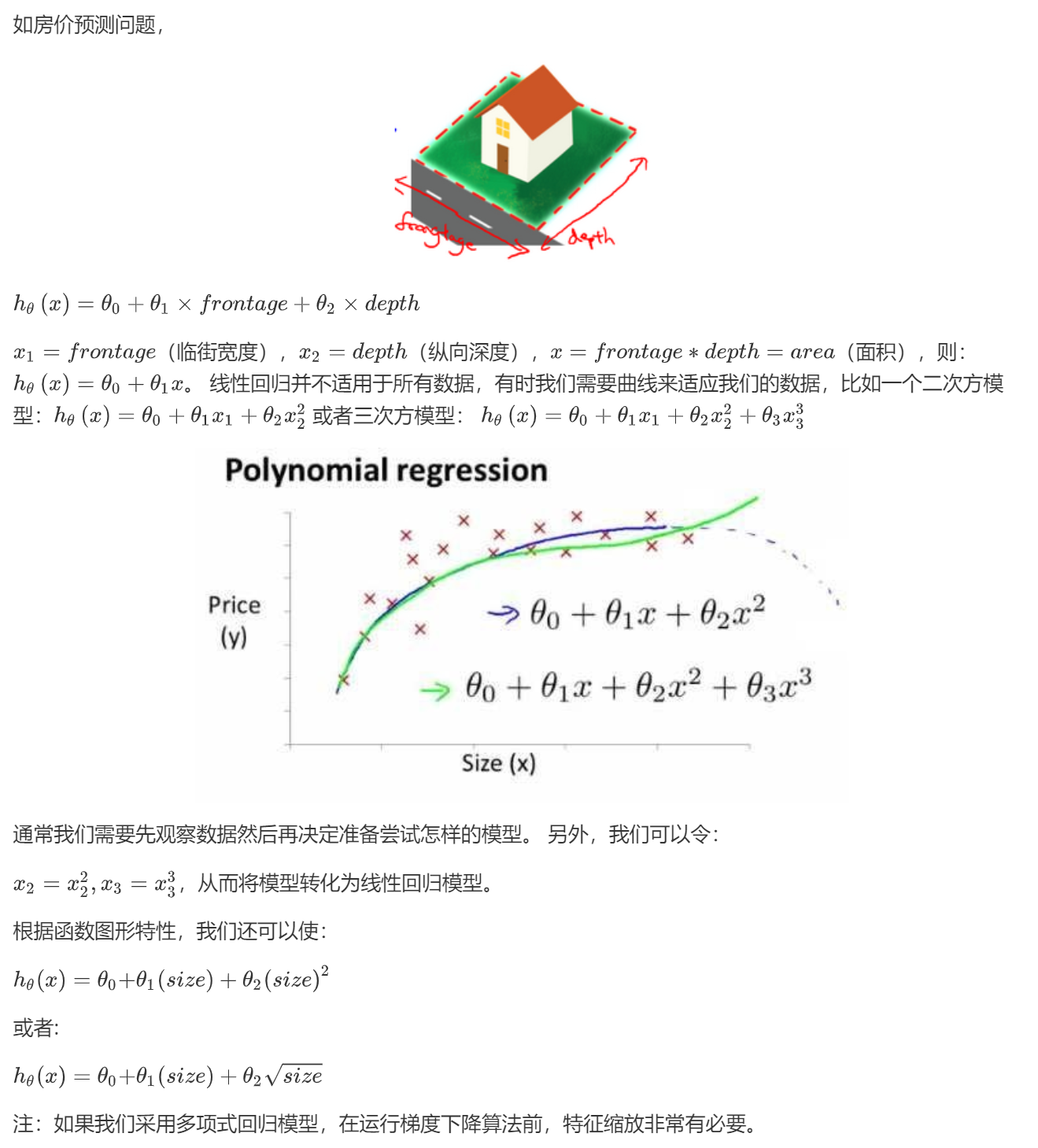

五、特征和多项式回归

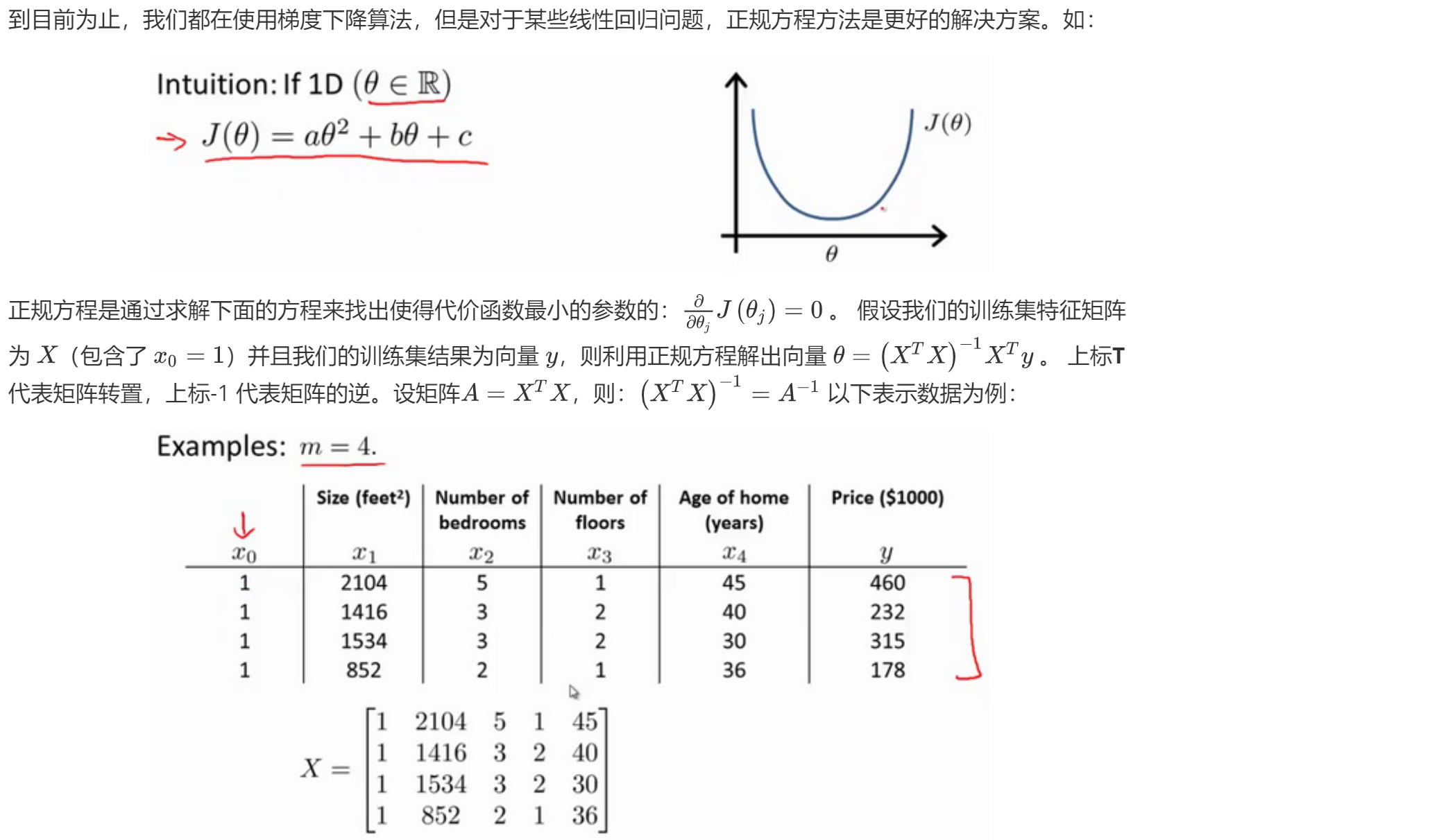

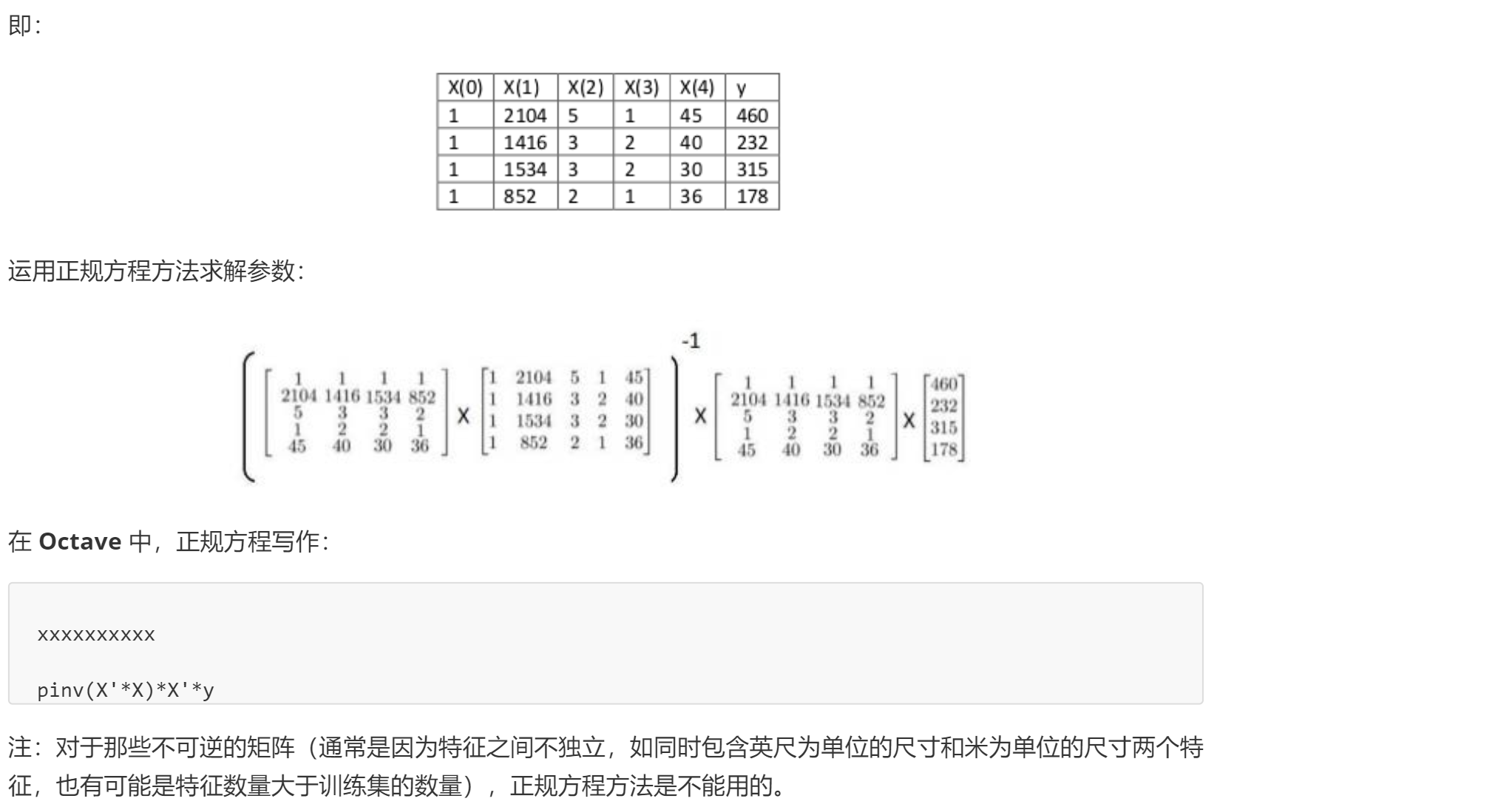

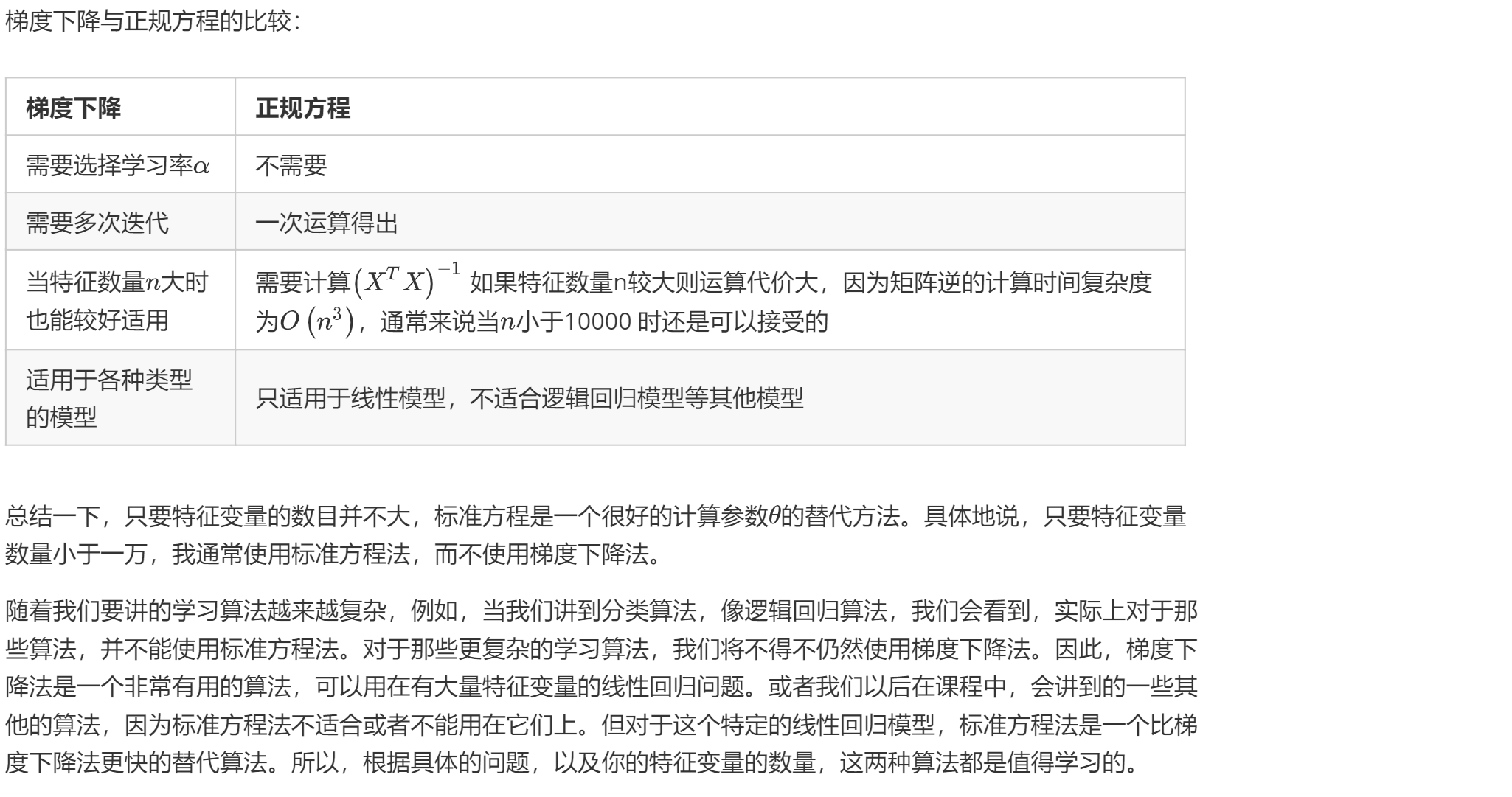

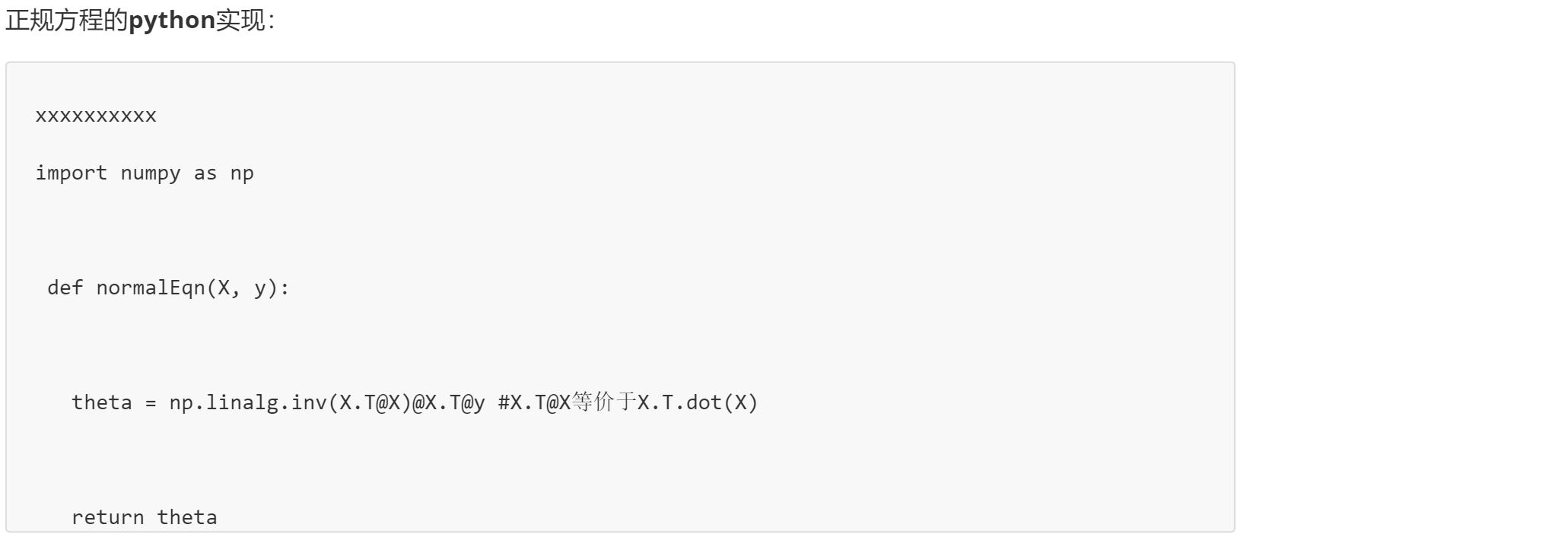

六、正规方程

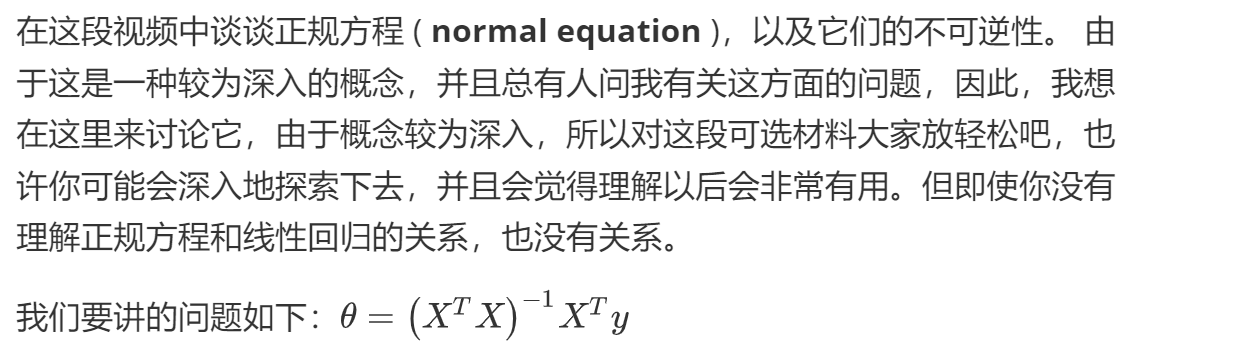

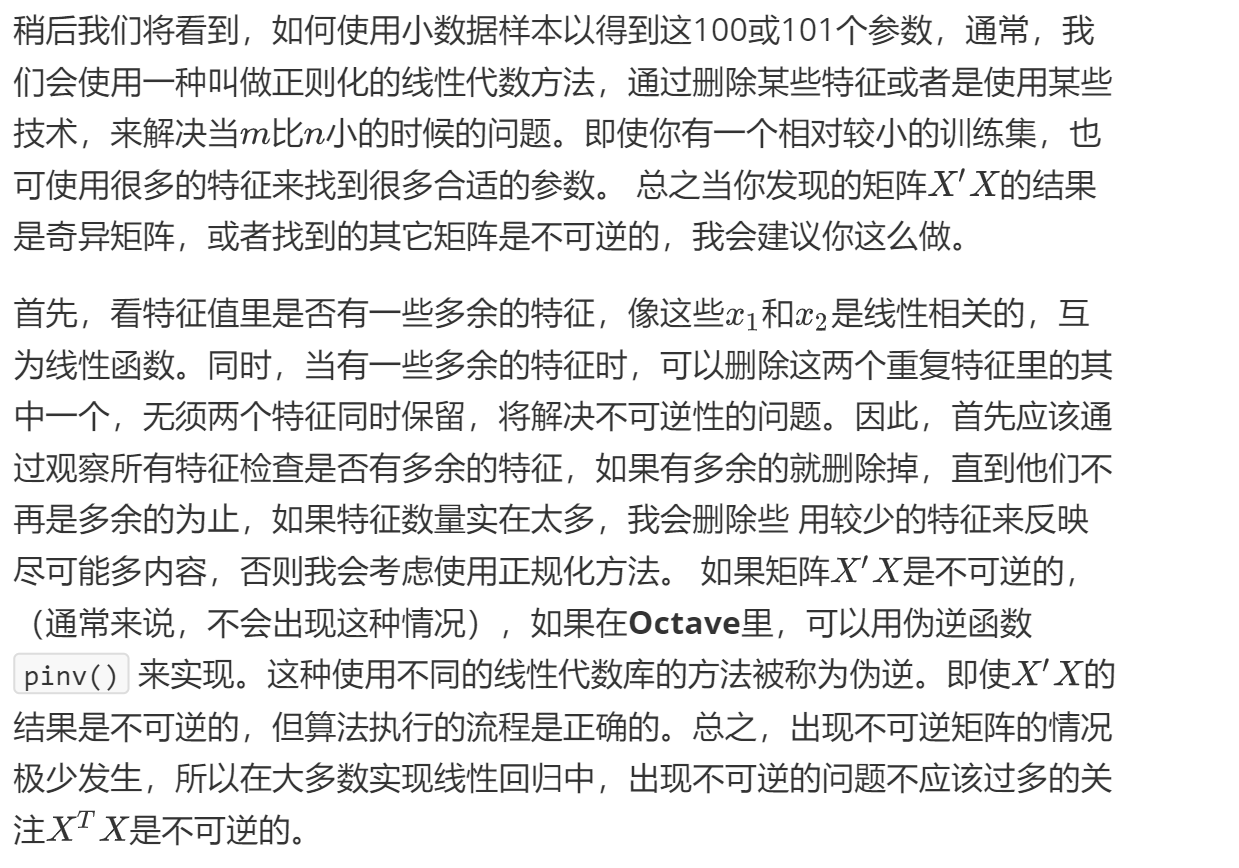

七、正规方程及不可逆性

参考-黄海广博士