Paper:

Practical Black-Box Attacks against Machine Learning

一、介绍

概况:Ian Goodfellow大神研究如何在不知道model内部结构和训练数据集的情况下(黑盒),产生adversarial example误导DNN分类器。

成果:

1)需要一个“人造”数据集,用于训练“替代”model,如何产生?

2)对不同DNN攻击

3)减少query的方法,在训练“替代”model时

4)为什么可以用“替代”model,附录B中解释

二、威胁模型

初始sample + 扰动,使得分类器结果不等于正确结果(出错)。问题转化为:优化找到最小扰动。

三、黑箱策略

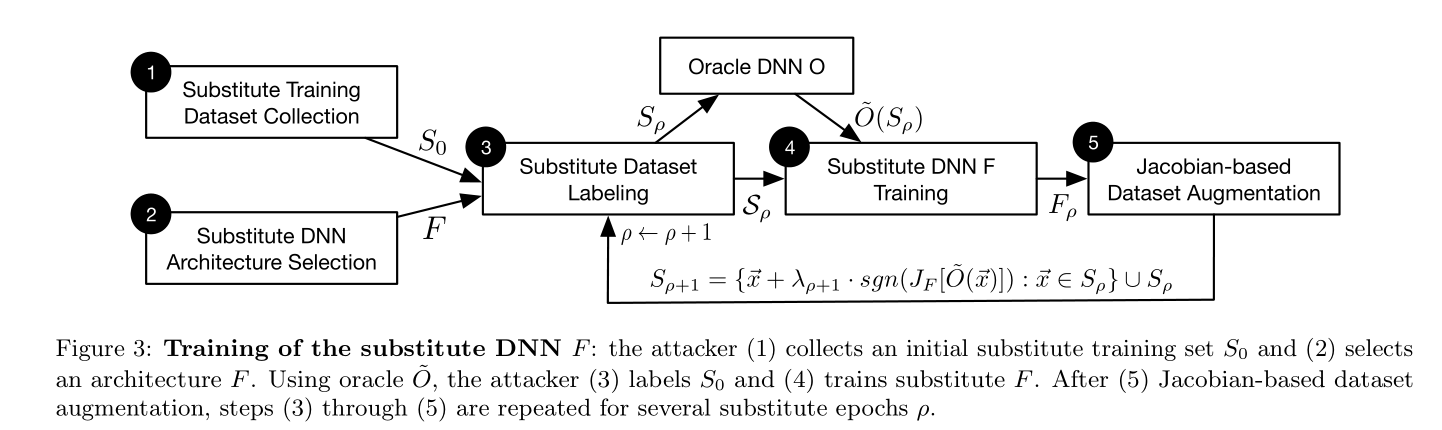

1. “替代”model训练

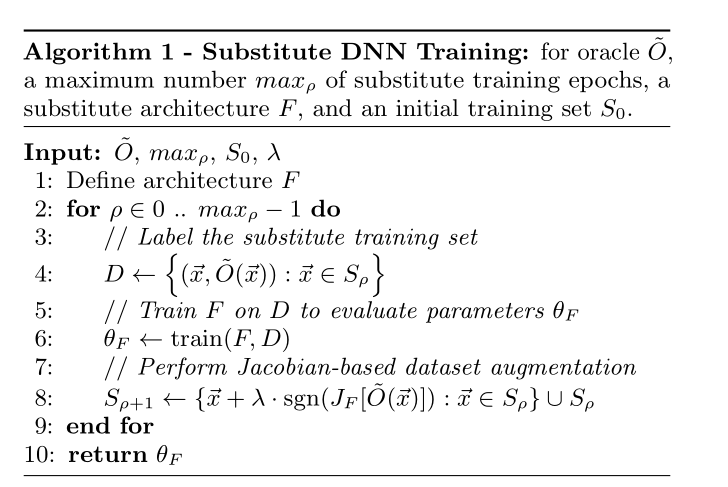

减少query:使用“Jacobian-based Dataset Augmentation”

即启发式:由一组初始数据,然后根据目标model输出变化的方向,产生其余数据。

1.1model的结构

论文指出:类型、层数、数量对攻击成功与否影响较小;若要提高准确率,需研究此问题。

遍历目标model整个输入空间从而获得输出不现实。

训练“替代”model的算法

1.2 产生adversarial example

fast gradient sign method

Ian J Goodfellow, et al. Explaining and harnessing adversarial

examples. In Proceedings of the International Conference on

Learning Representations, 2015.