最近在研究金融舆情分类的工作,所以调研了一些这方面的内容。

如果对这一块不了解的朋友,首先可能需要先了解下google发布的bert,其实我也是现学的。

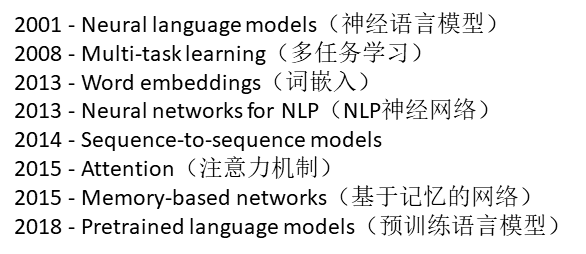

NLP的发展历程经过了下面几个阶段,到18年,由google发布的bert在NLP任务上取得不错的成绩,后续近几年就变成预训练模型的世界了。

NLP发展历程:

既然预训练模型这么厉害,那么接下来我们来讲讲什么是预训练模型?

举个例子,假设我们有大量的维基百科数据,那么我们可以用这部分巨大的数据来训练一个泛化能力很强的模型,当我们需要在特定场景使用时,例如做文本相似度计算,那么,只需要简单的修改一些输出层,再用我们自己的数据进行一个增量训练,对权重进行一个轻微的调整。预训练的好处在于在特定场景使用时不需要用大量的语料来进行训练,节约时间效率高效,bert就是这样的一个泛化能力较强的预训练模型。bert相比较之前的模型优势在于:

1、利用masked LM 来做双向encoding

2、句子级表示

来自bert预模型的几个不同模型,中文的选择bert-base,Chinese即可。

可以参考这篇github来进行情感分类。

https://github.com/renxingkai/BERT_Chinese_Classification

针对bert的模型,后续也有一些改进模型,例如erine1.0,在预训练阶段引入知识,erine2.0,在预训练阶段引入多任务学习等。

参考资料:

1、https://blog.csdn.net/chunyun0716/article/details/83660390

2、https://www.jiqizhixin.com/articles/2019-08-26-16

3、https://www.cnblogs.com/rucwxb/p/10277217.html

4、https://blog.csdn.net/sunhua93/article/details/102764783

5、https://zhuanlan.zhihu.com/p/46652512