tf.nn.softmax( logits, axis = None, name = None dim = None )

- 作用:softmax函数的作用就是归一化。

- 输入:全连接层(往往是模型的最后一层)的值,一般代码中叫做logits

- 输出:归一化的值,含义是属于该位置的概率,一般代码叫做probs,例如输出[0.4, 0.1, 0.2, 0.3],那么这个样本最可能属于第0个位置,也就是第0类。这是由于logits的维度大小就设定的任务的类别,所以第0个位置就代表第0类。softmax函数的输出不改变维度的大小。

- 用途:如果做单分类的问题,那么输出的值就取top1(最大, argmax); 如果做多分类问题,那么输出的值就取topN

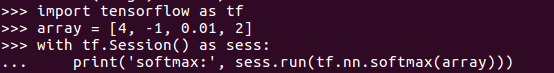

例子:

输出:

从结果中分析出array最有可能属于第0类(一共四类)

如果想进一步了解softmax的原理,可以参考这篇文章:https://zhuanlan.zhihu.com/p/93054123