最近在在学习强化学习方面的东西, 对于现有的很多文章中关于强化学习的知识很是不理解,很多都是一个公式套一个公式,也没有什么太多的解释,感觉像是在看天书一般,经过了较长时间的挣扎最后决定从一些基础的东西开始入手,于是便有了这篇论文的发现。

Learning from Delayed Reward

该论文的页面为: http://www.cs.rhul.ac.uk/~chrisw/thesis.html

下载地址为: http://www.cs.rhul.ac.uk/~chrisw/new_thesis.pdf

论文页面对这篇文章的描述:

The thesis introduces the notion of reinforcement learning as learning to control a Markov Decision Process by incremental dynamic programming,

and describes a range of algorithms for doing this, including Q-learning, for which a sketch of a proof of convergence is given.

这篇文章虽然在现有的很多文献中并不是很被提及,但是它却具有很大的意义。这篇文章(准确的说是作者在1987年发表的一篇会议论文,集成在了这篇学位论文中了)建立了现在意义上的强化学习模型,它第一次将trial-and-error 和 dynammic programming 和 temporal diffecrence 结合在了一起,并提出了Q-Learning算法。在某种意义上它可谓是“万恶之源”。

=====================================================

============================================================

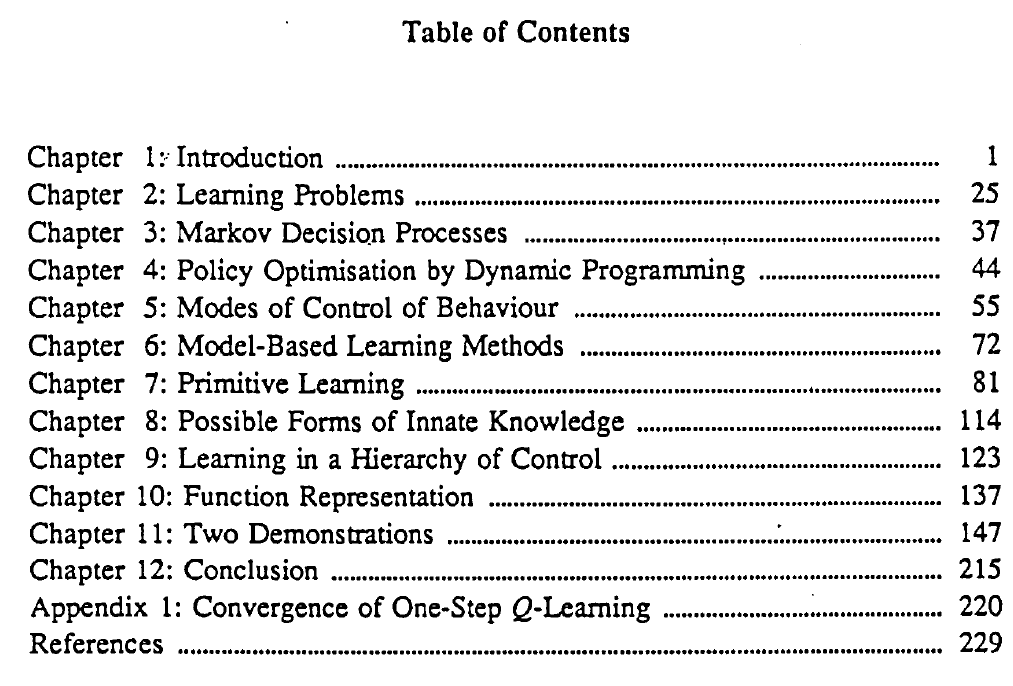

文章目录: