https://www.sohu.com/a/315828105_505897

芯片

http://www.openedv.com/forum.php?mod=viewthread&tid=284851

https://www.espressif.com/zh-hans/products/socs/esp8266/overview

1. SLAM技术

SLAM(Simultaneous Localization and Mapping)

同步定位与地图构建,最早在机器人领域提出,它指的是:机器人从未知环境的未知地点出发,在运动过程中通过重复观测到的环境特征定位自身位置和姿态,再根据自身位置构建周围环境的增量式地图,从而达到同时定位和地图构建的目的。由于SLAM的重要学术价值和应用价值,一直以来都被认为是实现全自主移动机器人的关键技术。

通俗的来讲,SLAM回答两个问题:“我在哪儿?”“我周围是什么?”,就如同人到了一个陌生环境中一样,SLAM试图要解决的就是恢复出观察者自身和周围环境的相对空间关系,“我在哪儿”对应的就是定位问题,而“我周围是什么”对应的就是建图问题,给出周围环境的一个描述。回答了这两个问题,其实就完成了对自身和周边环境的空间认知。有了这个基础,就可以进行路径规划去达要去的目的地,在此过程中还需要及时的检测躲避遇到的障碍物,保证运行安全。

2. SLAM发展简介

自从上世纪80年代SLAM概念的提出到现在,SLAM技术已经走过了30多年的历史。SLAM系统使用的传感器在不断拓展,从早期的声呐,到后来的2D/3D激光雷达,再到单目、双目、RGBD、ToF等各种相机,以及与惯性测量单元IMU等传感器的融合;SLAM的算法也从开始的基于滤波器的方法(EKF、PF等)向基于优化的方法转变,技术框架也从开始的单一线程向多线程演进。

VSLAM

基于视觉的Visual SLAM逐渐开始崭露头角,简称VSLAM。

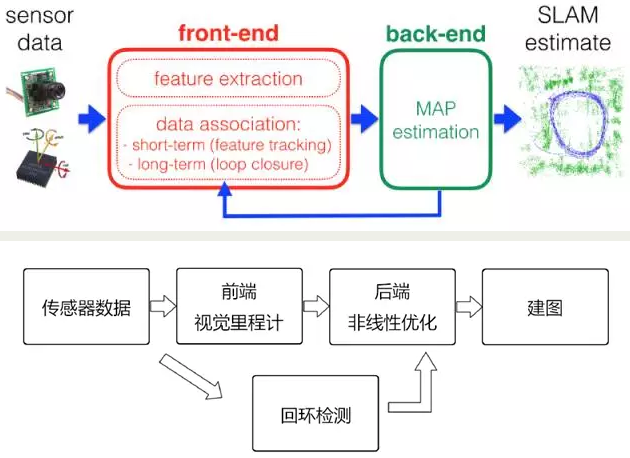

VSLAM的技术框架主要包括传感器数据预处理、前端、后端、回环检测、建图。

摄像头

ToF与结构光、双目视觉技术(StereoVision)一起,共同组成了当前3D摄像头的三条主流技术路线。

3D结构光(Structured Light)

3D结构光技术的基本原理是,通过近红外激光器,将具有一定结构特征的光线投射到被拍摄物体上,再由专门的红外摄像头进行采集。这种具备一定结构的光线,会因被摄物体的不同深度区域,而采集不同的图像相位信息,然后通过运算单元将这种结构的变化换算成深度信息,以此来获得三维结构。简单来说就是,通过光学手段获取被拍摄物体的三维结构,再将获取到的信息进行更深入的应用。

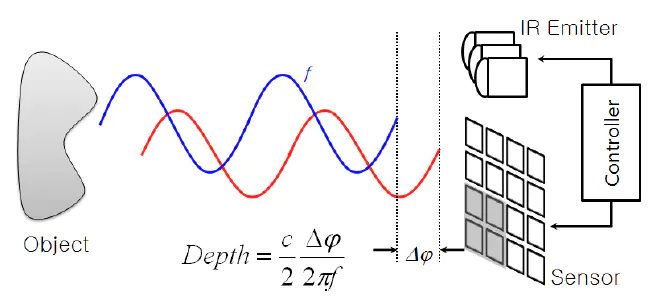

ToF(Time Of Flight)

手机摄像头中的飞行时间(TimeofFlight,ToF)技术

http://www.moqiehome.net/news/3067.html

简单来说就是,发出一道经过处理的光,碰到物体以后会反射回来,捕捉来回的时间,因为已知光速和调制光的波长,所以能快速准确计算出到物体的距离。

3D结构光和ToF优缺点总结

| -- | 结构光 | ToF |

|---|---|---|

| 基础原理 | 单相机和投影条纹斑点编码 | 红外光反射时间差 |

| 响应时间 | 慢 | 快 |

| 低光环境表现 | 良好,取决于光源 | 良好(红外激光) |

| 强光环境变现 | 弱 | 中等 |

| 深度精确度 | 中等 | 低 |

| 分辨率 | 中等 | 低 |

| 识别距离 | 短,受光斑图案影响 | 中等(1-10m),受光源强度限制 |

| 软件复杂度 | 中等 | 中等 |

| 材料成本 | 高 | 中等 |

| 功耗 | 中等 | 低 |

| 缺点 | 容易受光照影响 | 总体性能好、平面分辨率低 |

| 代表厂商 | iPhone X、Prime Sense、英特尔 | 英飞凌、微软、意法半导体 |

参考: