实现代码:

from sklearn.feature_extraction.text import CountVectorizer from sklearn.feature_extraction import DictVectorizer import jieba def cut_word(text): return " ".join(list(jieba.cut(text))) def chinese_count(): data = ["bili一般指bilibili。哔哩哔哩现为中国年轻世代高度聚集的文化社区和视频平台,该" "网站于2009年6月26日创建,被粉丝们亲切地称为“B站”。2018年3月28日,哔哩哔哩在美国纳斯达克上市。", "bilibili是国内知名的视频弹幕网站,这里有最及时的动漫新番,最棒的ACG氛围,最有创意的Up主。大家可以在这里找到许多欢乐。"] list = [] for temp in data: list.append(cut_word(temp)) print(list) transfer = CountVectorizer() new_data = transfer.fit_transform(list) names = transfer.get_feature_names() print("特征名字是: ", names) print(new_data.toarray()) print(new_data) if __name__ == '__main__': chinese_count()

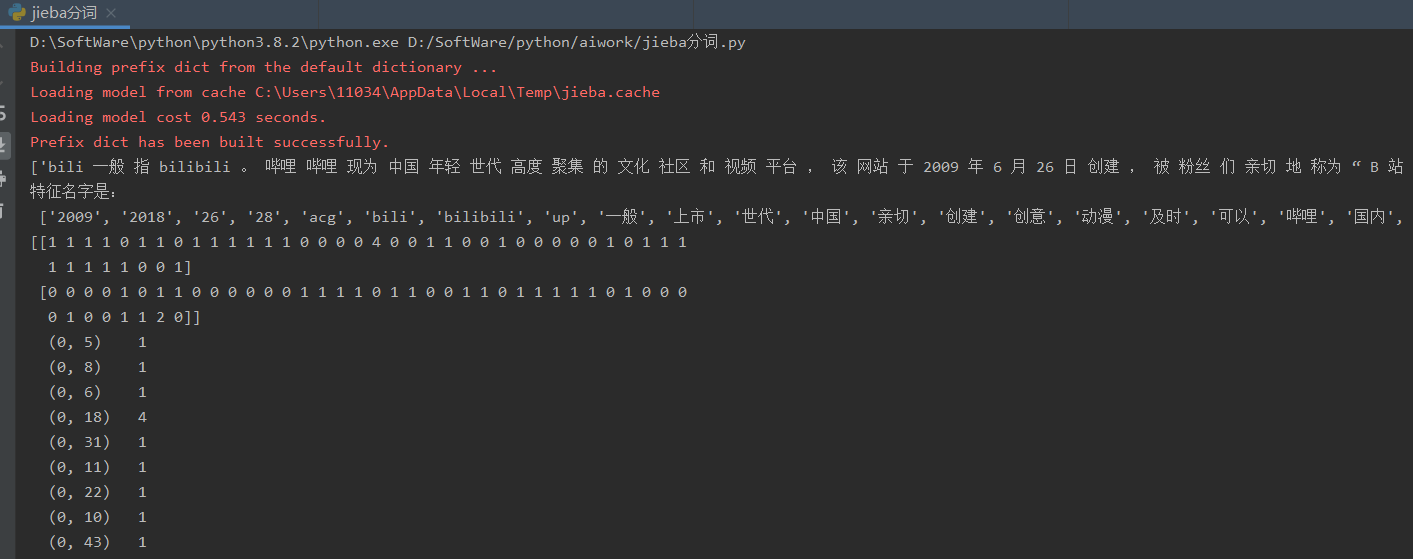

运行结果: