下面实现克隆Master节点,使之成为Slave节点。

克隆 (ctrl+o)M节点,生成新的节点S3.

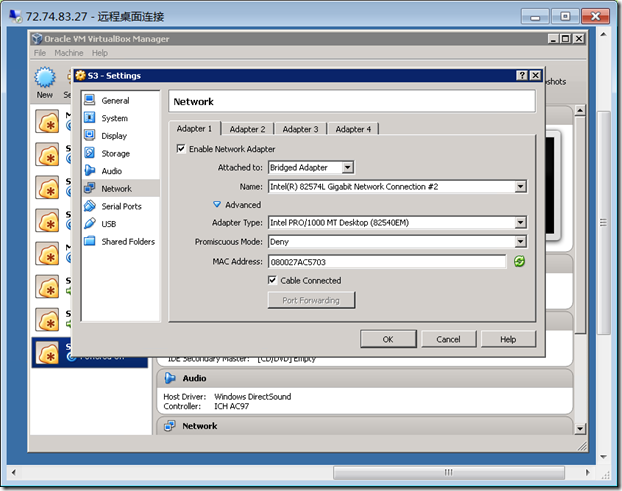

进入S3的节点设置,更新S3的mac地址。

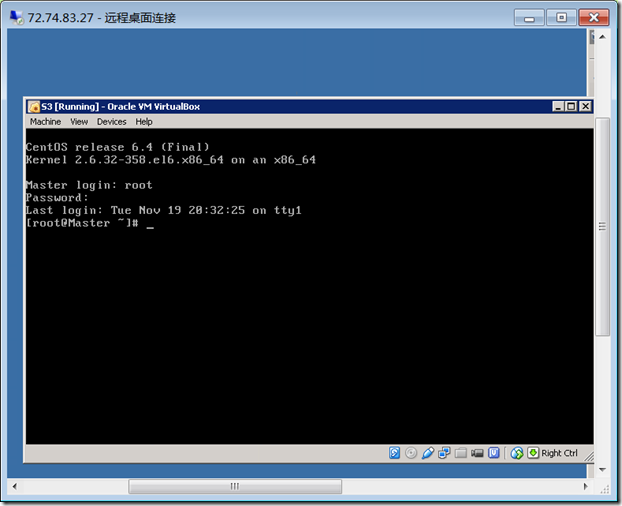

启动S3,可能比一般时间要长些。

使用root登录。

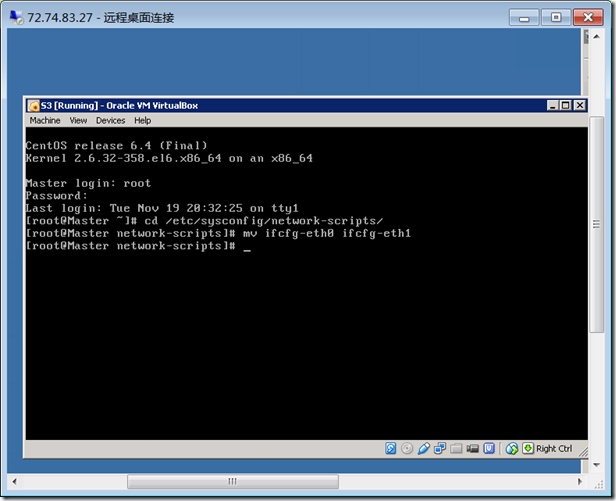

进入 /etc/sysconfig/network-scripts文件夹,修改ifcfg-eth0名为ifcfg-eth1

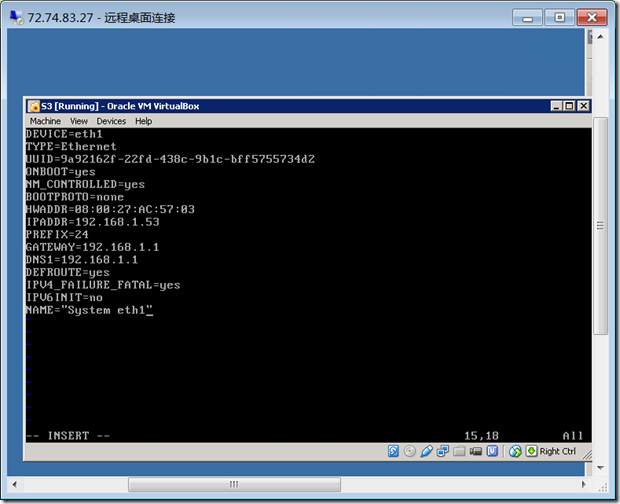

修改ifcfg-eth1文件,分别修改device, mac地址,ip address, name.

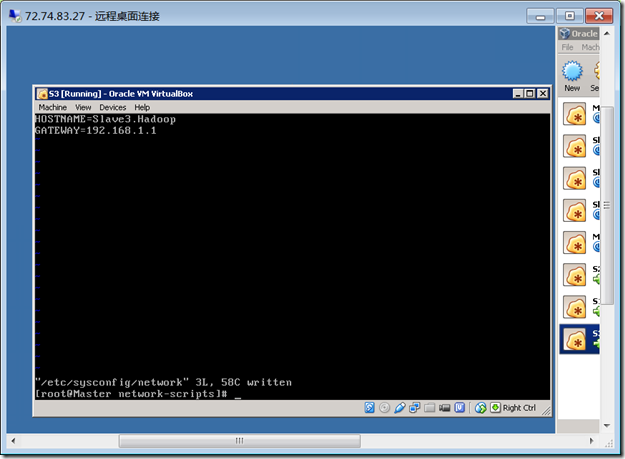

修改hostname : vim /etc/sysconfig/network

改为:Slave3.Hadoop

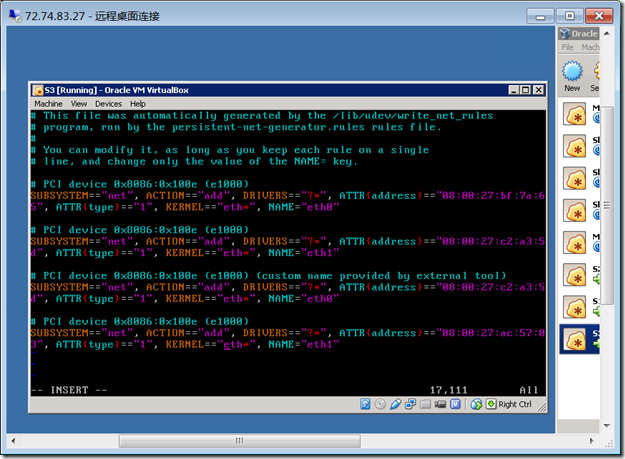

修改虚拟硬盘中配置信息:

# vim /etc/udev/rules.d/70-persistent-net.rules

将最有一排的eth2改为 eth1,保存退出。重新启动节点。

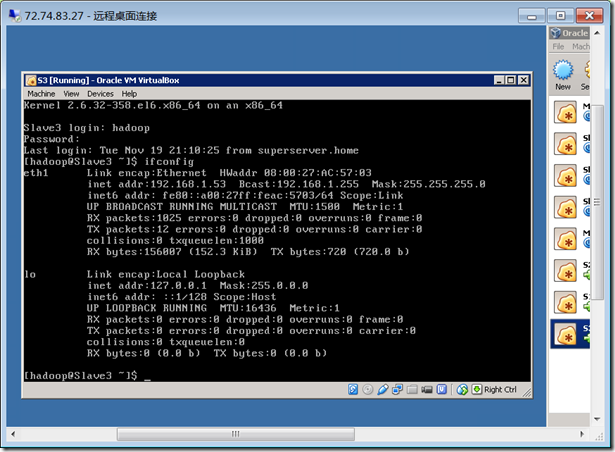

重新启动之后,ifconfig查看网络状态。发现eth1, ip地址为 192.168.1.53,说明配置完成。

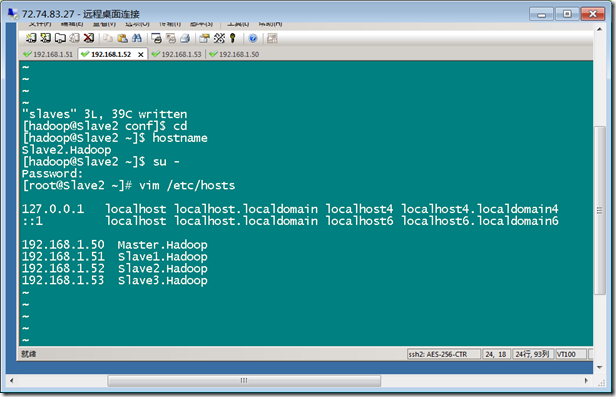

打开每个节点,修改 vim /etc/hosts

添加:

192.168.1.50 Master.Hadoop

192.168.1.51 Slave1.Hadoop

192.168.1.52 Slave2.Hadoop

192.168.1.53 Slave3.Hadoop

下面解决无密码登录的问题:

首先所有的节点进入: home/hadoop/.ssh 文件夹, 删除所有里面的文件: rm –rf /home/hadoop/.ssh/*

其次,master 节点生成key: ssh-keygen –t rsa –P ‘’

然后,把key添加:cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

然后,修改authorized_keys的权限: chmod 600 ~/.ssh/authorized_keys

然后,ssh localhost 测试。

然后,把 id_rsa.pub发送到每个节点:scp ~/.ssh/id_rsa.pub hadoop@192.168.1.51:~/

然后,对于每个slave节点,把master的key追加到authorized_keys的文件里,然后修改其权限:

cat ~/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

删除 id_rsa.pub文件: rm –rf ~/id-rsa.pub

最后,测试master 登录slave。

同样的方法,设置slave到master的访问。

首先:生成key

其次:追加到authorized_keys里面

然后发送:scp ~/.ssh/id_rsa.pub hadoop@192.168.1.50:~/

在Master节点: 追加id_rsa.pub 到authorized_keys里面,然后删除id_rsa.pub.