分享一个基于动态聚合网络的多领域端到端任务型对话系统 覃立波,哈尔滨工业大学社会计算与信息检索研究中心(SCIR)在读博士生,导师车万翔教授,研究兴趣为任务型对话系统,相应研究成果发表在ACL、EMNLP、AAAI上 更多关于ACL 2020的系列视频:可到https://mooc.yanxishe.com/open?from=bilibili观看

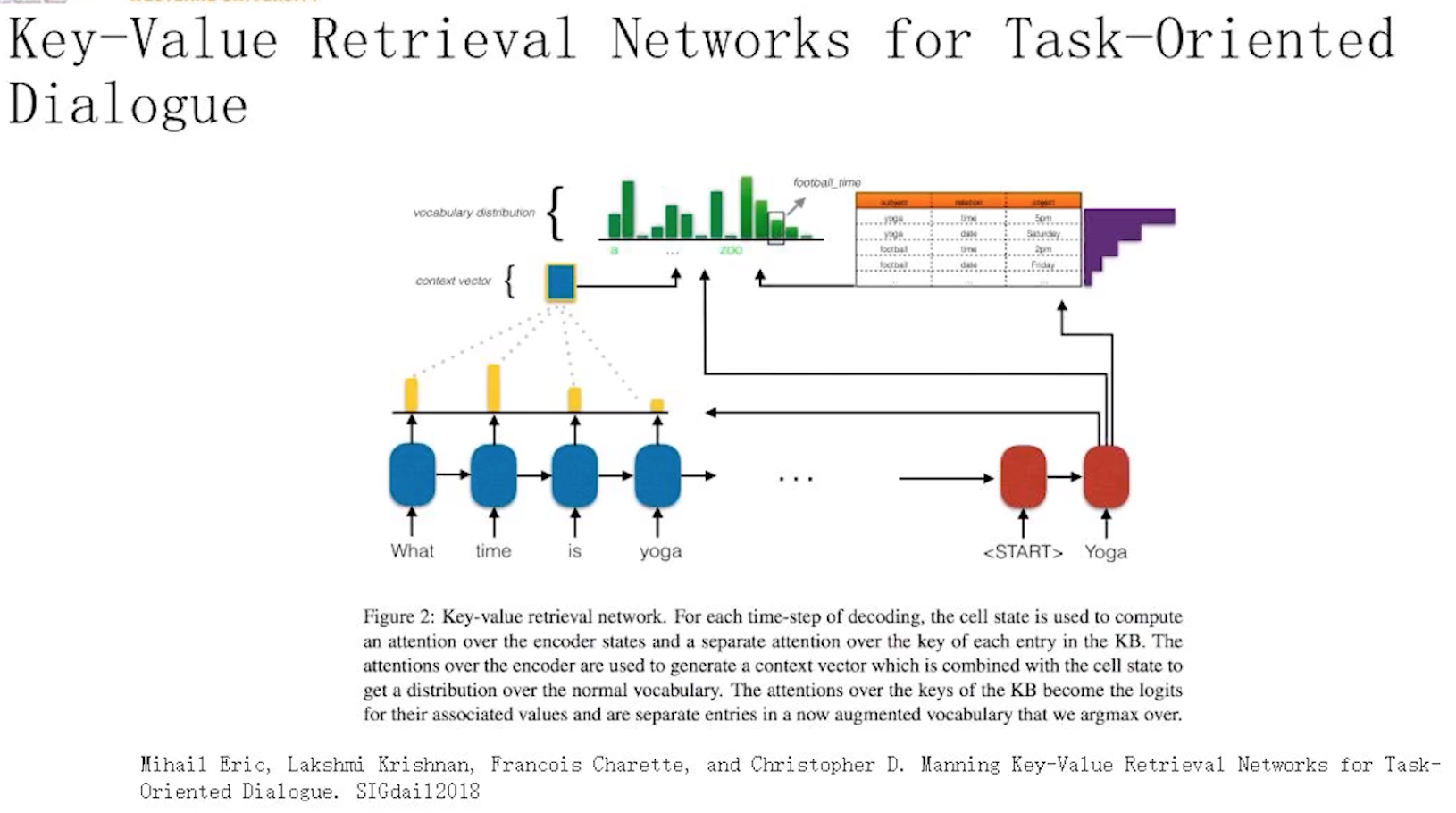

词汇 + 知识attention

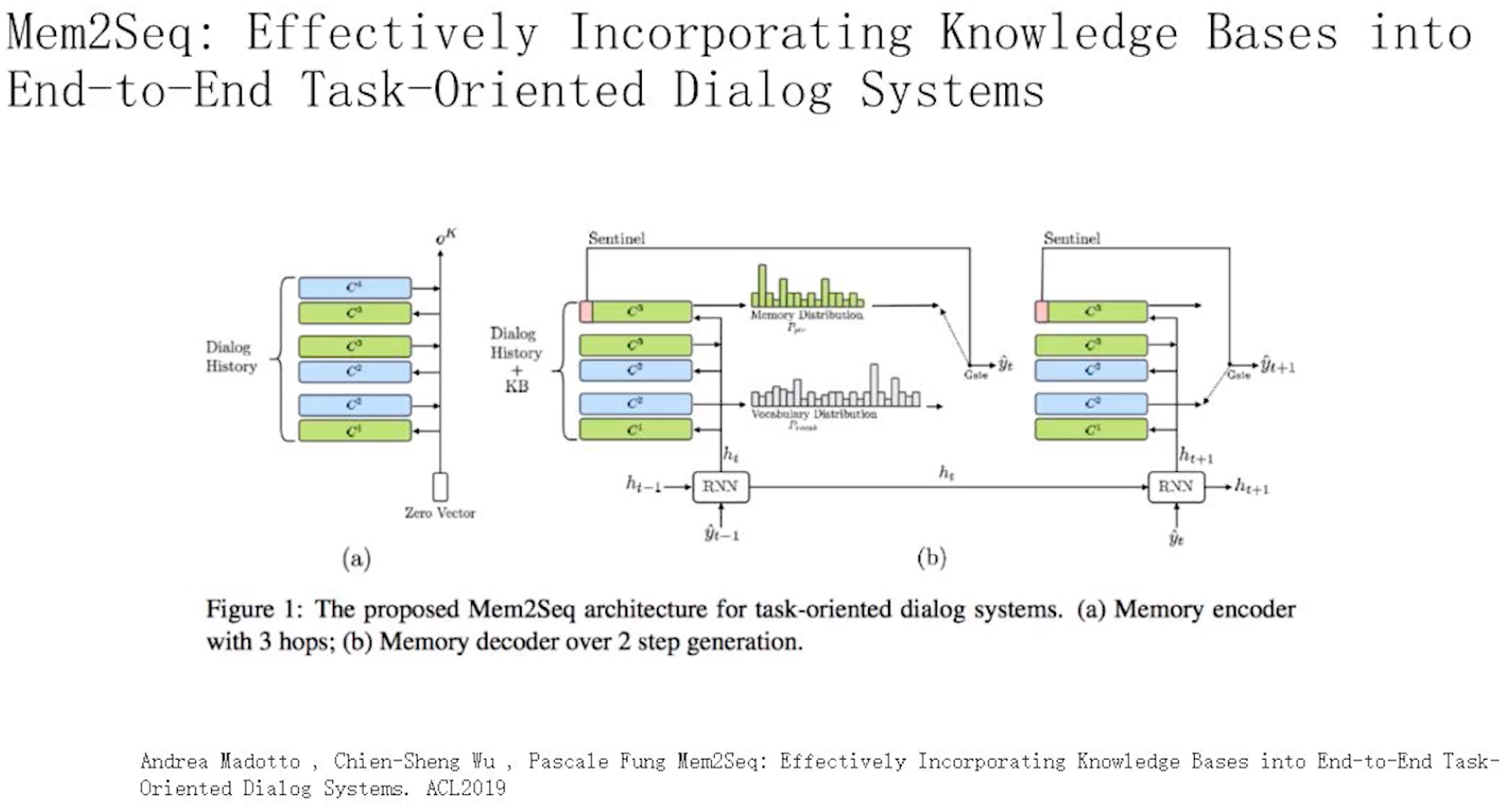

memeory存知识 + global 指针

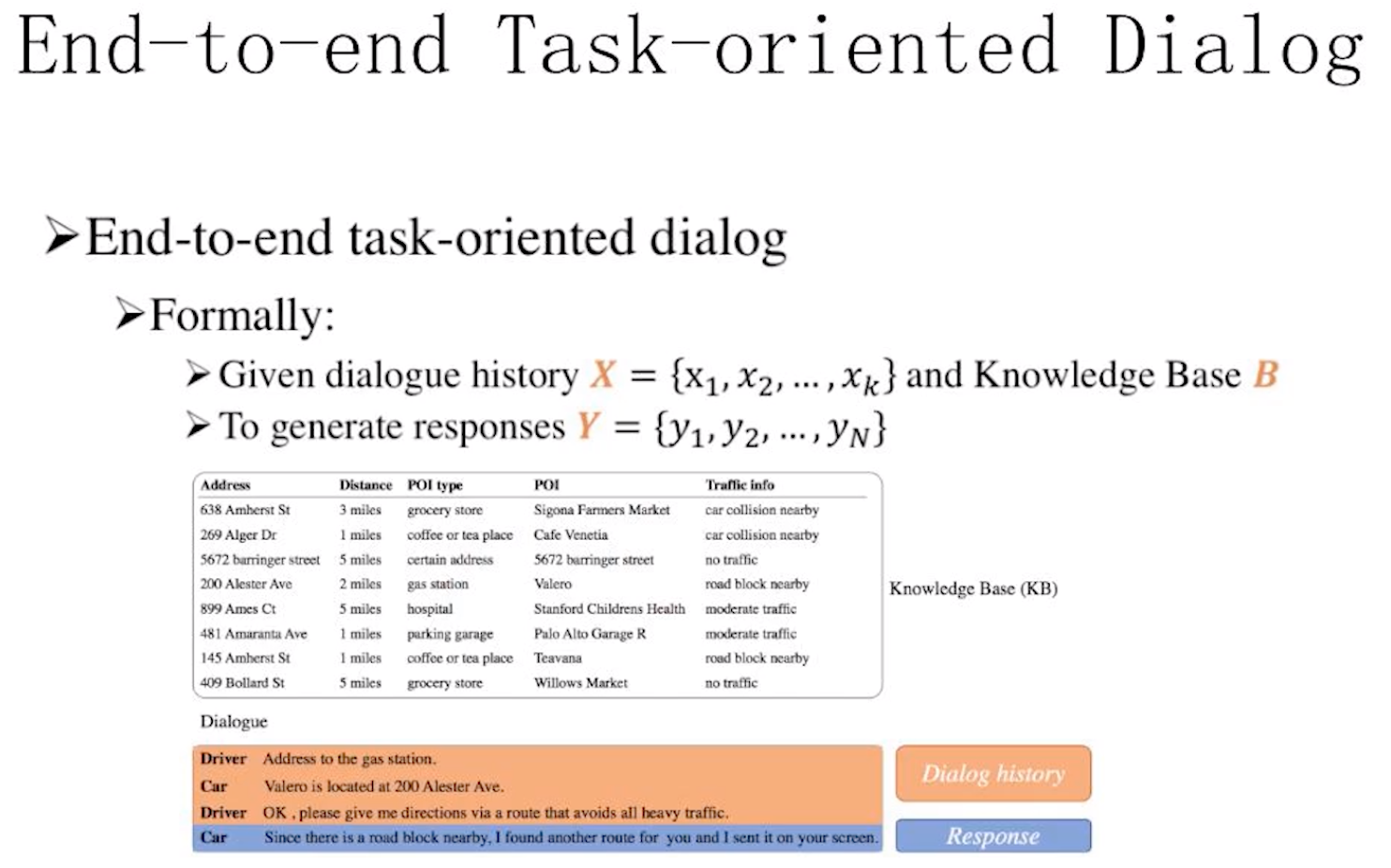

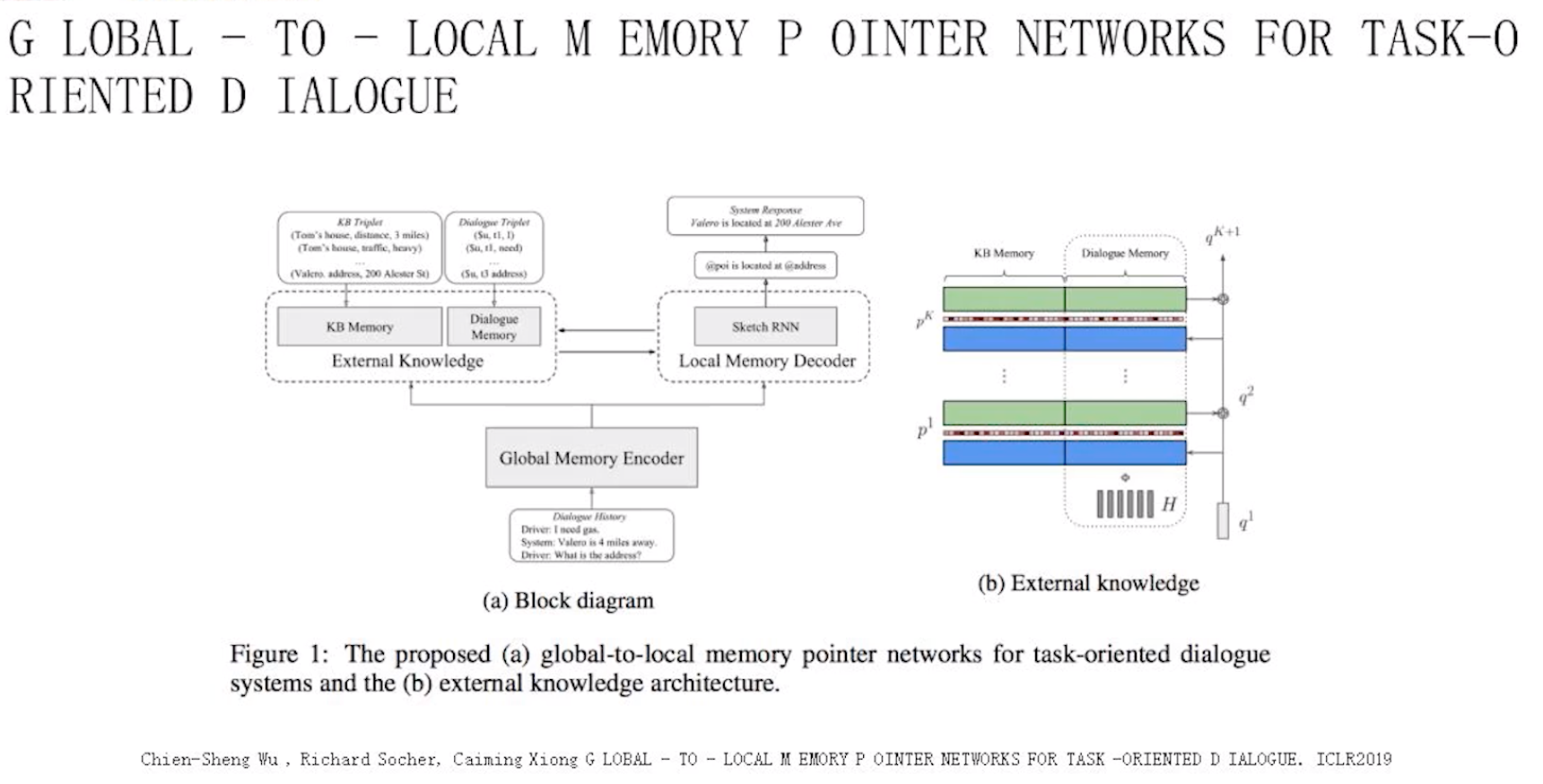

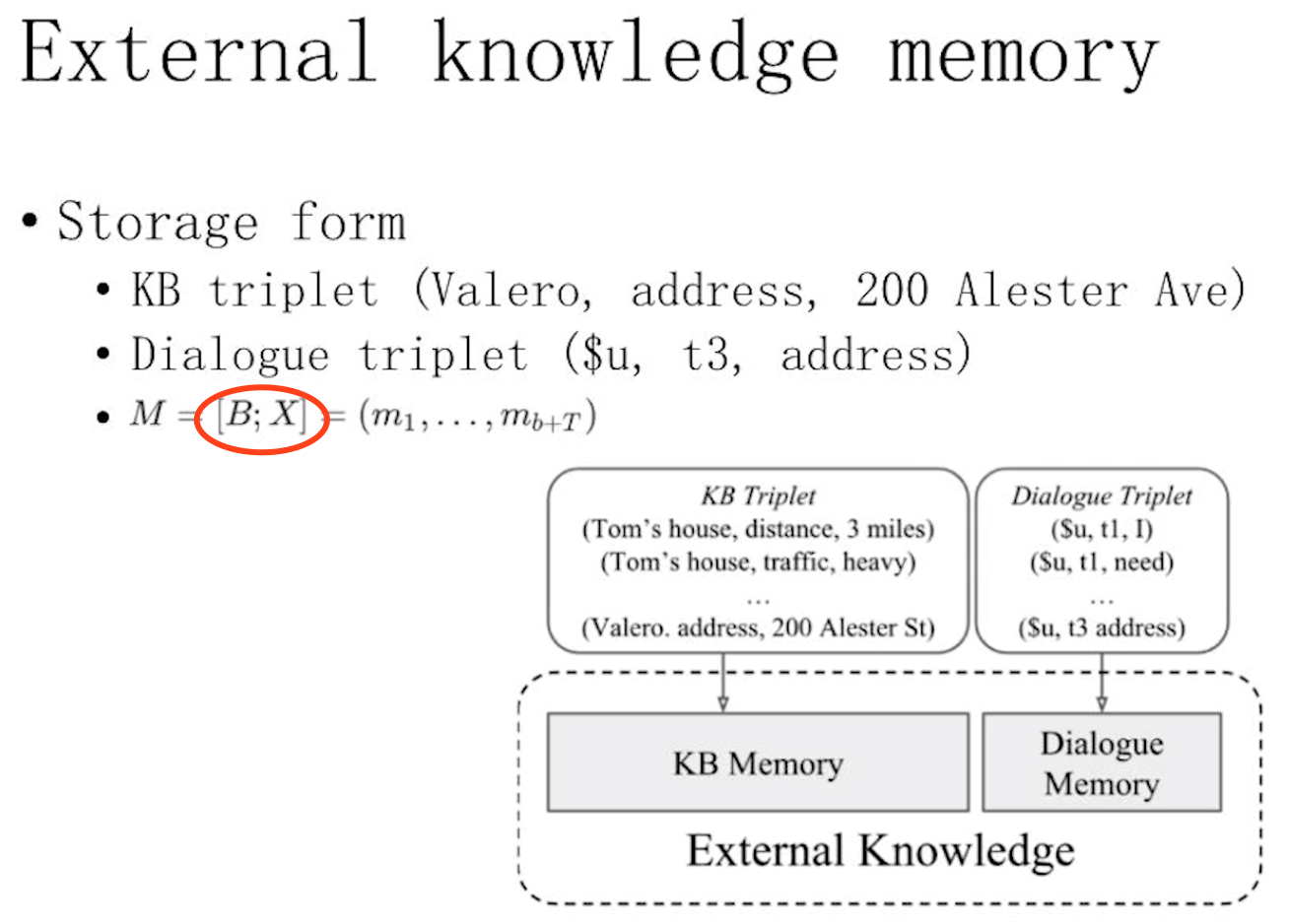

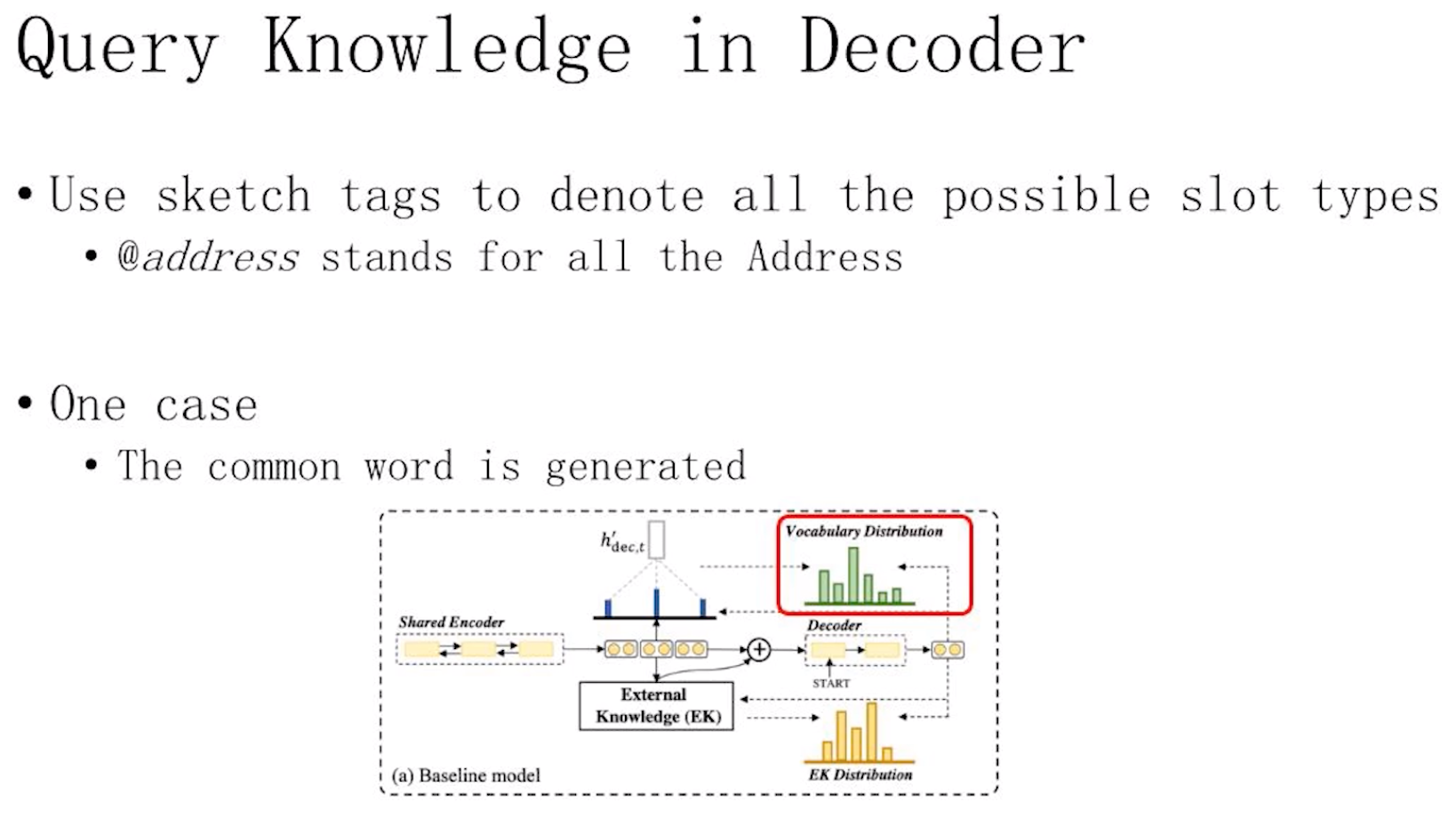

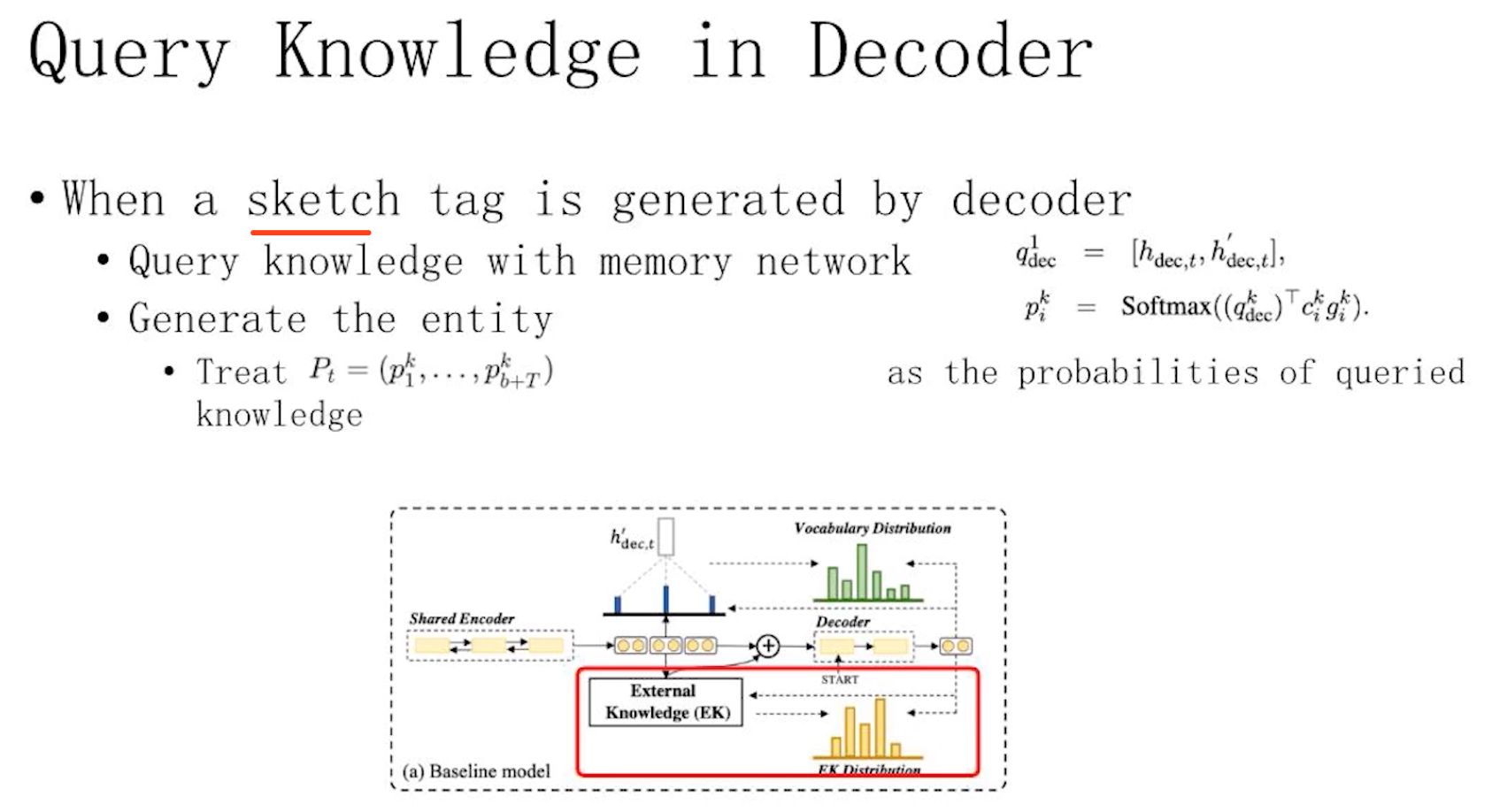

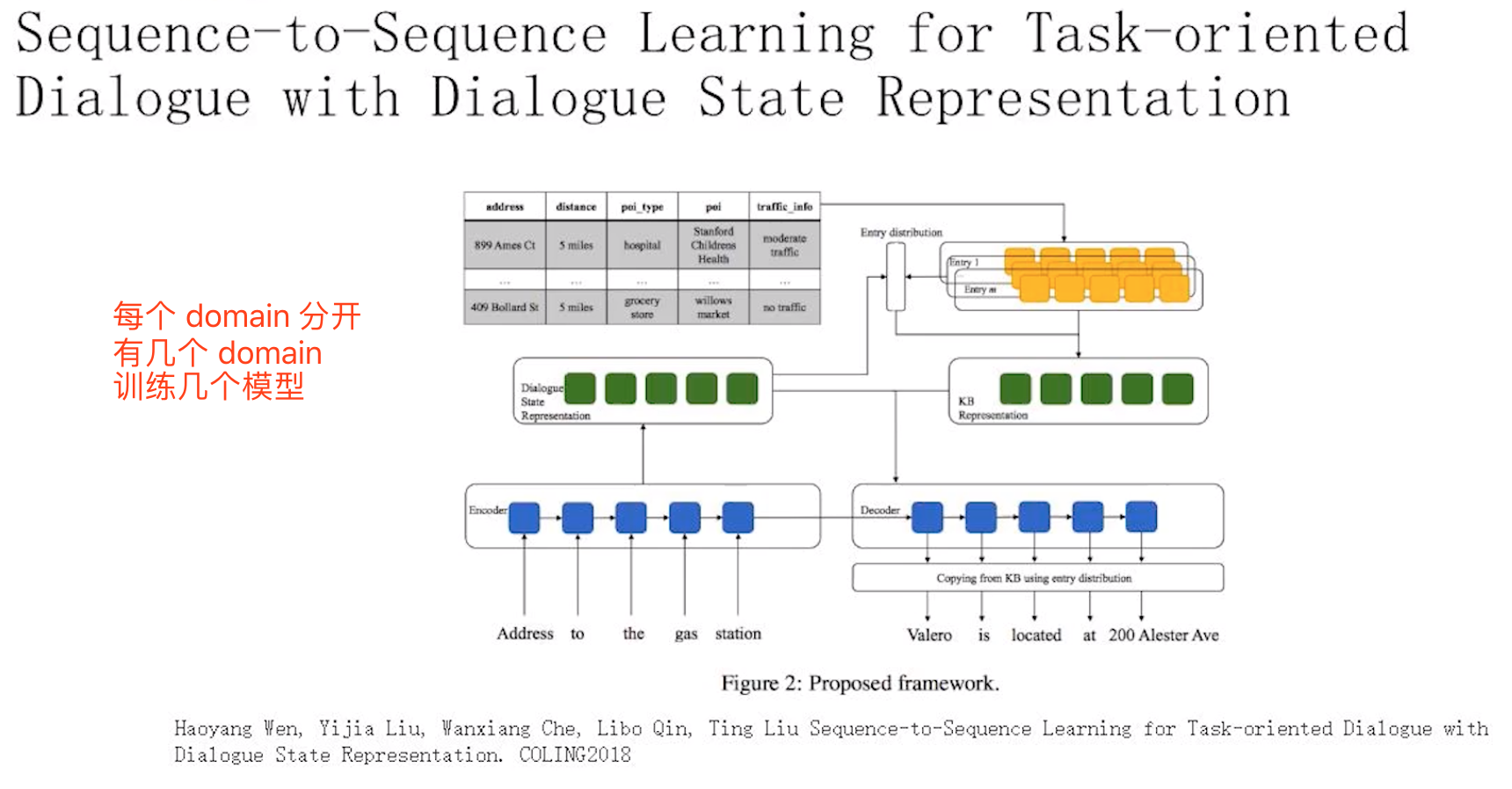

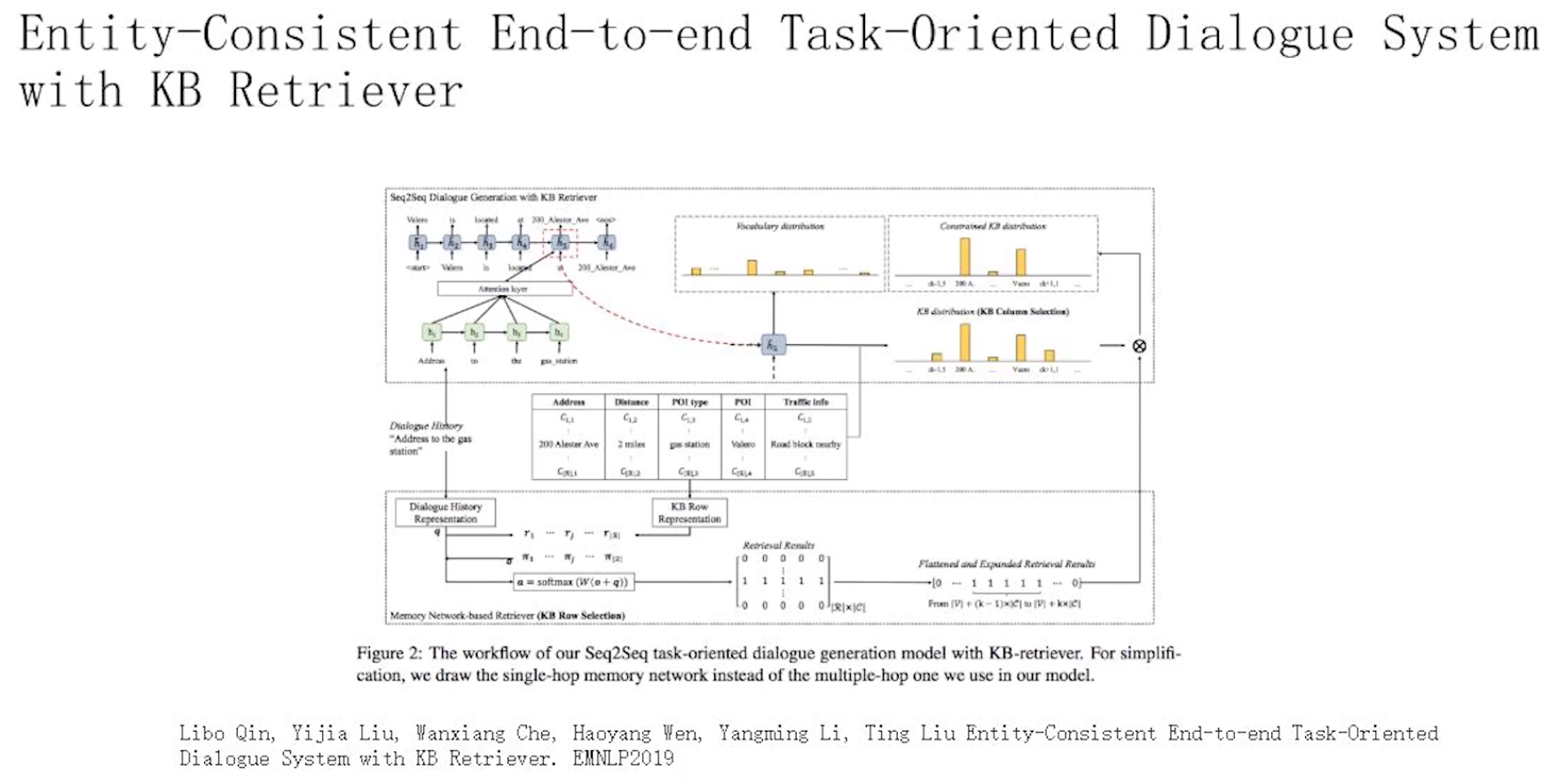

1 原文概述原文解决的问题是如何有效地在任务型对话系统中嵌入知识库。本文是Mem2Seq的改进模型(知无我:Mem2Seq:有效结合知识库的端到端任务对话系统),Mem2Seq的改进在于将decoder变成了PointNetwork,将copy以及生成思想和记忆网络结合在一起,有效的实现了任务型对话知识库嵌入。知识库对于任务型对话系统很重要,从某种程度上讲记忆网络是嵌入知识库较好的方式之一。尤其是multi-hop的结构,它可以提高模型的推理能力。尽管知识库对于任务型对话系统很重要,但是动态的大量的知识库的嵌入无疑相当于对模型引入一个巨量噪声,而且加大模型计算等方面的开销(知识库难于编码以及解码)。为了有效地在任务型对话系统中嵌入知识库,原文提出了全局到局部的记忆指针网络(GLOBAL-TO-LOCAL MEMORY POINTER NETWORKS,GLMP)。 GMLP的整体框架也是基于MemNN,包含encoder和decoder两部分。encoder编码对话历史,输出的两个量--全局记忆指针(Global Memory Pointer)和全局上下文表征 |

|

使用了全局记忆指针来对知识库过滤

--> 有最优 setting 吗?