参考:https://www.cnblogs.com/pinard/p/6422831.html

为什么要用到反向传播

我们的目的是得到每一个神经元的w和b。这个参数的获取一般是通过梯度下降算法得到的。因此我们需要设置损失函数,使损失函数到达最小。这个过程就是反向传播算法。

求得损失函数最小那么就需要对一个经过前向传播得到的w,b进行在损失函数中的求导得到梯度,然后根据得到的梯度对w,b进行更新。

为什么进行的是反向传播而不是正向的

个人认为因为某层某个神经元是正向传播得到的,在对这一个神经元用损失函数求导时,发现某一部分可以简便的求出上一层的梯度表示,就这样反向传播。(个人感觉这个名字起的是因为它具有这样传播的特点)

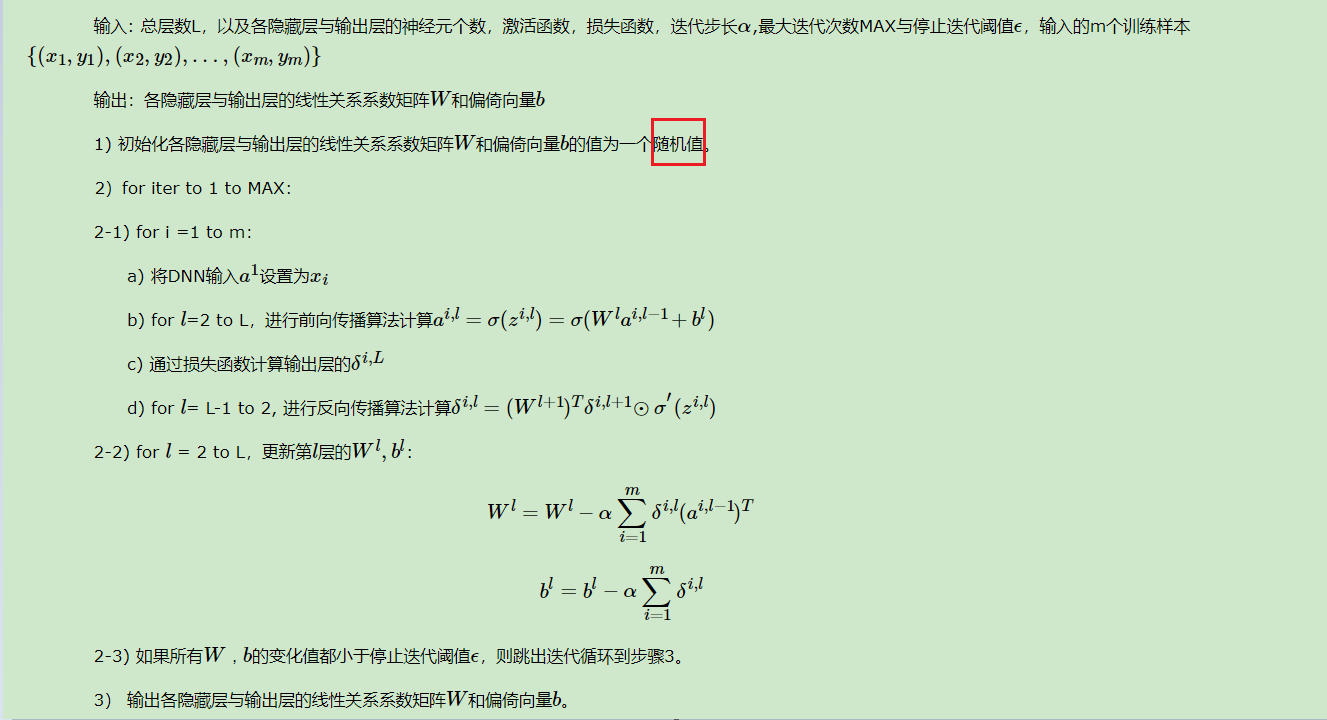

算法流程