这里主要总结Linear Regression,Linear Classification,Logistic Regression。

1.Linear Regression

线性回归的基本思想:寻找直线/平面/超平面,使得输入数据的残差最小

线性回归算法:

最终的线性回归的结果为:

其中:X+ 的求法如下

2.Linear Classification

线性分类根据之前的方法主要是PLA和package方法来实现。

3.Logistic Regression(逻辑斯蒂回归)

如果把,WTX的结果记作score,那么线性回归最后取得的函数是g(x)=WTX,线性分类器的最后结果是g(x)=sign(WTX),逻辑斯蒂回归的最后结果是g(s)=1/(1+exp(-WTX)),逻辑斯蒂回归选择的映射函数是S型的sigmoid 函数。输出结果是0-1之间的连续的值,

用一个更加直观的例子:通过二值分类,我们仅仅能够预测病人是否会患上心脏病,不同于此的是,现在我们还关心患病的可能性,即 f(x) = P(+1|x),取值范围是区间 [0,1]。然而,我们能够获取的训练数据却与二值分类完全一样,x 是病人的基本属性,y 是+1(患心脏病)或 -1(没有患心脏病)。输入数据并没有告诉我们有关“概率” 的信息,这个时候用到的就是逻辑斯蒂回归。

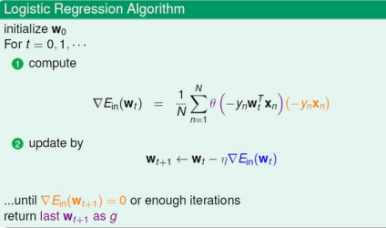

下边是该算法的实现:

该算法的推理过程将在后续过程补齐。

附1:以上三种模型的比较:

(1)error function

在错误处理方面,线性分类直接采用的是0/1 错误,线性分类采用的是平方的错误,逻辑斯蒂回归采用的是corss-entropy error其中err(w,x,y)=ln(1+exp(-ywx))

(2)模型的过程

线性回归直接使用s=WTX的值,线性分类直接对这个值取符号,逻辑斯蒂回归将s的值映射到(0,1)区间上,

线性回归使用的是一个最小二乘法的形式,线性分类是一个NP难问题,(主要采用LPA,或 Package算法,之后还可以转化为Regression问题,在求解),逻辑斯蒂回归是采用的梯度下降的方法求解。

附2:Regression for classification

① run logistic/linear reg. on D with yn€{-1,+1} to get WREG

② return g(x)=sign(WTREGX)

线性分类和线性回归基本是相同的,不同点在于,线性回归输出的结果是连续的值,二线性分类的结果仅仅是0或1

因此,可以把最后的函数改为sign函数即可。