参考资料:

https://github.com/ranjitation/DQN-for-LunarLander/

https://github.com/XinliYu/Reinforcement_Learning-Projects/tree/master/LunarLander

https://stanford-cs221.github.io/autumn2019-extra/posters/113.pdf

https://github.com/openai/gym/wiki/Leaderboard#lunarlander-v2、

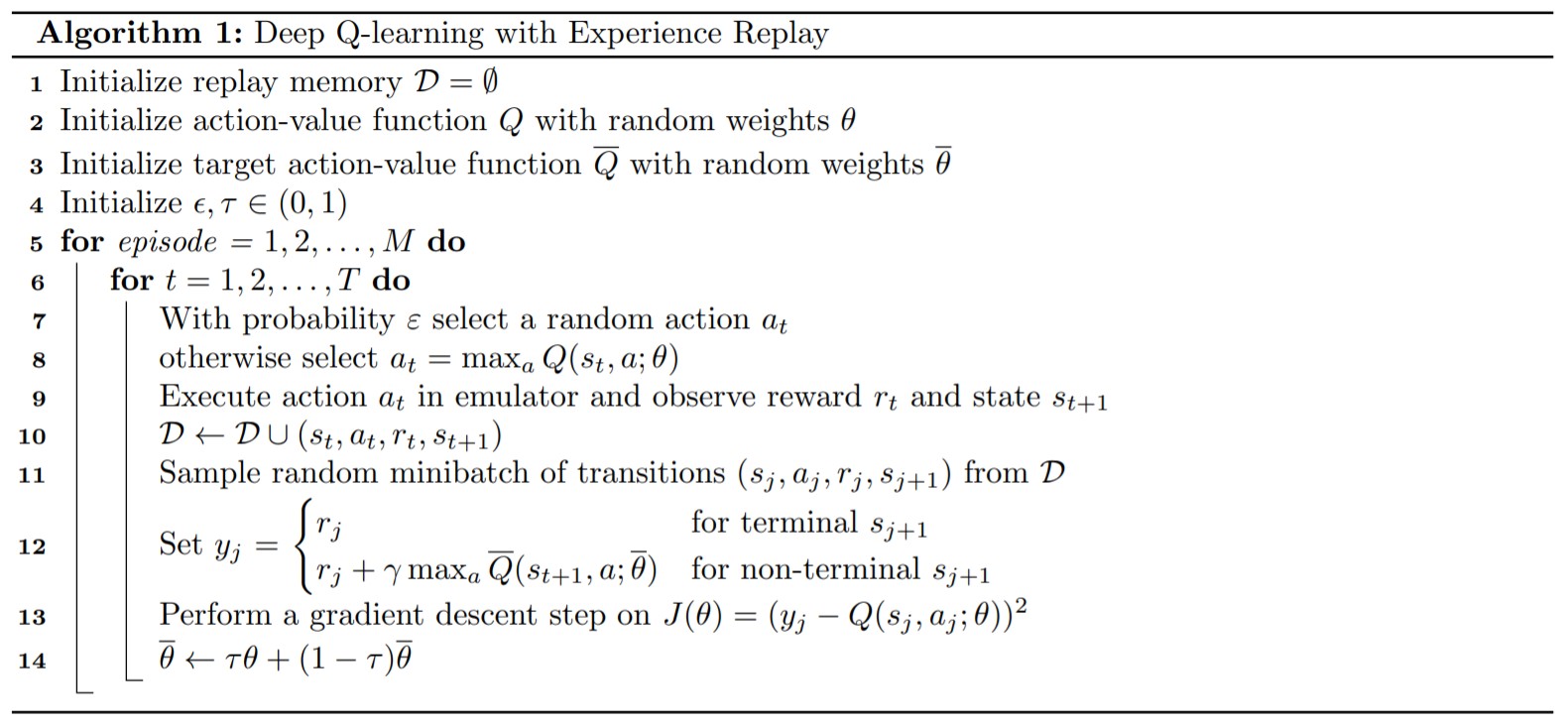

https://www.researchgate.net/publication/333145451_Deep_Q-Learning_on_Lunar_Lander_Game?enrichId=rgreq-97106d655a4f7c18eb0cd40c05fdbb59-XXX&enrichSource=Y292ZXJQYWdlOzMzMzE0NTQ1MTtBUzo3NTkyMDY2NzYyNzExMTRAMTU1ODAyMDM4NTg5MA%3D%3D&el=1_x_3&_esc=publicationCoverPdf  本人使用上图所示的算法,即DQN解决了OpenAI-gym中LunarLander-v2游戏。

本人使用上图所示的算法,即DQN解决了OpenAI-gym中LunarLander-v2游戏。

我仅仅列出了可用的资料,害怕遗忘所以记在这里。写的代码就不放了,主要是follow参考资料一,按照上图算法一步一步来就好。最后的结果的话平均分数能够达到281分,但是仍然有机率降落在停机坪外,只不过可以保证降落过程100%平稳。然而网上最强的结果是能够达到284多分,这意味着每次小火箭都基本能精确、平稳(缓慢)的降落在停机坪。可能和超参数有关,还需要多多尝试。虽然如此,成功解决问题的标准是连续100次的平均分数大于200,所以达到这个目标之后再精益求精就可。

下面放两个效果图,一个是迭代20次的结果,一个是最好分数的结果(大概6、700个episode)。

迭代20次:

最好模型: