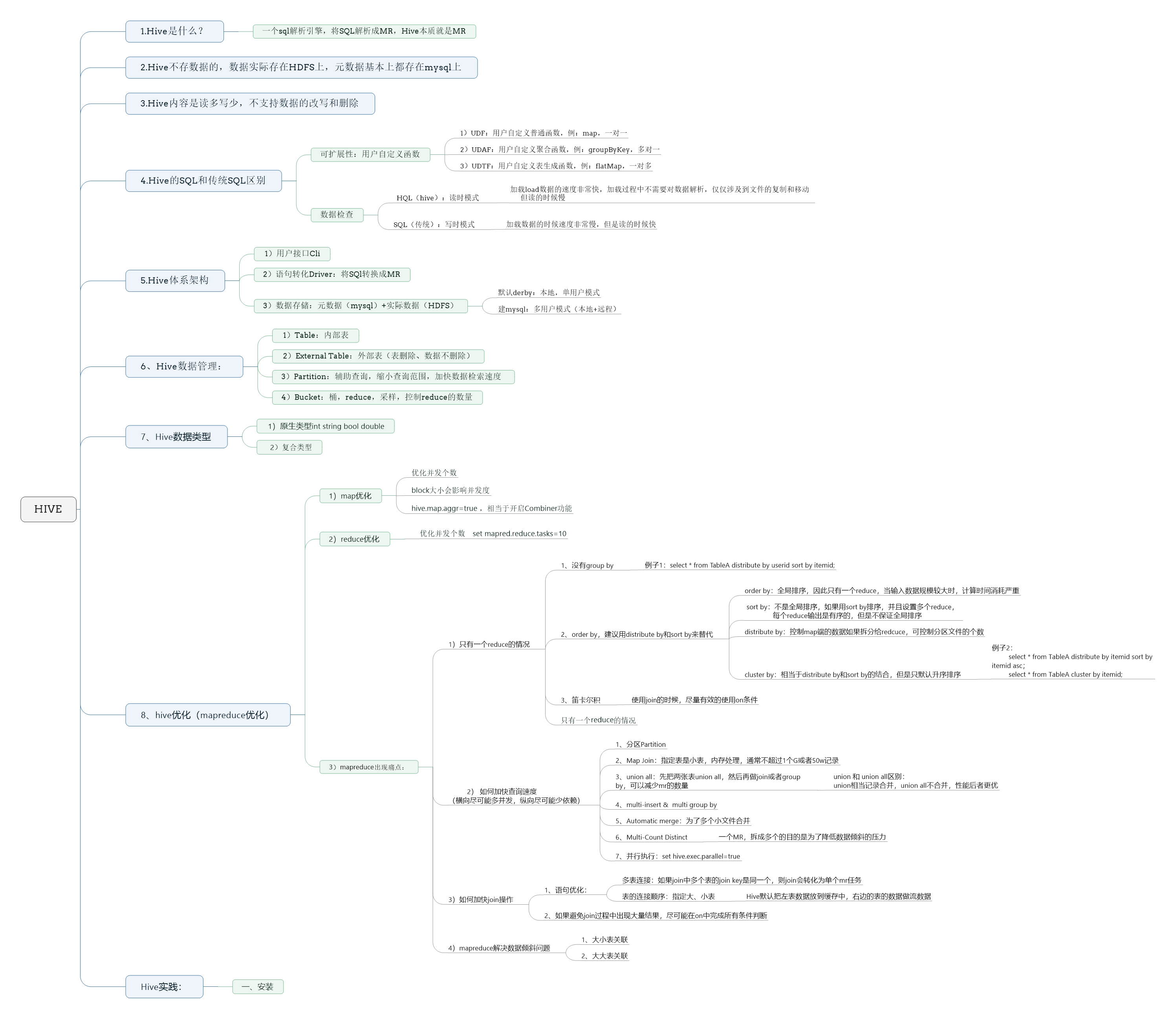

一、HIve的概念

1 Hive基本概念

1.1 什么是Hive

- Hive:由Facebook开源用于解决海量结构化日志的数据统计。

- Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表,并提供类SQL查询功能。

- 本质是:将HQL转化成MapReduce程序

- 1)Hive处理的数据存储在HDFS

- 2)Hive分析数据底层的实现是MapReduce

- 3)执行程序运行在YARN上

1.2 为什么使用Hive

- 直接使用hadoop所面临的问题

- (1)人员学习成本太高

- (2)项目周期要求太短

- (3)MapReduce实现复杂查询逻辑开发难度太大

- Hive的好处

- (1)操作接口采用类SQL语法,提供快速开发的能力。

- (2)避免了去写MapReduce,减少开发人员的学习成本。

- (3)扩展功能很方便。

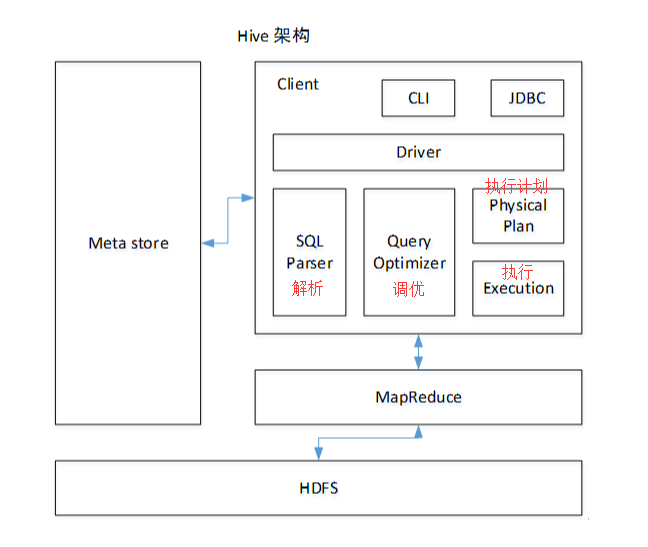

1.3 Hive架构概述原理

- 如图中所示,Hive通过给用户提供的一系列交互接口,接收到用户的指令(SQL),使用自己的Driver,结合元数据(MetaStore),将这些指令翻译成MapReduce,提交到Hadoop中执行,最后,将执行返回的结果输出到用户交互接口。

- 1)用户接口:Client

- CLI(hive shell)、JDBC/ODBC(java访问hive)、WEBUI(浏览器访问hive)

- 2)元数据:Metastore

- 元数据包括:表名、表所属的数据库(默认是default)、表的拥有者、列/分区字段、表的类型(是否是外部表)、表的数据所在目录等;

- 默认存储在自带的derby数据库中,推荐使用MySQL存储Metastore

- 3)Hadoop

- 使用HDFS进行存储,使用MapReduce进行计算。

- 4)驱动器:Driver

- (1)解析器(SQL Parser):将SQL字符串转换成抽象语法树AST,这一步一般都用第三方工具库完成,比如antlr;对AST进行语法分析,比如表是否存在、字段是否存在、SQL语义是否有误。

- (2)编译器(Physical Plan):将AST编译生成逻辑执行计划。

- (3)优化器(Query Optimizer):对逻辑执行计划进行优化。

- (4)执行器(Execution):把逻辑执行计划转换成可以运行的物理计划。对于Hive来说,就是MR/TEZ/Spark。

- 1)用户接口:Client

1.4 Hive 的特点

- 1)操作接口采用类SQL语法,提供快速开发的能力(简单、容易上手)

- 2)避免了去写MapReduce,减少开发人员的学习成本。

- 3)Hive的执行延迟比较高,因此hive常用于数据分析,对实时性要求不高的场合;

- 4)Hive优势在于处理大数据,对于处理小数据没有优势,因为Hive的执行延迟比较高。

- 5)Hive支持用户自定义函数,用户可以根据自己的需求来实现自己的函数。

1.5 Hive和数据库比较

由于 Hive 采用了类似SQL 的查询语言 HQL(hive query language),因此很容易将 Hive 理解为数据库。其实从结构上来看,Hive 和数据库除了拥有类似的查询语言,再无类似之处。本文将从多个方面来阐述 Hive 和数据库的差异。数据库可以用在 Online 的应用中,但是Hive 是为数据仓库而设计的,清楚这一点,有助于从应用角度理解 Hive 的特性。

- 1.5.1 查询语言

- 由于SQL被广泛的应用在数据仓库中,因此,专门针对Hive的特性设计了类SQL的查询语言HQL。熟悉SQL开发的开发者可以很方便的使用Hive进行开发。

- 1.5.2 数据存储位置

- Hive 是建立在 Hadoop 之上的,所有 Hive 的数据都是存储在 HDFS 中的。而数据库则可以将数据保存在块设备或者本地文件系统中。

- 1.5.3 数据更新

- 由于Hive是针对数据仓库应用设计的,而数据仓库的内容是读多写少的。因此,Hive中不支持对数据的改写和添加,所有的数据都是在加载的时候中确定好的。而数据库中的数据通常是需要经常进行修改的,因此可以使用 INSERT INTO … VALUES 添加数据,使用 UPDATE … SET修改数据。

- 1.5.4 索引

- Hive在加载数据的过程中不会对数据进行任何处理,甚至不会对数据进行扫描,因此也没有对数据中的某些Key建立索引。Hive要访问数据中满足条件的特定值时,需要暴力扫描整个数据,因此访问延迟较高。由于 MapReduce 的引入, Hive 可以并行访问数据,因此即使没有索引,对于大数据量的访问,Hive 仍然可以体现出优势。数据库中,通常会针对一个或者几个列建立索引,因此对于少量的特定条件的数据的访问,数据库可以有很高的效率,较低的延迟。由于数据的访问延迟较高,决定了 Hive 不适合在线数据查询。

- 1.5.5 执行

- Hive中大多数查询的执行是通过 Hadoop 提供的 MapReduce 来实现的。而数据库通常有自己的执行引擎。

- 1.5.6 执行延迟

- Hive 在查询数据的时候,由于没有索引,需要扫描整个表,因此延迟较高。另外一个导致 Hive 执行延迟高的因素是 MapReduce框架。由于MapReduce 本身具有较高的延迟,因此在利用MapReduce 执行Hive查询时,也会有较高的延迟。相对的,数据库的执行延迟较低。当然,这个低是有条件的,即数据规模较小,当数据规模大到超过数据库的处理能力的时候,Hive的并行计算显然能体现出优势。

- 1.5.7 可扩展性

- 由于Hive是建立在Hadoop之上的,因此Hive的可扩展性是和Hadoop的可扩展性是一致的(世界上最大的Hadoop 集群在 Yahoo!,2009年的规模在4000 台节点左右)。而数据库由于 ACID 语义的严格限制,扩展行非常有限。目前最先进的并行数据库 Oracle 在理论上的扩展能力也只有100台左右。

- 1.5.8 数据规模

- 由于Hive建立在集群上并可以利用MapReduce进行并行计算,因此可以支持很大规模的数据;对应的,数据库可以支持的数据规模较小。

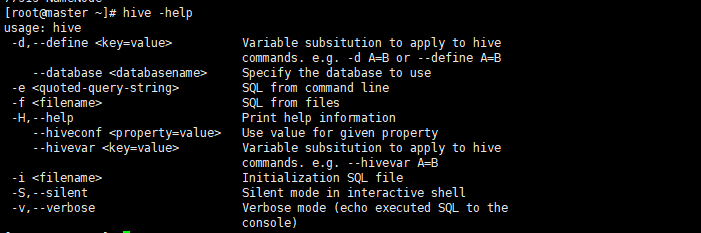

2 Hive常用命令

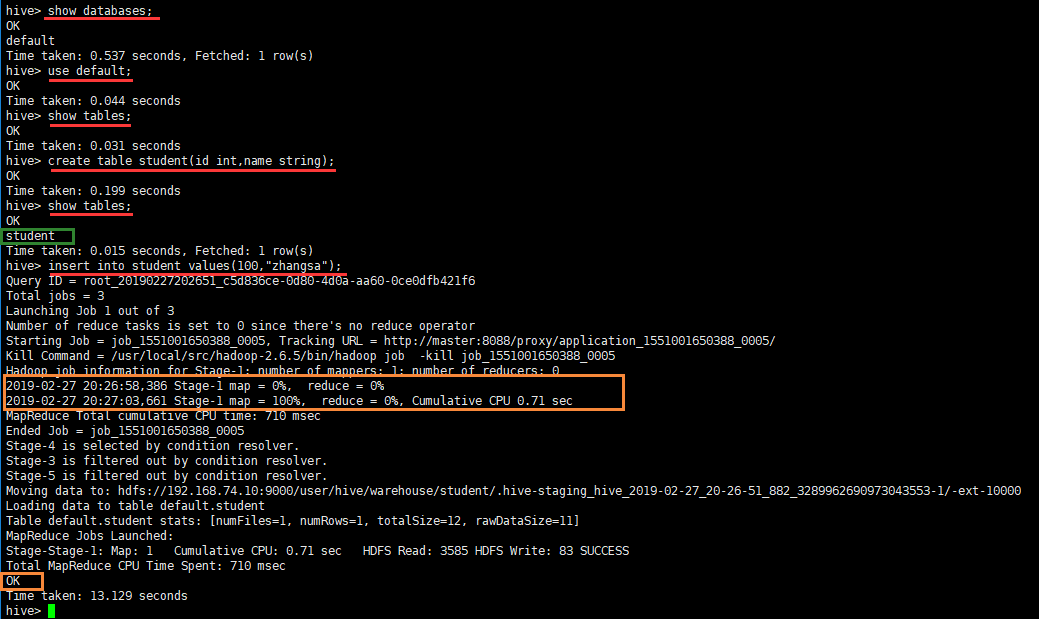

hive -help查看命令- 进入默认数据库,创建一个student表,并且插入一条数据

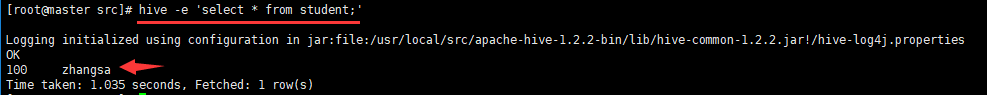

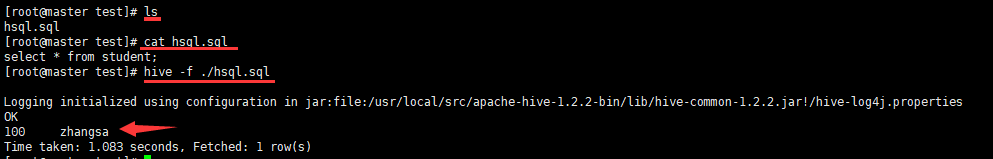

hive -e不进入互交命令查询表hive -f执行sql脚本- 创建一个hsql.sql文件内容为

select * from student;

- 创建一个hsql.sql文件内容为

- 查看50070端口

3 Hive其他命令

- 退出命令

exit和quit

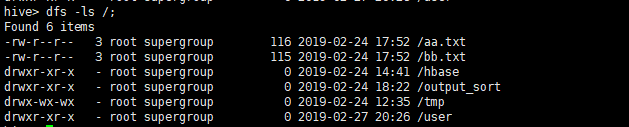

- hive cli下查看hdfs文件系统

dfs -ls /; - hive cli下查看hdfs本地系统(linux)

!ls /usr/local/src;查看历史hive命令(在用户目录下执行):[root@master ~]# cat .hivehistory

3 Hive常见属性配置

3.1 参数配置方式

- 1)查看当前所有的配置信息(hive下输入命令):

set; - 2)参数的配置三种方式及优先级

- 2.1配置文件方式

- 默认配置文件:hive-default.xml

- 用户自定义配置文件:hive-site.xml

- 注意:用户自定义配置会覆盖默认配置。另外,Hive也会读入Hadoop的配置,因为Hive是作为Hadoop的客户端启动的,Hive的配置会覆盖Hadoop的配置。配置文件的设定对本机启动的所有Hive进程都有效。

- 2.2命令行参数方式

- 启动Hive时,可以在命令行添加-hiveconf param=value来设定参数。

- 例如:

hive -hiveconf mapred.reduce.tasks=10;注意:仅对本次hive启动有效 - 查看参数设置:

hive (default)> set mapred.reduce.tasks;

- 2.3参数声明方式

- 可以在HQL中使用SET关键字设定参数

- 例如:

hive (default)> set mapred.reduce.tasks=100;注意:仅对本次hive启动有效。 - 查看参数设置:

hive (default)> set mapred.reduce.tasks;

- 2.1配置文件方式

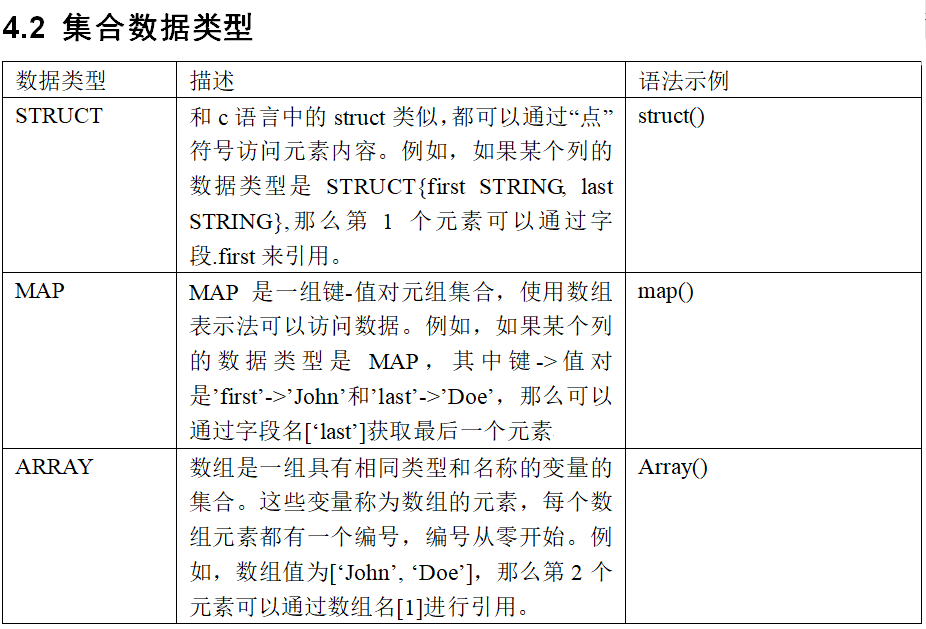

4 Hive数据类型

二、HIVE环境安装

1 安装MySQL

- 1.1 yum上mysql的资源有问题,所以不能仅仅之用yum。在使用yum之前还需要用其他命令获取mysql社区版

cd /usr/local/src

mkdir mysql5

cd mysql5

wget http://repo.mysql.com/mysql-community-release-el7-5.noarch.rpm

rpm -ivh mysql-community-release-el7-5.noarch.rpm - 1.2 通过yum命令开始安装

yum install mysql mysql-server mysql-devel -y- 1.3 启动

#启动命令

systemctl start mysql.service

#停止命令

systemctl stop mysql.service- 1.4 验证

启动后会占用3306端口。 使用如下命令查看3306端口是否启动,如果启动了则表示mysql处于运行状态。

netstat -anp | grep 3306

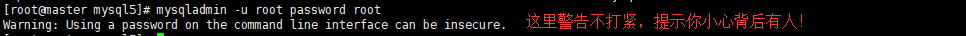

- 1.5 设置密码

#这里设置为root了

mysqladmin -u root password root

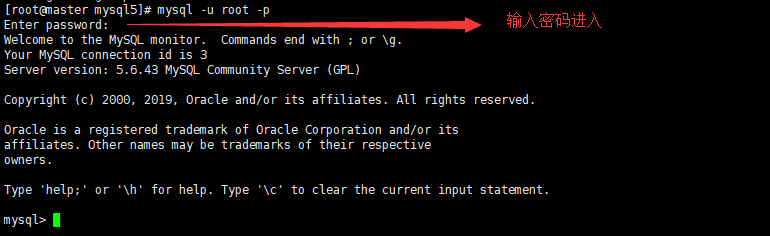

- 1.6 进入mysql

mysql -u root -p

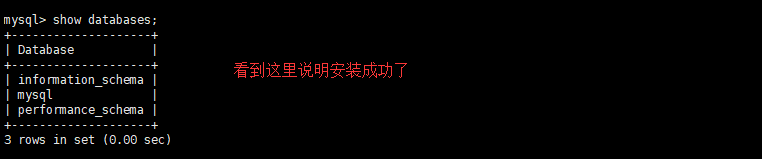

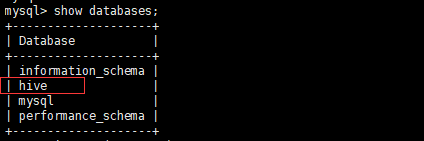

- 1.7 查询是否有数据库

show databases;

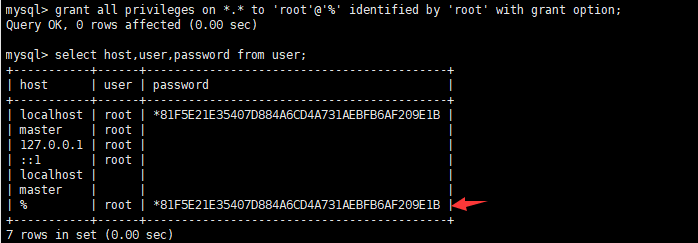

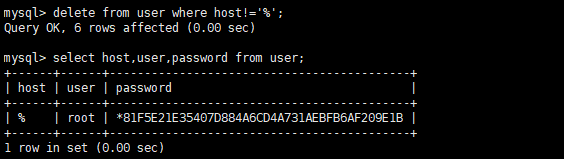

- 1.8MySql中user表中主机配置(配置远程可以访问)

进入mysql库,查询user表

添加一个权限控制

grant all privileges on *.* to 'root'@'%' identified by 'root' with grant option;

再次查询user表

删除其他的再次查询确定

delete from user where host!='%';

刷新

mysql>flush privileges;2 Hive源码包(操作master节点)

下载http://mirror.bit.edu.cn/apache/hive/上传至master

或者

wget http://mirror.bit.edu.cn/apache/hive/hive-1.2.2/apache-hive-1.2.2-bin.tar.gz

tar zxvf apache-hive-1.2.2-bin.tar.gz3 修改Hive配置文件

- hive-site.xml

cd apache-hive-1.2.2-bin/conf

cp hive-default.xml.template hive-site.xml

vim hive-site.xml批量修改:

#将${system:java.io.tmpdir}统一换成 /hive

#将${system:user.name}统一换成 root

#在vim命令行模式下的 :后面输入如下命令进行统一替换

%s/${system:java.io.tmpdir}/\/hive/g

%s/${system:user.name}/root/g将以下部分贴在配置文件尾部:

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>Username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>root</value>

<description>password to use against metastore database</description>

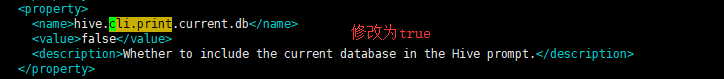

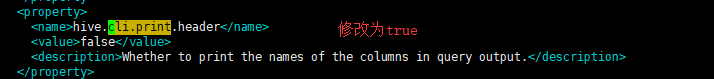

</property>配置hive显示当前数据库,和查询表头显示:

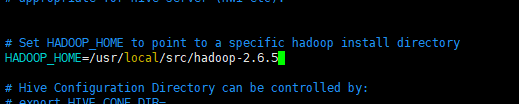

- hive-env.sh

cp hive-env.sh.template hive-env.sh

#指定hadoop路径

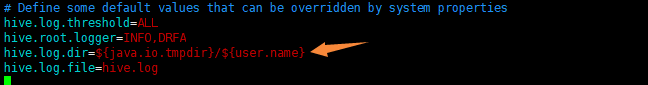

- hive-log4j.properties

cp hive-log4j.properties.template hive-log4j.properties

vim hive-log4j.properties修改log日志目录

4 增加环境变量

vim ~/.bashrc添加如下代码:

#hive

export HIVE_HOME=/usr/local/src/apache-hive-1.2.2-bin

export PATH=$HIVE_HOME/bin:$PATH#刷新环境变量

source ~/.bashrc5 安装MySQL连接工具

#下载安装包

cd mysql5

wget http://mirrors.ustc.edu.cn/mysql-ftp/Downloads/Connector-J/mysql-connector-java-5.1.46.tar.gz

tar zxvf mysql-connector-java-5.1.46.tar.gz

#复制连接库文件到hive的lib下

cp mysql-connector-java-5.1.46/mysql-connector-java-5.1.46.jar /usr/local/src/apache-hive-1.2.2-bin/lib/6 拷贝安装包(可以先把步骤7的bug修复了)

scp -r /usr/local/src/apache-hive-1.2.2-bin root@slave1:/usr/local/src/apache-hive-1.2.2-bin

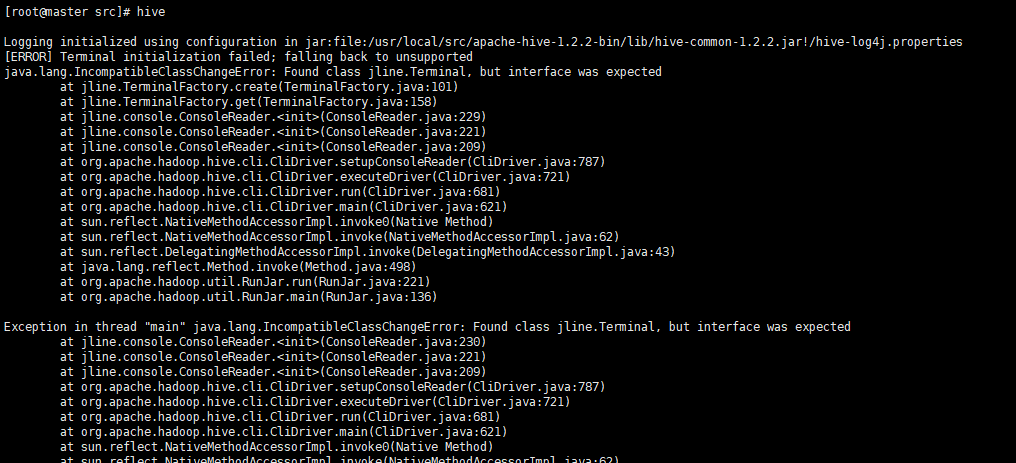

scp -r /usr/local/src/apache-hive-1.2.2-bin root@slave2:/usr/local/src/apache-hive-1.2.2-bin7 启动报错

[ERROR] Terminal initialization failed; falling back to unsupported

java.lang.IncompatibleClassChangeError: Found class jline.Terminal, but interface was expected

原因是hadoop目录下存在老版本jline---->解决:将hive下的新版本jline的JAR包拷贝到hadoop下,删除老的

cp /usr/local/src/apache-hive-1.2.2-bin/lib/jline-2.12.jar /usr/local/src/hadoop-2.6.5/share/hadoop/yarn/lib/

rm -rf /usr/local/src/hadoop-2.6.5/share/hadoop/yarn/lib/jline-0.9.94.jar 注意需要重启hadoop集群

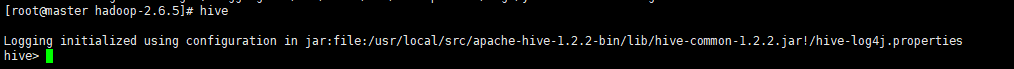

8 启动Hive服务(需要hadoop集群)

hive

9 观察mysql

显示增加了hive数据库

show databases;

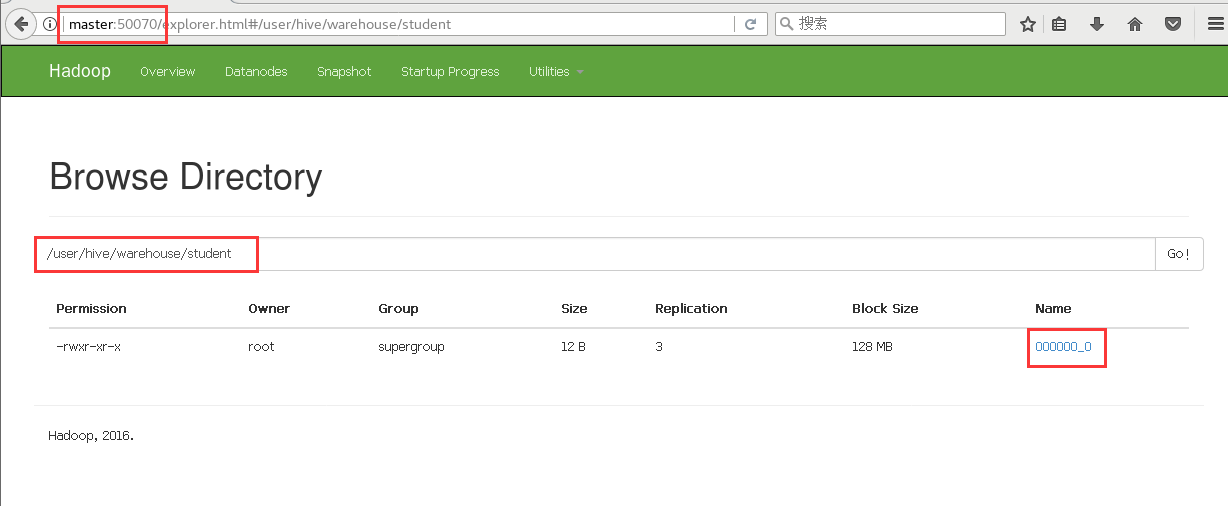

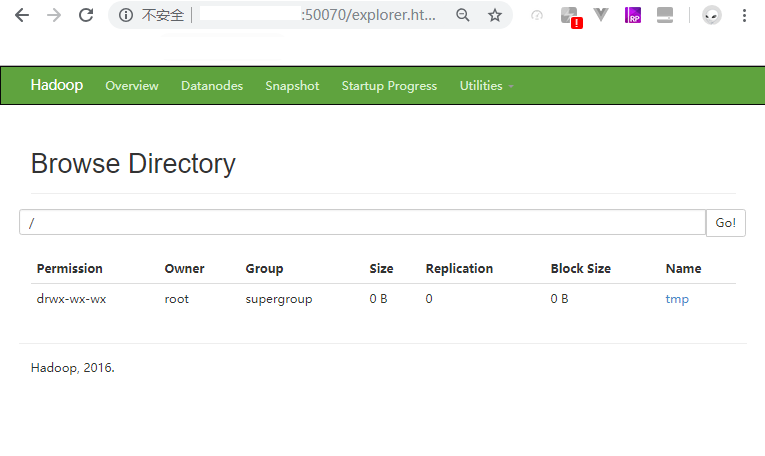

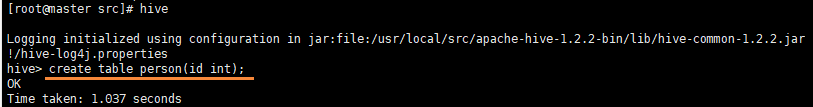

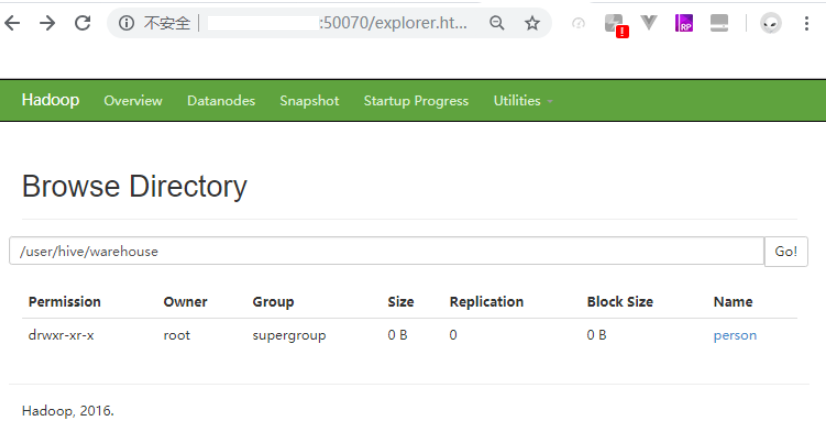

10 观察hdfs

在hive中创建一个表

hdfs上多了文件

三、Hive思维导图