1.启动hadoop

进入HADOOP_HOME sh bin/start-all.sh

2.关闭hadoop

进入HADOOP_HOME sh bin/stop-all.sh

3.查看/tmp目录下文件

hadoop fs -ls /tmp

hadoop fs -lsr /tmp —递归查看包括子目录文件

4.创建文件目录/tmp/newdir

hadoop fs -mkdir /tmp/newdir

5.删除文件或目录

hadoop fs -rm /tmp/newdir/a (a是文件)

hadoop fs -rmr /tmp/newdir 递归删除newdir

6.上传文件

hadoop fs -put /home/newfile /user/ 把本地文件上传至/user目录下

7.下载文件

hadoop fs -get /user/newfile /home

8.查看文件

hadoop fs -cat /user/newfile

9.集群间的信息拷贝

hadoop distcp hdfs://10.173.255.4:8020/user/hive/warehouse/url_yinxin_20160302 /tmp

10.查看hdfs剩余空间

hadoop fs -df /

11.显示访问控制列表的文件和目录

hadoop fs -getfacl /tmp

12.把几个源文件合并到本地(output文件中有a b c三个文件,合并成本地文件local_file)

hadoop fs -getmerge /user/hadoop/output local_file

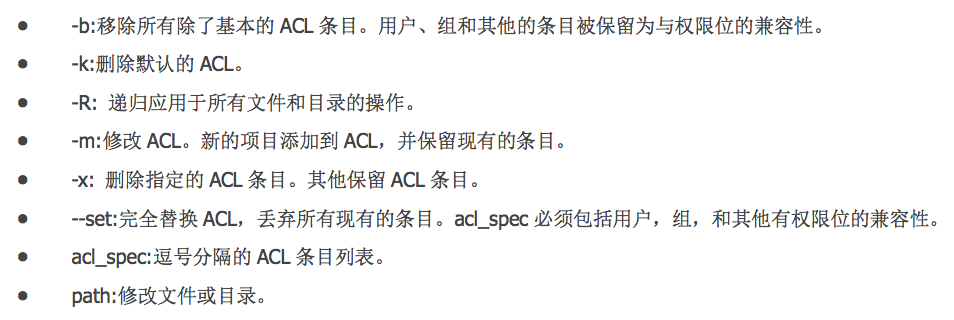

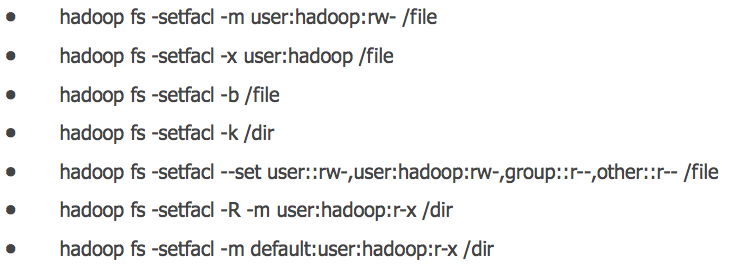

13.设置访问控制列表

hadoop fs -setfacl

例子:

hadoop fs -setfacl -R -m user:etla:rwx /home/dcp/sca_in/gene/

14.新建一个空文件(空文件a)

hadoop fs -touchz /tmp/a

15.hadoop 设置目录存储配额

hadoop dfsadmin -setSpaceQuota 3000 /group/d_sdo_data/user/liuxiaowen

16.查看目录配额

hadoop fs -count -q /group/d_sdo_data/user/liuxiaowen

17.清除目录配额限制

hadoop dfsadmin -clrSpaceQuota /group/d_sdo_data/user/liuxiaowen

18.查看当前hdfs的副本数

hadoop fsck -locations

19.修改hdfs副本数

hdfs dfs -setrep -R -w 2 hdfs://ns1/tmp/test.db20查看hdfs是否有坏块

hdfs dfsadmin -report