参考官方地址:https://spark.apache.org/docs/1.6.2/programming-guide.html

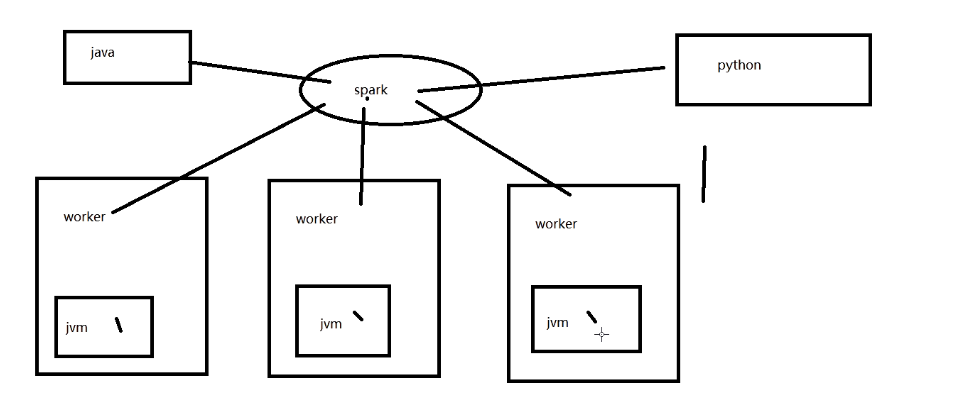

误解:

spark多语言的支持,并不是说spark可以操作各个语言写的程序。而是各种语言可以使用spark提供的编程模型来开发spark程序,并连接spark集群来运行开发好的app

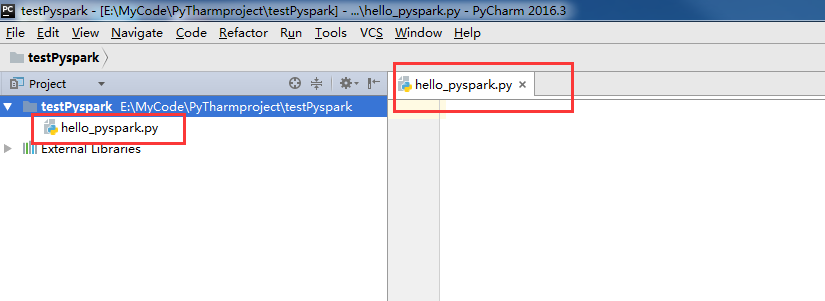

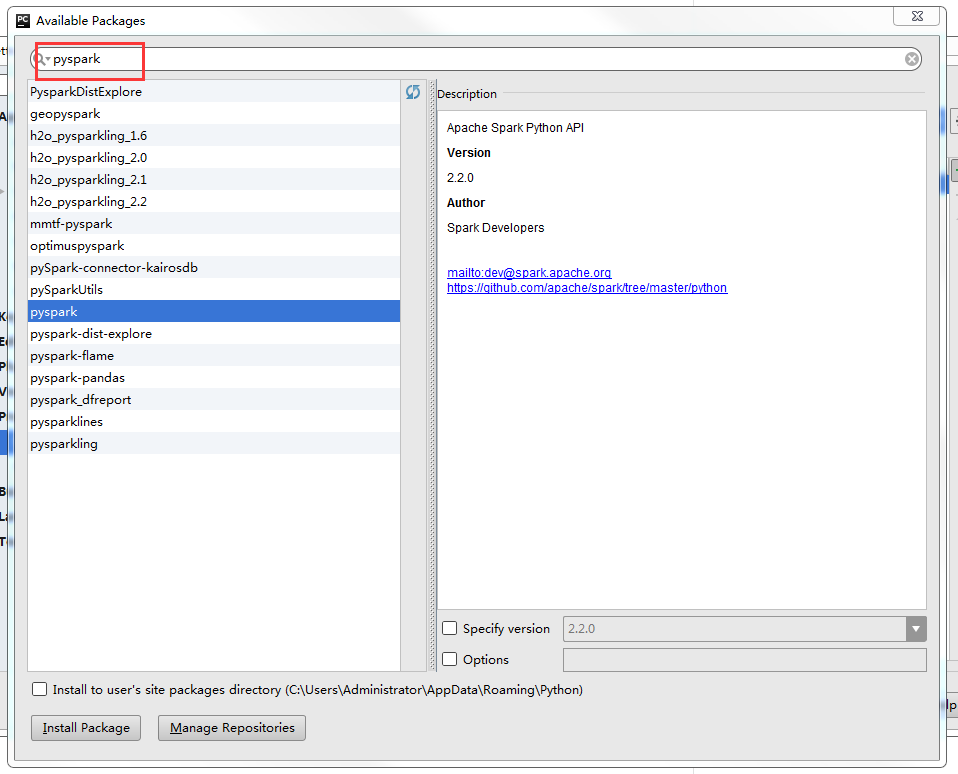

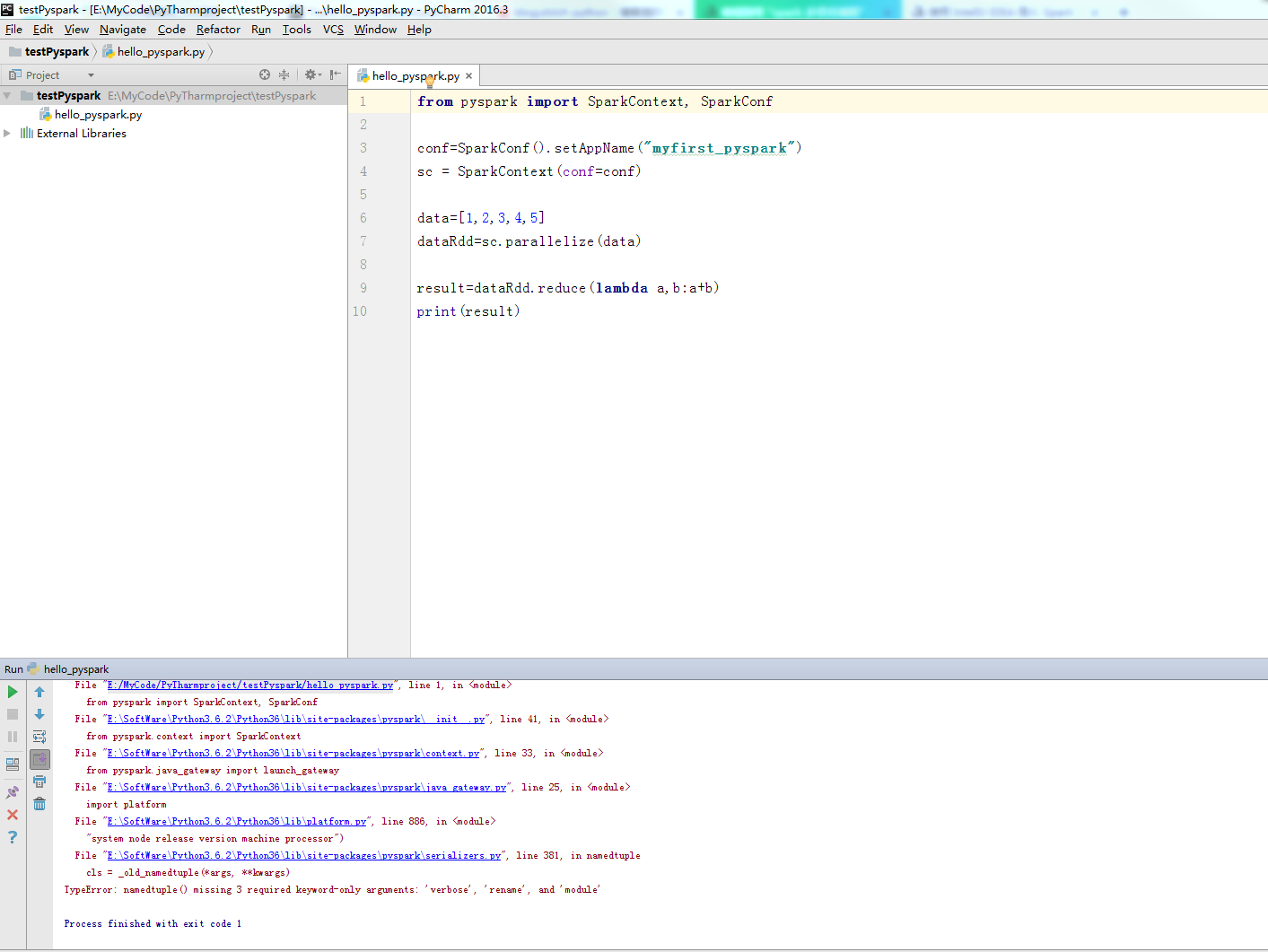

我在pycharm新建了一个项目

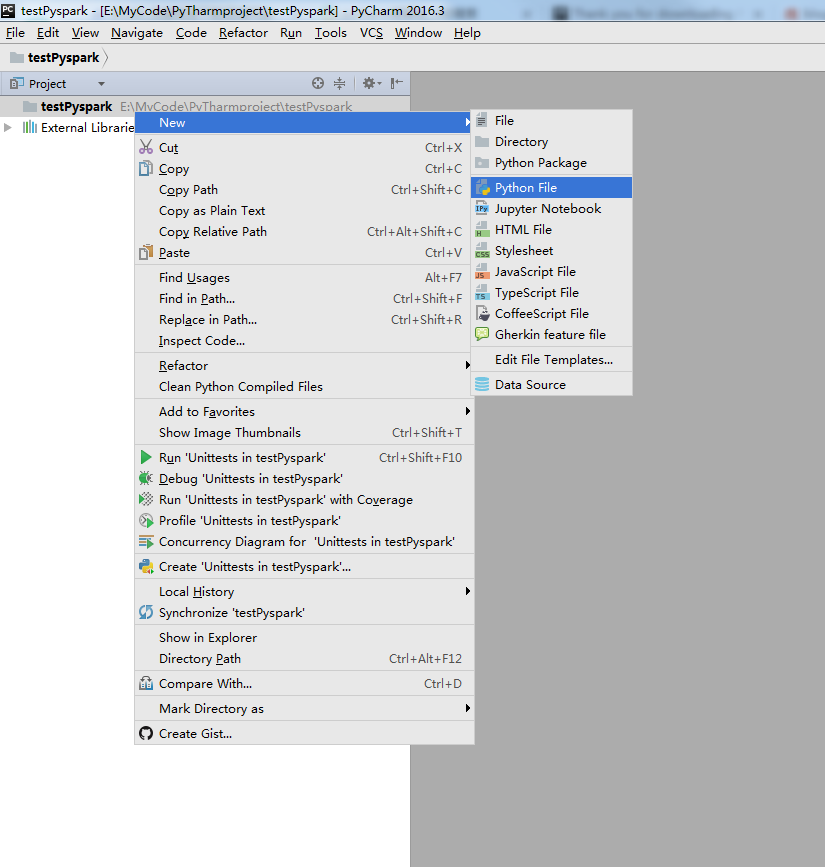

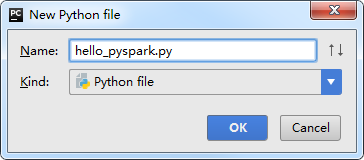

新建一个python文件

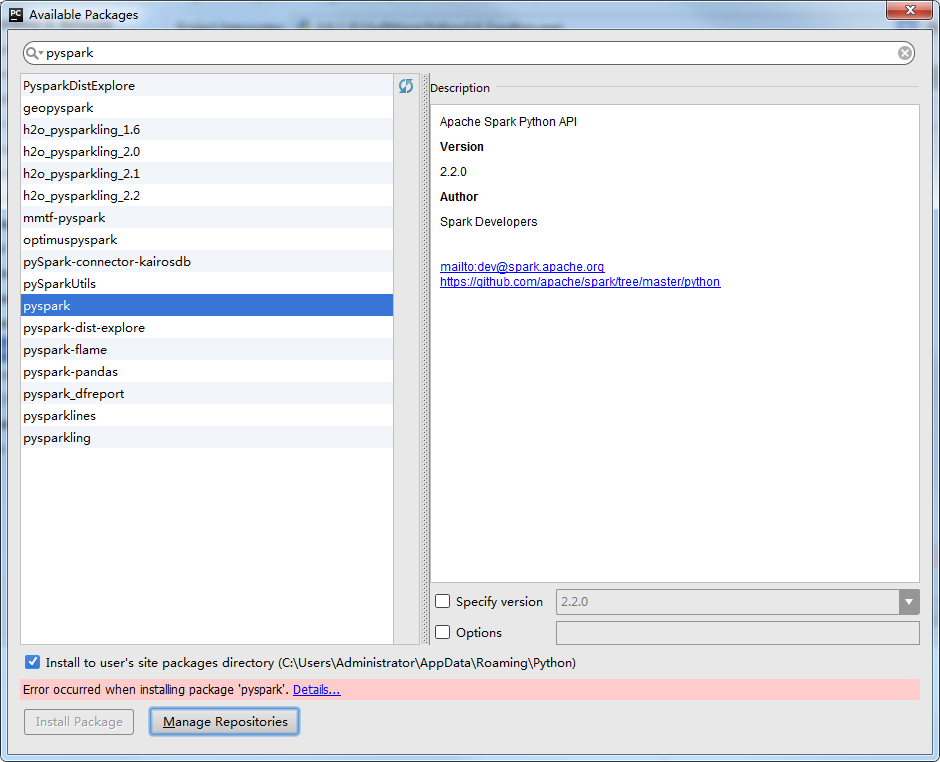

加载失败了!!

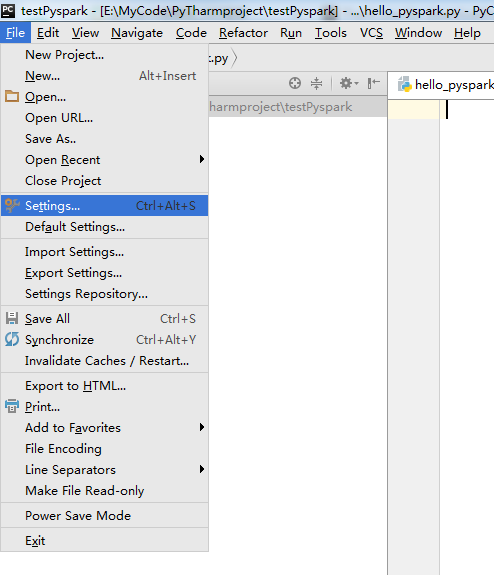

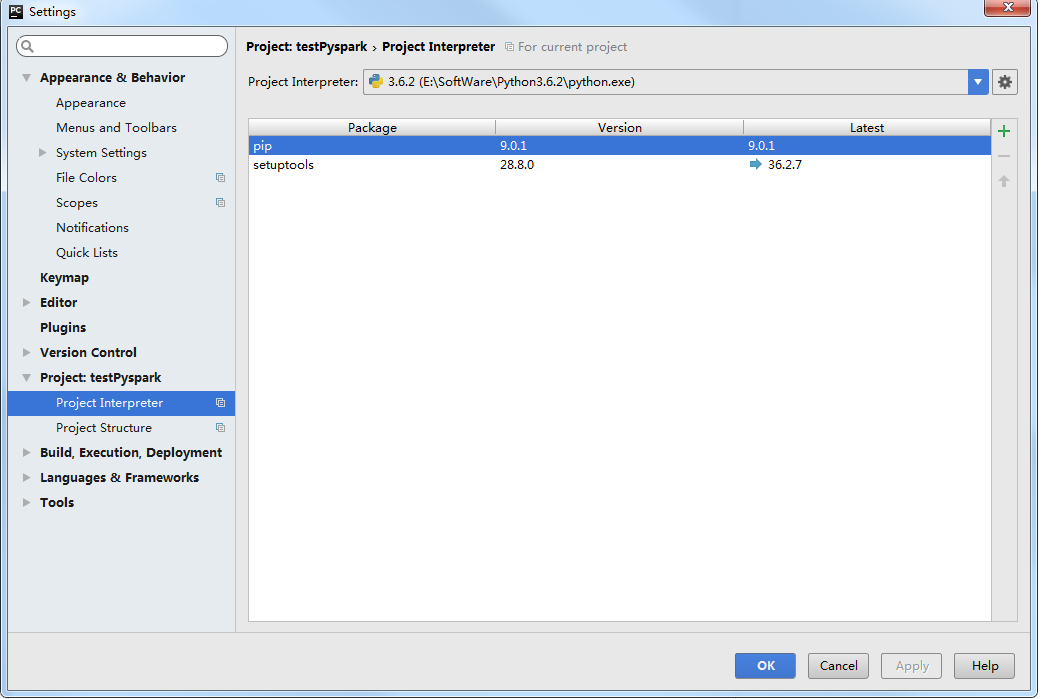

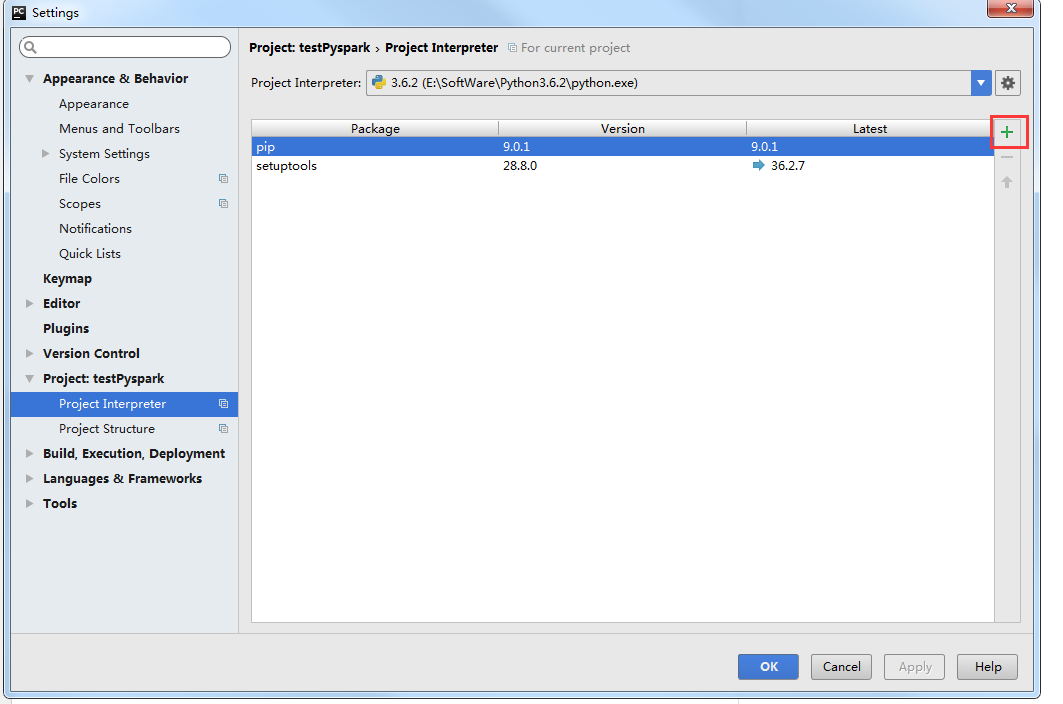

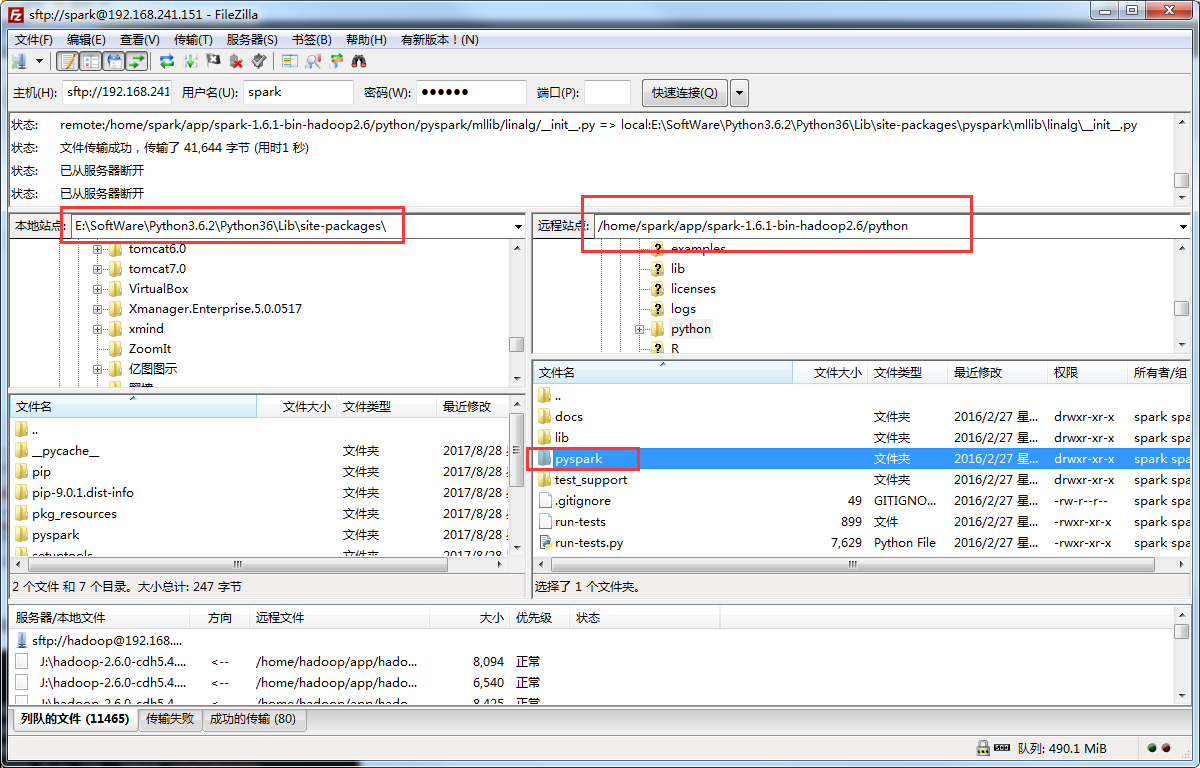

既然在软件加载失败了,我们就换种方法加载进去

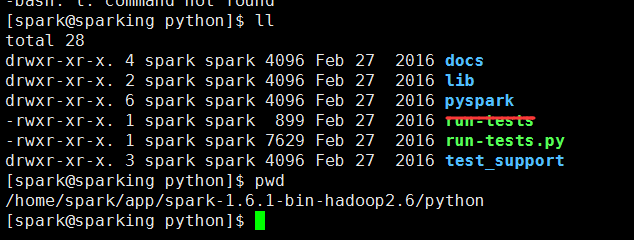

可以看到在centos下安装的/spark-1.6.1-bin-hadoop2.6下有我们需要的包

下载好后就把Pycharm重新启动一下,不重启的话会不认你刚刚下载的包

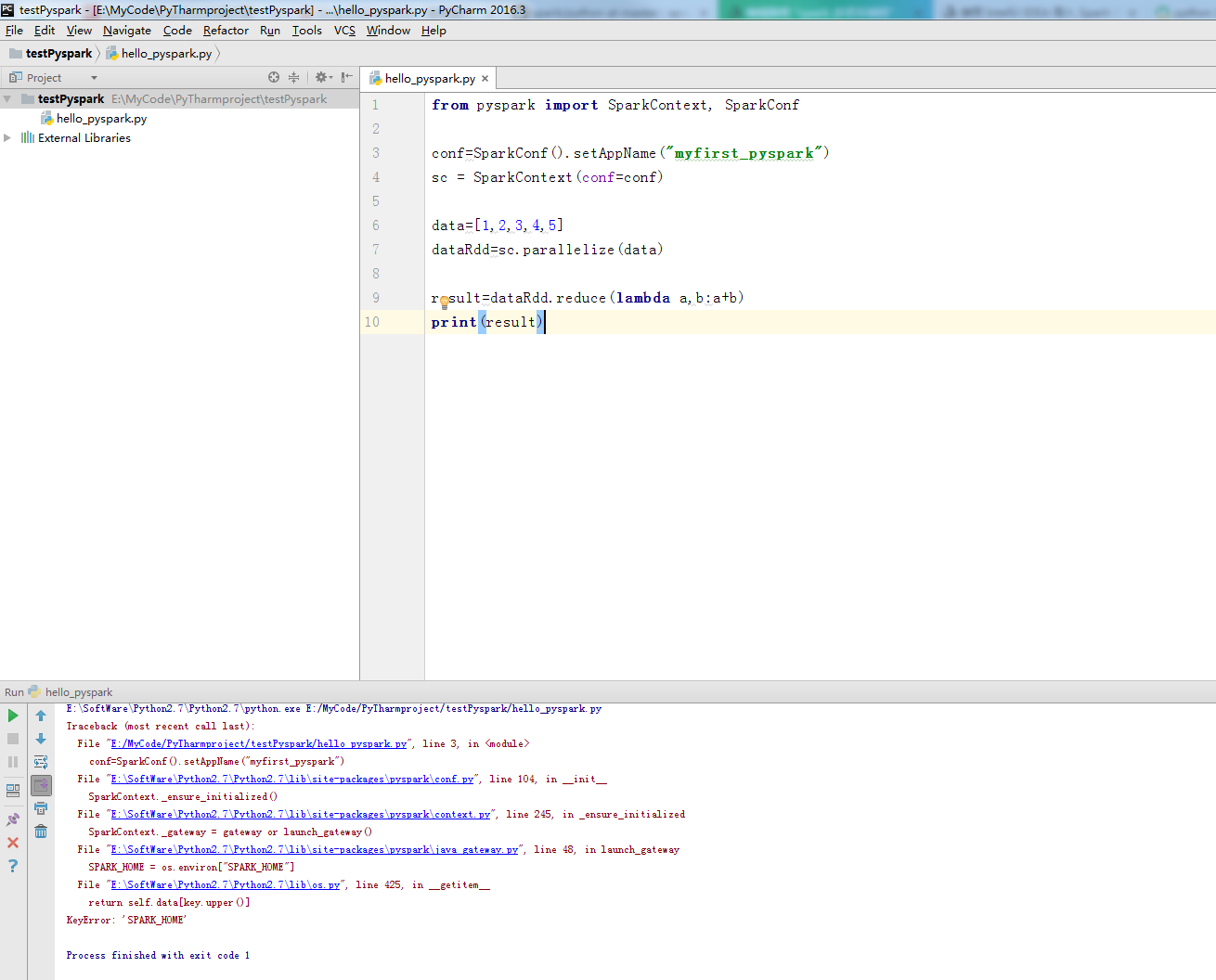

运行一下出错了!!!

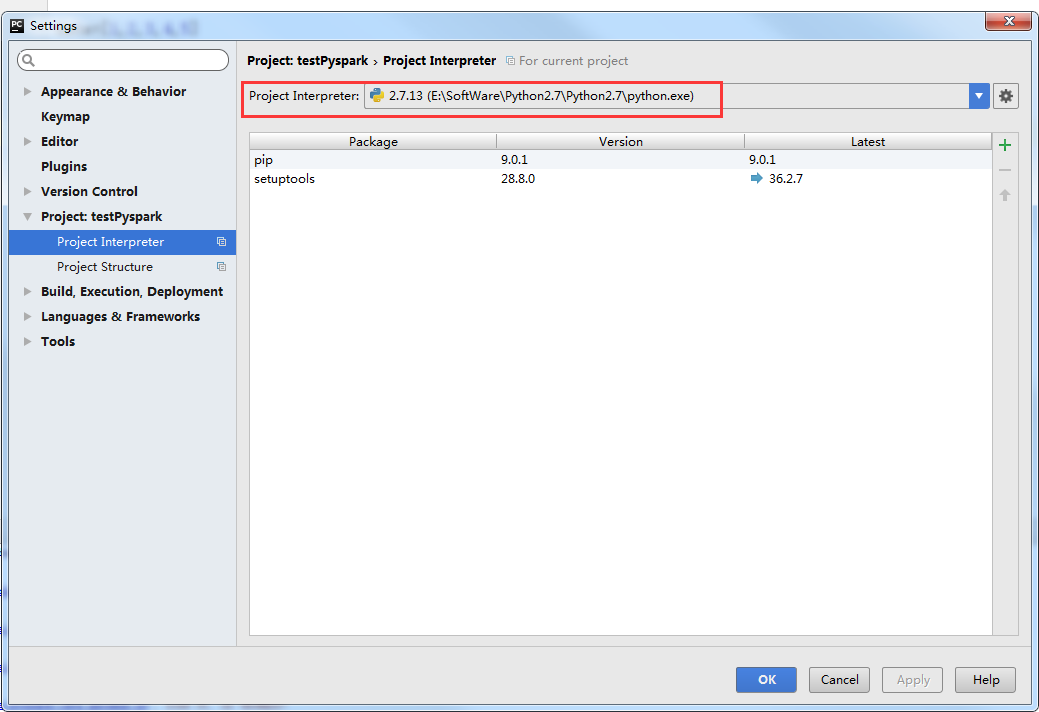

出现这个错误spark不支持python3.6,我就再安装了个python2.7的,那个pyspark包也拷过来

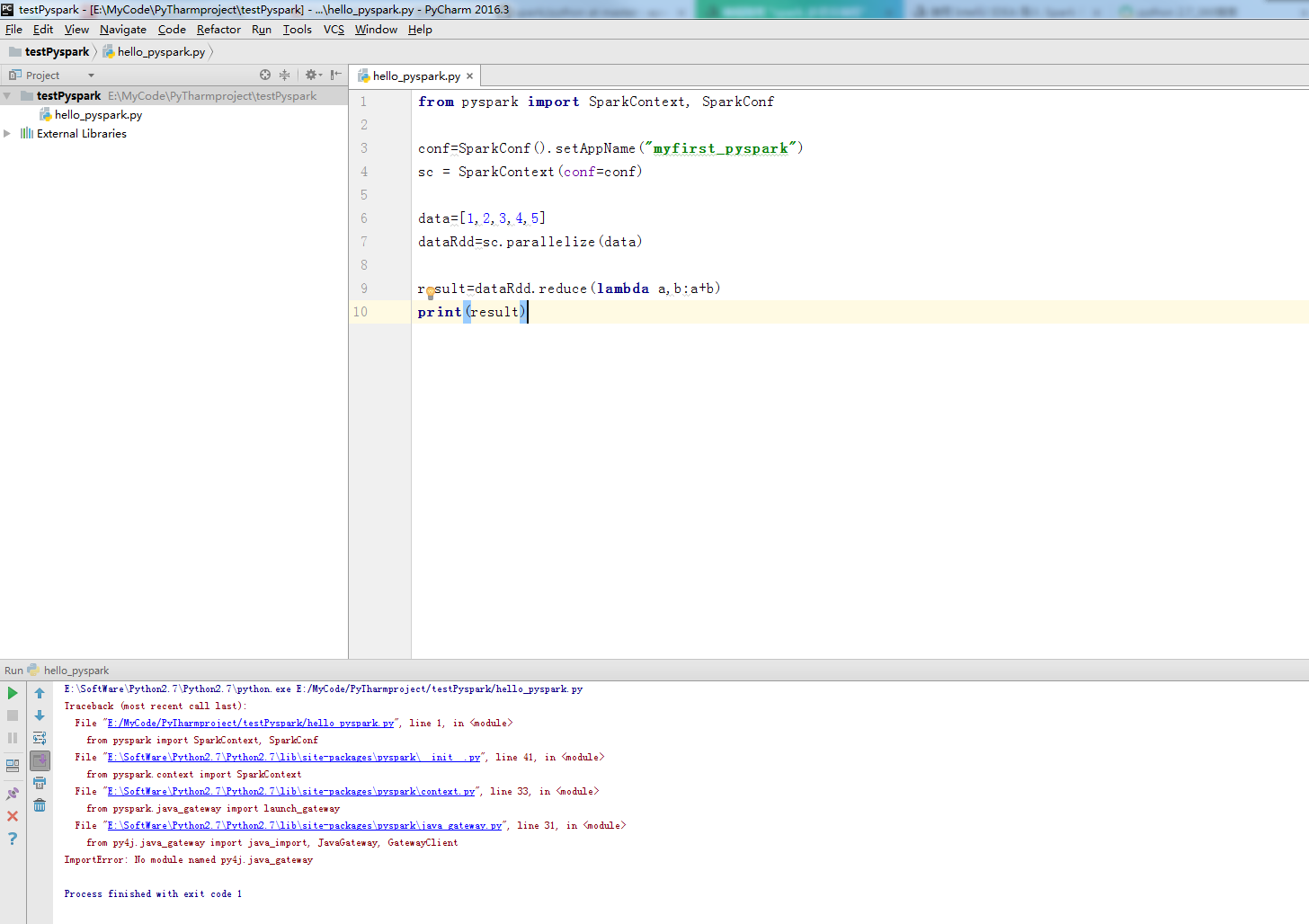

再次运行程序

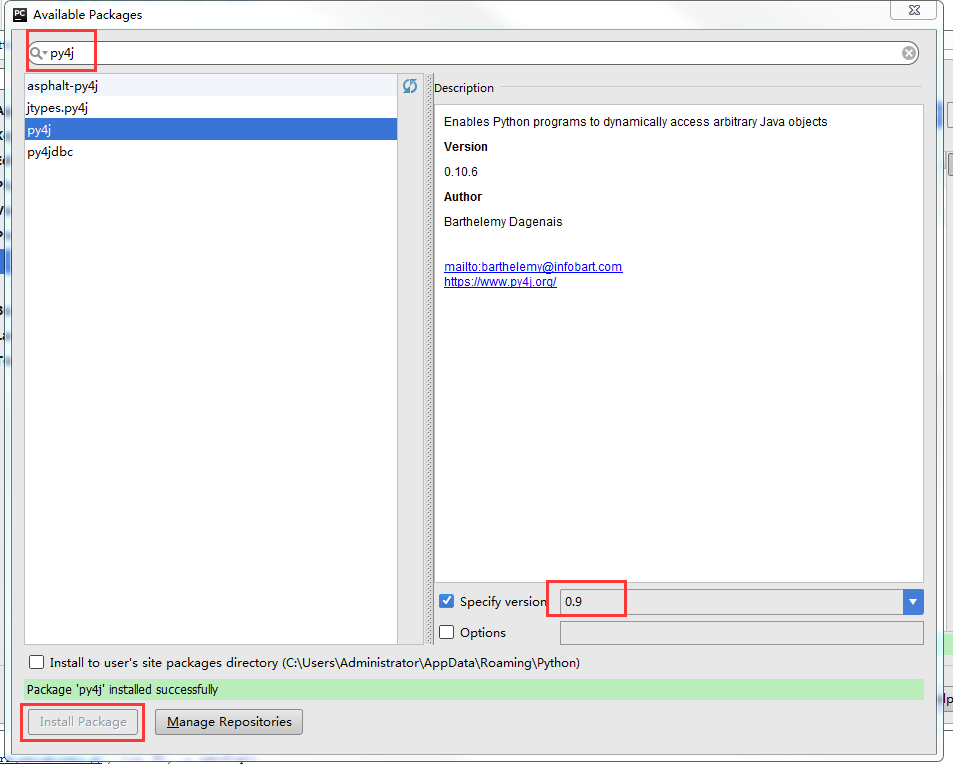

报错了,可以看到少了py4j这个包

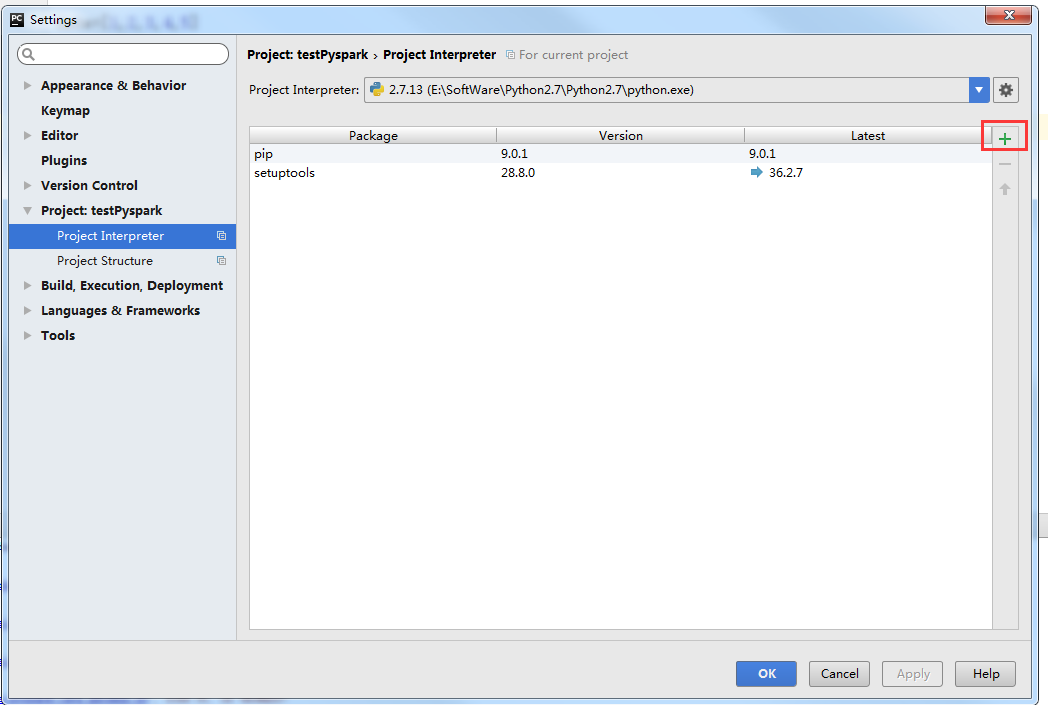

再次添加包

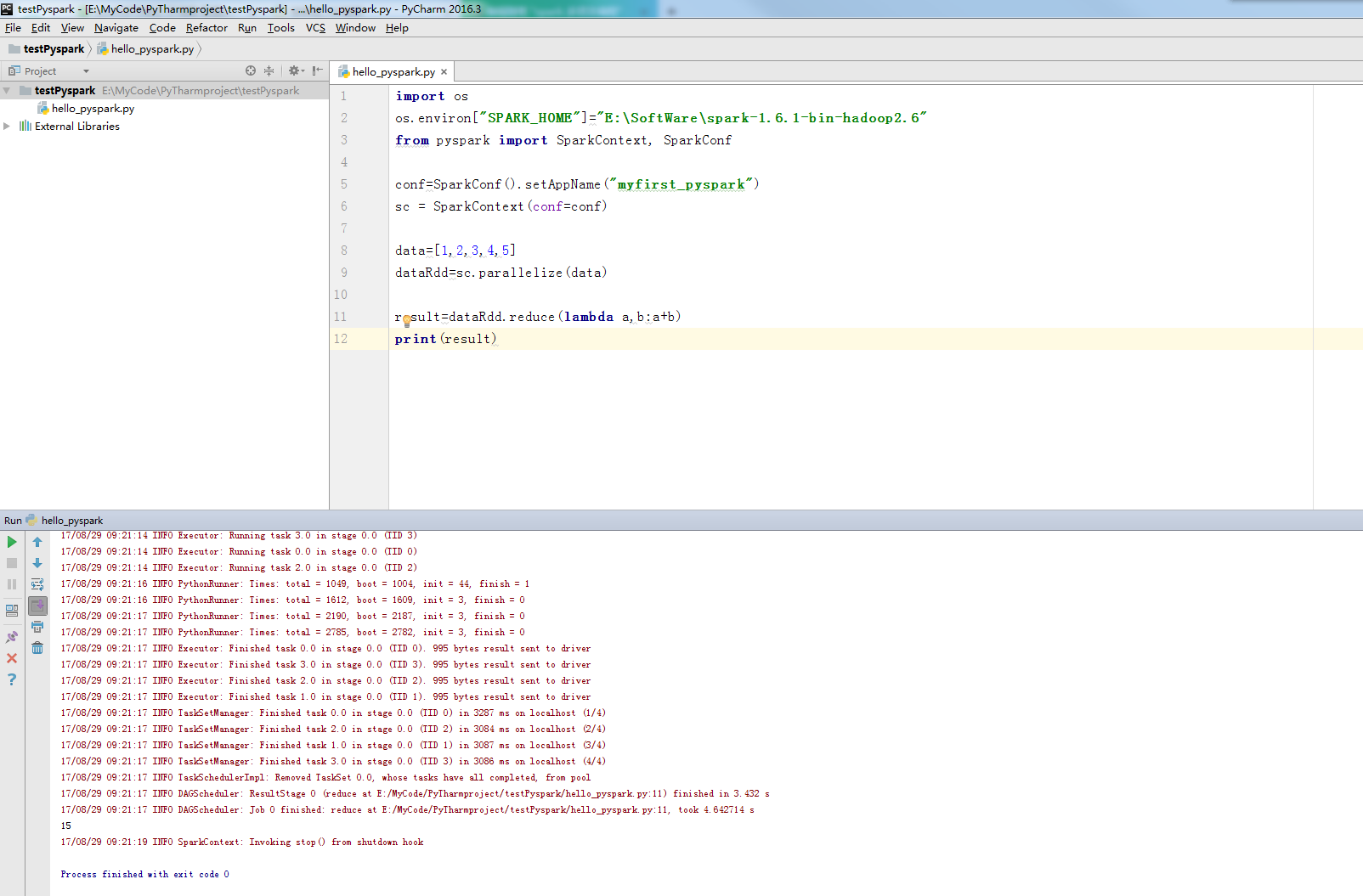

现在再次运行程序

配置一下spark的环境变量

成功了(在这里说明一下,我的spark安装在windows下面,昨晚这一步一直报错,今天早上开电脑跑了一下就成功了,具体原因我自己也不清楚)