一、实验目的

- 在实验 2 的基础上进一步熟悉 Mininet 自定义拓扑脚本,以及与损耗率相关的设

定; - 初步了解 Mininet 安装时自带的 POX 控制器脚本编写,测试路径损耗率。

二、实验任务

- h0 向 h1 发送数据包,由于在 Mininet 脚本中设置了连接损耗率,在传输过程中会丢失一些包,本次实验的目的是展示如何通过控制器计算路径损耗速率(h0-s0-s1-h1)。这里假设控制器预先知道网拓扑。控制器将向 s0 和 s1 发送flow_stats_request,当控制器接收到来自 s0 的 response 时,将特定流的数据包数保存在 input_pkts 中,当控制器接收到来自 s1 的 response 时,将接收到特定

流的数据包数保存在 output_pkts 中,差值就是丢失的数据包数量。基于上述拓扑,编写 Mininet 脚本,设置特定的交换机间的路径损耗速率,然后编写 POX 控制器脚本,实现对路径的损耗率的测量。

三、实验步骤

1. 实验环境

- 安装了 Ubuntu 18.04.5 Desktop amd64 的虚拟机

2. 实验过程

- SDNLAB 实验参考资料:https://www.sdnlab.com/15100.html

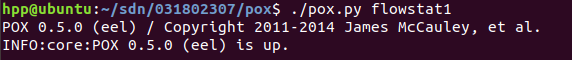

(1)新建并编辑 pox 脚本 flowstat.py: 在 pox 安装目录下(Mininet 完整安装包含了 pox)执行以下命令运行 pox 脚本

-

$ ./pox.py flowstat

-

现在一起看下 flowstat.py 的关键代码:

-

第 7 行开始,让 h0 ping h1,监测 s0 和 s1 之间的链路。

- 如果匹配到以太网类型的包头(0x0800),并且数据包的目的 IP 地址是192.168.123.2(对照后面 Mininet 的脚本发现是 h1),并且连接到控制器的数据平面设备 id 是 s0(h0 ping h1,链路 s0-s1 上数据包是从 s0 流向 s1,s0 为源,s1 为目的地),执行 input_pkts = f.packet_count,把数据包数量存入input_pkts;

- 同理,如果连接到控制器的数据平面设备 id 是 s1,执行 output_pkts = f.packet_count,把数据包数量存入 output_pkts。

- 最后求 input_pkts 和 output_pkts 的差值。一般情况下差值为正,说明链路上数据包有损耗。

def _handle_flowstats_received (event):

#stats = flow_stats_to_list(event.stats)

#log.debug("FlowStatsReceived from %s: %s", dpidToStr(event.connection.dpid), stats)

global src_dpid, dst_dpid, input_pkts, output_pkts

#print "src_dpid=", dpidToStr(src_dpid), "dst_dpid=", dpidToStr(dst_dpid)

for f in event.stats:

if f.match.dl_type==0x0800 and f.match.nw_dst==IPAddr("192.168.123.2") and f.match.nw_tos==0x64

and event.connection.dpid==src_dpid:

#print "input: ", f.byte_count, f.packet_count

input_pkts = f.packet_count

if f.match.dl_type==0x0800 and f.match.nw_dst==IPAddr("192.168.123.2") and f.match.nw_tos==0x64

and event.connection.dpid==dst_dpid:

#print "output: ", f.byte_count, f.packet_count

output_pkts = f.packet_count

if input_pkts !=0:

print getTheTime(), "Path Loss Rate =", (input_pkts-output_pkts)*1.0/input_pkts*100, "%"def _handle_flowstats_received (event):

#stats = flow_stats_to_list(event.stats)

#log.debug("FlowStatsReceived from %s: %s", dpidToStr(event.connection.dpid), stats)

global src_dpid, dst_dpid, input_pkts, output_pkts

#print "src_dpid=", dpidToStr(src_dpid), "dst_dpid=", dpidToStr(dst_dpid)

for f in event.stats:

if f.match.dl_type==0x0800 and f.match.nw_dst==IPAddr("192.168.123.2") and f.match.nw_tos==0x64

and event.connection.dpid==src_dpid:

#print "input: ", f.byte_count, f.packet_count

input_pkts = f.packet_count

if f.match.dl_type==0x0800 and f.match.nw_dst==IPAddr("192.168.123.2") and f.match.nw_tos==0x64

and event.connection.dpid==dst_dpid:

#print "output: ", f.byte_count, f.packet_count

output_pkts = f.packet_count

if input_pkts !=0:

print getTheTime(), "Path Loss Rate =", (input_pkts-output_pkts)*1.0/input_pkts*100, "%"

(2)编辑 Mininet 脚本 mymininet3.py

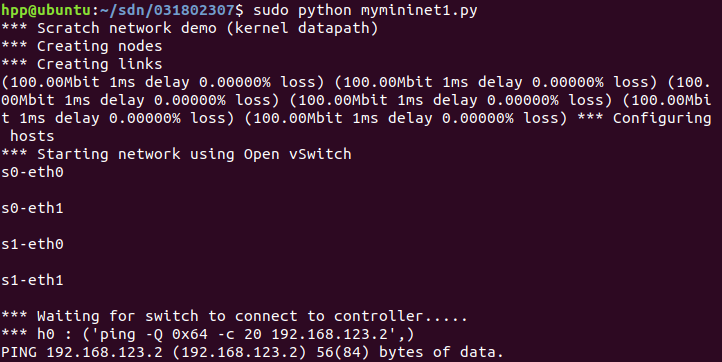

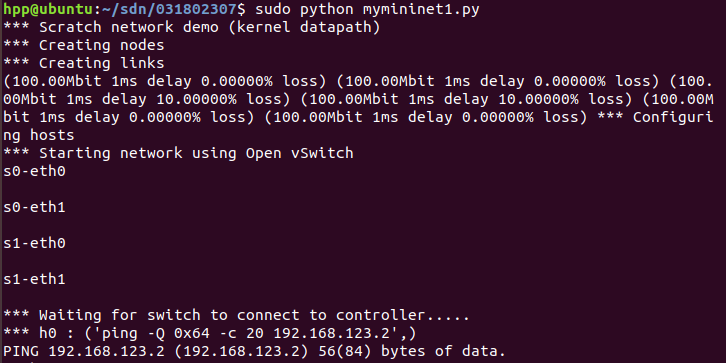

- 参照拓扑图,新建并编辑 Mininet 脚本 mymininet1.py,控制器因为安装在本机,所以需修改参考资料代码中的控制器地址为 127.0.0.1:6633。

switch.cmd( 'ovs-vsctl set-controller dp0 tcp:127.0.0.1:6633' )

switch1.cmd( 'ovs-vsctl set-controller dp1 tcp:127.0.0.1:6633' )

- 设置 s0 和 s1 之间链路的丢包率为 0

info( "*** Creating links

" )

linkopts0=dict(bw=100, delay='1ms', loss=0)

linkopts1=dict(bw=100, delay='1ms', loss=0)

link0=TCLink( h0, switch, **linkopts0)

link1 = TCLink( switch, switch1, **linkopts1)

link2 = TCLink( h1, switch1, **linkopts0)

-

再执行命令运行 Mininet 脚本 mymininet1.py

$ sudo python mymininet1.py

-

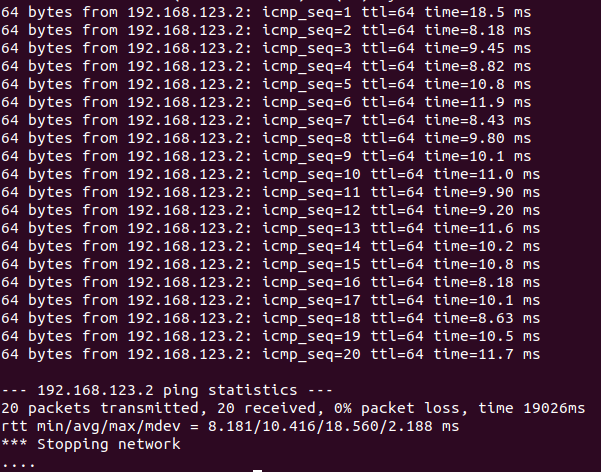

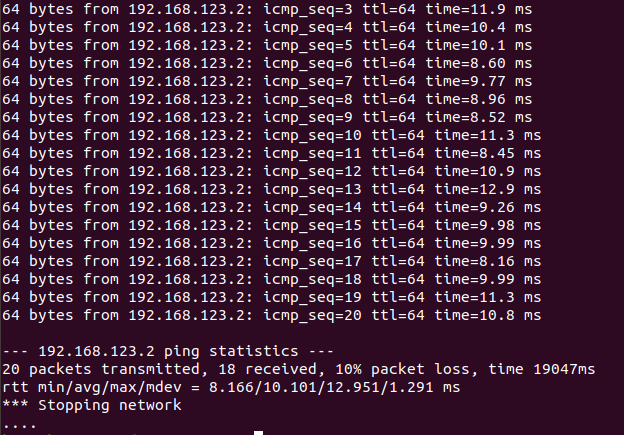

Ping 默认是每 1 秒钟测一次,ping 的结果会显示一个丢包率,这里的丢包率是根 据 ping 不通的次数占总次数的百分比计算得到的。上图中由于一共 ping 了 20次,每次都能通,所以丢包率是 0。

-

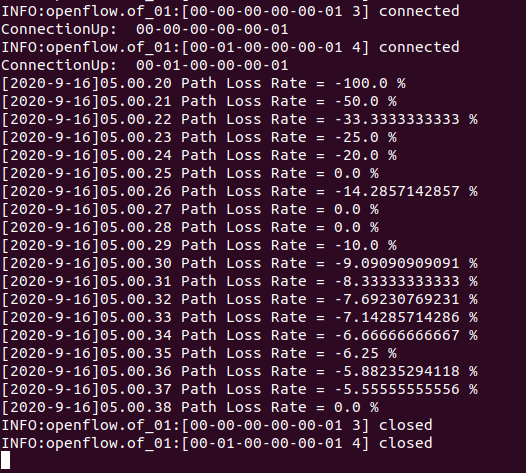

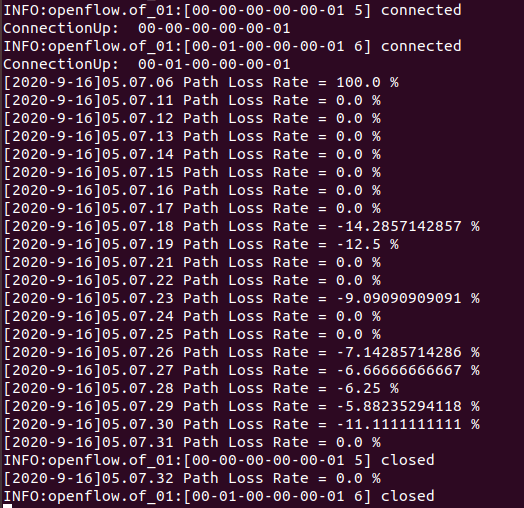

观察 pox 侧的实时状态更新

-

平均丢包率为 0,结果符合 Mininet 脚本中设置的损耗率,也有可能出现负值,可以认为没有丢包。

-

如果修改代码中 s0 和 s1 之间链路的丢包率为 10。

info( "*** Creating links

" )

linkopts0=dict(bw=100, delay='1ms', loss=0)

linkopts1=dict(bw=100, delay='1ms', loss=10)

link0=TCLink( h0, switch, **linkopts0)

link1 = TCLink( switch, switch1, **linkopts1)

link2 = TCLink( h1, switch1, **linkopts0)

-

重新运行 Mininet 脚本 mymininet1.py,20 秒时间的 ping 过程中有 icmp_seq 为 1/2 共 2 次 ping 不通,所以丢包率计算为 10%。

-

POX 端重新测试,会发现出现丢包现象,但是实际测量出的丢包率会有浮动,链路的性能总体受到了限制。

四、实验要求

1. 根据实验步骤重复上述实验。

2. 在博客园发表一篇博客,记录主要步骤。

五、实验心得

- 善用sudo gedit来编辑文件