Introduction:A Non-Rigorous Review of Deep Learning

原文地址

本篇文章为 MIT 课程 Mathematical Aspects of Deep Learning 的lecture 1 的学习笔记,没有进行完整的翻译,仅供参考

2.卷积网络(Convolution Network)

卷积网络是有线性算子的网络,有使用“底层网格几何”(underlying grid geometry)的局部卷积算子。

卷积层

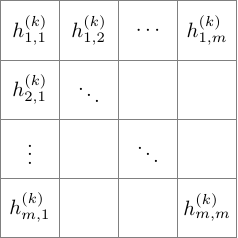

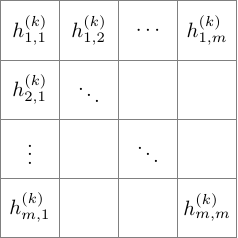

举例来说,用 m×m 的网格结构来表示网络的第 k 层的话,如下图所示

我们定义第 k+1 层的函数 h(k+1)i,j 是由其下面一层的 2×2 方阵卷积运算,再带入非线性函数 g 求得的:

h(k+1)i,j=g(a(k)h(k)i,j+b(k)h(k)i+1,j+c(k)h(k)i,j+1+d(k)h(k)i+1,j+1)

参数 a(k),b(k),c(k),d(k) 只取决于其所在的层,与具体的方阵坐标 i,j 无关(在视觉领域应用中的必要限制,基本定义并无这一限制)

优点:

- 参数共享

- 函数 h 定义的 局部性 使网络获得了“稀疏性”(sparsity)

池化层(Pooling)

经过卷积操作和 g 函数运算后,得到 grid-indexed 函数 h(k+1)i,j ,我们用其邻近范围内的所有函数的均值或最大值来替代这个函数。

h¯(k+1)i,j=14(h(k+1)i,j+h(k+1)i+1,j+h(k+1)i,j+1+h(k+1)i+1,j+1)

这个技巧也可以用来减少维度