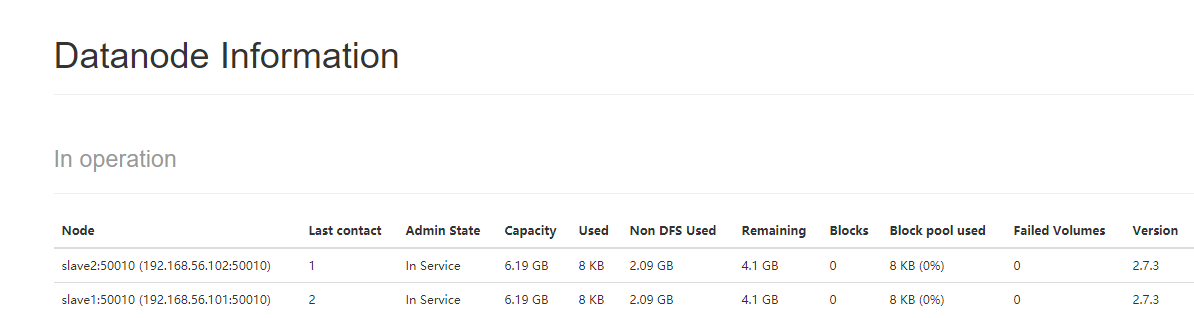

(1)观察集群配置情况

[root@master ~]# hdfs dfsadmin -report (注意:这时要启动namenode,命令hadoop-daemon.sh start namenode)

(2)web界面观察集群运行情况

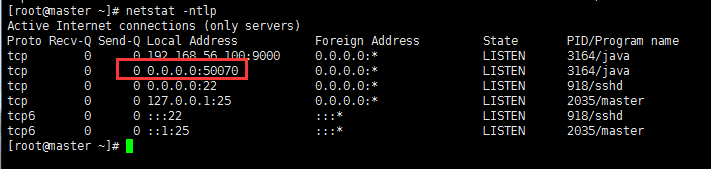

使用netstat命令查看端口监听

[root@master ~]# netstat -ntlp

浏览器地址栏输入:http://192.168.56.100:50070 (注意要关掉192.168.56.100的防火墙,否则连接不上。

systemctl stop firewalld.service 关掉防火墙

systemctl disable firewalld.service 重启后也不会启动防火墙

)

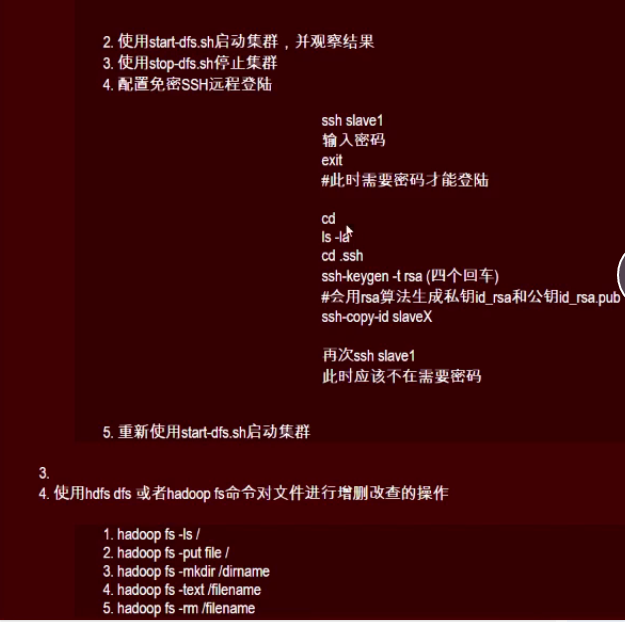

(3)root@master .ssh]#ssh-keygen -t rsa(四个回车)

(4)[root@master .ssh]# ls

id_rsa id_rsa.pub known_hosts (发现生成一个公钥一个私钥)

(5)(a)root@master .ssh]# ssh-copy-id slave1 把生成的公钥拷贝到slave1

这时ssh slave1发现并不需输入slave1 的密码就可以连接到slave1

切换到slave1,

(b) [root@salve1 ~]# cd .ssh (注意这个文件只有执行了ssh-copy-id slave1 后,才会在slave1中生成)

[ root@salve1 .ssh]# ls

authorized_keys (这个新生成的文件里就保存了slave1的公钥)

用同样的方式把公钥复制给slave2、master(也要拷贝一份公钥给自己,即使是主机,默认也是远程登录)

(6)[root@master .ssh]# start-dfs.sh 启动集群。(这是启动或者关闭集群就不需要输入密码了。stop-dfs.sh是关闭集群)

[root@master .ssh]# jps是查看启动情况

[root@salve1 ~]# jps 查看slave的启动情况

(7)hadoop fs -ls/ 查看根目录的文件

(8) find / -name hdfs-site.xml 查找文件路径,并将数据备份数由默认的3改为2

vim /usr/local/hadoop-2.7.3/etc/hadoop/hdfs-site.xml

(9)[root@master local]# hadoop fs -rm hadoop-2.7.3.tar.gz / 把文件hadoop-2.7.3.tar.gz赋值到文件系统的根目录下

例如:把linux下root下install.log文件上传的hadoop的hdfs的d1目录下

hadoop fs -put /root/install.log /d1

如果从fs上删除此文件:

命令为:[root@master local]# hadoop fs -rm /hadoop-2.7.3.tar.gz

hdfs 删除文件夹

hadoop fs -rmr /d1 此语句的意思是删除hdfs的根目录下的d1文件夹下的所有文件

(9)