Softmax

softmax可以将经交叉熵损失函数的输出都映射到 0 到 1 间,且各分类累和为 1。符合概率分布。

假设共有 n 个输出 [Z1,...,Zn],对第 i 个元素 Zi 的softmax的计算公式:Si = ezi / sum(ezn)

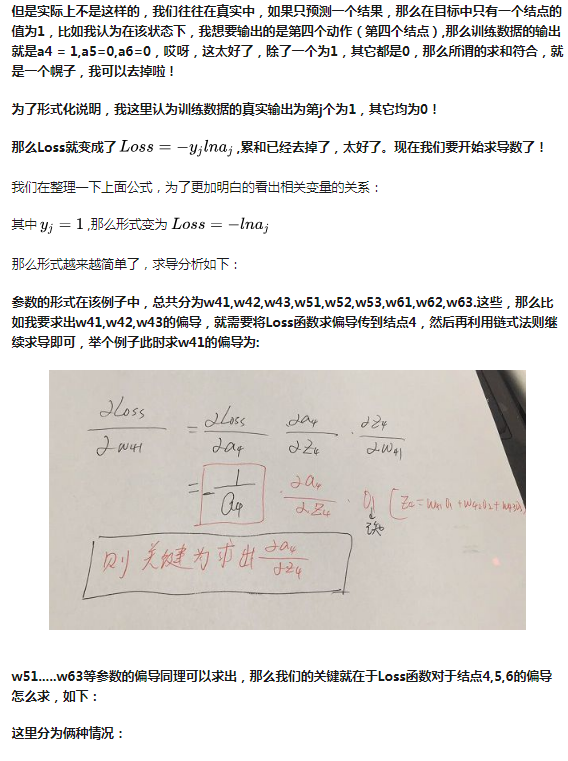

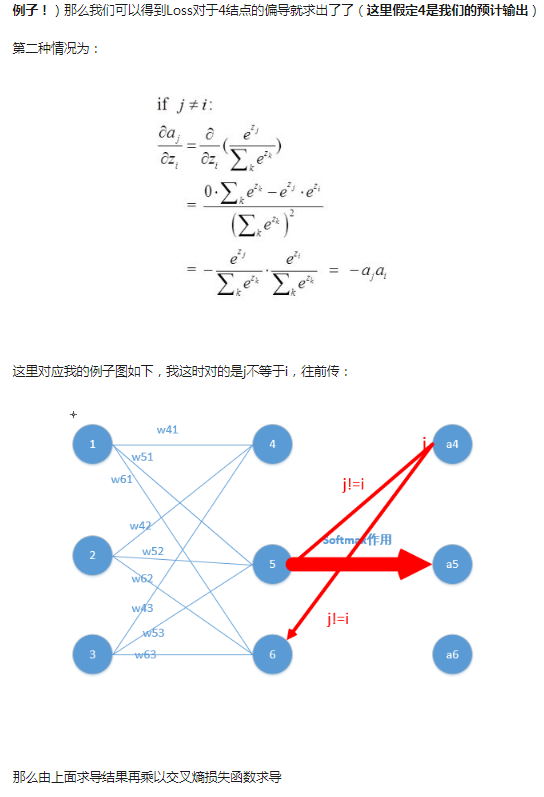

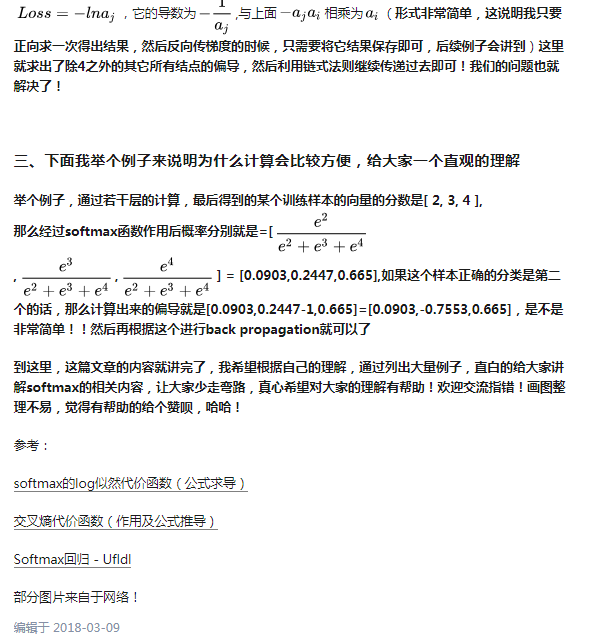

softmax的反向传播求导过程:

博客园上面公式太难弄了,于是上传的手推图。。然后图有点糊了。。

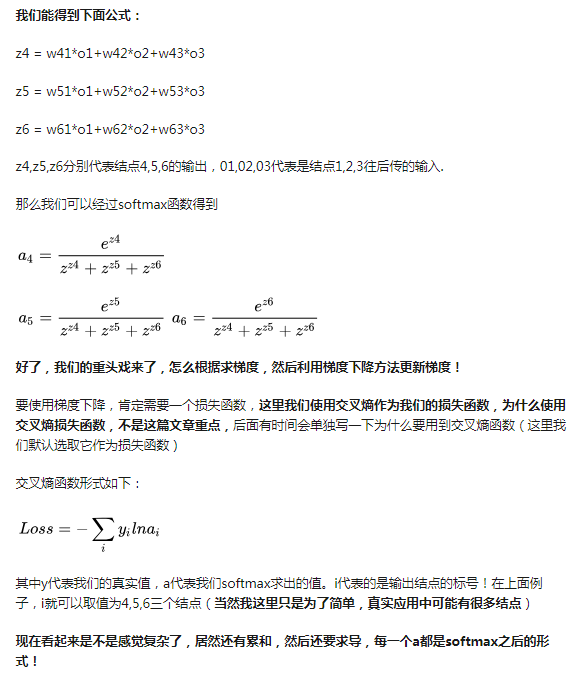

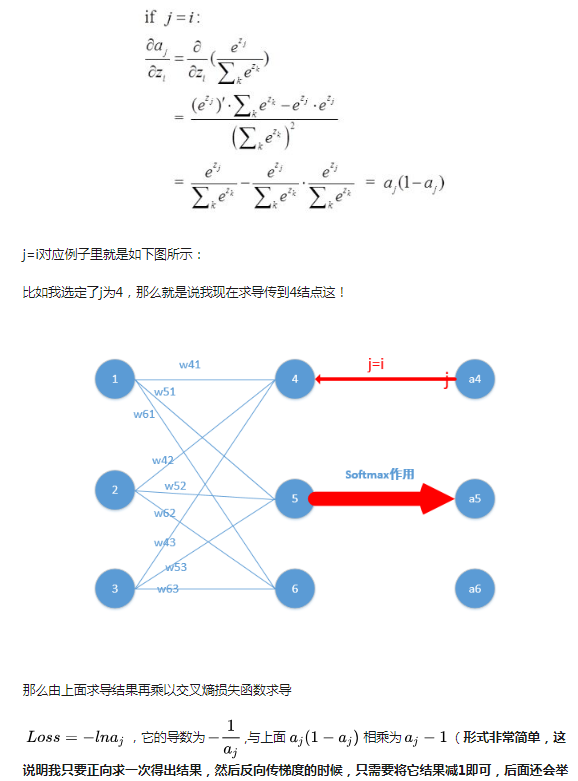

再贴一个参考博客的截图吧,原文链接:https://zhuanlan.zhihu.com/p/25723112

以下为截图内容:

(第一部分省略)

主要怕以后万一文章删掉了或链接失效了,没得参考了。自己的手推图又比较糊,侵删。

参考:

https://zhuanlan.zhihu.com/p/25723112