一般情况下,我并不建议使用自己的IP来爬取网站,而是会使用代理IP。

原因很简单:爬虫一般都有很高的访问频率,当服务器监测到某个IP以过高的访问频率在进行访问,它便会认为这个IP是一只“爬虫”,进而封锁了我们的IP。

那我们爬虫对IP代理的要求是什么呢?

- 1、代理IP数量较多,可以减低被封锁的概率;

- 2、IP生命周期较短,因为没钱o(´^`)o。

接下来,就讲一下从购买代理IP到urllib配置代理IP的全过程。

购买代理IP:

代理IP的中间商有很多,我们以无忧代理为例。

- 这里共有4套餐,我们选择第一个“¥10”套餐,进入详情界面:

- 竟然更便宜了,只要8.5???买!

(我真的没拿无忧代理的广告费......) - 购买成功之后,我们点击“创建API接口”:

- 获取HTTP爬虫代理IP的API链接:

配置代理IP:

- 我们先调用下接口试一下:

import urllib.request as ur

proxy_address = ur.urlopen('http://api.ip.data5u.com/dynamic/get.html?order=d314e5e5e19b0dfd19762f98308114ba&sep=4').read()

print(proxy_address)

- 由于返回结果为字节,我们还需对其进行

utf-8格式转换,以及去空格:

proxy_address = proxy_address.decode('utf-8').strip()

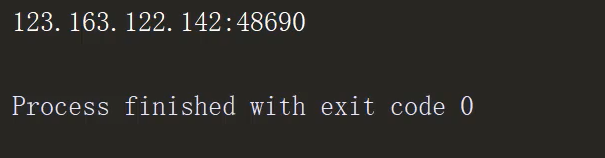

输出如下:

- 创建proxy_handler:

proxy_handler = ur.ProxyHandler(

{

'http': proxy_address

}

)

- 新建opener对象:

proxy_opener = ur.build_opener(proxy_handler)

- 使用代理IP进行访问并输出:

request = ur.Request(url='https://edu.csdn.net/')

# open == urlreponse,只是进行了代理IP封装

reponse = proxy_opener.open(request).read().decode('utf-8')

print(reponse)

输出如下:

全文完整代码:

import urllib.request as ur

proxy_address = ur.urlopen('http://api.ip.data5u.com/dynamic/get.html?order=d314e5e5e19b0dfd19762f98308114ba&sep=4').read().decode('utf-8').strip()

# print(proxy_address)

# 创建proxy_handler

proxy_handler = ur.ProxyHandler(

{

'http': proxy_address

}

)

# 新建opener对象

proxy_opener = ur.build_opener(proxy_handler)

request = ur.Request(url='https://edu.csdn.net/')

# open == urlreponse,只是进行了代理IP封装

reponse = proxy_opener.open(request).read().decode('utf-8')

print(reponse)

为我心爱的女孩~~