逻辑回归(Logistic Regression)

定义

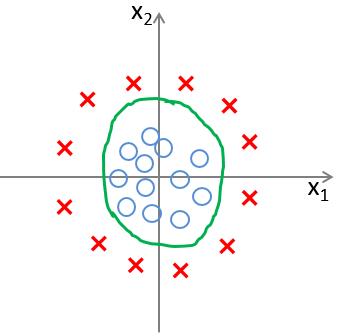

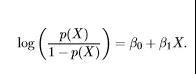

逻辑回归,又被称为对数几率回归,被用于监督学习-离散分类,重点是寻找最优决策边界 但结果变量和自变量的对数概率(log-odds)具有线性关系。

主要目的是使训练数据的标签值域预测出来的值之间的误差最小化。

逻辑回归主要思想就是用最大似然概率方法构建出方程,为最大化方程,利用牛顿梯度上升求解方程

用于解决分类问题,逻辑回归为啥不叫做逻辑分类,主要是因为逻辑回归应用了回归的思想去解决分类问题。(回归指的是接近拟合逼近一个界,这个界进行分类的cost最少)。使用logit方法去代替单位阶跃函数

优缺点

优点:计算代价不高,易于理解和实现

缺点:容易欠拟合,分类精度可能不高

逻辑回归的核心-比率(odds)

概率(0-1)!=比率(0-正无穷大)

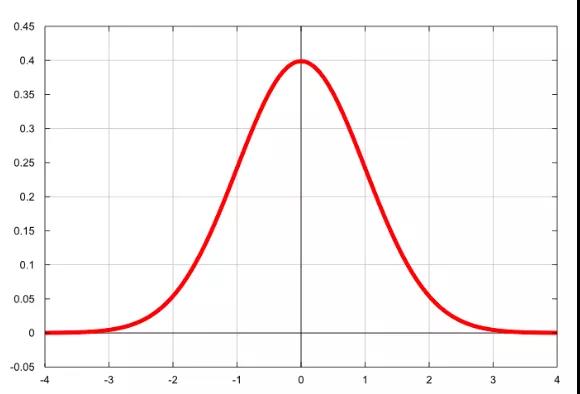

逻辑回归密度函数与分布函数

密度函数

为了使得模型预测的比率不会因为某个因素而影响太大(例如胜利:输的==∞),因此为了使得odds的大小均匀分布或对称,通过Logit 变换函数计算了对数比率(log-odds).

使得 odds从原来的0-正无穷,变成了现在的负无穷大到正无穷大。

Logit函数:为了计算得到log-odds而做的数学运算,logit函数通过取其自然对数将odds设置为负无穷大到正无穷大。

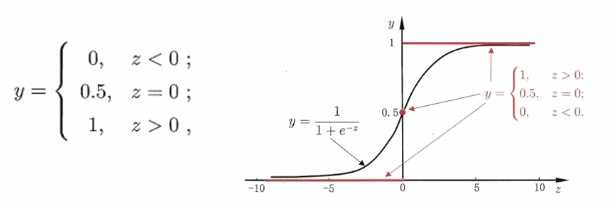

另外一种说法,logit方法代替单位阶跃函数,用sigmoid代替单位阶跃函数

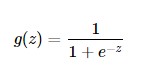

分布函数

但逻辑回归预输出的是概率,那么,就得从比率转成概率。由于log-odds在正无穷到负无穷大,符合sigmoid函数。

sigmoid函数,以其绘制时呈现的s形状而命名,是log-odds的倒数。通过得到log-odds的倒数,我们将我们的值从** (−∞,∞) 映射到了 (0,1)**。

我们现在就可以插入任何x值,并追溯到预测的y值。该y值将是该x值在一个类别或另一个类别中的概率。

优化算法--梯度下降法

概念:梯度下降就是找到RSS的最小值,RSS是点与线之间差异的平方和,代表了点和限的距离有多远(即找出数据点和最佳拟合线之间的最小空间)。

我们把每次为这根线找的不同参数进行可视化,就得到了一个叫做成本曲线的东西。

逻辑回归过程

-

定义预测函数h(x):

-

分类函数

-

损失函数(最大似然估计√,最小二乘法×)

-

优化损失函数中的W

迭代优化: