DStream的相关操作:

DStream上的操作与RDD的类似,分为以下两种:

- Transformations(转换)

- Output Operations(输出)/Action

1.1Transformations

●常见Transformation---无状态转换:每个批次的处理不依赖于之前批次的数据

|

Transformation |

Meaning |

|

map(func) |

对DStream中的各个元素进行func函数操作,然后返回一个新的DStream |

|

flatMap(func) |

与map方法类似,只不过各个输入项可以被输出为零个或多个输出项 |

|

filter(func) |

过滤出所有函数func返回值为true的DStream元素并返回一个新的DStream |

|

union(otherStream) |

将源DStream和输入参数为otherDStream的元素合并,并返回一个新的DStream. |

|

reduceByKey(func, [numTasks]) |

利用func函数对源DStream中的key进行聚合操作,然后返回新的(K,V)对构成的DStream |

|

join(otherStream, [numTasks]) |

输入为(K,V)、(K,W)类型的DStream,返回一个新的(K,(V,W)类型的DStream |

|

transform(func) |

通过RDD-to-RDD函数作用于DStream中的各个RDD,可以是任意的RDD操作,从而返回一个新的RDD |

●特殊的Transformations---有状态转换:当前批次的处理需要使用之前批次的数据或者中间结果。

有状态转换包括基于追踪状态变化的转换(updateStateByKey)和滑动窗口的转换

1.UpdateStateByKey(func)

2.Window Operations开窗函数

1.2. Output/Action

Output Operations可以将DStream的数据输出到外部的数据库或文件系统

当某个Output Operations被调用时,spark streaming程序才会开始真正的计算过程(与RDD的Action类似)

|

Output Operation |

Meaning |

|

print() |

打印到控制台 |

|

saveAsTextFiles(prefix, [suffix]) |

保存流的内容为文本文件,文件名为"prefix-TIME_IN_MS[.suffix]". |

|

saveAsObjectFiles(prefix,[suffix]) |

保存流的内容为SequenceFile,文件名为 "prefix-TIME_IN_MS[.suffix]". |

|

saveAsHadoopFiles(prefix,[suffix]) |

保存流的内容为hadoop文件,文件名为"prefix-TIME_IN_MS[.suffix]". |

|

foreachRDD(func) |

对Dstream里面的每个RDD执行func |

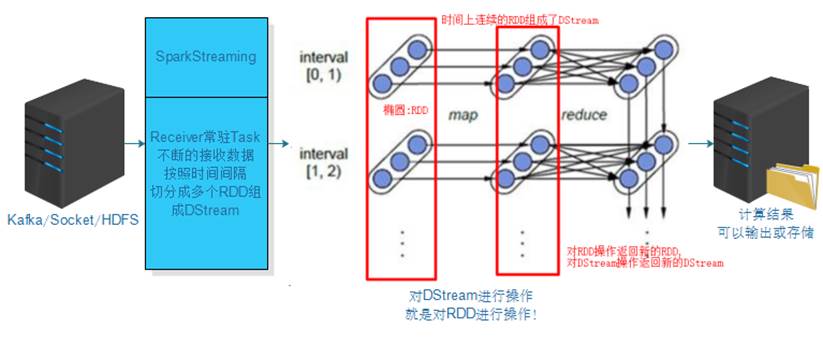

1.3. 总结: