本分享为脑机学习者Rose整理发表于公众号:脑机接口社区(微信号:Brain_Computer).QQ交流群:903290195

延世大学和洛桑联邦理工学院(EPFL)的研究团队最近开发了一种新的技术,可以通过分析图像中的人脸和上下文特征来识别情绪。他们在arXiv上预先发表的一篇论文中介绍并概述了他们基于深度学习的架构,称为CAER-Net。

近年来,世界各地的研究人员一直在尝试开发通过分析图像、视频或音频剪辑来自动检测人类情绪的工具。这些工具可以有许多应用,例如,改善人机交互或帮助医生识别精神或神经疾病的迹象(例如,基于非典型的语音模式、面部特征等)。

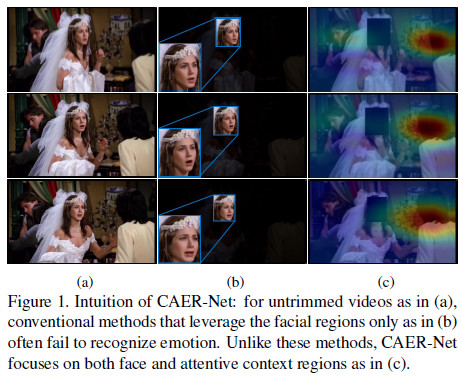

迄今为止,大多数识别图像中情绪的技术都是基于对人们面部表情的分析,其隐藏条件是认为这些表情最能传达人类的情绪反应。因此,大多数用于训练和评估情绪识别工具的数据集(如AFEW和FER2013数据集)只包含剪裁过的人脸图像。

传统的情绪识别工具的主要局限是,当人们的面部表情模糊或难以区分时,它们无法获得令人满意的性能。与这些方法相比,人类不仅能够根据自己的面部表情,而且还可以根据上下文线索(例如,他们正在执行的动作,与他人的互动,所在的位置等)来识别他人的情绪。

过去的研究表明,同时分析面部表情和与上下文相关的特征可以显着提高情绪识别工具的性能。受这些发现启发,延世大学和洛桑联邦理工学院的研究人员着手开发一种基于深度学习的网络架构,该网络架构可以基于人的面部表情和上下文信息识别图像中的人的情绪。

研究人员在论文中写道: “我们提出了一种被称为CAER-Net的深层环境感知情感识别网络,它不仅利用了人类的面部表情,而且还通过联合和增强的方式利用了环境信息。”“关键思想是将人脸隐藏在视觉场景中,并基于注意力机制寻找其他上下文。”

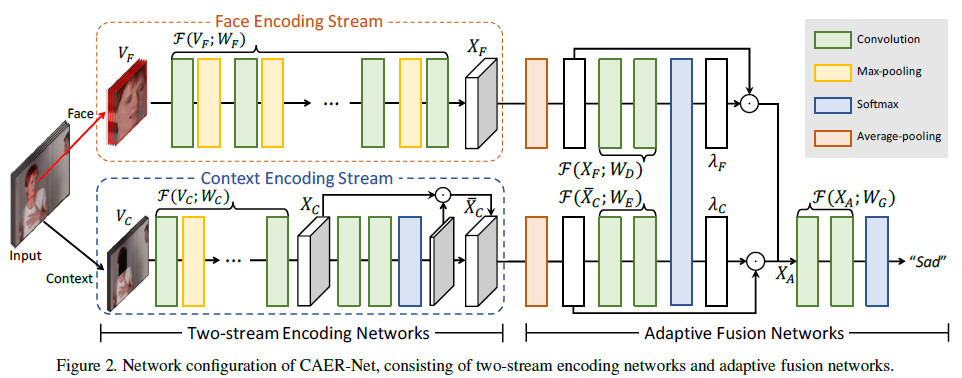

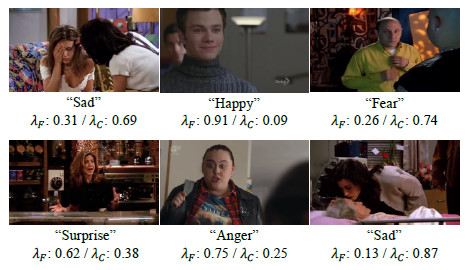

研究人员开发的CAER-Net网络结构由两个关键的子网络和编码器组成,分别提取图像中的面部特征和上下文区域。然后使用自适应融合网络将这两种类型的特征结合起来,并一起分析以预测给定图像中人们的情绪。

除了CAER- net,研究人员还引入了一个新的数据集,用于上下文感知的情感识别,他们称之为CAER。该数据集中的图像同时描绘了人的面部和他们周围的环境/背景,因此它可以作为一个更有效的基准,用于培训评估情绪识别技术。

研究人员在一系列实验中使用使他们收集的数据集和一些数据集来评估他们的情绪识别技术。研究发现表明,正如之前的研究表明的那样,分析面部表情和上下文信息可以显著提高情绪识别工具的性能。

研究人员写道:"我们希望这项研究的结果将促进情境感知的情绪识别及其相关任务的进一步发展。"

参考:

将深度学习技术应用于基于情境感知的情绪识别

A deep learning technique for context-aware emotion recognition

本文章由脑机学习者Rose笔记分享,QQ交流群:903290195

更多分享,请关注公众号