201116西瓜书机器学习系列---14、概率图模型

一、总结

一句话总结:

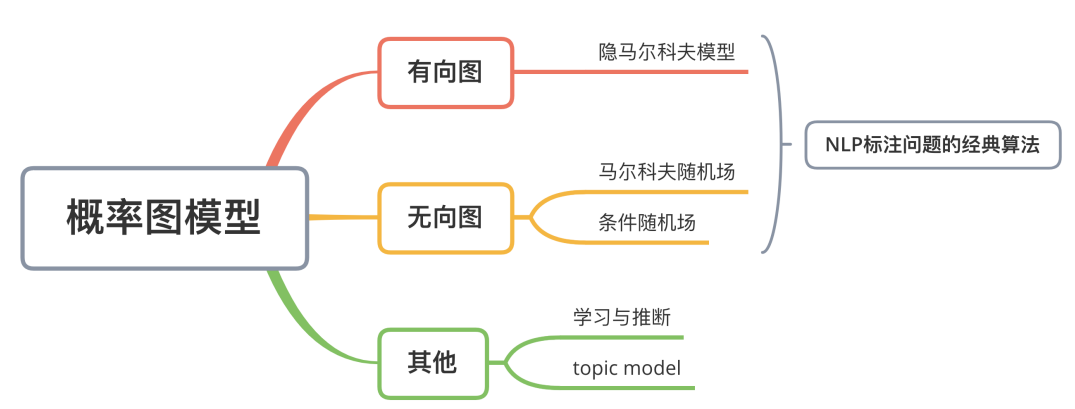

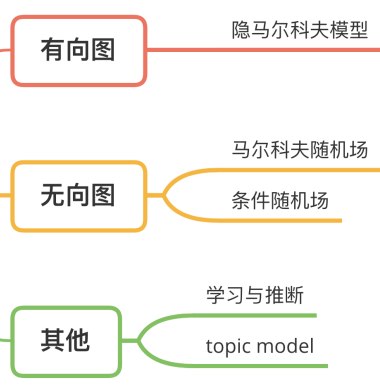

概率图模型:一类用【图】来【表达变量关系】的模型

从【有向图模型】到【无向图模型】,到学习与推断

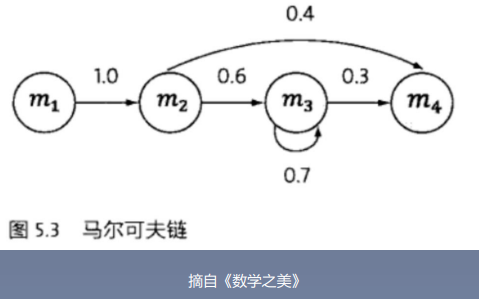

1、马尔科夫假设?

概率图中各个状态的变化,【只与他的临近前一个状态相关】

$$P ( i _ { t } | i _ { 1 } , i _ { 2 } , ldots , i _ { t - 1 } ) = P ( i _ { t } | i _ { t - 1 } )$$:【这个式子就能反映只和前面一个相关】,再之前的就没关系了

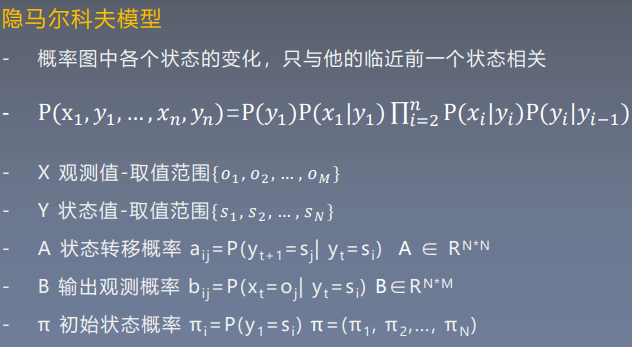

2、隐马尔科夫模型例子 一些名词说明?

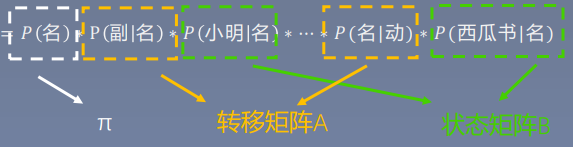

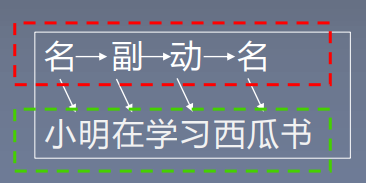

【描述】:X 【观测值】-取值范围 {小明,在,学习,西瓜书,…}

【词性】:Y 【状态值】-取值范围 {名,动,状,副,…}

【pi初始状态概率】:【就是第一个词是名词、副词、动词的概率】:$$pi _ { i } = P ( y _ { 1 } = s _ { i } ) pi = ( pi _ { 1 } , pi _ { 2 t cdots , } pi _ { N } )$$

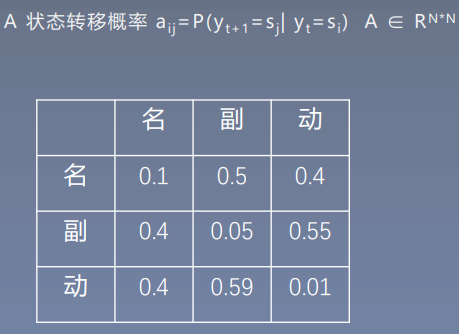

【A状态转移概率】:【就是名词转副词、名词转动词等的概率】:$$a _ { i j } = P ( y _ { t + 1 } = s _ { j } | y _ { t } = s _ { i } ) quad A in R ^ { N ^ { * } N }$$

3、隐马尔科夫模型 原理?

知道【状态转移概率矩阵、观测概率矩阵、初始化概率】,我们就可以求出这些词在一起的概率:P(名,副,动,名,小明,在,学习,西瓜书)= P(名)*P(副|名)*P(小明|名)* … *P(名|动)*P(西瓜书|名)

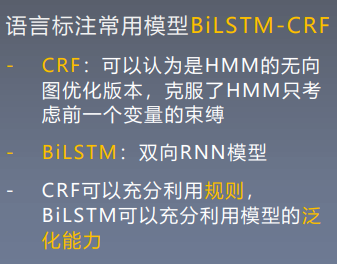

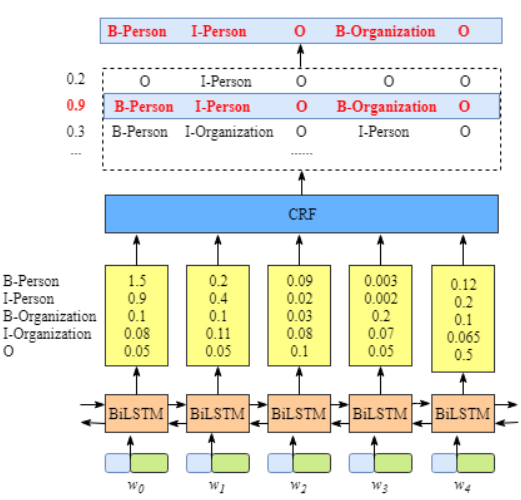

4、语言标注常用模型BiLSTM-CRF?

【CRF】:可以认为是【HMM的无向图优化版本】,【克服了HMM只考虑前一个变量的束缚】;【BiLSTM】:【双向RNN模型】

【CRF】可以充分【利用规则】,【BiLSTM】可以充分利用模型的【泛化能力】

二、内容在总结中

转自或参考: