Spark学习笔记2

配置spark所需环境

1.首先先把本地的maven的压缩包解压到本地文件夹中,安装好本地的maven客户端程序,版本没有什么要求

不需要最新版的maven客户端。

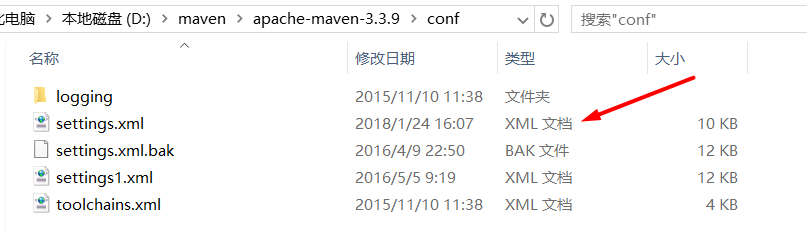

解压完成之后在解压好的maven客户端的文件夹内打开conf文件夹,修改里面的settings.xml文件

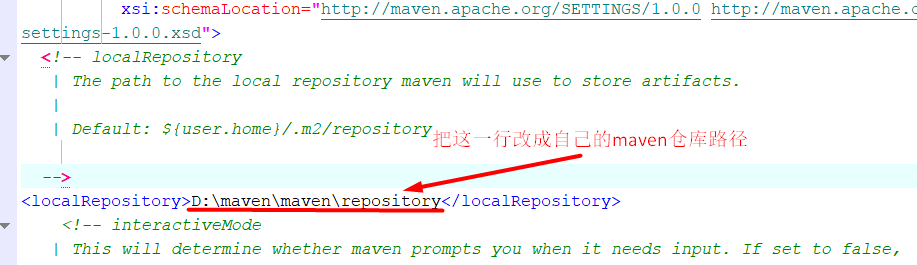

然后只需要修改这一行就可以了 ,把这一行替换成你自己本地的maven仓库的路径

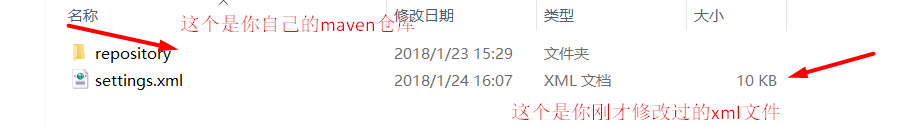

最好是自己有一个完整点的maven仓库,然后把这个修改过的xml文件放到maven仓库下

到这里,你本地的maven客户端环境已经搭建好了,现在可以到IDEA里建一个maven项目了!

在IDEA上建立一个maven项目

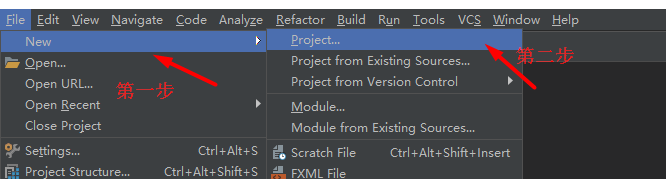

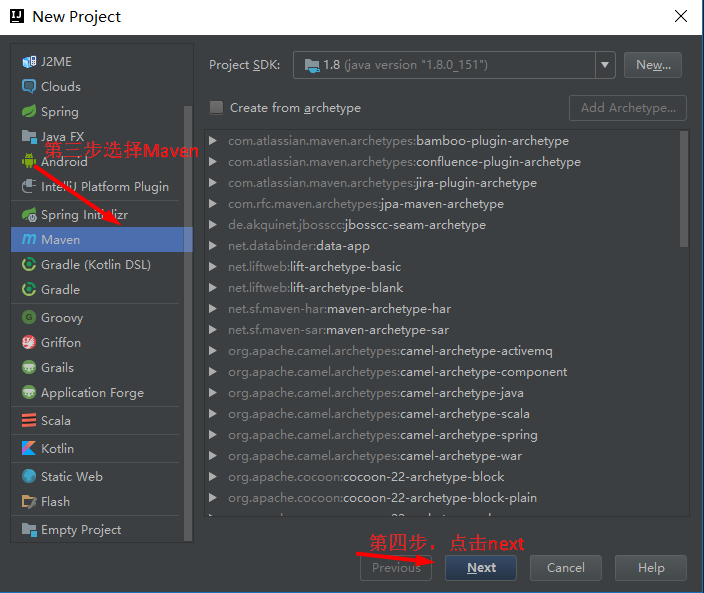

1.创建一个maven项目

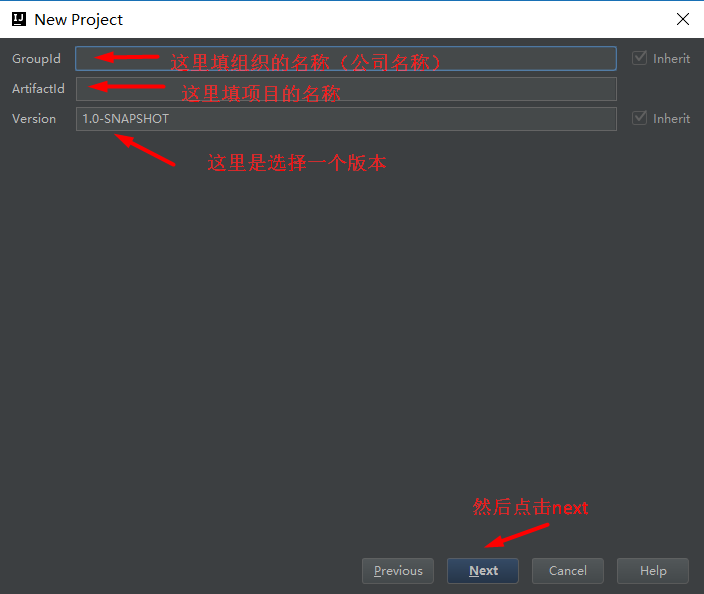

new Project --》 Maven --》 next --》 groupId:组织名称(类似eclipse的工作空间),Artifactid:项目名称 Version:版本名称

--》 next到 项目名称,项目的工作路径等 --》 finish

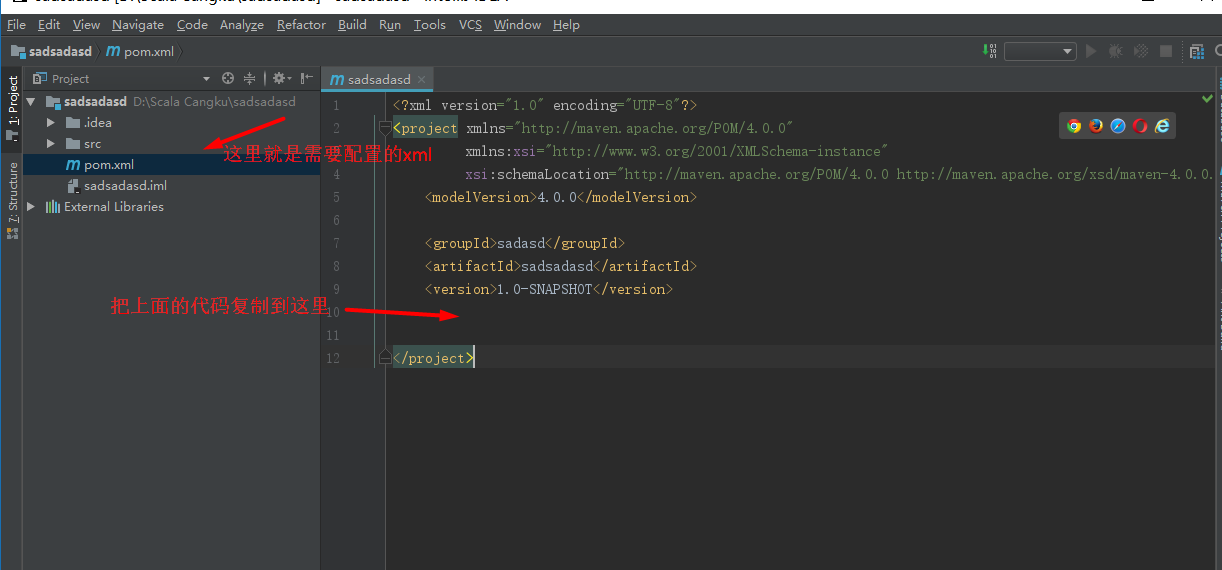

下面开始配置你的xml文件,因为maven项目需要很多的依赖,配置好xml文件

就可以导入大部分的依赖包了,直接把下面的代码复制进来放入你的xml文件里就ok

1 <?xml version="1.0" encoding="UTF-8"?> 2 <project xmlns="http://maven.apache.org/POM/4.0.0" 3 xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" 4 xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd"> 5 <modelVersion>4.0.0</modelVersion> 6 7 <groupId>cn.beicai1704</groupId> 8 <artifactId>sparkLearn1704</artifactId> 9 <version>1.0-SNAPSHOT</version> 10 11 <properties> 12 <maven.compiler.source>1.7</maven.compiler.source> 13 <maven.compiler.target>1.7</maven.compiler.target> 14 <encoding>UTF-8</encoding> 15 <scala.version>2.10.6</scala.version> 16 <spark.version>1.6.1</spark.version> 17 <hadoop.version>2.6.4</hadoop.version> 18 </properties> 19 20 <dependencies> 21 <dependency> 22 <groupId>org.scala-lang</groupId> 23 <artifactId>scala-library</artifactId> 24 <version>${scala.version}</version> 25 </dependency> 26 27 <dependency> 28 <groupId>org.apache.spark</groupId> 29 <artifactId>spark-core_2.10</artifactId> 30 <version>${spark.version}</version> 31 </dependency> 32 33 <dependency> 34 <groupId>org.apache.hadoop</groupId> 35 <artifactId>hadoop-client</artifactId> 36 <version>${hadoop.version}</version> 37 </dependency> 38 <dependency> 39 <groupId>org.apache.spark</groupId> 40 <artifactId>spark-streaming_2.10</artifactId> 41 <version>${spark.version}</version> 42 </dependency> 43 <dependency> 44 <groupId>org.apache.spark</groupId> 45 <artifactId>spark-sql_2.10</artifactId> 46 <version>${spark.version}</version> 47 </dependency> 48 49 <dependency> 50 <groupId>org.apache.spark</groupId> 51 <artifactId>spark-hive_2.10</artifactId> 52 <version>${spark.version}</version> 53 </dependency> 54 55 <dependency> 56 <groupId>org.apache.spark</groupId> 57 <artifactId>spark-streaming-kafka_2.10</artifactId> 58 <version>1.6.1</version> 59 </dependency> 60 61 <dependency> 62 <groupId>org.apache.spark</groupId> 63 <artifactId>spark-streaming-flume_2.10</artifactId> 64 <version>${spark.version}</version> 65 </dependency> 66 67 <dependency> 68 <groupId>com.alibaba</groupId> 69 <artifactId>fastjson</artifactId> 70 <version>1.1.41</version> 71 </dependency> 72 73 </dependencies> 74 75 <build> 76 <sourceDirectory>src/main/scala</sourceDirectory> 77 <testSourceDirectory>src/test/scala</testSourceDirectory> 78 <plugins> 79 <plugin> 80 <groupId>net.alchim31.maven</groupId> 81 <artifactId>scala-maven-plugin</artifactId> 82 <version>3.2.2</version> 83 <executions> 84 <execution> 85 <goals> 86 <goal>compile</goal> 87 <goal>testCompile</goal> 88 </goals> 89 <configuration> 90 <args> 91 <arg>-make:transitive</arg> 92 <arg>-dependencyfile</arg> 93 <arg>${project.build.directory}/.scala_dependencies</arg> 94 </args> 95 </configuration> 96 </execution> 97 </executions> 98 </plugin> 99 100 <plugin> 101 <groupId>org.apache.maven.plugins</groupId> 102 <artifactId>maven-shade-plugin</artifactId> 103 <version>2.4.3</version> 104 <executions> 105 <execution> 106 <phase>package</phase> 107 <goals> 108 <goal>shade</goal> 109 </goals> 110 <configuration> 111 <filters> 112 <filter> 113 <artifact>*:*</artifact> 114 <excludes> 115 <exclude>META-INF/*.SF</exclude> 116 <exclude>META-INF/*.DSA</exclude> 117 <exclude>META-INF/*.RSA</exclude> 118 </excludes> 119 </filter> 120 </filters> 121 <transformers> 122 <transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer"> 123 <mainClass>WordCount</mainClass> 124 </transformer> 125 </transformers> 126 </configuration> 127 </execution> 128 </executions> 129 </plugin> 130 </plugins> 131 </build>

然后根据提示点击加载依赖到项目里,因为我已经配置过了,所以没有任何显示

到这里基本就配置完成了,现在可以写一个spark文件来测试一下了!

转载本文请和本文作者联系,本文来自博客园一袭白衣一