Hadoop综合大作业

作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363

Hadoop综合大作业 要求:

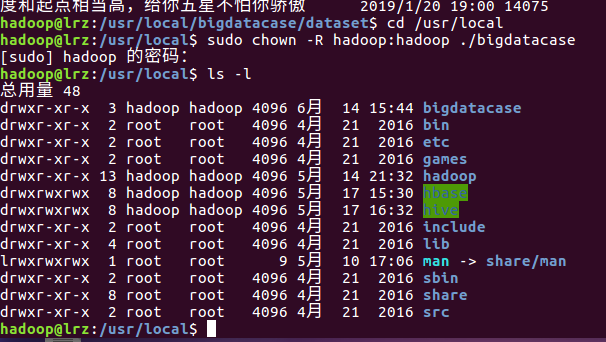

1.将爬虫大作业产生的csv文件上传到HDFS

3.把hdfs中的文本文件最终导入到数据仓库Hive中

4.删除文件第一行记录,即字段名称

5.用Hive对爬虫大作业产生的进行数据分析,写一篇博客描述你的分析过程和分析结果。(10条以上的查询分析)

(1)查询前二十条信息的评论时间

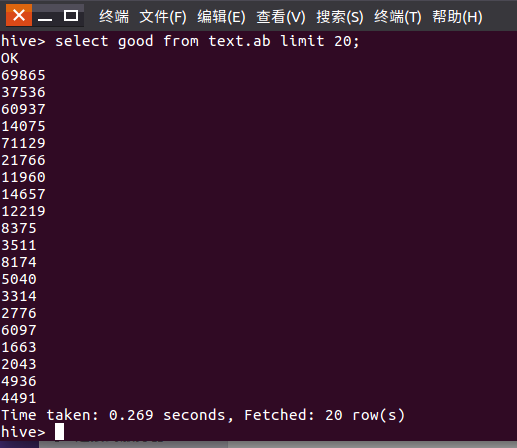

(2)查询前二十条评论点赞数

(3)查询前二十条评论的用户

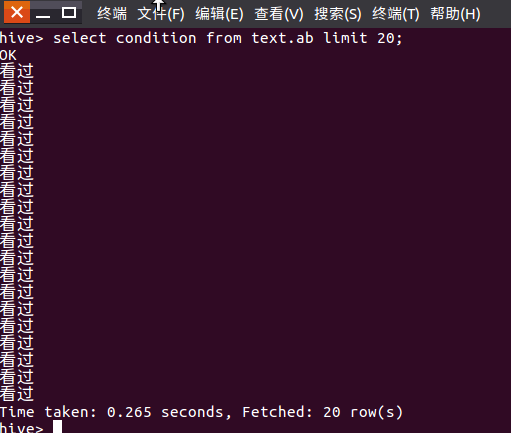

(4)查询前20个用户的观看情况

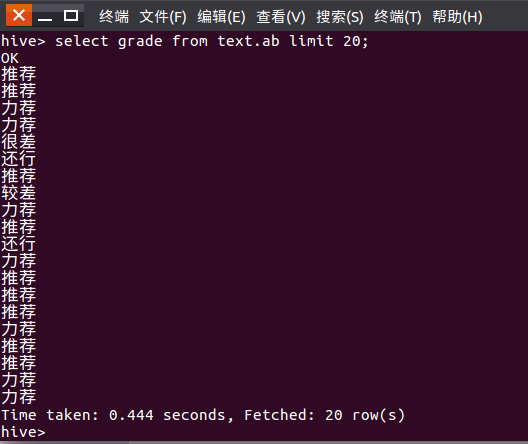

(5)查询前20个用户的评分情况

(6)查询前3条评论

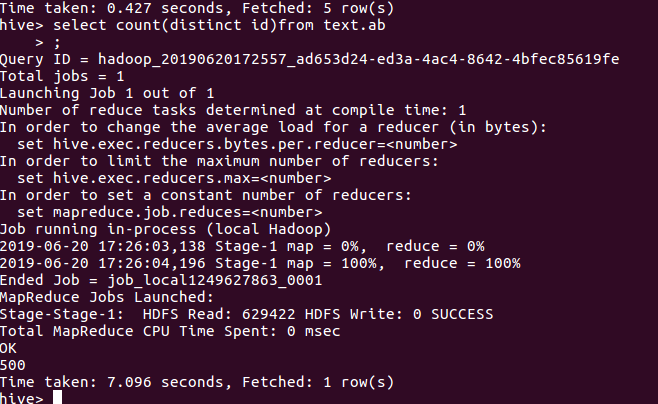

(7)查询不重复id的评论数

(8)查询不重复昵称的评论数

总结分析:第一次在hadoop上分析数据,估计很容易发生一些不知名的错误,通过对在豆瓣对电影《流浪地球》的相关数据分析可以发现:网友对《流浪地球》评分相当高,有65%的推荐率和25%的力荐率。从词云可以看出来《流浪地球》的评论中科幻电影,中国,科幻,国产出现频率很高,可以看出网友把这种高质量的科幻片和中国,国产联系起来。因此网友应该对于国产科幻片开始有一定的信心。最后从数据分析来看《流浪地球》是值得一看的国产科幻片。