转载自阿里云:

https://yq.aliyun.com/articles/126898?spm=a2c4e.11153940.blogcont149583.12.4ab360c0aTD6mg

文章中实验代码见:

注明:这三个比赛就是本博客列表中的“

| 九、产生和防御对抗样本的新方法 | 分享总结--廖方舟(2018-10-31 11:02) |

”

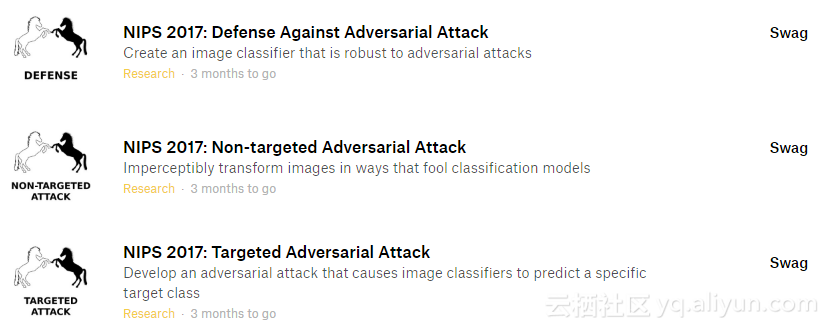

下面具体来说下这三个相关比赛的侧重点:

- 1、Non Targeted Adversarial Attack,竞赛者所提交的系统需要对任何类别的图像进行处理,使得某个通用机器学习分类器无法识别。

- 2、Targeted Adversarial Attack,竞赛者所提交的系统需要对给定的图像进行处理,使得某个通用机器学习分类器无法识别。

- 3、Defense Against Adversarial Attack,竞赛者需要构建一个机器学习分类器,拥有足够的鲁棒性使之能正确鉴别对抗性的图像。

根据前两个挑战的对抗性攻击,防御挑战的得分取决于分类器的好坏,另外前两个挑战的得分是基于在第三个挑战中对抗性攻击的伎俩有多好。

下面,我们将通过一些代码示例来生成非目标和目标的对抗图像,然后看看Inception V3模型是如何对它们进行分类。关于googleNet Inception V3介绍大家可以上网找找相关教程或博客,这里就不一一讲述。