一、测试目的:

1、测试分布卷(Distributed)、分布式复制卷(Distributed-Replicate)、条带卷(Strip)和分布式条带复制卷(Distributed-Strip-Replicate)的读写性能。

2、测试网络对文件系统读写性能的影响。

一、测试准备:

1、三台千兆网测试机:dn151,dn152,dn154。每台测试机上有七块1T硬盘,dn151等是测试机的hostname。hostname配置方式,以及glusterfs的安装见https://www.cnblogs.com/ForestCherry/p/10876049.html。

2、创建目录:mkdir -p /data01 /data02 /data03 /data04 /data05 /data06 /data07 /Distributed-test /Distributed-Replicate-test /Strip-test /Distributed-Strip-Replicate-test(前面的是磁盘挂载目录,后面是卷节点挂载目录)

3、挂载磁盘:mount /dev/sdb /data01;mount /dev/sdc /data02;mount /dev/sdb /data03;mount /dev/sde /data04;mount /dev/sdf /data05;mount /dev/sdg /data06;mount /dev/sdh /data07;

4、测试命令:time dd if=/dev/zero bs=1M count=4096 of=4G.file(也可以借助fio工具测试)

三、开始测试:

1、创建gluster集群:gluster peer probe dn152;gluster peer probe dn154(这里是在dn151上创建的,也可以在其他两台上创建)

2、创建卷:(任意一台上执行)

1)gluster volume create Distributed-Strip-Replicate-test strip 2 replica 2 dn151:/data01 dn152:/data01 dn151:/data02 dn152:/data02 dn151:/data03 dn152:/data03 dn151:/data04 dn152:/data04 force 创建分布式条带复制卷

2)gluster volume create Distributed-test dn151:/data05 dn152:/data05 force 创建分布卷

3)gluster volume create Strip-test strip 2 dn151:/data06 dn152:/data06 force 创建条带卷

4)gluster volume create Distributed-Replicate-test replica 2 151:/data07 dn152:/data07 force 创建分布式复制卷

3、启动卷:gluster volume start Distributed-Strip-Replicate-test;gluster volume start Distributed-test; gluster volume start Strip-test;gluster volume start Distributed-Replicate-test(任意一台上执行)

4、挂载卷:mount -t glusterfs dn151:/Distributed-Replicate-test Distributed-Replicate-test;mount -t glusterfs dn151:/Distributed-Strip-Replicate-test Distributed-Strip-Replicate-test; mount -t glusterfs dn151:/Distributed-test Distributed-test;mount -t glusterfs dn151:/Strip-test Strip-test(每台上都要执行)

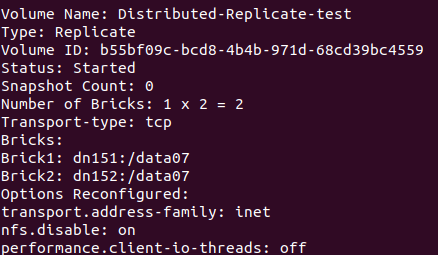

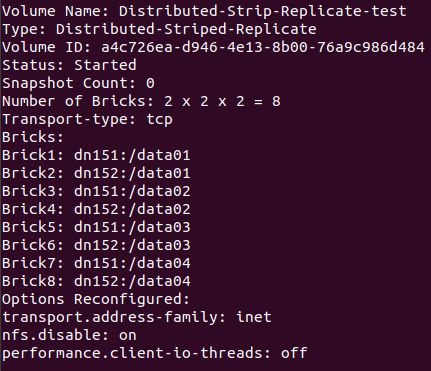

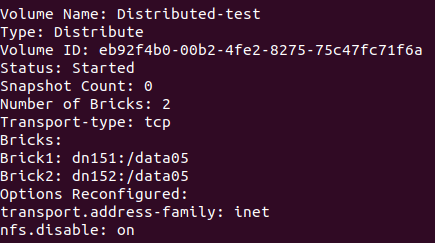

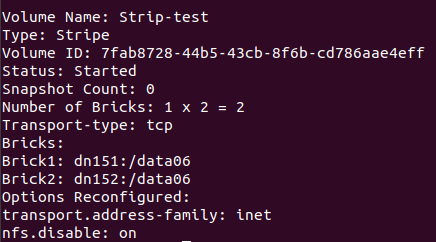

5、查看卷信息:gluster volume info

图一:

6、测试及现象:

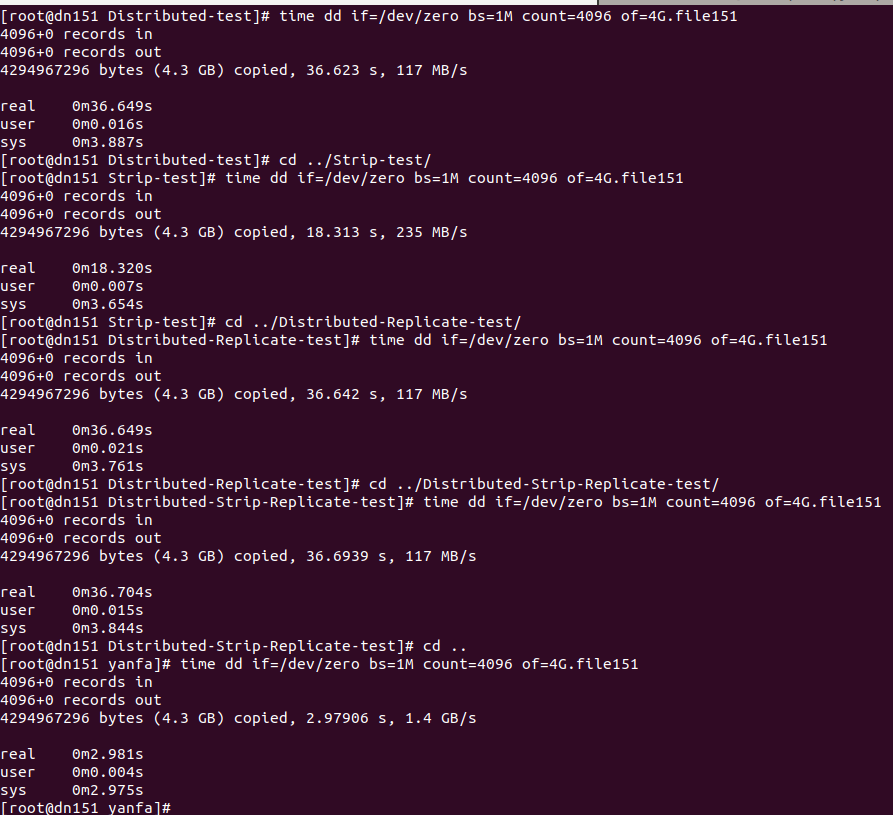

dn151上:

图二:

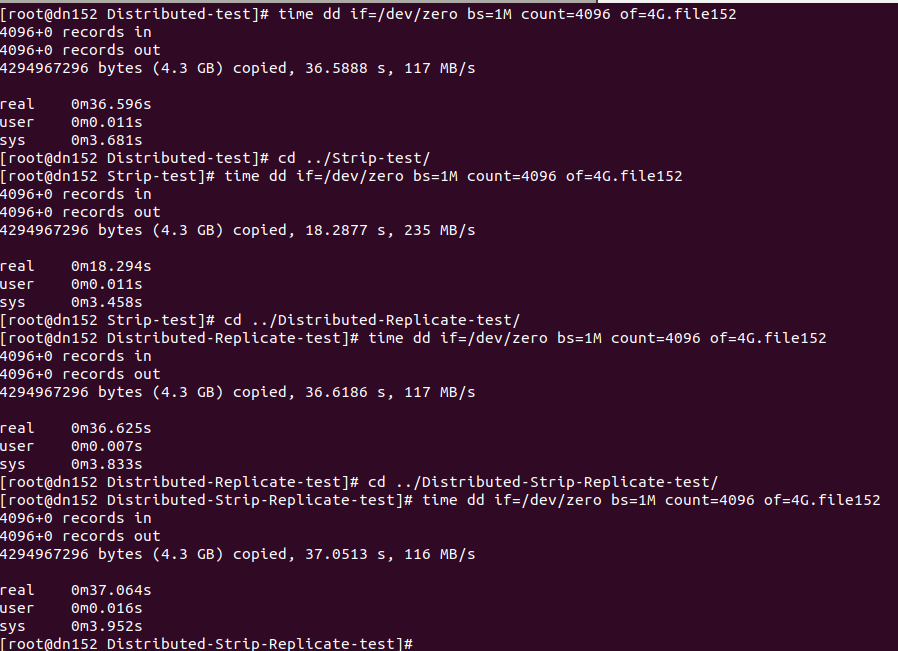

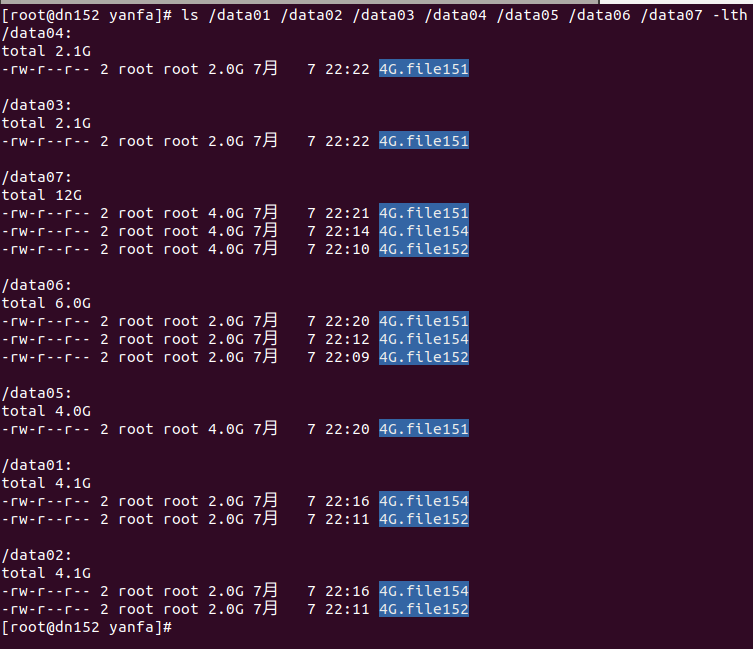

dn152上:

图三:

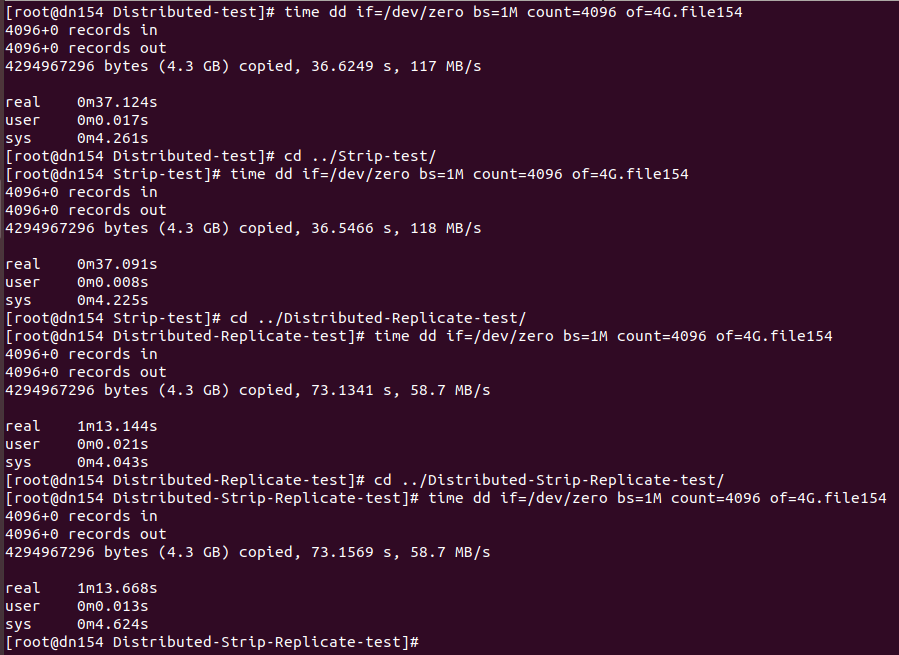

dn154上:

图四:

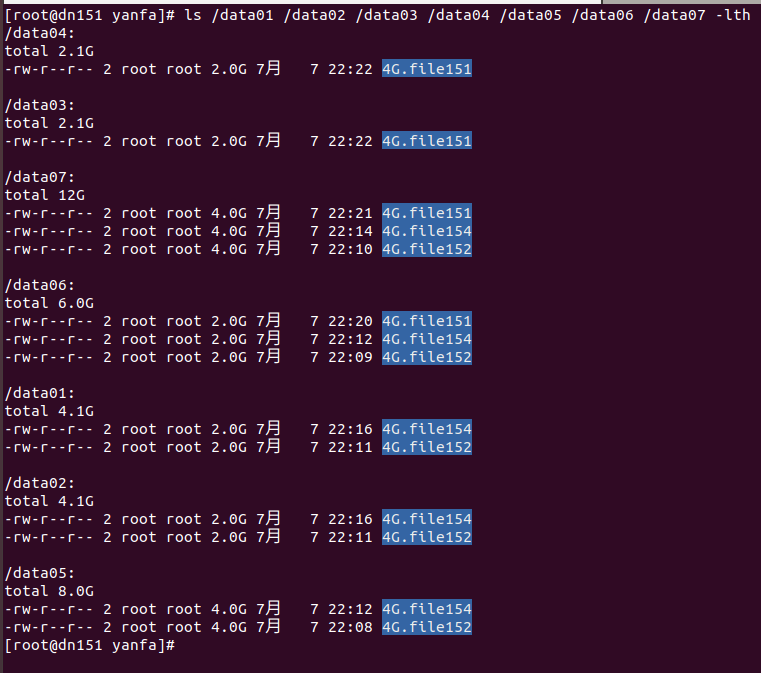

dn151上:

图五:

dn152上:

图六:

说明:上诉dd命令是在一台上执行完后再去另一台上执行(相当于只测试了读或写),如果几台同时执行dd(相当于并发读写测试),那么性能会有所下降。

四、测试结果分析:(来自小白的简单分析,可能不准确,求大神指教)

1、glusterfs下读写请求的处理流程分析:请参照https://www.cnblogs.com/chaozhu/p/6402000.html

2、从图二或图三或图四可以看出:本地 > 条带卷 > 分布卷 ≈ 复制卷 ≈ 分布式条带复制卷

分析:

1)条带卷大于分布卷:结合图五图六可以看出,在dn151上执行dd命令,分布卷目录下根据哈希算法,随机将文件4G.flie151存储在dn152:/data05上;而条带卷是将4G.flie151分别存在dn151和dn152上的/data06上。所以就跨网来说,分布卷时4G全部使用socket存储,而条带卷只有2G文件通过socket存储,所以此时表现条带卷速度大于分布卷(如果分布卷存储通过哈希算法,在dn151上也将文件存储在dn151上,那么肯定是分布卷速度远大于条带卷速度,读者可自行测试)。

2)值得一提,创建条带卷时,当Number of Bricks: 为n*2(n >= 2)时,如果创建语句为:gluster volume create Strip-test strip 2 dn151:/data06 dn151:/data07 dn152:/data06 dn152:/data07 force(未跨网络分段),

如果创建语句为:gluster volume create Strip-test strip 2 dn151:/data06 dn152:/data06 dn151/data07 dn152:/data07 force(跨网络分段,不好的习惯,性能下降),两者的速度是不一样的,前者速度明显大于后者。

3)分布式复制卷 ≈ 分布式条带复制卷:测试文件不够大或者网络条件制约(千兆网的传输速率门槛大概在128MB/s),没体现出条带卷的优势。

2、图二和图三和图四对比可得:图四 < 图三 = 图二

分析:拿复制卷来说。

1)无论是在dn151上执行还是在dn152上执行,文件都是先在本地创建了4G.flie151或4G.flie152,然后再通过socke备份到另一台上,而当本地执行完请求后就会返回;而在dn154上执行,是要通过socket将文件存储到dn151和dn152上,所以返回响应会更久。

2)从结果117MB/s的测试结果可以看出,网络是制约影响文件系统读写性能的主要因素。

3、求指教:

1、以上分析是在当前条件下测试,结果和分析可能不太准确,如有不当,还请指教。

2、网上说fuse层对性能的影响很小,那么为什么在本地执行dd命令和通过flusterfs的挂载目录执行dd命令速度会慢那么多(咱们可以在dn151上执行 gluster volume create test-volume dn151:/test1 /dn151:/test2 force试一下)

3、求大神对上面的测试结果进行专业的分析。