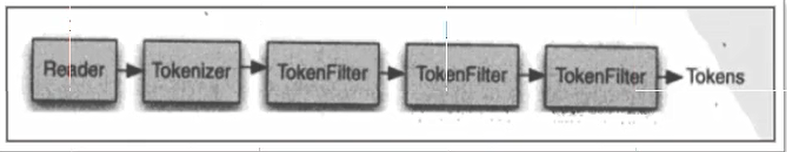

下图是语汇单元的生成过程:

从一个Reader字符流开始,创建基于Reader的Tokenizer分词器,经过三个TokenFilter生成语汇单元Tokens。

要看分词器的分析效果,只需要看Tokenstream中的内容就可以了。每个分词器都有一个方法tokenStream,返回一个tokenStream对象。

分词器的种类有很多,目前使用最广的分词器IK-analyzer,注意:Ik-analyzer的版本要与lucene版本相匹配才能使用,否则会报错。

Analyzer使用时机

索引是使用

搜索时使用

注意:搜索使用的分词器要和索引使用的分词器一致。