1.将HDFS中的文本文件读取并以JSON格式转存到MongoDB时,报磁盘不足的异常。

实验室的5台计算机的存储空间都在500G以上,就目前存储的数据量来看,完全达不到磁盘接近饱和的状态。通过查看HDFS的web客户端,显示如下:

看了一下remaining,发现差别很大,首先想到的balance;其次看出dm5的总存储空间只有0.03TB,完全不正常,再看一下Linux的磁盘使用情况,让我大跌眼镜:

根目录的挂载只有9.4G,而HDFS存储数据的文件夹就放在本地磁盘的根目录下,如下图:

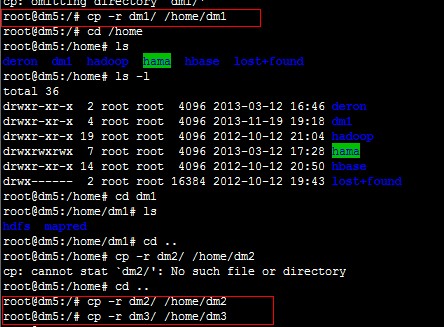

看到以上内容,应该修改本地存储目录才能解决问题。于是就有了下面的操作,将本地存储文件夹放在大一点的“房子”里:

当然,一定要把hadoop/conf/hdfs-site.xml文件下的配置项修改一下。最后重启一下hadoop,再看一下web客户端,搞定,收工!