https://www.bilibili.com/video/BV1kE411G7qo?p=5

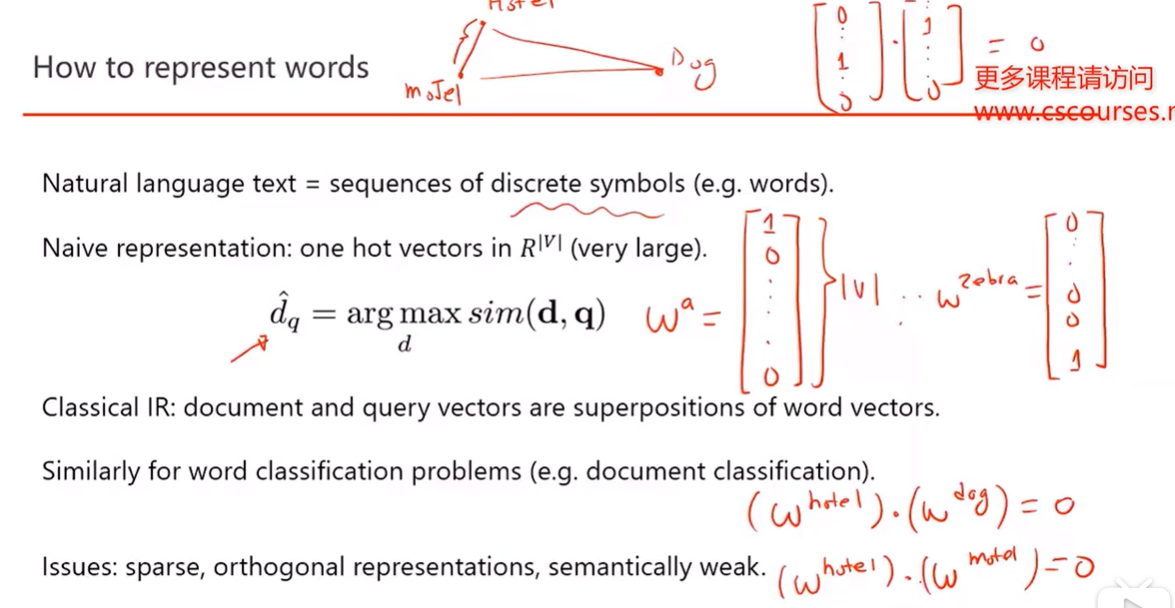

1. Word Representation:

one-hot vector :

1)稀疏

2) 每一个词向量之间都是垂直,没法算相似度

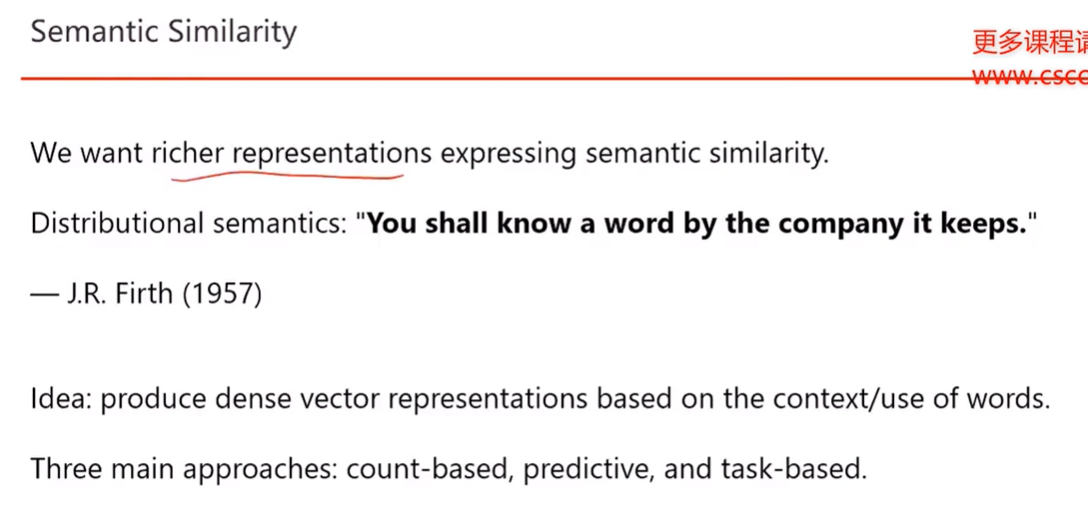

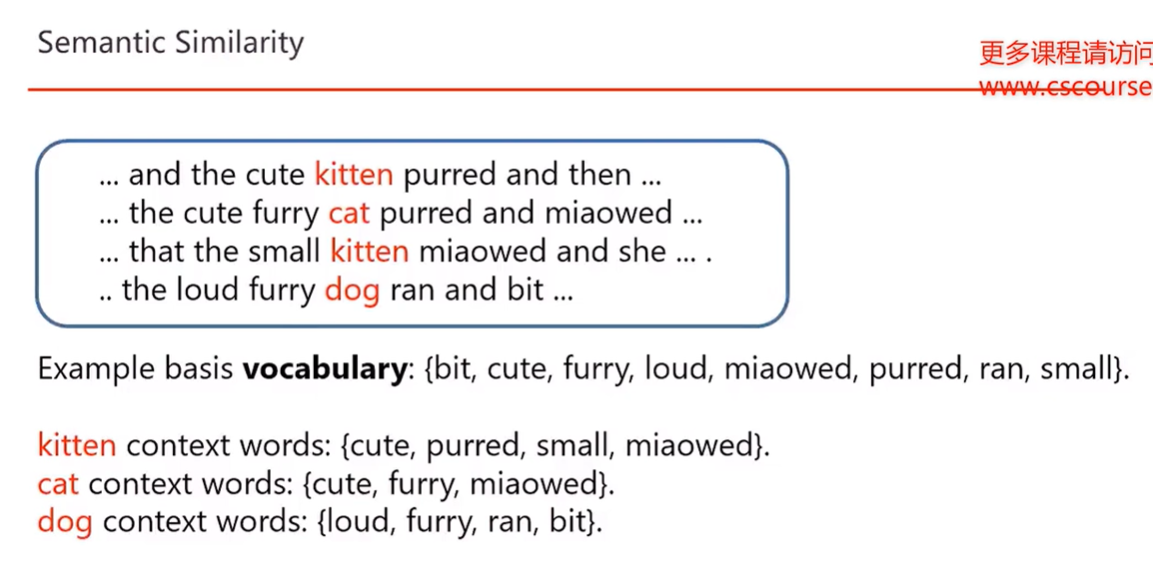

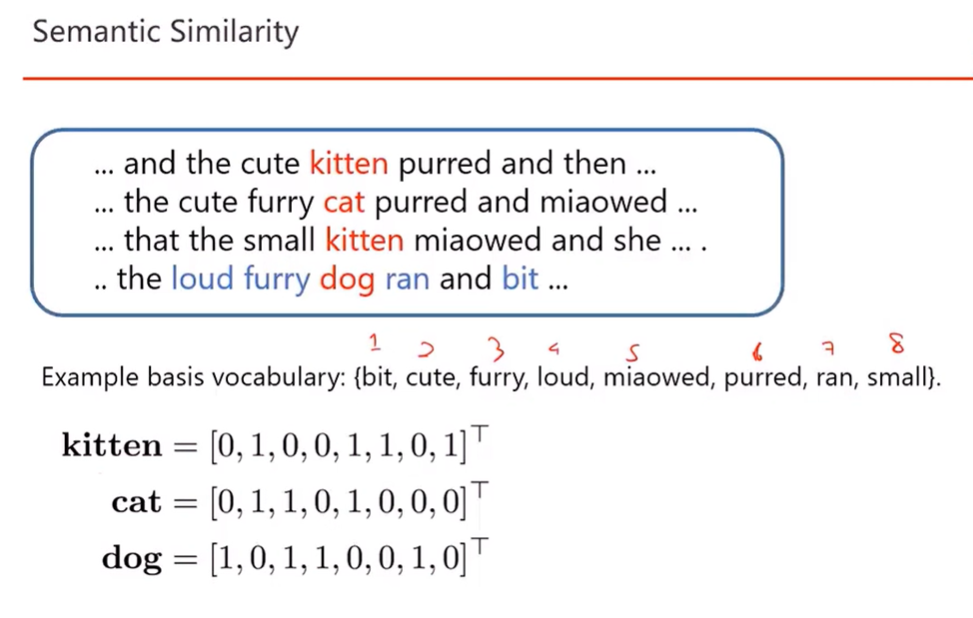

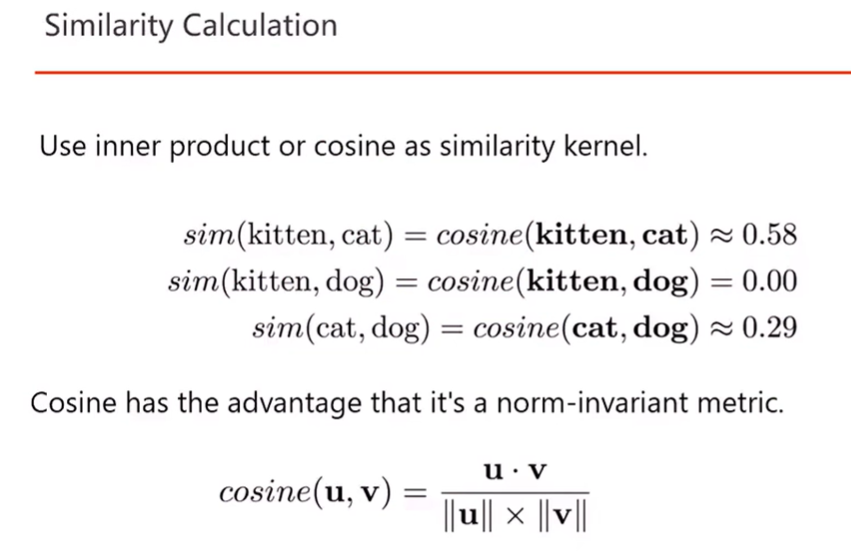

2. Semantic Similarity

语义 similarity, 用上下文来表示一个词

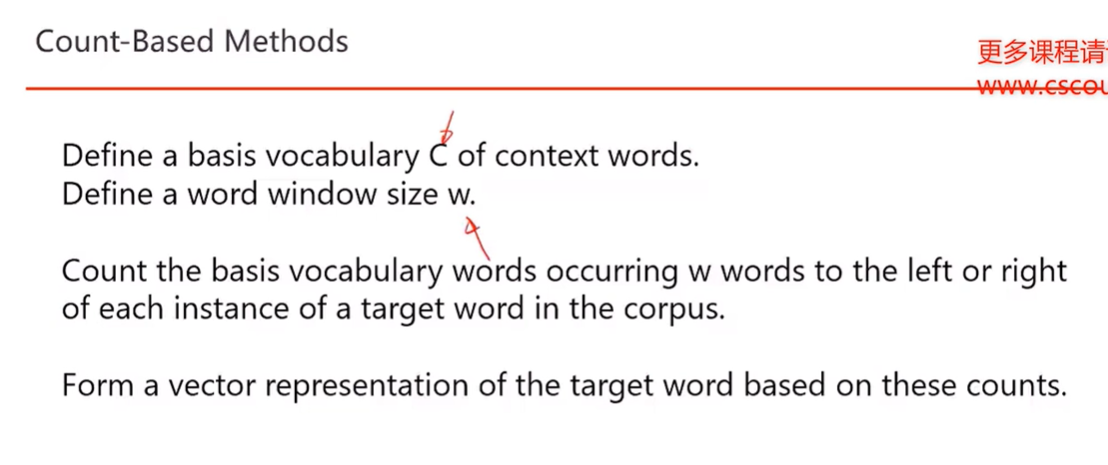

1) Count-Based Methods

滑动窗口

语料库 corpus

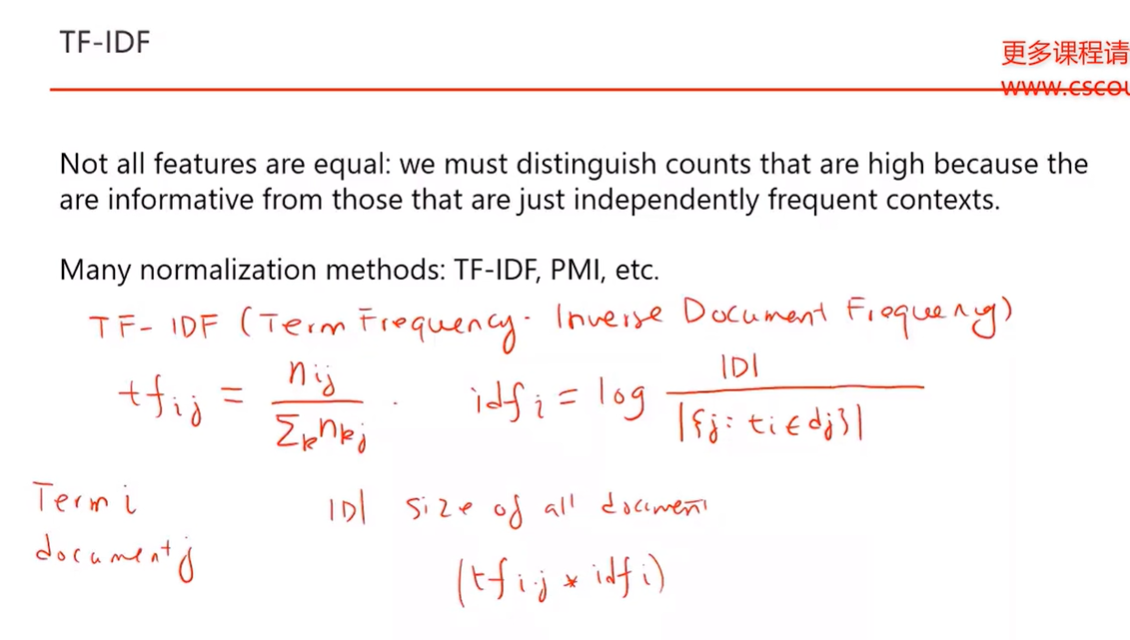

2) TF - IDF

TF = 词 i 在文本 j 中出现次数 / 文本 j 中总词数

IDF = log (所有文档数量/包含词 i 的文档数量)

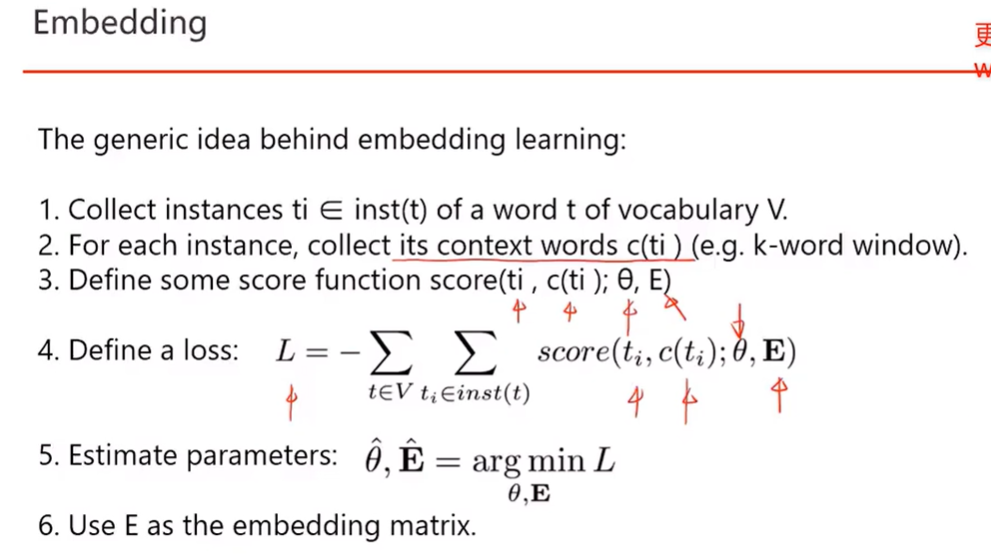

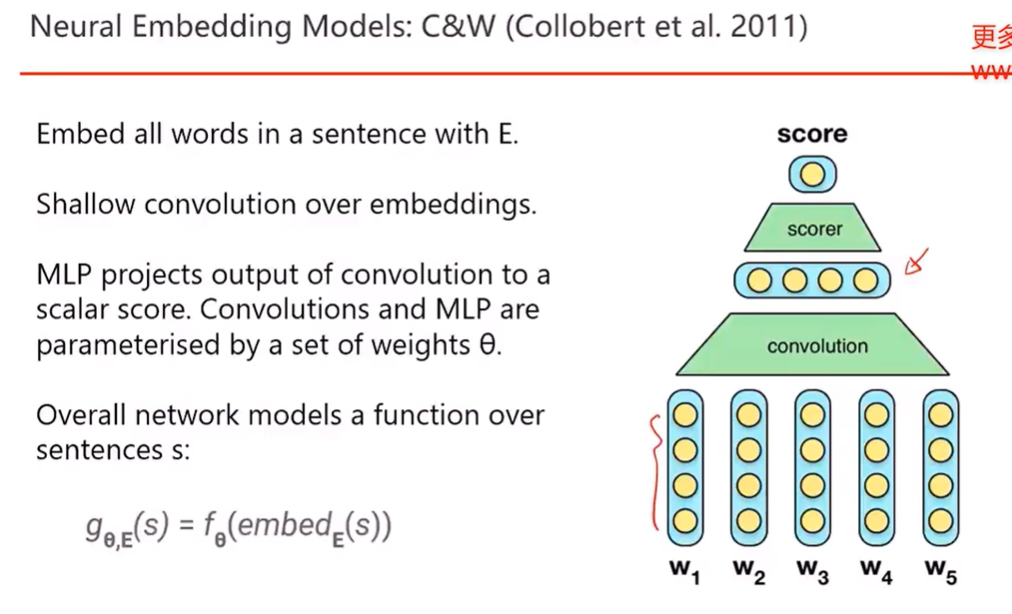

3)embedding

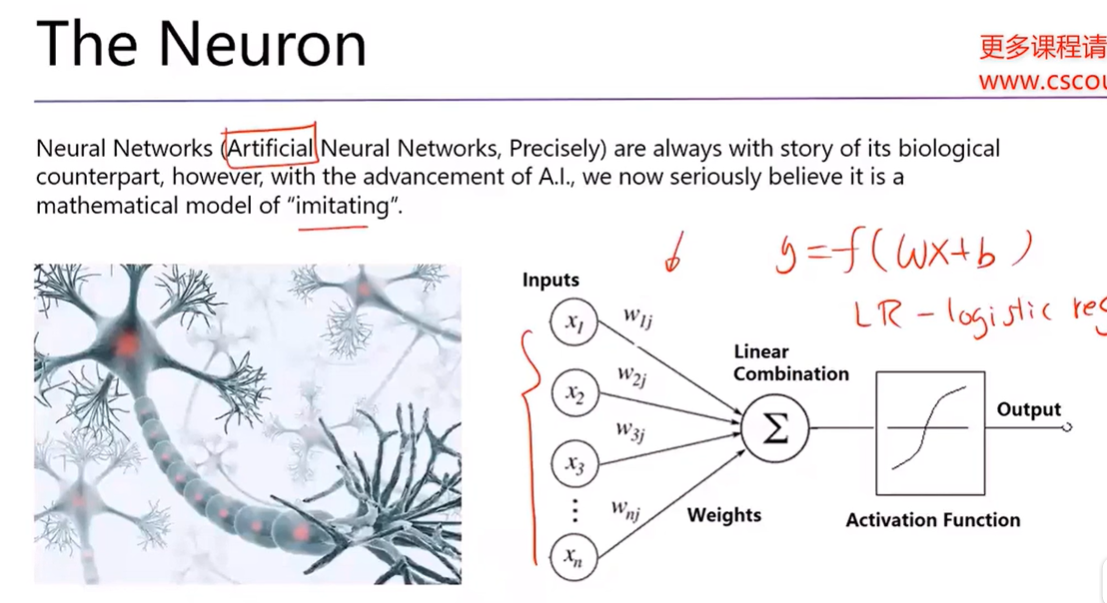

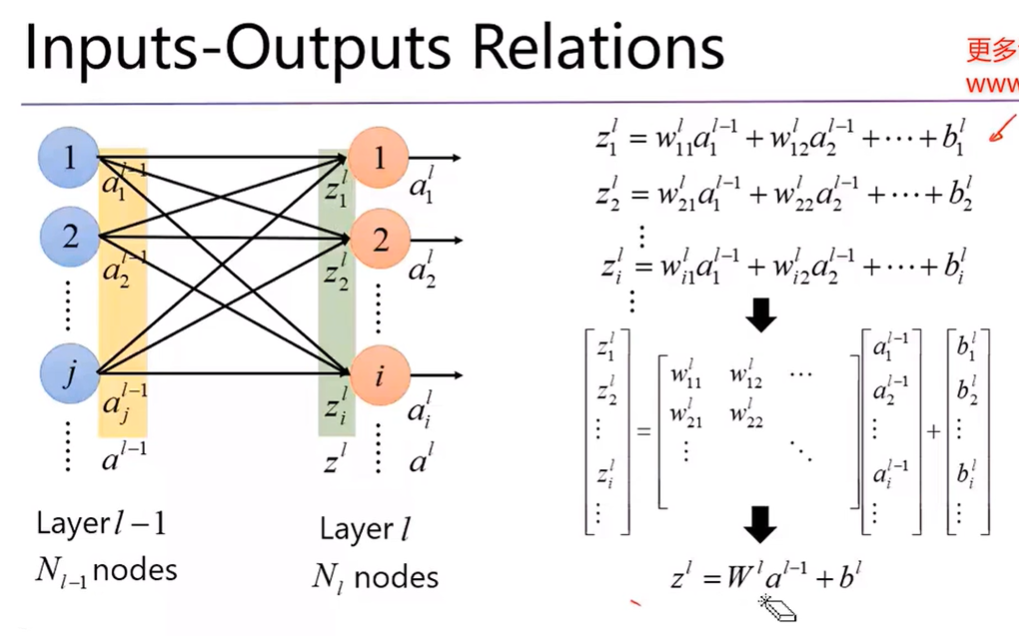

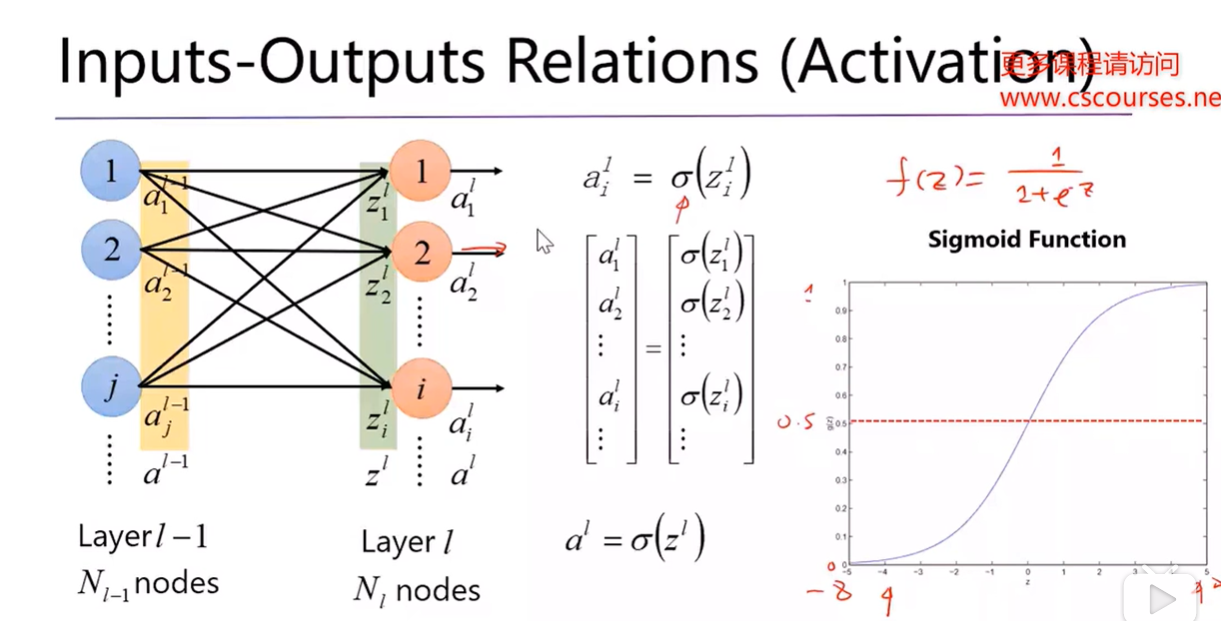

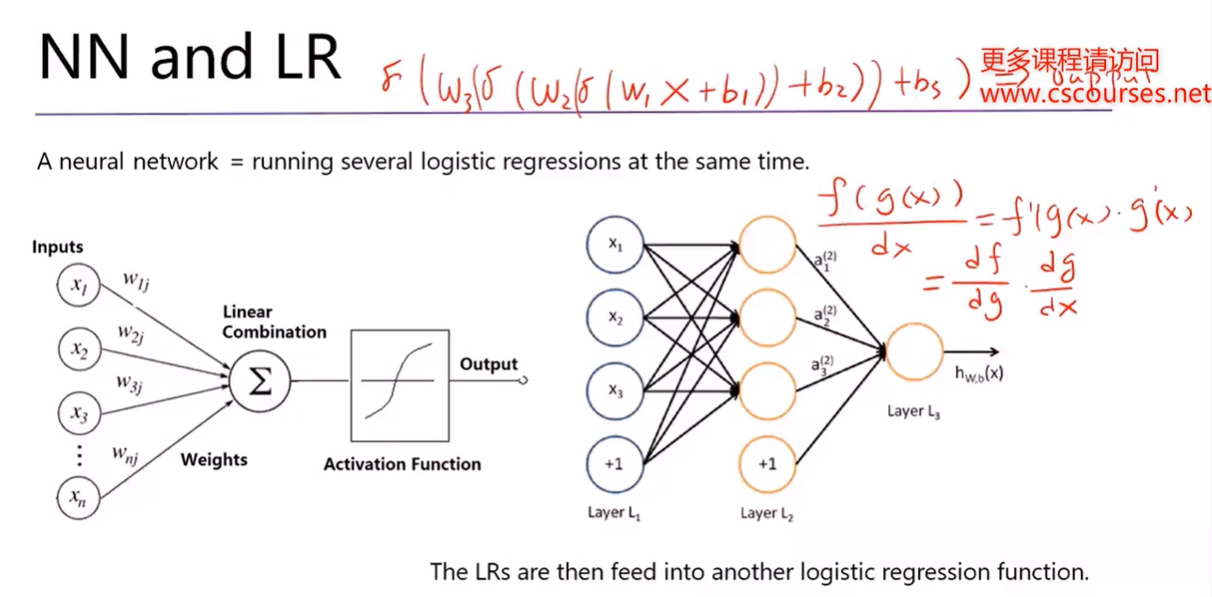

3. Neuron Network

1) LR 一个神经元

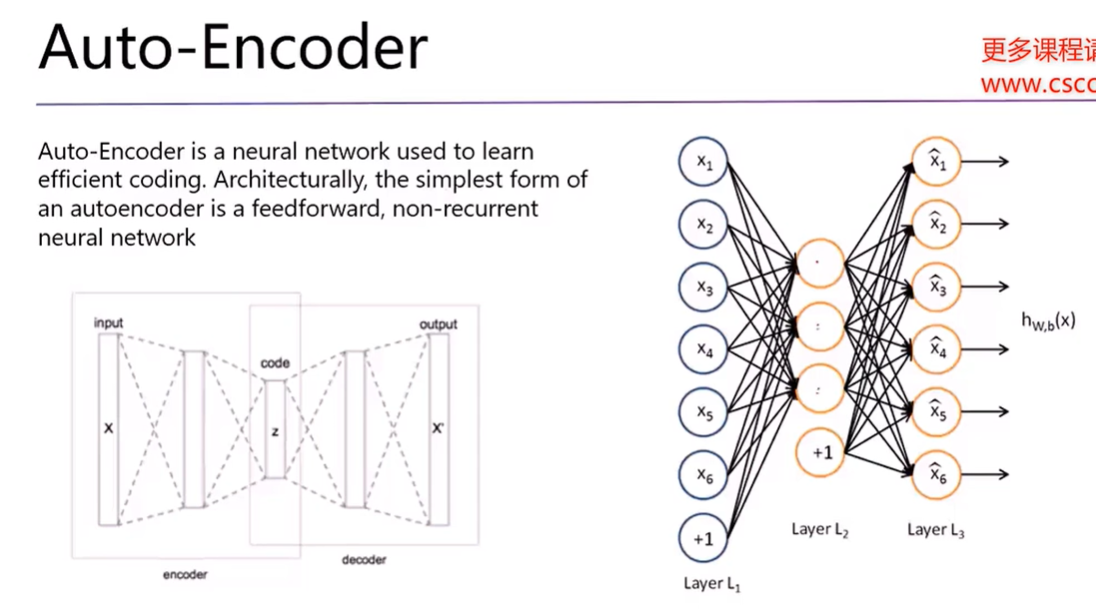

压缩,加密解密

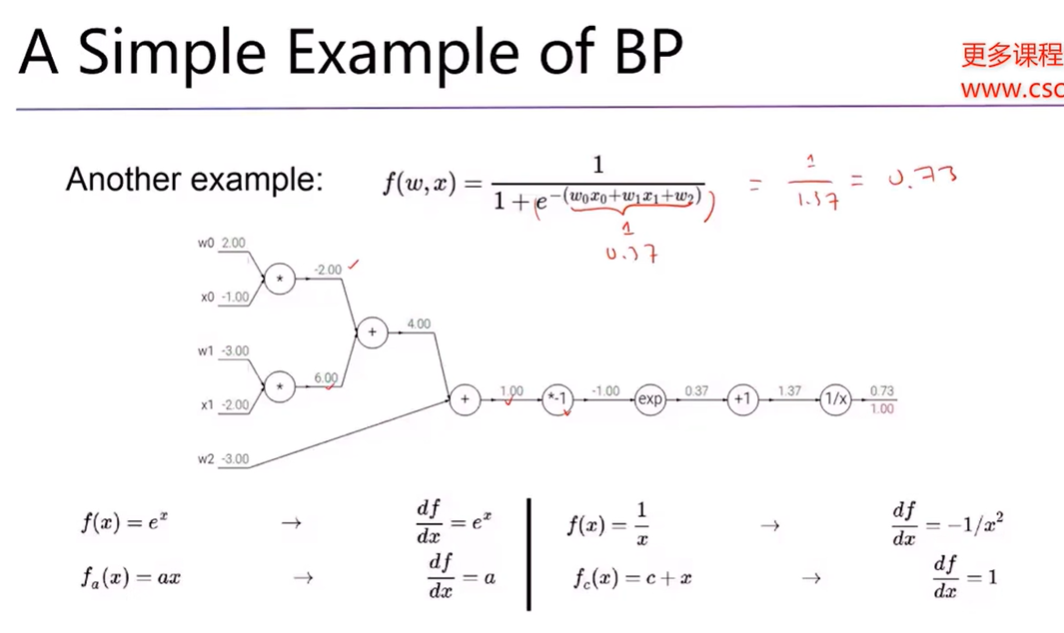

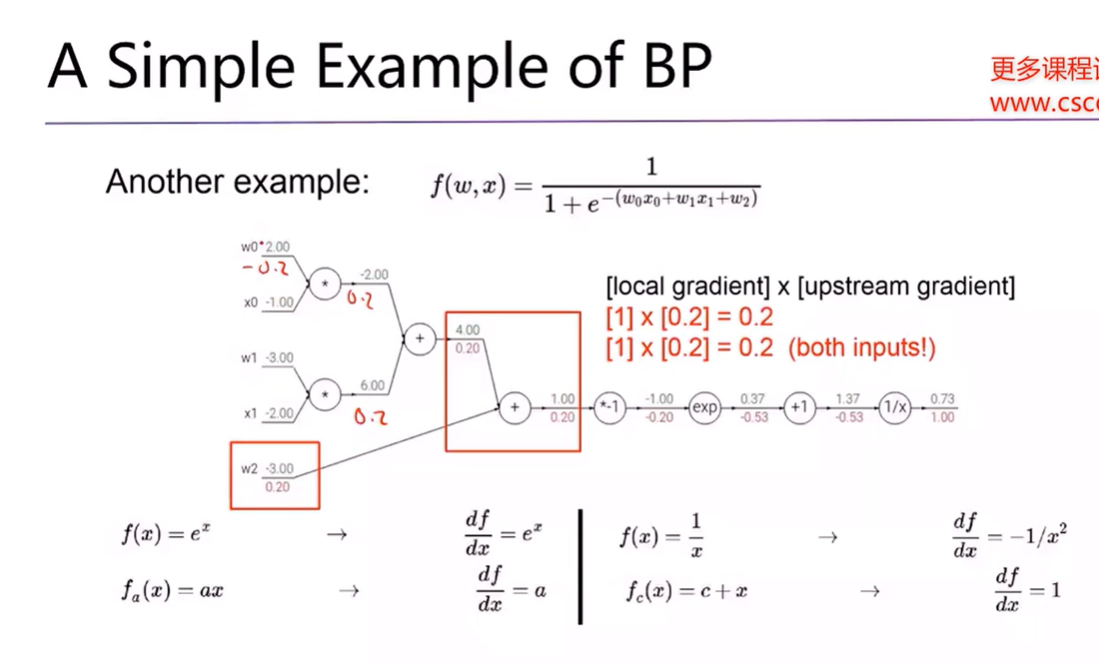

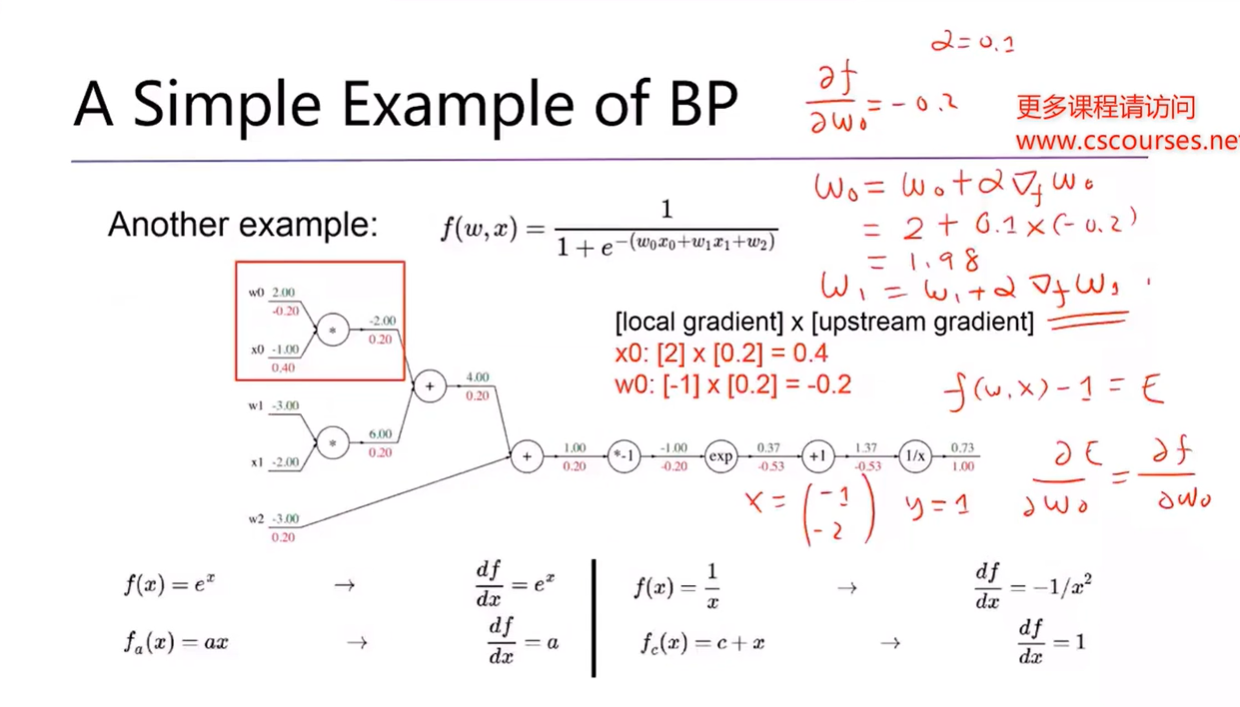

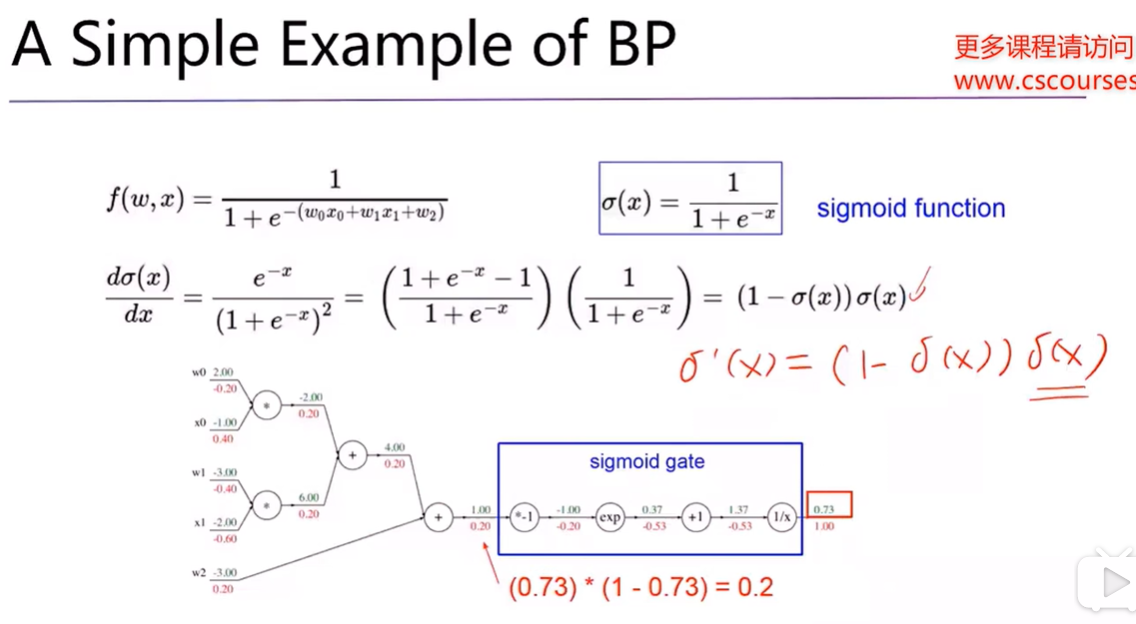

2)Back Propagation

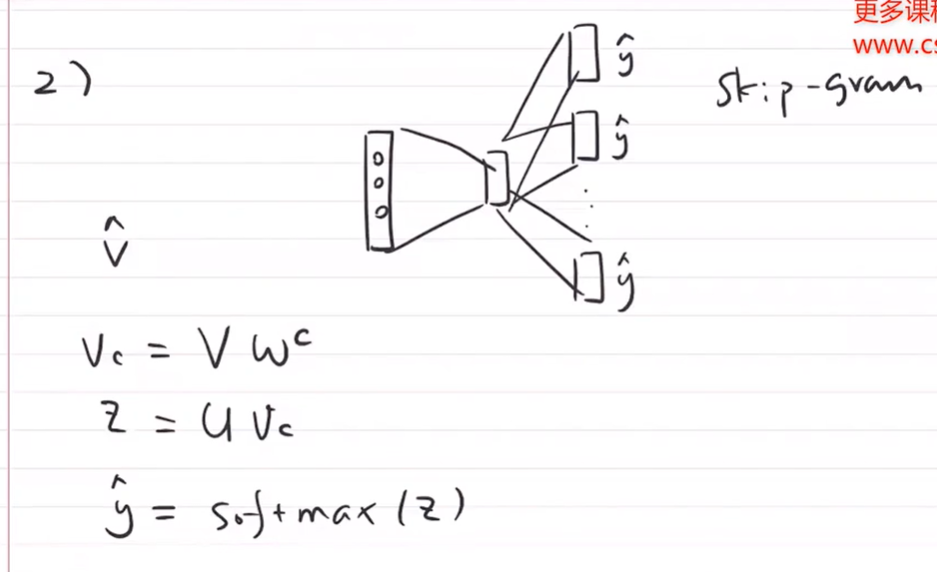

4. Word2Vec

CBOW continuous bag of words: 输入很多词向量,求平均V

skip-gram: 输入center word,变成词向量,