http://cs231n.stanford.edu/slides/2017/cs231n_2017_lecture10.pdf

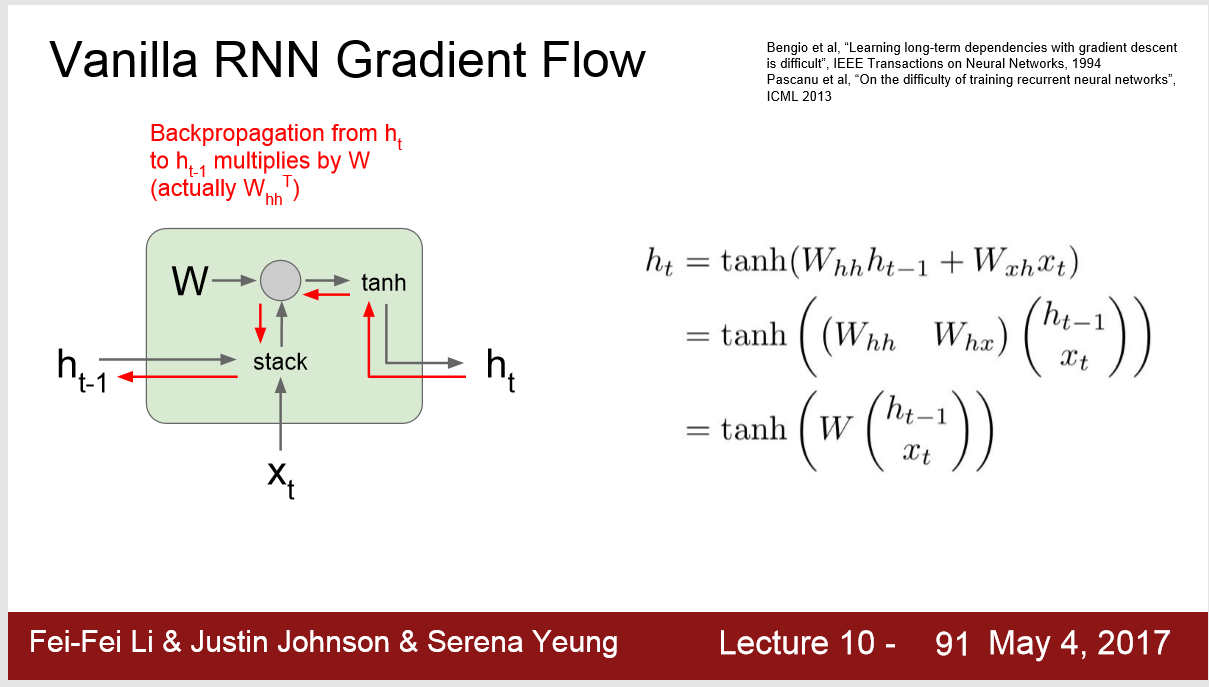

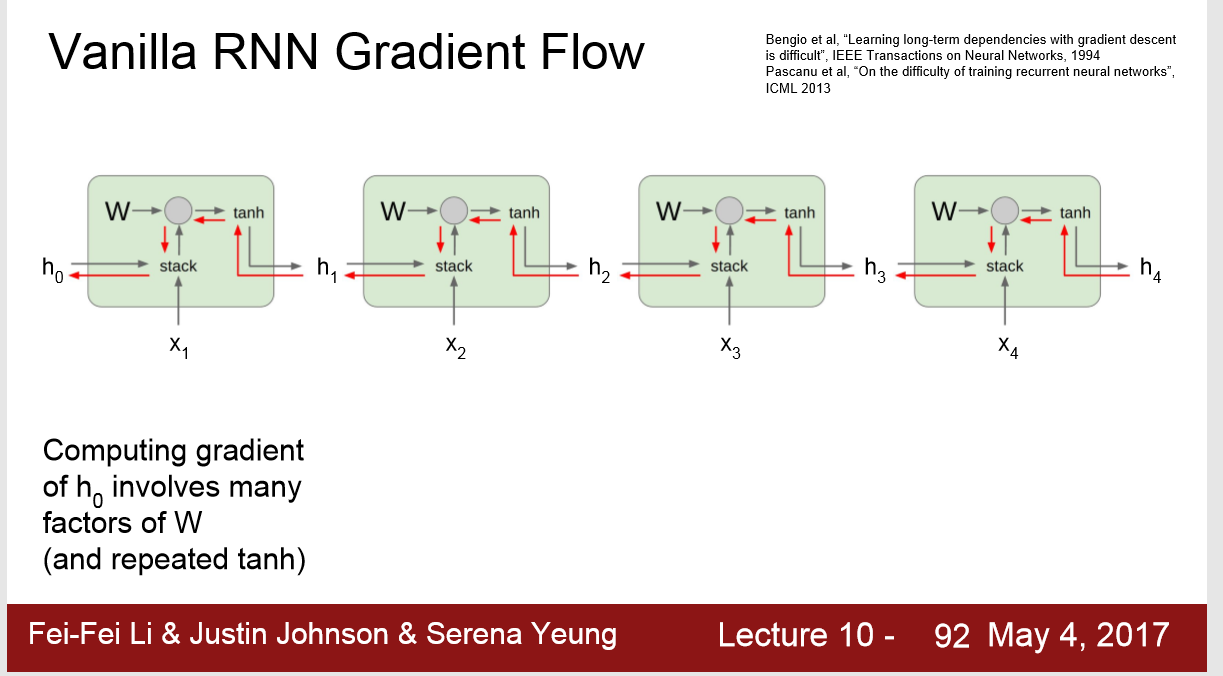

Vanilla RNN Gradient Flow:

问题 : 1. 传统的RNN在 Backpropagation 的时候会出现梯度消失或者梯度爆炸:

这是因为在RNN中,每一个单元的 weight matrix W都是相同的,梯度反向传播的时候 Whh被乘以 t 次。

2. 这种RNN只能学到 medium-range dependencies (中期依赖关系)不能学到 Long term dependencies (长期依赖关系)

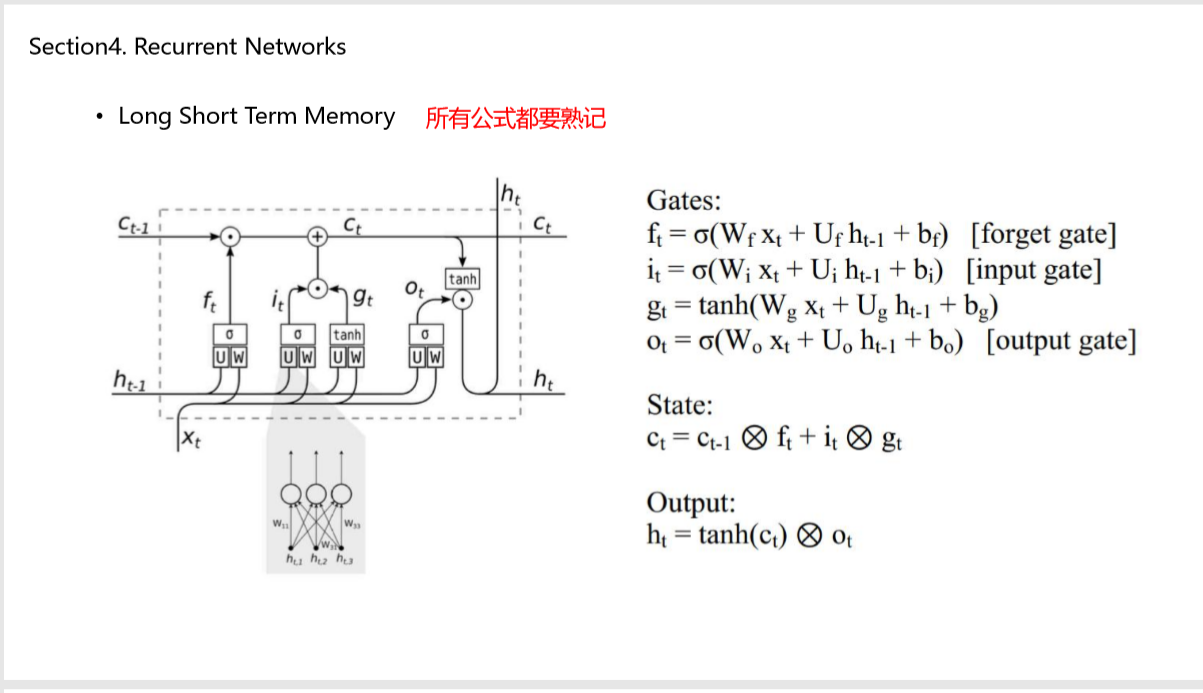

LSTM:

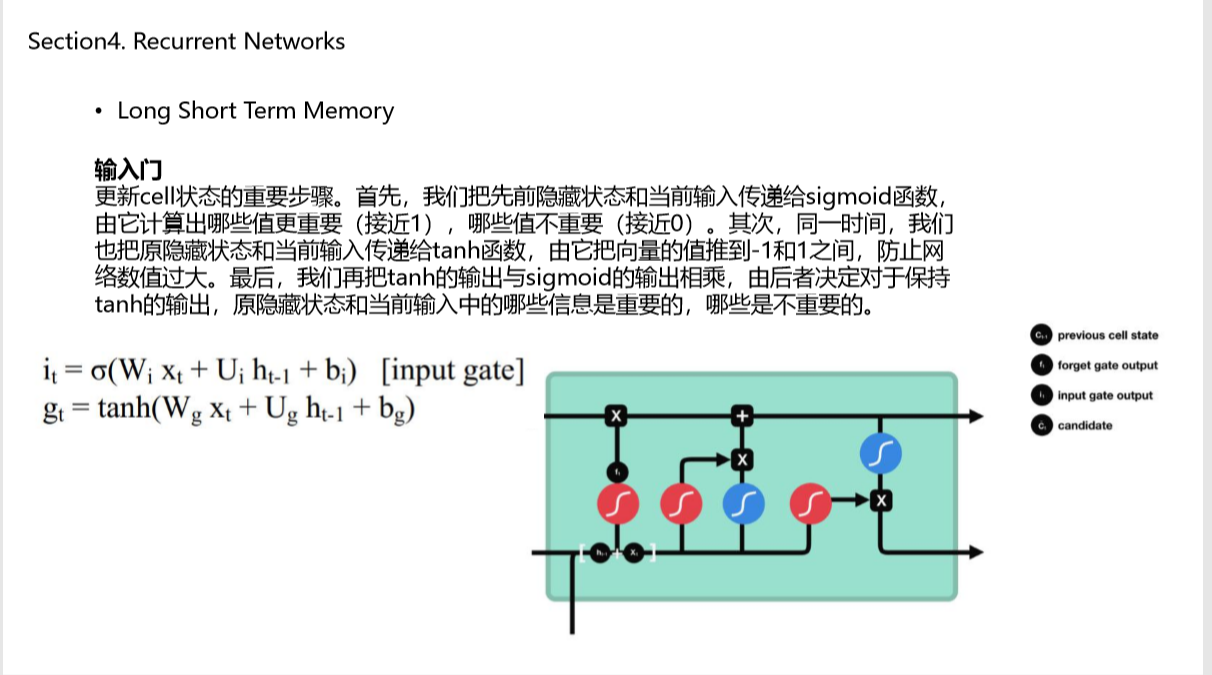

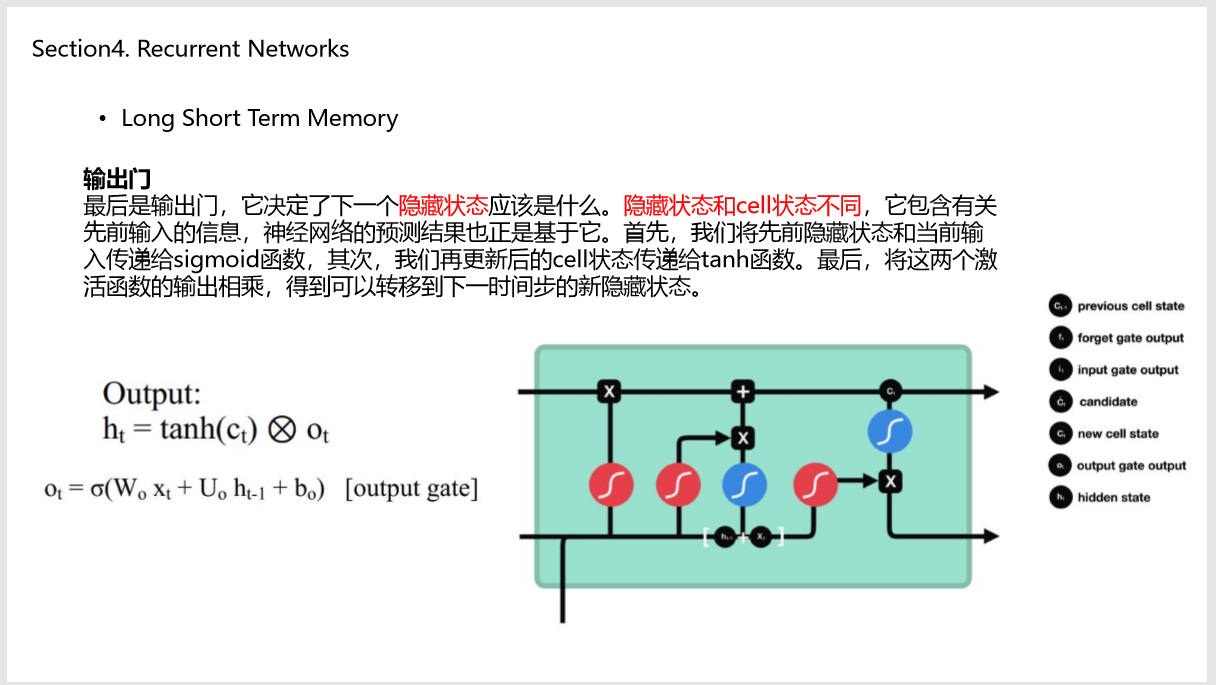

四个门可以记作 ifog: input forget output gate

思路:

1)forget gate 先过滤 cell state

2) input gate 与 gate gate 计算哪些部分更重要

3)计算cell state

4) 输出 ht = tanh(ct) · ot