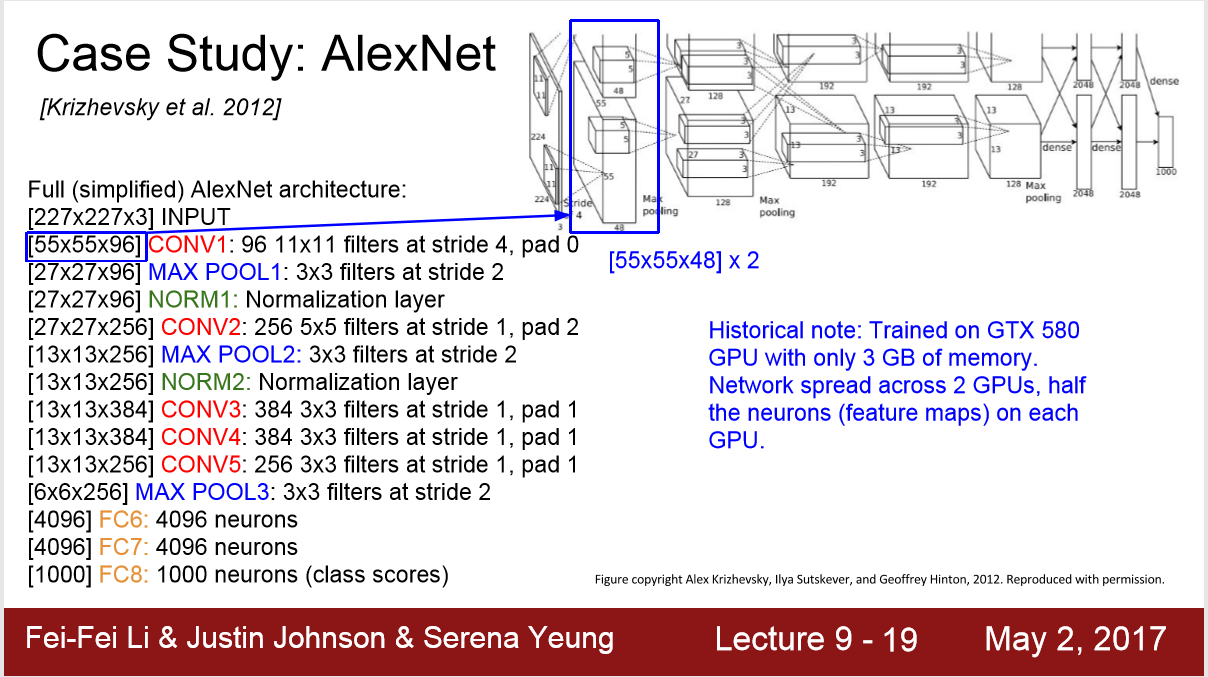

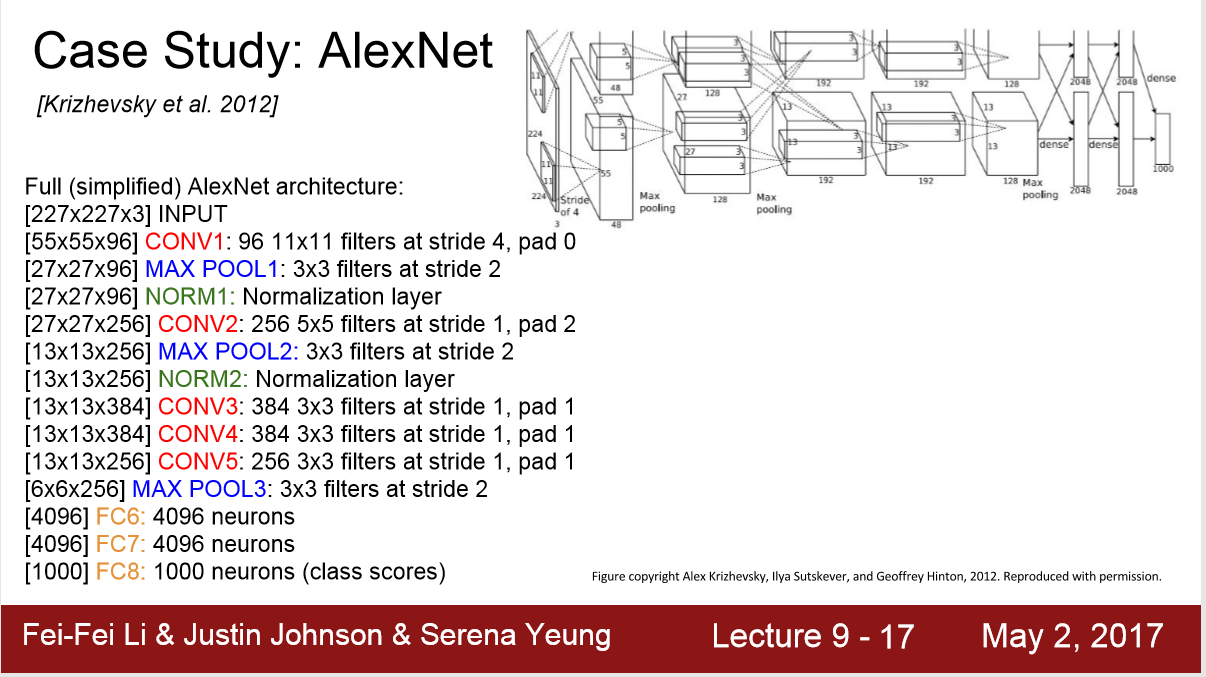

AlexNet

结构:

Conv,pooling,Normalization,Conv,pooling,Normalization,Conv,Conv,Conv,Pool,FC,FC,FC

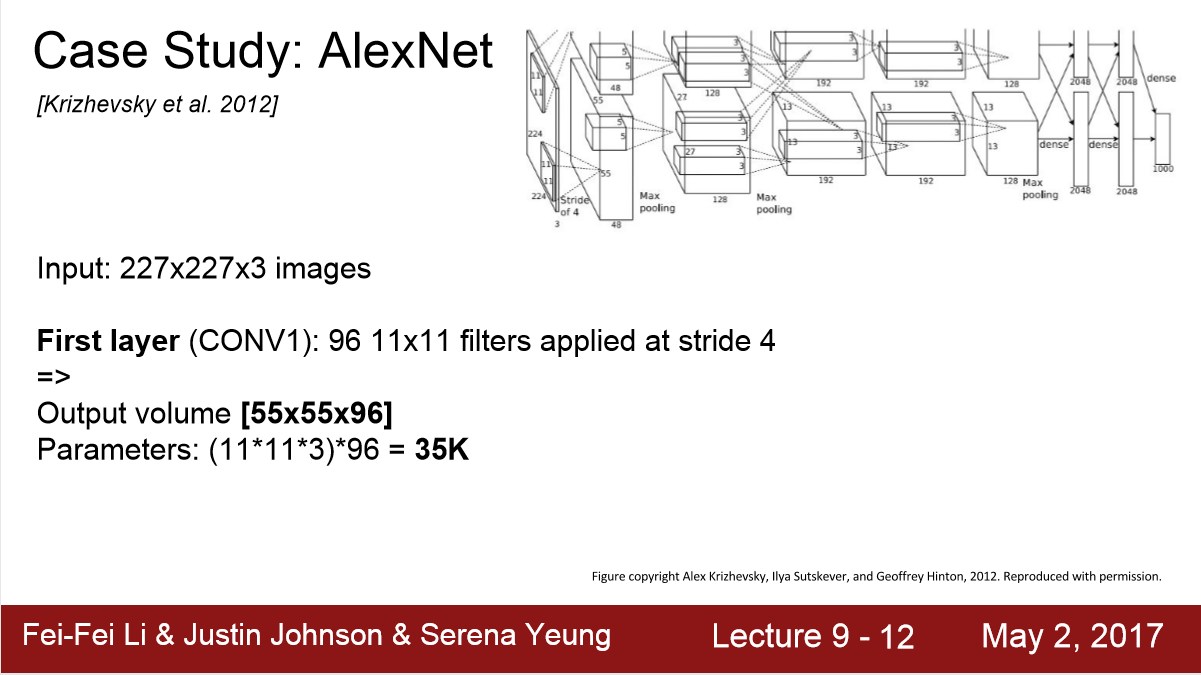

Conv层:

输入 227*227*3 , 96个11*11*3的filter,步长=4,pad=4,边长 = (227-11)/4+1 = 55

输出: 55*55*96

参数数量: 就是weight matrix的总数 = 96*11*11*3 = 35K

池化层:

输入: 55*55*96 , filter 为 3*3,strde=2,边长 = (55-3)/2+1 = 27

输出: 27*27*96

参数数量:0! # 不像卷积层的filter都是weight matrix,池化层的filter是一个最大化函数,所以没有参数

计算尺寸:

输入: 227*227*3

CONV1 : 55*55*96

MAXPOOL1: 27*27*96

NORM1: 27*27*96

CONV2: 27*27*256 # (27-5+4)/1+1 = 27

MAXPOOL2 13*13*256 # (27-3)/2+1

CONV3 13*13*384 # (13+2-3)/1 + 1

CONV4 13*13*384

CONV5 13*13*256

MAXPOOL3 6*6*256 # (13-3)/2+1=6

FC6 4096 # 把 6*6*256的输入flatten 再与 4096个 6*6*256的filtter计算 https://www.cnblogs.com/ChevisZhang/p/12974224.html 全连接层操作

FC7 4096

FC8 1000