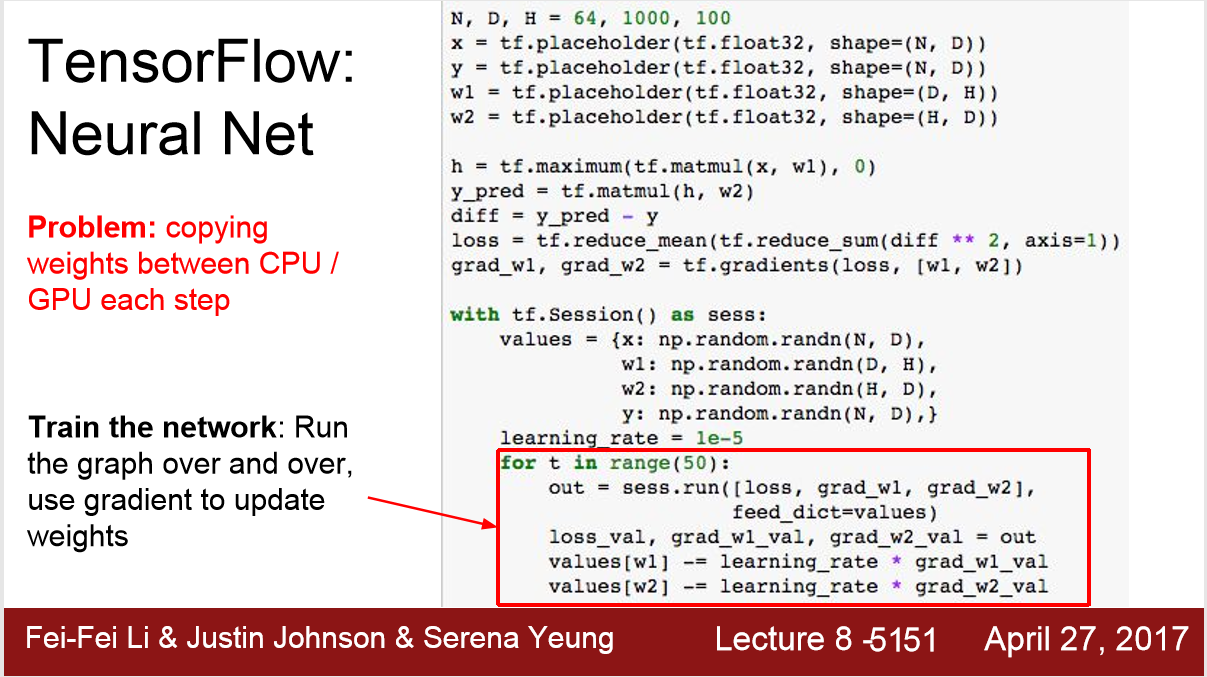

trouble:

我们把w1,w2放在session里会面临,每一步我们都会copy weights 在CPU/GPU之间,这样会导致运行非常缓慢

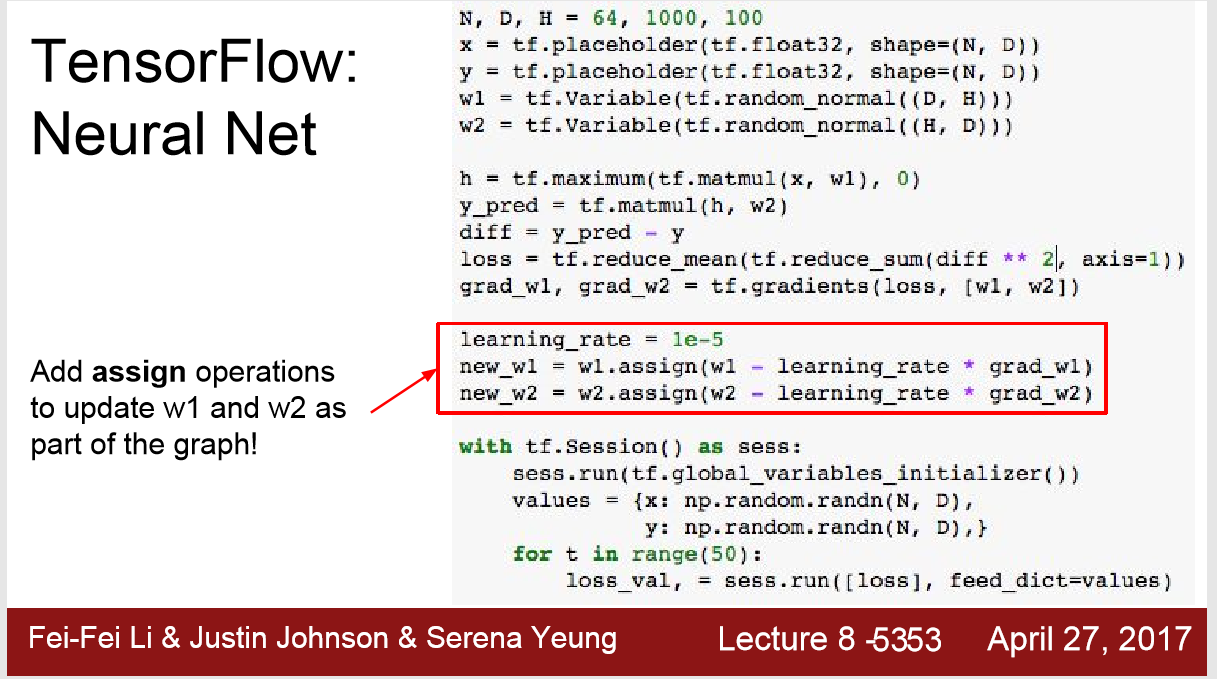

所以把w1,w2放入graph里,避免这种copy

提问:

为什么不把输入与labels: x,y 也放入graph

答:

在实际中,输入是mini-batch的形式,每一个step都会变,而不是这里的随机数。

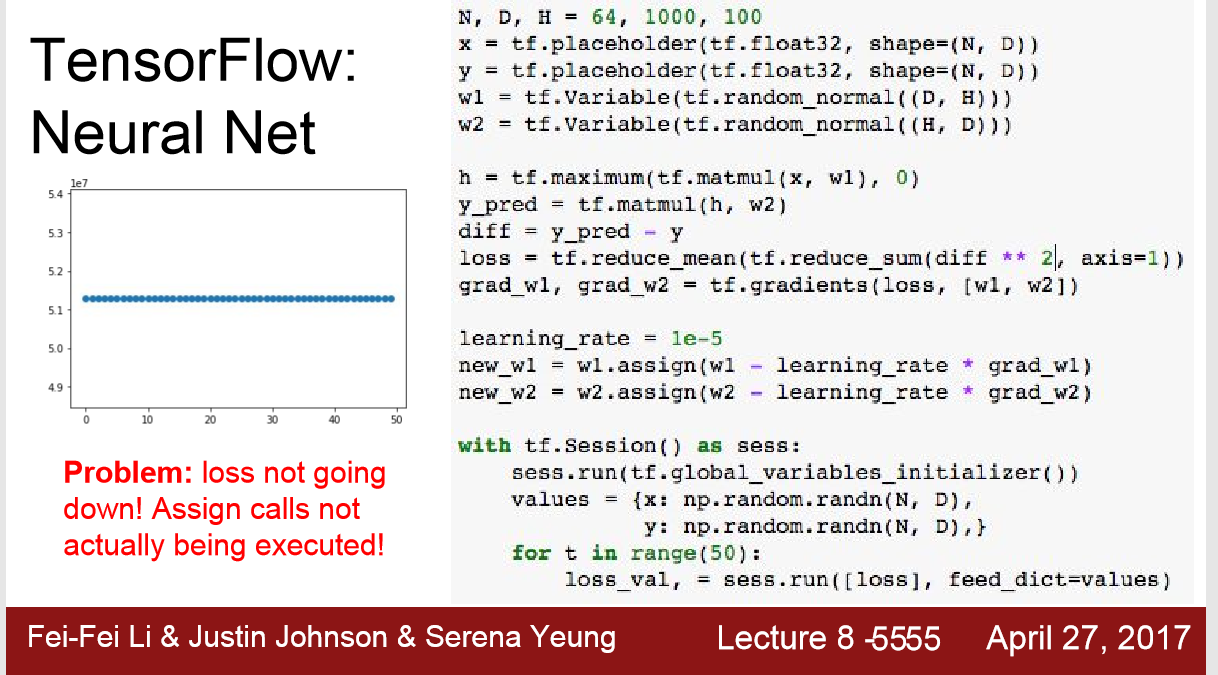

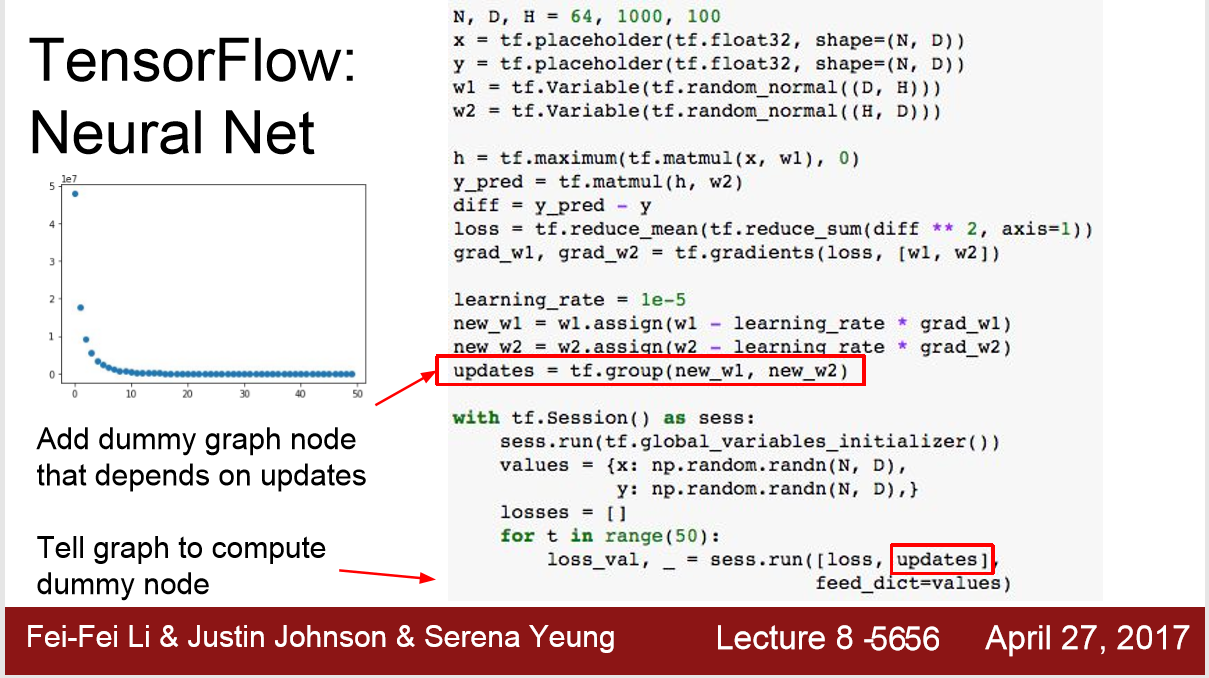

trouble:

将w1,w2写入graph中,结果其没有跟着loss一起更新

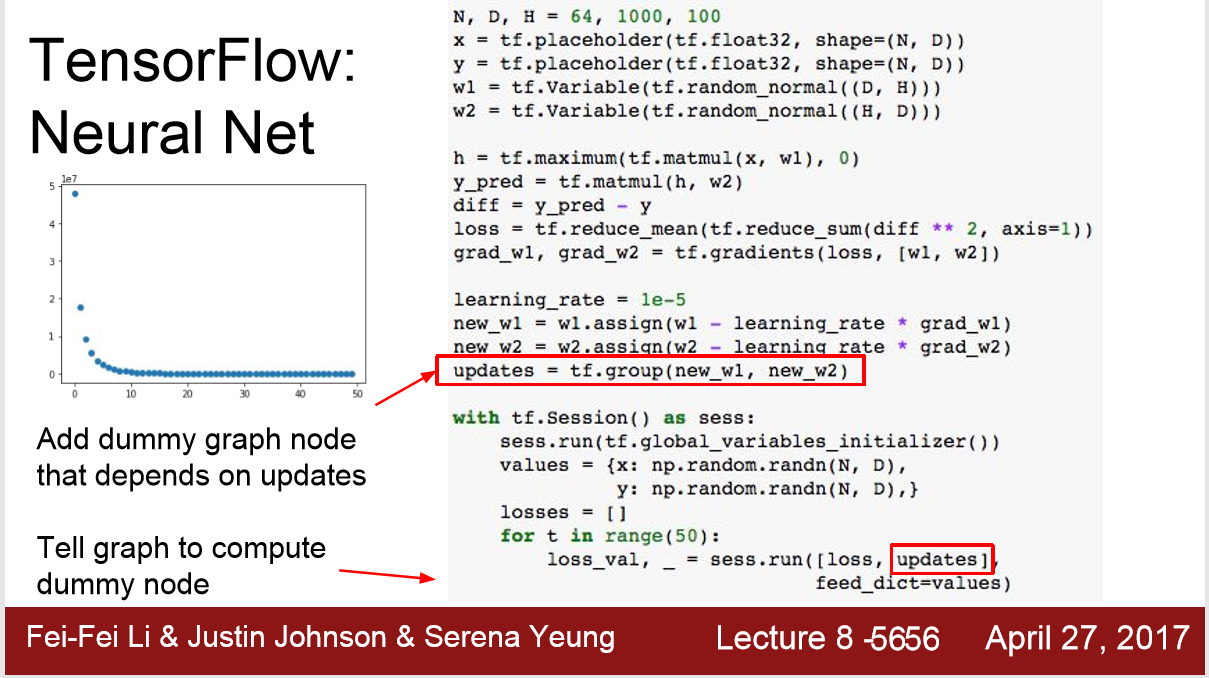

解决方法:

因为在sess.run()中没有加入w1,w2所以其没有更新,现在在 .run() 中加入了tf.group(new_w1,new_w2),其返回None值,但是会一起更新了

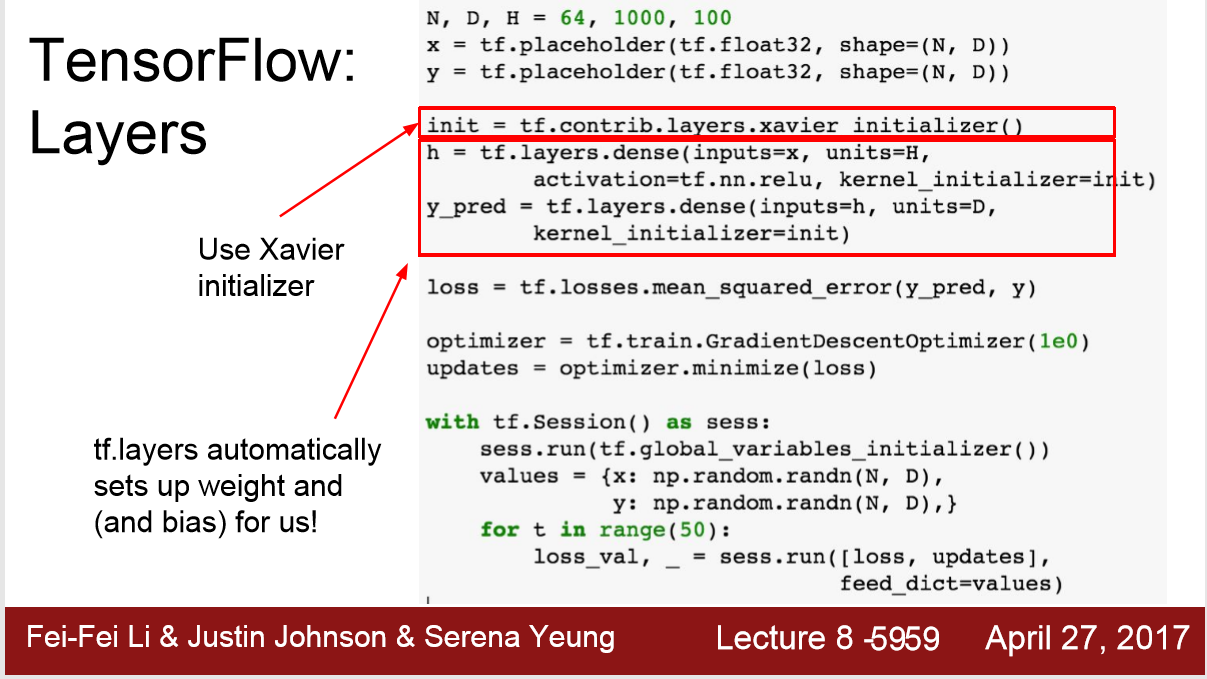

新方法:

这里可以用两行optimizer来计算梯度更新权重,其中参数是learning rate, 代替了上面的五行

新方法:

调用 MSE()方法来代替我们自己写的两行L2 distance (欧氏距离)

新方法: Xavier initializer 有点不懂

set bias

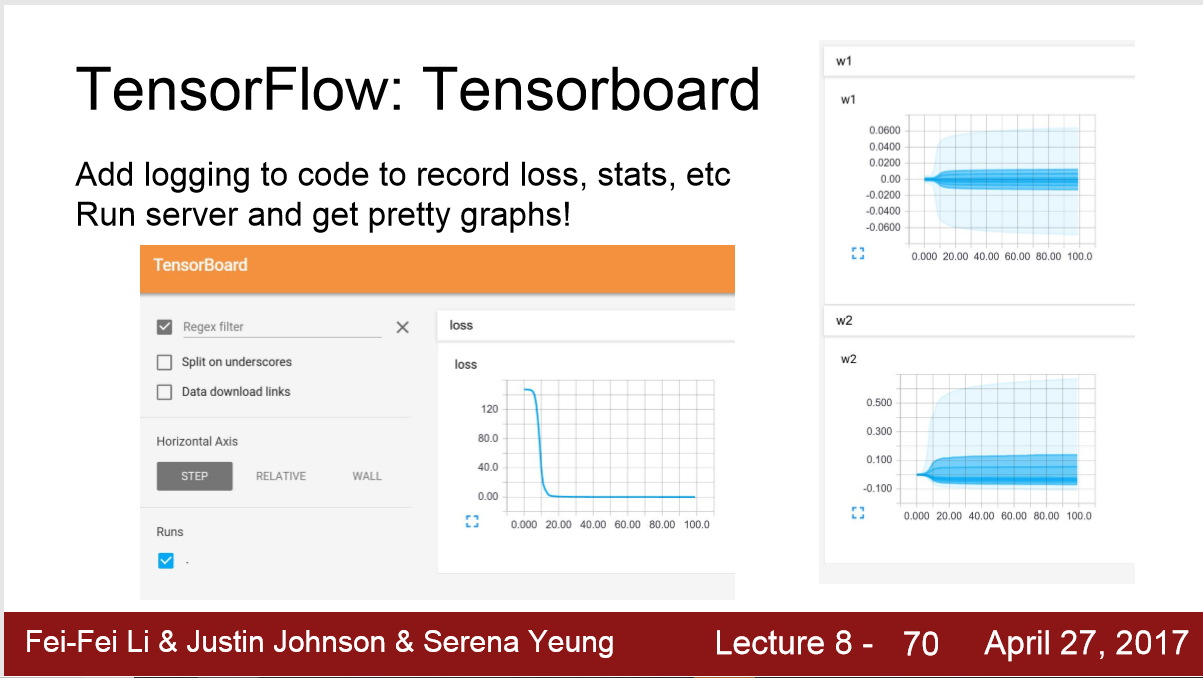

图像记录: tensorBoard

基于TF的包 Keras