深度强化学习

基本概念

-

强化学习

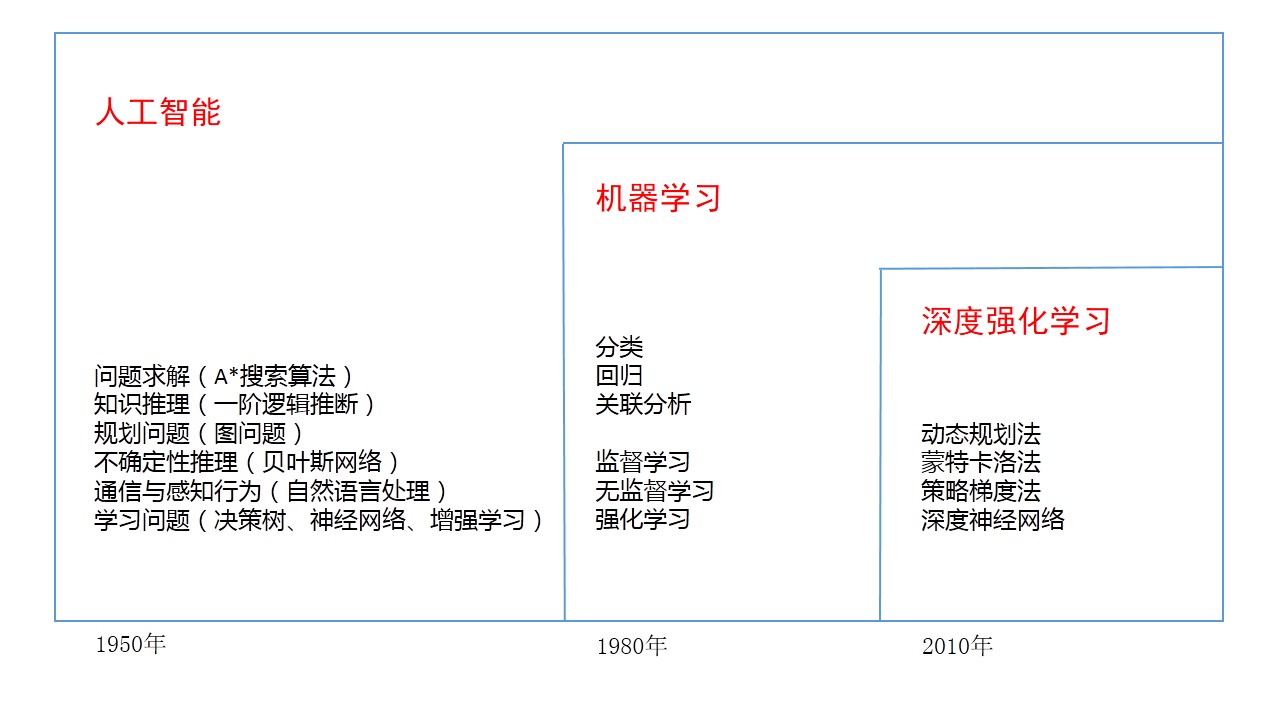

强化学习(Reinforcement Learning)是机器学习的一个重要的分支,主要用来解决连续决策的问题。强化学习可以在复杂的、不确定的环境中学习如何实现我们设定的目标。

-

深度学习

深度学习(Deep Learning)也是机器学习的一个重要分支,也就是多层神经网络,通过多层的非线性函数实现对数据分布及函数模型的拟合。(从统计学角度来看,就是在预测数据分布,从数据中学习到一个模型,然后通过这个模型去预测新的数据)

-

深度强化学习

深度强化学习(Deep Reinforcement Learning)是一种用于做决策(Decision Making)学习的算法,深度学习善于做非线性拟合,强化学习适合做决策学习。二者结合形成了深度强化学习算法。

初探强化学习

-

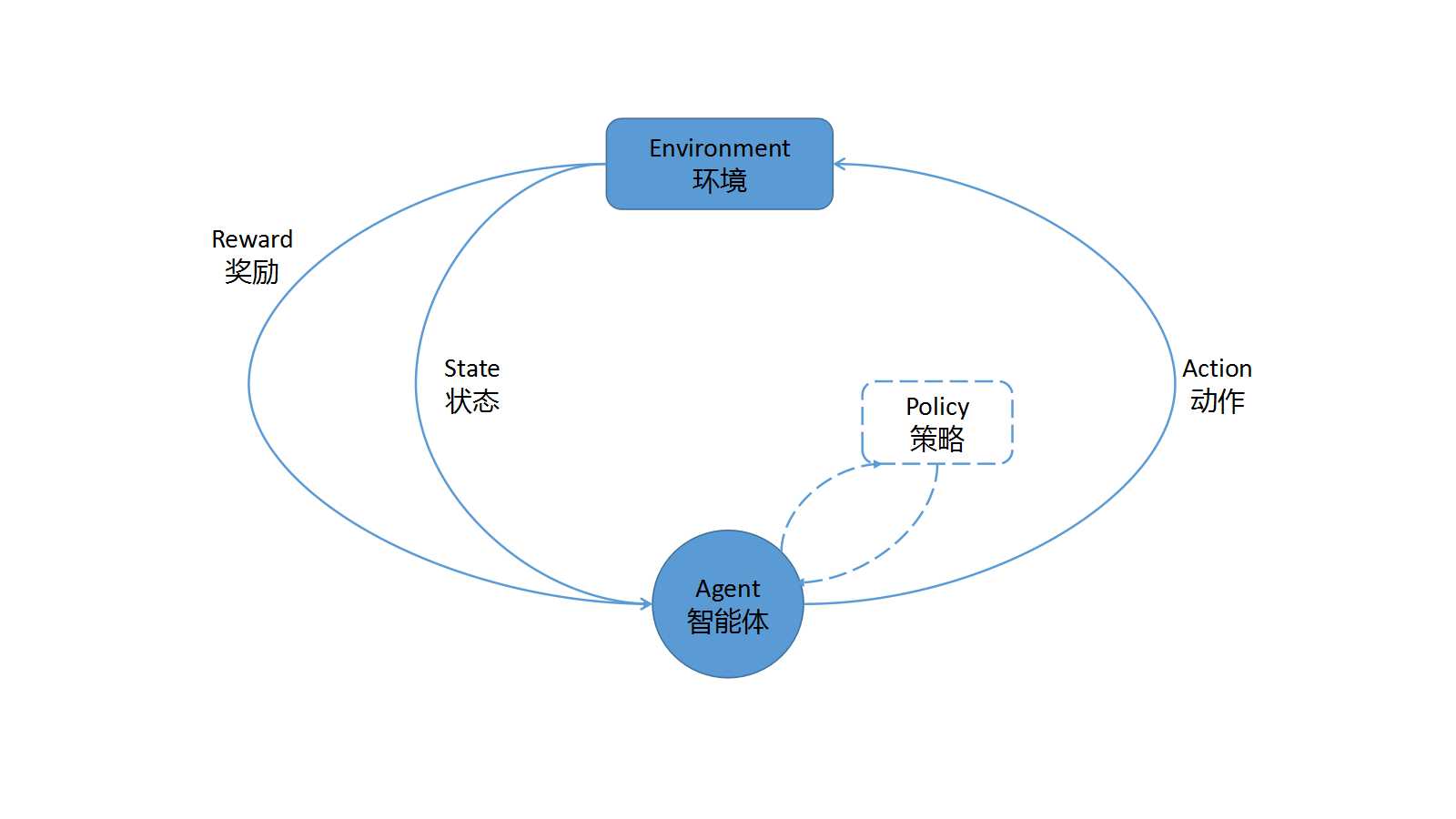

定义:受到行为心理学启发,强化学习主要在关注智能体如何在环境中采取不同的行动,以最大限度地提高累积奖励。

-

基本框架:智能体(Agent)、环境(Environment)、状态(State)、动作(Action)、奖励(Reward)

-

核心元素

- 智能体:强化学习的本体,作为学习者和决策者。

- 环境:强化学习智能体以外的一切,主要由状态集构成。

- 状态:表示环境的数据。状态集是环境中所有可能的状态。

- 动作:智能体可以做出的动作。动作集是智能体可以做出的所有动作。

- 奖励:智能体在执行一个动作后,获得的正/负奖励信号。奖励集是智能体可以获得的所有反馈信息,正/负奖励信号亦可称作正/负反馈信号。

- 策略:强化学习是从环境状态到动作的映射学习,该映射关系称为策略。(即:智能体选择动作的思考过程为策略)

- 目标:智能体自主寻找在连续时间序列里的最优策略,而最优策略通常指最大化长期累积奖励。

因此,强化学习实际上是智能体在与环境进行交互的过程中,学会最佳决策序列。

强化学习和机器学习

-

著名的机器学习十大算法:

- 决策树

- 支持向量机SVM

- 随机森林

- 逻辑回归

- 朴素贝叶斯

- KNN算法

- K-means算法

- AdaBoost算法

- Apriori算法

- PageRank算法

-

强化学习和机器学习的关系

强化学习和监督学习

-

区别

- 两者学习方式不尽相同。

- 两者所需的数据类型有差异,监督学习需要多样化的标签数据,强化学习则需要带有回报的交互数据。

-

学习方式

-

监督学习

监督学习是对数据进行分析,找到数据的表达模型;然后利用这个模型,在新输入的数据上进行决策(即主要分为训练阶段和预测阶段)。学习只发生在训练阶段,该阶段会出现一个预测阶段不会出现的监督信号。

-

强化学习

智能体在与环境的互动中,通过不断探索与试错的方式,利用基于正/负奖励的方式进行学习。强化学习的学习过程与生物的自然学习过程非常相似。

-

-

先验知识与标注数据

强化学习不需要像监督学习那样依赖先验知识数据,它通过自我博弈的方式产生更多的标准数据。强化学习可以利用较少的训练信息,让系统自主学习补充更多信息使整个系统不受标注数据和先验知识的限制。

拿围棋游戏来说,围棋的棋谱数据很容易获得,这些数据都是人类玩家的动作行为记录。如果利用监督学习模型建模,模型模拟出的对弈技能很有可能只局限在所收集的有限棋谱内。当出现新的下棋方式时,模型可能就因为找不到全局最优解而棋力大减。强化学习模型则不同,它可以利用系统自我学习和奖励的方式,让系统自动学习更多棋谱或者进行智能体间的博弈,这样可以为系统补充更多棋谱信息,进而免受监督者的限制。