1.BCELoss和CrossEntropyLoss 区别

https://blog.csdn.net/f156207495/article/details/88874911

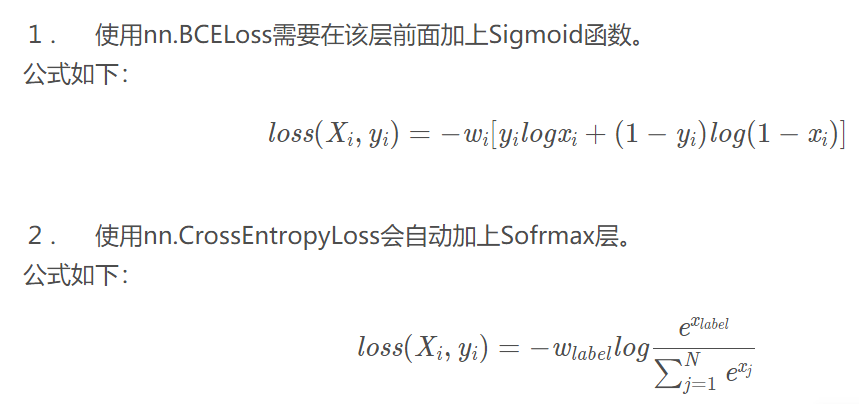

BCELoss是针对二分类的,CrossEntropyLoss是针对多分类的:

也就是使用的分类函数不同。二分类使用sigmoid,多分类使用softmax。

sigmoid和softmax都能将数据归一到【0,1】之间的。

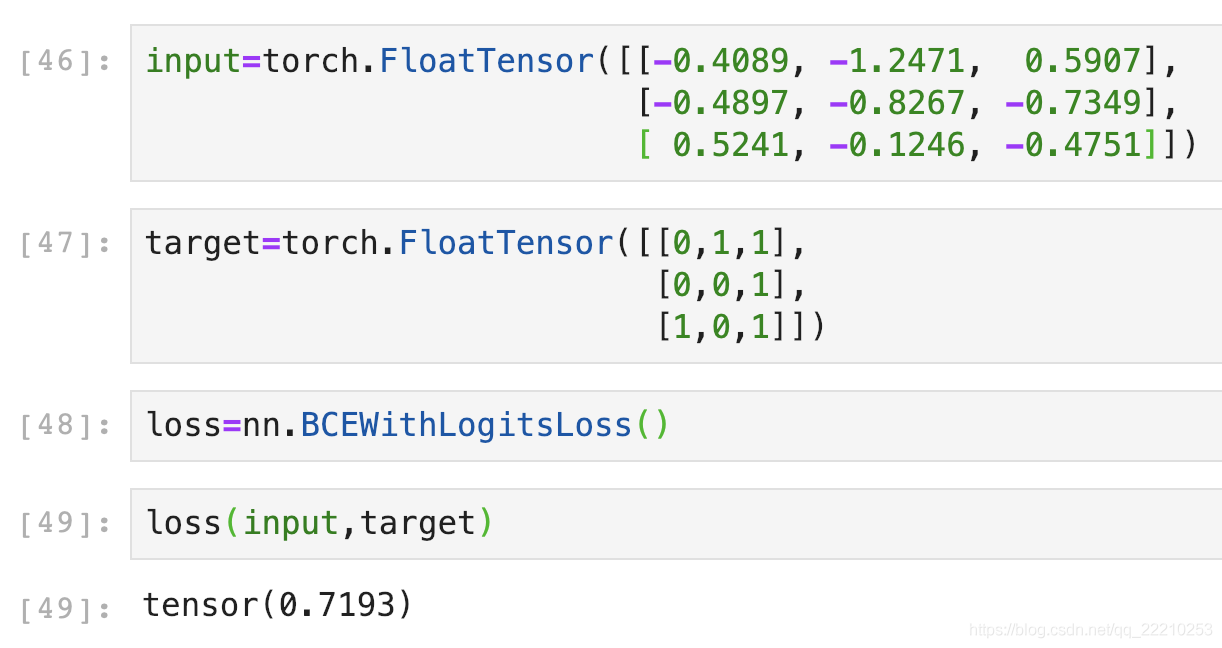

2.BCEWithLogitsLoss

https://blog.csdn.net/qq_22210253/article/details/85222093

BCEWithLogitsLoss就是把Sigmoid-BCELoss合成一步。