绪论

信息论解答了通信理论中的两个基本问题:临界数据压缩(答案:熵H)和临界通信传输速率的值(答案:信道容量C)

熵

如果随机变量X的概率密度函数为p(x),那么X的熵定义为

使用以2为底的对数函数,熵的量纲为比特。熵可以看作是随机变量的平均不确定度的度量。在平均意义下,它是为了描述该随机变量所需的比特数。

联合熵

对于服从联合分布为p(x,y)的一对离散随机变量(X,Y),其联合熵是:

上式也可以表示成:

条件熵

若(X,Y)~p(x,y),条件熵的定义

联合熵和条件熵的定义的这种自然行可由一个事实得到体现,它就是一对随机变量的熵等于其中一个变量的熵加上另一个随机变量的条件熵

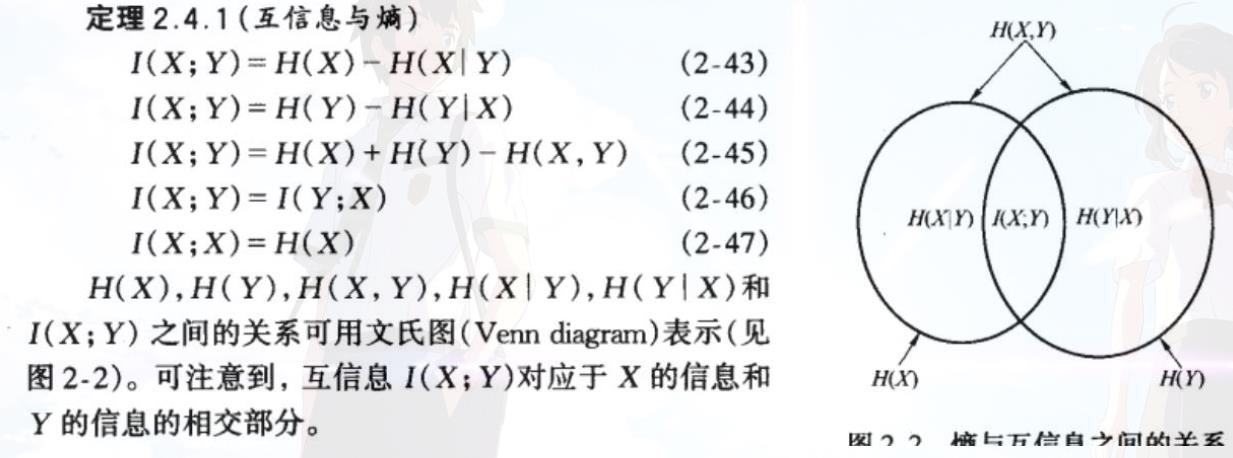

互信息

单个随机变量的熵为该随机变量的不确定度。涉及两个随机变量的条件熵H(X|Y),即一个随机变量在给定另外一个随机变量的条件下的熵。由另一随机变量导致的原随机变量不确定度的缩减量称为互信息。设X和Y是两个随机变量,那个这个缩减量为互信息

互信息 (I(X;Y)) 是两个随机变量相互之间独立程度的度量,它关于X和Y对称,并且永远为非负值,当且仅当X和Y相互独立时,等于零。

通信信道是一个系统,系统的输出信号按概率依赖于输入信号。该系统由一个转移概率矩阵p(y|x)决定,该矩阵决定在输入情况下输出的条件概率分布。对于输入信号为X和输出信号为Y的通信信道,定义它的信道容量C为

相对熵(KL散度,信息增益)

互信息实际上是更广泛量的相对熵 (D(p||q))的特殊情形。相对熵是两个概率密度函数p和q之间距离,定义为

尽管相对熵不是一个真正的度量(并不对称,也不满足三角不等式),但它有着度量的某些性质。相对熵总是非负的,为0的充分必要条件是p=q。

互信息I(X;Y)为联合分布p(x,y)和乘积分布p(x)p(y)之间的相对熵:

推理

随机变量与自身的互信息为该随机变量的熵。有时,熵称为自信息

其他

信息论在计算机科学中,计算消息长度的解释不再适用。主要用它的思想来描述概率分布或者量化概率分布之间的相似性。

信息论的基本想法是一个不太可能的事件发生了,要比一个非常可能的事件发生,能提供更多的信息。