1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

因为python生成的结果为中文,所以首先去网上下载一篇英文小说,我选择的时《了不起的盖茨比》

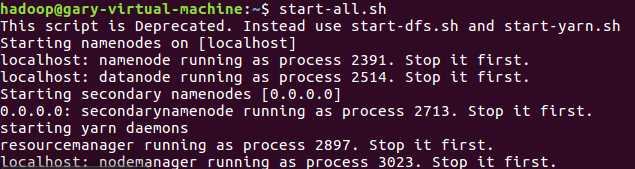

首先启动hadoop

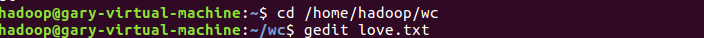

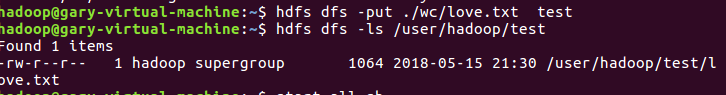

文件上传到hdfs

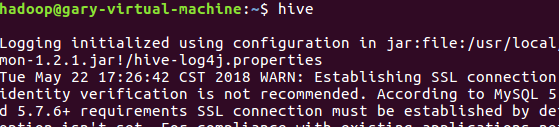

启动hive

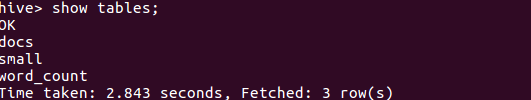

创建原始文件,导入文件到small中并查看,因为之前已经操作,所以直接查看是否有small表

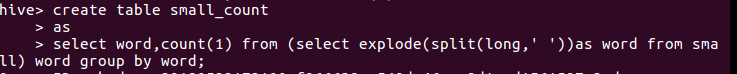

然后进行HQL词频统计,结果放到small_count中

查看small_count表中的前十

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

- 将爬虫大作业的cvs数据传到wc目录下

-

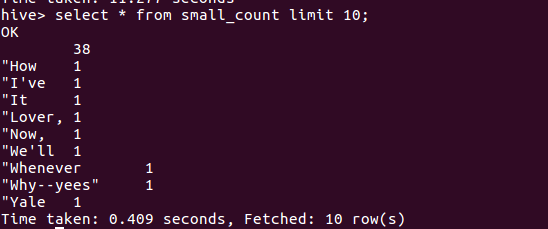

- 将csv文件上传到hdfs中的gigdatacase,并查看

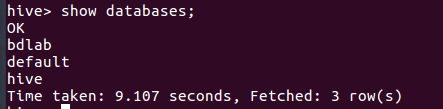

- 显示数据库,并进bdlab数据库

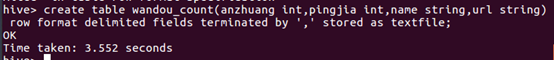

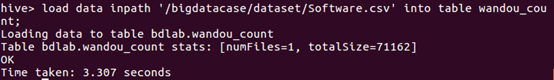

- 创建初始表,并导入数据

- 显示前10行数据

分析数据:

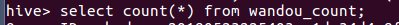

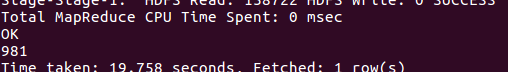

统计该表中有多少条数据行

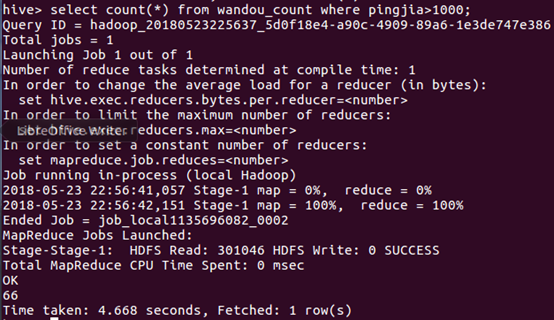

查看评价人数大于1000的软件数量

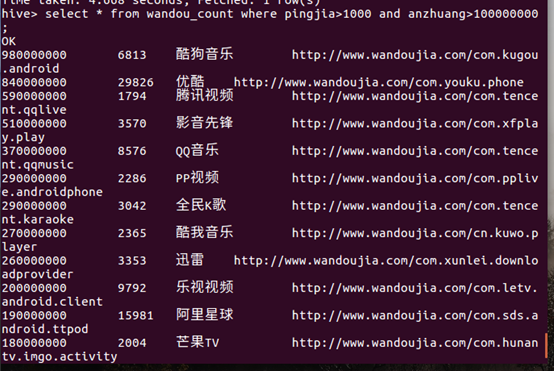

查看显示评价人数大于1000且安装人数大于1亿的全部软件

显示的数据均符合预期效果。