《Linux内核分析》第八周学习笔记 进程的切换和系统的一般执行过程

郭垚 原创作品转载请注明出处 《Linux内核分析》MOOC课程http://mooc.study.163.com/course/USTC-1000029000

【学习视频时间:1小时40分钟 实验时间:1小时35分钟 撰写博客时间:2小时40分钟】

【学习内容:进程切换、Linux系统的一般执行过程、Linux系统架构】

一、进程切换的关键代码switch_to分析

1.1 进程调度与进程调度的时机分析

操作系统原理中介绍了大量进程调度算法,这些算法从实现的角度看仅仅是从运行队列中选择一个新进程,选择的过程中运用了不同的策略而已。 对于理解操作系统的工作机制,反而是进程的调度时机与进程的切换机制更为关键。

1. 进程调度的时机

schedule()函数实现调度:

- 中断处理过程(包括时钟中断、I/O中断、系统调用和异常)中,直接调用schedule(),或者返回用户态时根据need_resched标记调用schedule()

- 内核线程可以直接调用schedule()进行进程切换,也可以在中断处理过程中进行调度,也就是说内核线程作为一类的特殊的进程可以主动调度,也可以被动调度

- 用户态进程无法实现主动调度,仅能通过陷入内核态后的某个时机点进行调度,即在中断处理过程中进行调度

2. 不同类型的进程有不同的调度需求

-

第一种分类:

- I/O-bound 频繁的进行I/O;通常会花费很多时间等待I/O操作的完成

- CPU-bound 计算密集型;需要大量的CPU时间进行运算

-

第二种分类:

- 批处理进程

- 实时进程

- 交互式进程shell

【用户态进程只能被动调度,内核线程是只有内核态没有用户态的特殊进程。】

1.2 进程上下文切换相关代码分析

1. 为了控制进程的执行,内核必须有能力挂起正在CPU上执行的进程,并恢复以前挂起的某个进程的执行,这叫做进程切换、任务切换、上下文切换。

2. 挂起正在CPU上执行的进程,与中断时保存现场是不同的,中断前后是在同一个进程上下文中,只是由用户态转向内核态执行。

3. 进程上下文包含了进程执行需要的所有信息

- 用户地址空间:包括程序代码,数据,用户堆栈等

- 控制信息:进程描述符,内核堆栈等

- 硬件上下文(注意中断也要保存硬件上下文只是保存的方法不同)

4. schedule()函数选择一个新的进程来运行,并调用context_ switch进行上下文的切换,这个宏调用switch_ to来进行关键上下文切换

- next = pick_ next_ task(rq, prev);//进程调度算法都封装这个函数内部

- context_ switch(rq, prev, next);//进程上下文切换

-

switch_ to利用了prev和next两个参数:prev指向当前进程,next指向被调度的进程

31#define switch_to(prev, next, last) 32do { 33 /* 34 * Context-switching clobbers all registers, so we clobber 35 * them explicitly, via unused output variables. 36 * (EAX and EBP is not listed because EBP is saved/restored 37 * explicitly for wchan access and EAX is the return value of 38 * __switch_to()) 39 */ 40 unsigned long ebx, ecx, edx, esi, edi; 41 42 asm volatile("pushfl " /* save flags */ 43 "pushl %%ebp " /* save EBP */ 44 "movl %%esp,%[prev_sp] " /* save ESP */ 45 "movl %[next_sp],%%esp " /* restore ESP */ 46 "movl $1f,%[prev_ip] " /* save EIP */ 47 "pushl %[next_ip] " /* restore EIP */ 48 __switch_canary 49 "jmp __switch_to " /* regparm call */ 50 "1: " 51 "popl %%ebp " /* restore EBP */ 52 "popfl " /* restore flags */ 53 54 /* output parameters */ 55 : [prev_sp] "=m" (prev->thread.sp), 56 [prev_ip] "=m" (prev->thread.ip), 57 "=a" (last), 58 59 /* clobbered output registers: */ 60 "=b" (ebx), "=c" (ecx), "=d" (edx), 61 "=S" (esi), "=D" (edi) 62 63 __switch_canary_oparam 64 65 /* input parameters: */ 66 : [next_sp] "m" (next->thread.sp), 67 [next_ip] "m" (next->thread.ip), 68 69 /* regparm parameters for __switch_to(): */ 70 [prev] "a" (prev), 71 [next] "d" (next) 72 73 __switch_canary_iparam 74 75 : /* reloaded segment registers */ 76 "memory"); 77} while (0)

5. schedule()函数代码分析

-

创建一些局部变量

struct task_struct *prev, *next;//当前进程和一下个进程的进程结构体 unsigned long *switch_count;//进程切换次数 struct rq *rq;//就绪队列 int cpu;

-

关闭内核抢占,初始化一部分变量

need_resched: preempt_disable();//关闭内核抢占 cpu = smp_processor_id(); rq = cpu_rq(cpu);//与CPU相关的runqueue保存在rq中 rcu_note_context_switch(cpu); prev = rq->curr;//将runqueue当前的值赋给prev

-

选择next进程

next = pick_next_task(rq, prev);//挑选一个优先级最高的任务排进队列 clear_tsk_need_resched(prev);//清除prev的TIF_NEED_RESCHED标志。 clear_preempt_need_resched();

-

完成进程的调度

next = pick_next_task(rq, prev);//挑选一个优先级最高的任务排进队列 clear_tsk_need_resched(prev);//清除prev的TIF_NEED_RESCHED标志。 clear_preempt_need_resched();

以上代码中context_switch(rq,prev,next)完成了从prev到next的进程上下文的切换。

6. 进程切换上下文的代码分析

-

schedule()函数选择一个新的进程来运行

next = pick_next_task(rq, prev); clear_tsk_need_resched(prev); clear_preempt_need_resched(); rq->skip_clock_update = 0;

-

通过context_switch完成进程上下文切换

2336context_switch(struct rq *rq, struct task_struct *prev, 2337 struct task_struct *next) 2338{ 2339 struct mm_struct *mm, *oldmm; 2340 2341 prepare_task_switch(rq, prev, next); 2342 2343 mm = next->mm; 2344 oldmm = prev->active_mm; 2350 arch_start_context_switch(prev); 2351 2352 if (!mm) { 2353 next->active_mm = oldmm; 2354 atomic_inc(&oldmm->mm_count); 2355 enter_lazy_tlb(oldmm, next); 2356 } else 2357 switch_mm(oldmm, mm, next); 2358 2359 if (!prev->mm) { 2360 prev->active_mm = NULL; 2361 rq->prev_mm = oldmm; 2362 } 2369 spin_release(&rq->lock.dep_map, 1, _THIS_IP_); 2370 2371 context_tracking_task_switch(prev, next); 2373 switch_to(prev, next, prev); 2374 2375 barrier(); 2381 finish_task_switch(this_rq(), prev); 2382}

-

switch_ to函数代码分析

-

注意:

- 下图42行保存当前进程的flags

- 下图43行把当前进程的堆栈基址压栈

- switch_ to完成寄存器的切换:先保存当前进程的寄存器,再进行堆栈切换(下图第44、45行)自此后所有的压栈都是在新进程的堆栈中了,再切换eip(下图46、56行),这样当前进程可以从新进程中恢复,还有其他必要的切换

- next_ ip一般是$1f(对于新创建的进程来说就是ret_ from_ fork)

- 下图47行表明下一进程栈顶是起点。next_ ip一般是$1f,对于新创建的子进程是ret_ from_fork

- 下图49行jmp _ switch_ to是函数调用,通过寄存器传递参数;函数执行结束return的时候从下一条指令开始(即是新进程的开始)

-

next进程曾经是prev进程,nex执行完后执行的“下一个”其实是刚刚被切换的进程

42 asm volatile("pushfl " /* save flags */ 43 "pushl %%ebp " /* save EBP */ 44 "movl %%esp,%[prev_sp] " /* save ESP */ 45 "movl %[next_sp],%%esp " /* restore ESP */ 46 "movl $1f,%[prev_ip] " /* save EIP */ 47 "pushl %[next_ip] " /* restore EIP */ 48 __switch_canary 49 "jmp __switch_to " /* regparm call */ 50 "1: " 51 "popl %%ebp " /* restore EBP */ 52 "popfl " /* restore flags */ 53 54 /* output parameters */ 55 : [prev_sp] "=m" (prev->thread.sp), 56 [prev_ip] "=m" (prev->thread.ip), 57 "=a" (last), 58 59 /* clobbered output registers: */ 60 "=b" (ebx), "=c" (ecx), "=d" (edx), 61 "=S" (esi), "=D" (edi) 62 63 __switch_canary_oparam 64 65 /* input parameters: */ 66 : [next_sp] "m" (next->thread.sp), 67 [next_ip] "m" (next->thread.ip), 68 69 /* regparm parameters for __switch_to(): */ 70 [prev] "a" (prev), 71 [next] "d" (next) 72 73 __switch_canary_iparam 74 75 : /* reloaded segment registers */ 76 "memory"); 77} while (0)

二、Linux系统的一般执行过程

2.1 Linux系统的一般执行过程分析

最一般的情况:正在运行的用户态进程X切换到运行用户态进程Y的过程

- 正在运行的用户态进程X

- 发生中断——save cs:eip/esp/eflags(current) to kernel stack,then load cs:eip(entry of a specific ISR) and ss:esp(point to kernel stack).

- SAVE_ALL //保存现场

- 中断处理过程中或中断返回前调用了schedule(),其中的switch_to做了关键的进程上下文切换

- 标号1之后开始运行用户态进程Y(这里Y曾经通过以上步骤被切换出去过因此可以从标号1继续执行)

- restore_all //恢复现场

- iret - pop cs:eip/ss:esp/eflags from kernel stack

- 继续运行用户态进程Y

2.2 Linux系统的一般执行过程中的几个特殊情况

几种特殊情况:

- 通过中断处理过程中的调度时机,用户态进程与内核线程之间互相切换和内核线程之间互相切换,与最一般的情况非常类似,只是内核线程运行过程中发生中断没有进程用户态和内核态的转换

- 内核线程主动调用schedule(),只有进程上下文的切换,没有发生中断上下文的切换,与最一般的情况略简略

- 创建子进程的系统调用在子进程中的执行起点及返回用户态,如fork

- 加载一个新的可执行程序后返回到用户态的情况,如execve

2.3 内核与舞女

- 进程的地址空间一共有4G,其中0——3G是用户态可以访问,3G以上只有内核态可以访问

- 内核相当于出租车,可以为每一个“招手”的进程提供内核态到用户态的转换。

- 没有进程需要“承载”的时候,内核进入idle0号进程进行“空转”。当用户进程有需求时,内核发生中断,帮助用户进程完成请求,然后再返回到用户进程。就好像Taxi将用户载了一圈之后又把用户放下来。

- 3G以上的部分就是这样的“出租车”,是所有进程共享的,在内核态部分切换的时候就比较容易

- 内核是各种中断处理程序和内核线程的集合。

三、Linux系统架构和执行过程概览

3.1 Linux操作系统架构概览

1. 操作系统的基本概念及目的

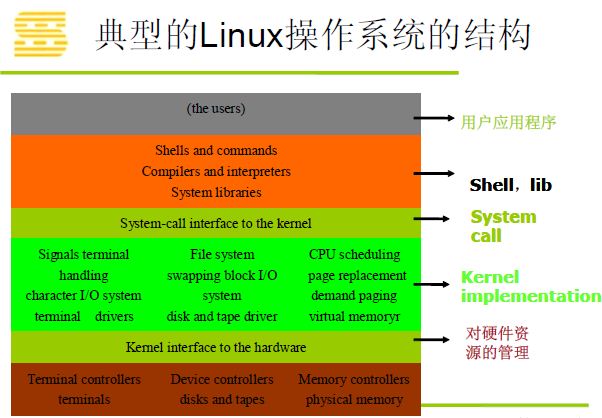

2. 典型的Linux操作系统架构

3.2 最简单、最复杂的操作——执行ls命令

3.3 从CPU和内存的角度看Linux系统的执行

1. 执行gets()函数

2. 执行系统调用,陷入内核

3. 等待输入,CPU会调度其他进程执行,同时wait一个I/O中断

4. 输入ls,发I/O中断给CPU,中断处理程序进行现场保存、压栈等等

5. 中断处理程序发现X进程在等待这个I/O(此时X已经变成阻塞态),处理程序将X设置为WAKE_UP

6. 进程管理可能会把进程X设置为next进程,这样gets系统调用获得数据,再返回用户态堆栈

7. 从CPU执行指令的角度看:

8. 从内存角度看,所有的物理地址都会被映射到3G以上的地址空间。因为这部分对所有进程来说都是共享的:

四、实验

使用gdb跟踪分析一个schedule()函数 ,验证对Linux系统进程调度与进程切换过程的理解

跟踪调试schedule()函数的执行过程如下。由下图可知进程调度时,首先进入schedule()函数,将一个task_ struct结构体的指针tsk赋值为当前进程,然后调用sched_ submit_ work(tsk)。

进入sched_ submit_ work(tsk)函数查看它的工作:sched_ submit_ work主要作用是避免死锁。

由上图可知该函数时检测tsk->state是否为0 (runnable)若为运行态时则返回, tsk_ is_ pi_ blocked(tsk),检测tsk的死锁检测器是否为空,若非空的话就return。

![]()

进入schedule()函数,schedule()是切换进程的真正代码:

整个schedule的执行过程可以用下面的流程图表示:

总结

本周视频主要讲解了进程切换的关键代码switch_ to分析、Linux系统的一般执行过程、Linux系统架构和执行过程。从中我了解到schedule()函数实现进程调度,context_ switch完成进程上下文切换,switch_ to完成寄存器的切换。在调度时机方面,内核线程可以直接调用schedule()进行进程切换,也可以在中断处理过程中进行调度,也就是说内核线程作为一类的特殊的进程可以主动调度,也可以被动调度。而用户态进程无法实现主动调度,仅能通过陷入内核态后的某个时机点进行调度,即在中断处理过程中进行调度。