Hadoop组件依赖图(从下往上看)

安装步骤:

详细步骤:

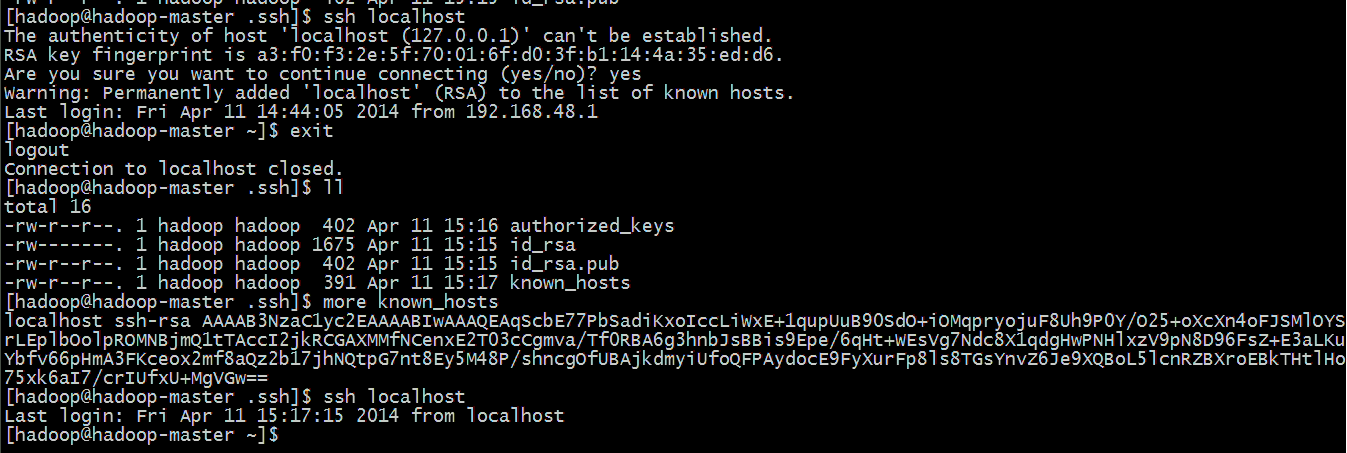

设置ssh自动登录(如下图):

1、输入命令 【ssh-keygen -t rsa】,然后一直按回车就可以了

2、然后切换目录到 ~ .ssh目录下执行命令【cp id_rsa.pub authorized_keys】

3、这样就完成了,然后测试

1) 输入命令【ssh localhost】,然后输入【yes】,就会登陆成功另外会看到原本的 .ssh目录变成了 ~ 目录

2) 输入命令【exit】退出,然后还是在以前的.ssh目录下,这时候输入ll会发现多了一个 known_hosts文件,顾名思义。

3) 然后再次输入命令【ssh localhost】就可以直接登录了,当然还可以【ssh ip地址】、【ssh 主机名】等等,只需第一次输入【yes】,之后就可以直接登录了。

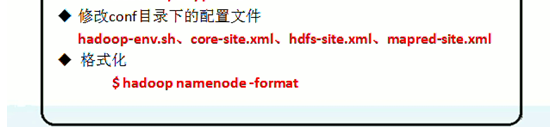

下面进行hadoop相关文件配置:

1、配置 hadoop 环境文件 hadoop-env.sh

1) 打开文件,找到某行有 ”# export JAVA_HOME = ...” 字样的地方,去掉 “#” ,然后在等号后面填写你自己的 JDK 路径,比如像我自己的 JDK 路径,那就改为了 如下所示

export JAVA_HOME=/opt/modules/jdk1.7.0_45

2) 配置 Hadoop 的核心文件 core-site.xml

打开文件,会发现标签 <configuration></configuration> 中是空的,在空的地方添加如下配置

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://hadoop-master.dragon.org:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/data/tmp</value>

</property>

</configuration>

2、

上面配置项是 hdfs副本数(默认为3),下面配置项为 是否进行权限检查

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

3、

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>hadoop-master.dragon.org:9001</value>

</property>

</configuration>

当然下面两个也可以用默认配置

hadoop-master.dragon.org

hadoop-master.dragon.org

到这里,基本就算配置完毕了

测试:

首先格式化:hadoop namenode -format

然后启动:

初步学习安装可以一步一步来(在hadoop的bin目录下)

可先启动start-dfs.sh

然后可输入jps观察如下

可在浏览器 输入 http://192.168.1.123:50070看到相关信息(当然也可以输入域名等)

然后启动start-mapred.sh

然后可输入jps观察如下

可在浏览器 输入 http://192.168.1.123:50030看到相关信息(当然也可以输入域名等)

好了,到这里伪分布式环境搭建就算结束了。