今天做了极限测试,七个多小时的时间,做数据的导入,清洗,分析,导出,可视化。我做到了导出这一步,可视化还没做,计划明天找个时间把可视化的部分做了。

下面是极限测试的要求与我的操作步骤和流程:

要求:

1、数据导入:

要求将样表文件中的(sales_sample_20170310)数据导入 HIVE 数据仓库中。

2、数据清洗:

要求将 day_id 一列中的数值清洗为真实的日期格式,可用字符串表示。

数据 1 对应日期 2021-09-01,依次类推,15 对应日期 2021-09-15

3、数据分析处理:

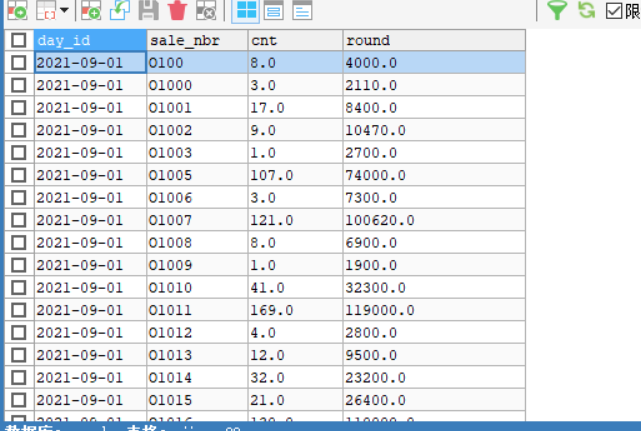

(1)统计每天各个机场的销售数量和销售金额。

要求的输出字段

day_id,sale_nbr,,cnt,round

日期编号,卖出方代码,数量,金额

(2)统计每天各个代理商的销售数量和销售金额。

要求的输出字段

day_id,sale_nbr,,cnt,round

日期编号,卖出方代码,数量,金额

(3)统计每天各个代理商的销售活跃度。

要求的输出字段

day_id,sale_nbr, sale_number

日期编号,卖出方代码,交易次数(买入或者卖出均算交易次数)

(4)汇总统计 9 月 1 日到 9 月 15 日之间各个代理商的销售利润。

编号,卖出方代码,买入数量,买入金额,卖出数量,卖出金额,销售利润(卖出

金额-买入金额)

(5)设计分析代理商的市场地位根据市场交易次数、交易对象个数、销售机票数量、

销售利润等。(选做题)

4、处理结果入库:

将上述统计分析的结果数据保存到 mySQL 数据库中。 第 3 页 共 9 页

5、数据可视化展示:

利用 Echarts 将上述统计结果以图形化展示的方式展现出来:饼图、柱状图、地图、折

线图等。

我的处理步骤:

先打开三台虚拟机:

然后用xshell连接:

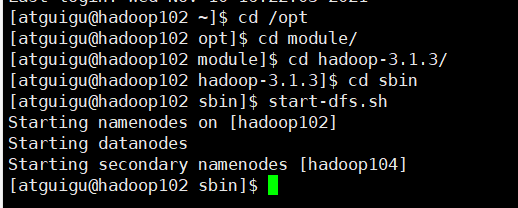

打开dfs

开启hive的两个服务:

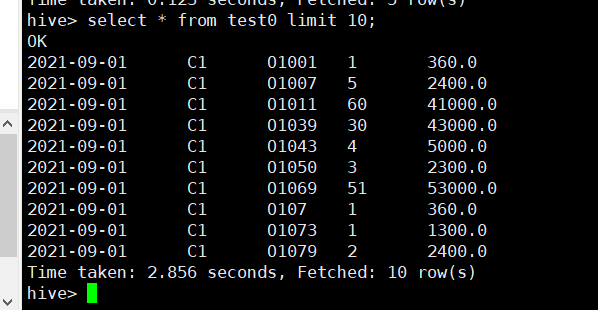

进入hive:

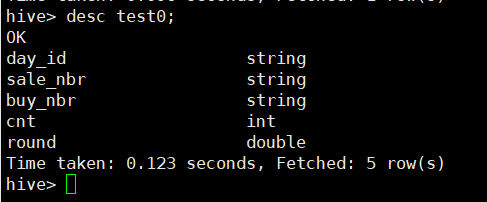

在hive里面建表:

create table test0 (day_id string,sale_nbr string,buy_nbr string,cnt string,round string) ROW format delimited fields terminated by ',' STORED AS TEXTFILE;

导入数据:

load data local inpath '/opt/software/sale.csv' into table test0;

然后进行清洗:把日期清洗成标准格式:

insert overwrite table test0 select date_add('2021-09-00',cast(day_id as int)) as day_id,

sale_nbr as sale_nbr,buy_nbr as buy_nbr,cnt as cnt,round as round from test0;

导出:

bin/sqoop export \

--connect jdbc:mysql://192.168.10.102:3306/user \

--username root \

--password 123456 \

--table wenti7 \

--num-mappers 1 \

--export-dir /user/hive/warehouse/dao1 \

--input-fields-terminated-by ","

这样就做好到导出数据了;明天计划进行可视化操作。