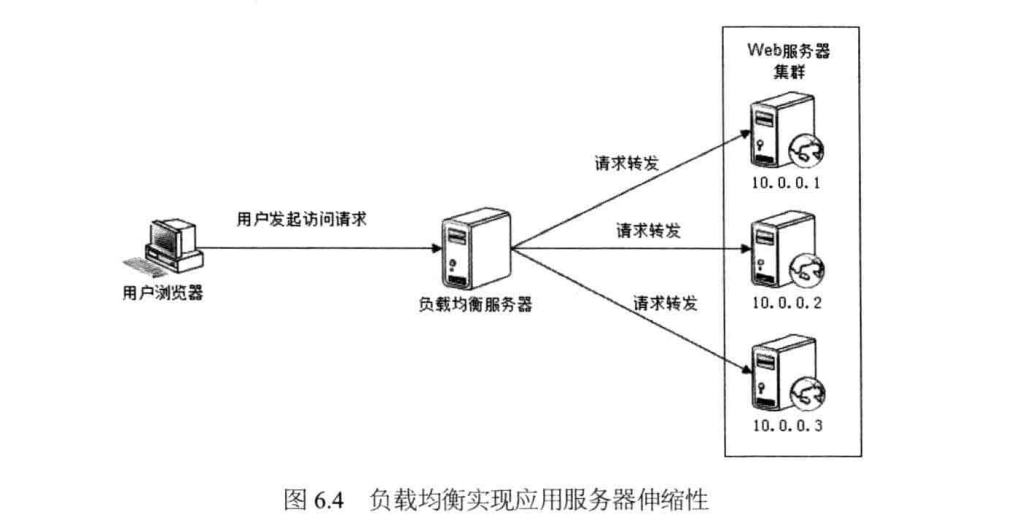

HTTP请求分发装置被称为负载均衡服务器。

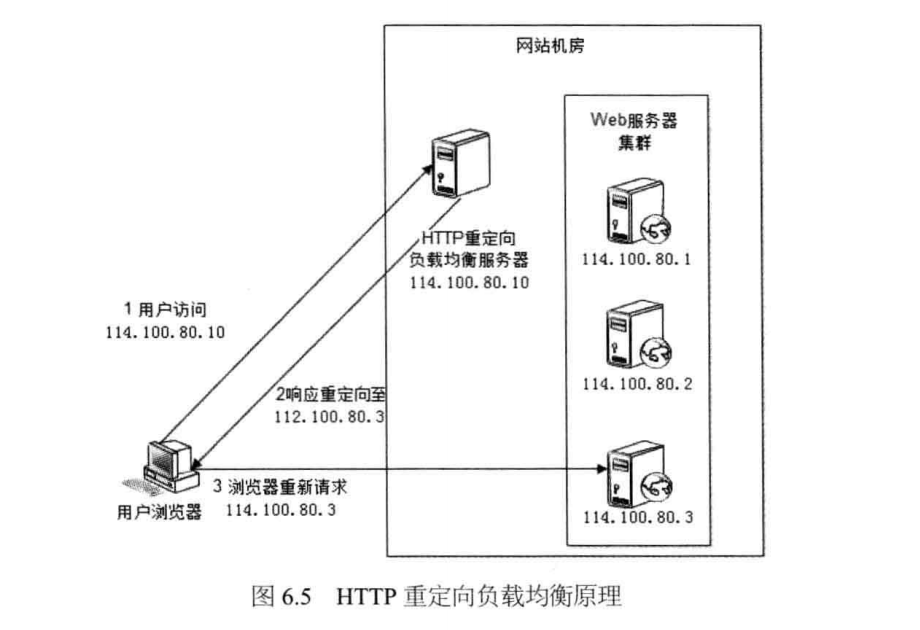

1. HTTP重定向负载均衡

利用HTTP重定向协议实现负载均衡。

这种负载均衡方案比较简单。缺点是浏览器需要请求两次服务器才能完成一次访问,性能较差;重定向服务器自身的处理能力成为瓶颈,整个集群伸缩性规模有限;使用HTTP302响应码重定向,有可能是搜索引擎判断为SEO作弊,降低搜索排名。

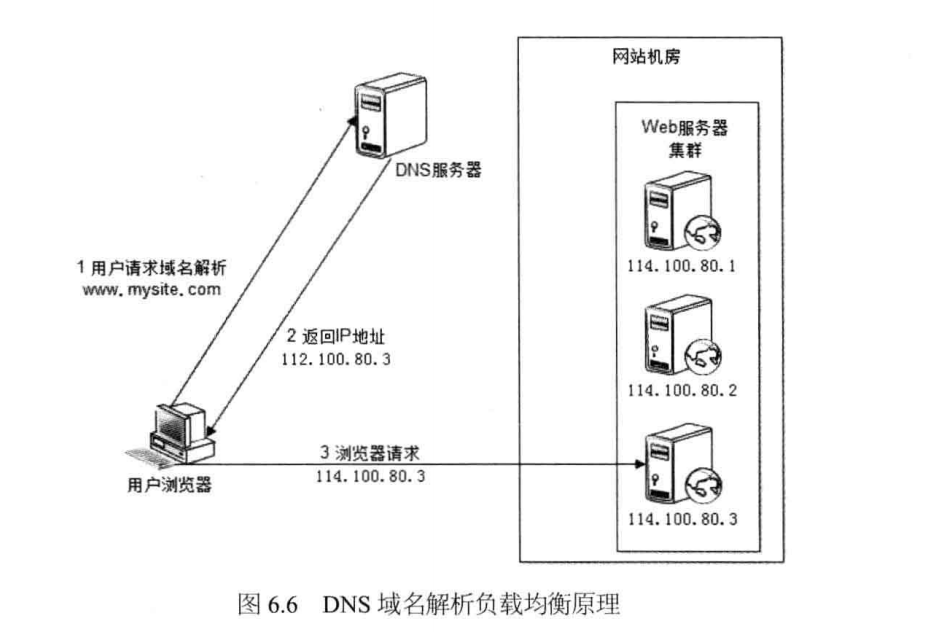

2. DNS域名解析负载均衡

这是利用DNS处理域名解析请求的同时进行负载均衡处理的一种方案,

每次域名解析请求都会根据负载均衡算法计算一个不同的IP地址返回,这样A记录中配置的多个服务器就构成一个集群,并可以实现负载均衡。

事实上,大型网站总是部分使用DNS域名解析,利用域名解析作为第一级负载均衡手段,即域名解析得到的一组服务器并不是实际提供Web服务的物理服务器,而是同样提供负载均衡服务的内部服务器,这组内部负载均衡服务器在进行负载均衡,将请求分发到真是的Web服务器上。

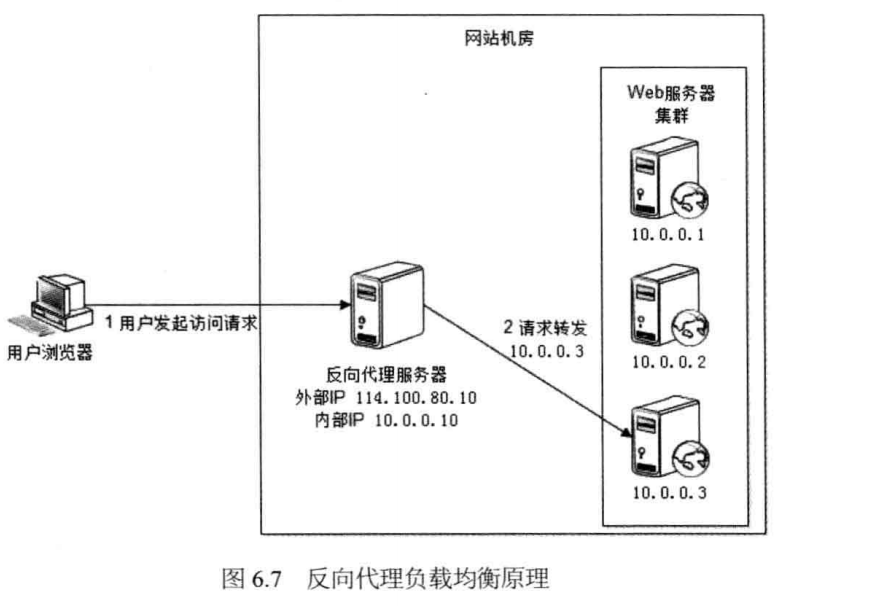

3. 反向代理负载均衡

利用反向代理服务器进行负载均衡。

前面我们提到利用反向代理缓存资源,以改善网站性能。实际上,在部署位置上,反向代理服务器处于Web服务器前面,这个位置也正好是负载均衡服务器的位置,所以大多数反向代理服务器同时提供负载均衡的功能,管理一组Web服务器,将请求根据负载均衡算法转发到不同Web服务器上。Web服务器处理完成的响应也需要通过反向代理服务器返回给用户。

由于反向代理服务器转发请求在HTTP协议层面,因此也叫应用层负载均衡。其优点是和反向代理服务器绑定在一起,部署简单。缺点是反向代理服务器是所有请求和响应的中转站,其性能可能会成为瓶颈。

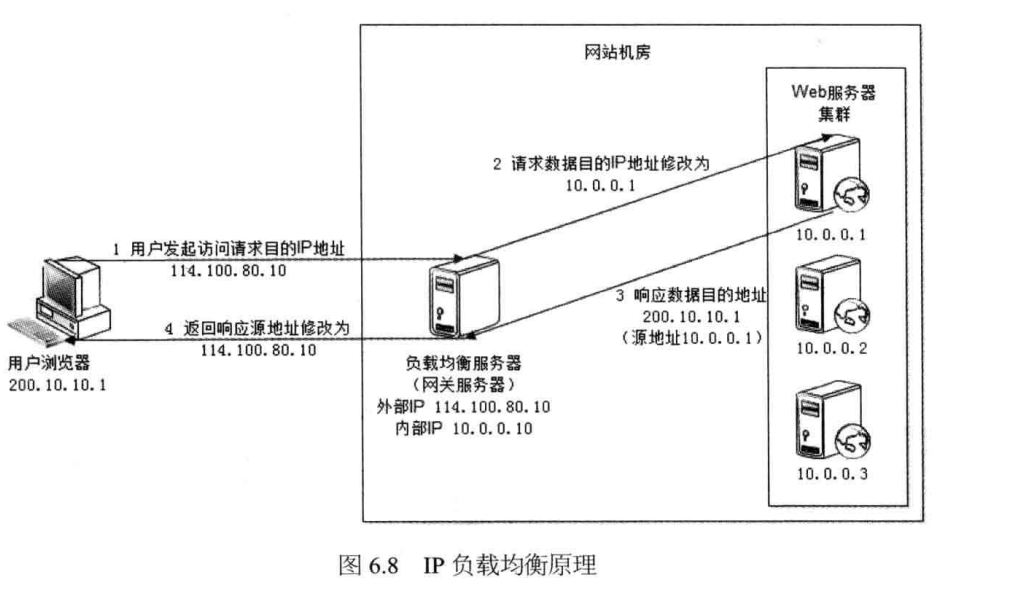

4. IP 负载均衡

在网络层通过修改请求目标地址进行负载均衡,

这里的关键在于真是物理Web服务器响应数据包如何返回给负载均衡服务器。一种方案是负载均衡服务器在修改目的IP地址的同时修改源地址,将数据包源地址设为自身IP,即源地址转换(SNAT),这样Web服务器的响应会再回到负载均衡服务器;另一种方案是将负载均衡服务器同时作为真是物理服务器集群的网关服务器,这样所有的响应数据都会到达负载均衡服务器。

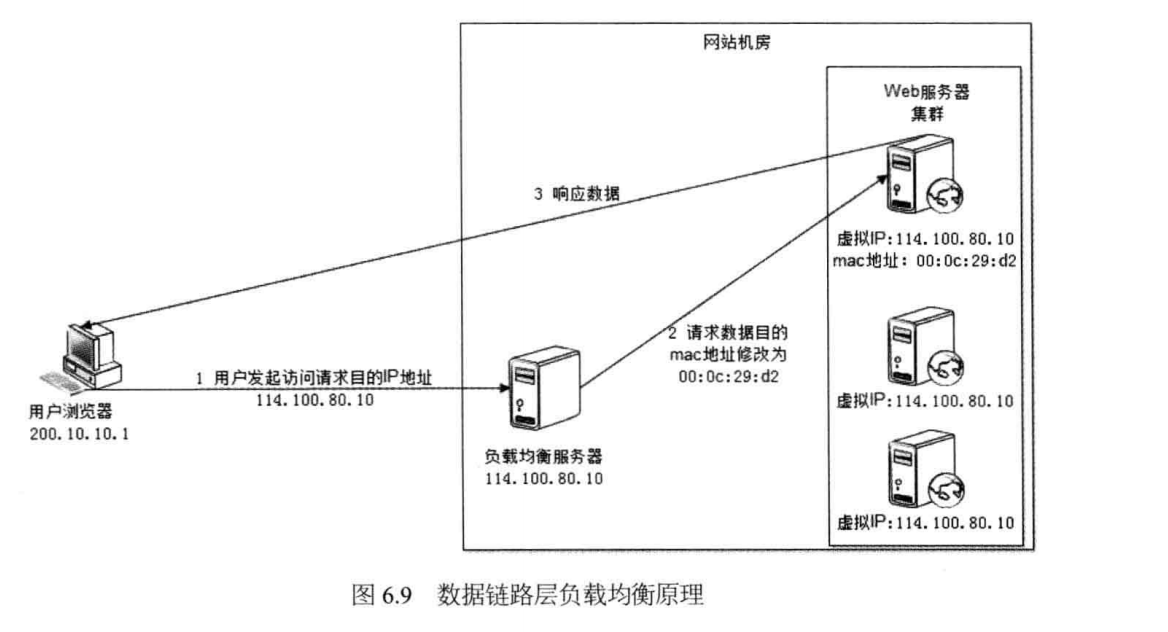

5. 数据链路层负载均衡

顾名思义,数据链路层负载均衡是指在通信协议的数据链路层修改mac地址进行负载均衡,

这种传输方式又称作三角传输模式,负载均衡数据分发过程中不修改IP地址,只修改目的mac地址,通过配置真是物理服务器集群所有机器虚拟IP和负载均衡服务器IP地址一致,从而达到不修改数据包的源地址和目的地址就可以进行数据分发的目的,由于实际处理请求的真是物理服务器IP和数据请求目的IP一致,不需要通过负载均衡服务器进行地址转换,可将响应数据包直接返回给用户浏览器,避免负载均衡服务器网卡带宽成为瓶颈。这种负载均衡方式又称作直接路由方式(DR)。

使用三角传输模式的链路层负载均衡是目前大型网站使用最广的一种负载均衡手段。在Linux平台上最好的链路层负载均衡开源产品是LVS(Linux Virtual Server)。

6. 负载均衡算法

负载均衡服务器的实现可以分为两个部分:

1. 根据负载均衡算法和Web服务器列表计算得到集群中一台Web服务器的地址。

2. 将请求数据发送到该地址对应的Web服务器上。

轮询(Round Robin,RR)

所有请求被依次分发到每台应用服务器上,即每台服务器需要处理的请求数目都相同,适合所有服务器硬件都相同的场景。

加权轮询(Weighted Round Robin,WRR)

根据应用服务器硬件性能的情况,在轮询的基础上,按照配置的权重将请求分发到每个服务器,高性能的服务器能分配的更多请求。

随机(Random)

请求被随机分配到各个服务器,在许多场合下,这种方案都简单实用,因为随机数本身就很均衡。即使应用服务器硬件配置不同,也可以使用加权随机算法。

最少连接(Least Connections)

记录每个应用服务器正在出来的连接数(请求数),将新的请求分发到最少连接数的服务器上,应该说,这是最符合负载均衡定义的算法。同样,最少连接算法也可以实现加权最少连接。

源地址散列(Source Hashing)

根据请求来源IP地址进行Hash计算,得到应用服务器,这样来自同一个IP地址的请求总在同一个服务器上处理,请求的上下文信息可以存储在这台服务器上,在一个会话周期内重复使用,从而实现会话黏滞。